你真的需要本地部署DeepSeek吗?

自从DeepSeek火了之后,围绕这个AI的各种生意就成为大热门,前段时间雷科技的一篇文章就提到过,在小红书、抖音等平台上教你如何用DeepSeek的教程已然泛滥成灾,只是数量繁多的教程其实大多高度相似,并没有太大的用处。

不过这些教程至少大部分都不收钱,即使要你关注或是加入群聊领取,回头觉得没用也是可以“反悔”的。而且就算是收费的教程,一般价格也贵不到哪去,大家被“割韭菜”了也可以及时止损,但是与这些“虚拟服务”相比,DeepSeek的“实体周边”可就贵多了,如果你不小心被坑,就会成为真正的冤大头了。

图源:淘宝

过去一段时间里,不少粉丝都在微信后台问小雷,本地部署DeepSeek的事情,比如本地部署高参数的DeepSeek体验到底如何?部署DeepSeek到底要怎样的配置等,在出了一篇本地部署的教程后,小雷这次想和大家聊一聊网上正在泛滥的“DeepSeek PC”(或者“DeepSeek主机”、“DeepSeek电脑”、“DeepSeek机”)这件事。

什么是DeepSeek PC?看名字挺高大上的,实际上就是以前的高性能PC,其中很多产品甚至只是把商品展示页P上DeepSeek的字样,改改商品描述页就上架销售。

比如淘宝某商家标注的「入门款」DeepSeek PC,配置是AMD Ryzen 5 5600X+DDR4 16G*2+RTX 3060 12G显卡,同时标注可以本地部署1.5B和7B的DeepSeek AI模型。

图源:淘宝

这样一台所谓的「DeepSeek PC」,售价高达5000+元,对PC DIY市场有所了解的朋友,估计很快就能看出不对劲了。一颗5年前发布的中端处理器+四年前的甜点级显卡,其他配置也不是什么好东西,在2025年居然还能卖到5000元以上?钱真的不是这样赚的。

让小雷给大家简单剖析一下这台PC的成本,5600X散片价格为549元,RTX 3060 12G的二手价是1500元,主板算570元,最核心的三大件加起来也就2500元,剩下的硬件1000元配齐基本无压力。而且,这还是按照淘宝的零售价计算的成本,商家成本在此基础上再砍个20%甚至更多是没问题的。

或许会有人说:小雷,人家也要赚钱的嘛,不就是小赚2000元吗?算上售前售后和三年质保,对于企业来说这个钱也不算亏吧?问题就出在这里。

花5000元的成本部署个7B参数量的DeepSeek,就像杀鸡用牛刀一样,花大钱办小事(不少云服务商直接提供完全免费的1.5B和7B版DeepSeek服务)。

首先来看看商家推荐的1.5B和7B参数模型,这两个模型本质上都不是DeepSeek,而是用DeepSeek的开源技术,在阿里的Qwen AI大模型基础上制作的小参数版本。简单来说,里面的训练数据用的是Qwen,只不过思维链和推理过程与DeepSeek-R1相似,拥有后者的“部分功力”。

图源:魔塔社区

如果你寄希望于1.5/7B参数量的DeepSeek AI模型提供接近官网水平的回答,其实可以直接洗洗睡了,因为官网的DeepSeek不仅是原生版本,而且参数量高达671B,是这两个模型的447倍和96倍。

在这种级别的参数差距下,不仅仅是回答质量有显著区别,AI的性能也会严重受限,基本上只能给你提供一些日常问答聊天级别的建议,面对高级一点的数学题都会直接“束手无策”或是反馈给你错误的答案。所以这类型的DeepSeek PC,基本上可以直接无视,“不要购买”就是我给大家的唯一建议。

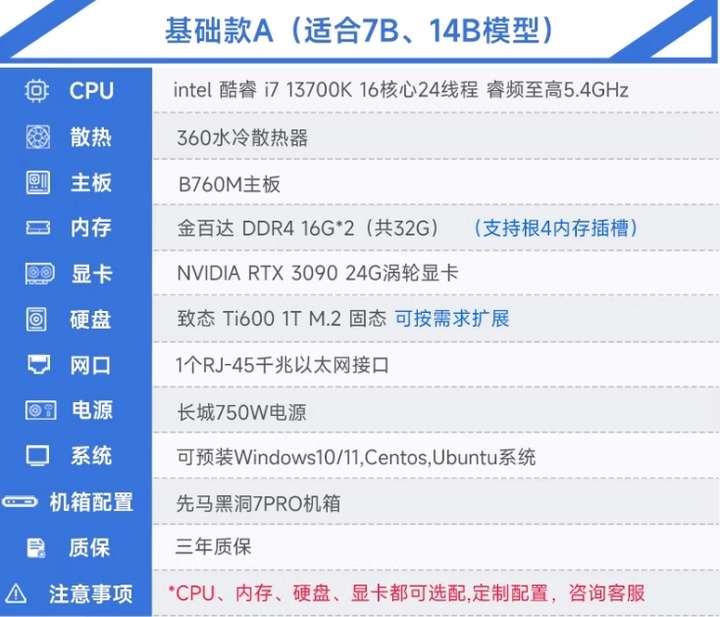

那么更贵的型号呢?还是同一家店,一台售价高达12xx9元的DeepSeek PC,配置是i7-13700K+16G*2+RTX 3090 24G,价格暴涨后给的配置确实好了不少,但是RTX 3090仍然是一款“老显卡”,而且考虑到商家标注为“涡轮显卡”,基本上可以确定是在服务器机房里“长期服役”的老将。

图源:淘宝

虽然从网友的反馈来看,RTX 3090实际上最高可部署32B的DeepSeek,但是不知道为何店家却只建议部署最高14B,个人猜测或许是为了确保输出速度,也有可能是担心高负荷下显存不稳定导致“炸机”。

从体验角度来说,14B的DeepSeek虽然已经堪堪能用(可以进行一些简单的写作、代码辅助和问答),但是一万二的价格仍然是相当不值得。事实上,你用相似的价格去购买RX 7900XTX,推理速度甚至还要优于RTX 3090,而且作为一款2022年11月才发布的显卡,你很轻松就可以买到仅用了一两年的显卡,远比一张经受过“长久考验”的RTX 3090靠谱。

简单来说,如果你是为了尝鲜想折腾下本地部署,那么在没有自备显卡 的情况下,任何为了本地部署而购买「DeepSeek PC」的行为都是不值得的,还不如直接去买一台正经的游戏PC,然后花几块钱买个本地部署教程或者让客服直接远程操控安装(如果你具备基础的电脑知识,那么免费的教程也是随手就能搜到)。

虽然本地部署的AI大模型听起来很酷,但是从小雷的实际体验来看,其实远不如直接购买API资源。以小雷自己的PC为例,我有两台台式机,一台用的是14700K+32G内存+RTX 4070TI Super 16G,一台则是14600K+32G内存+RX 7900XT 20G。

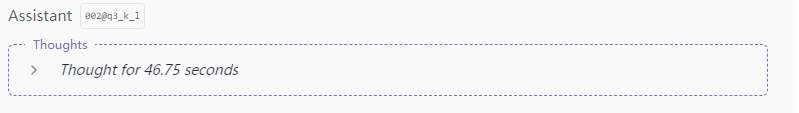

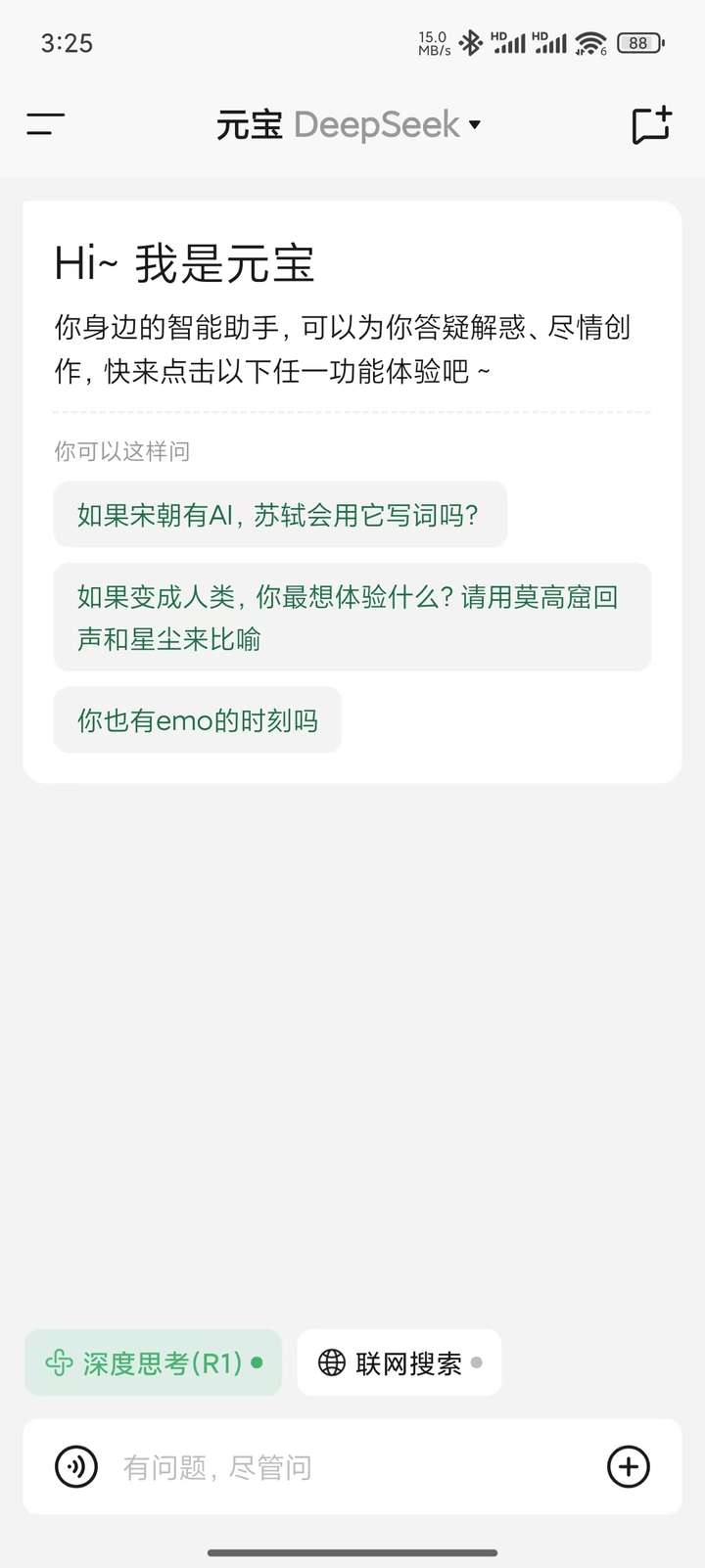

我在两台电脑上分别部署了32B和14B版本的DeepSeek,虽然都可以顺畅运行,但是推理速度并不乐观。在没有进行优化的情况下,RTX 4070Ti Super的推理速度是5.89tok/sec,一篇千字左右的纯文字创作回答就思考了整整46秒。

图源:雷科技

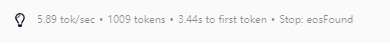

而在RX 7900XT的电脑上,我曾经尝试过用他来推理一个高考数学题,结果就是推理速度仅为2.51tok/sec,整个思考过程长达37分钟45秒,最后还给了一个错误的答案,属实让我有点无语。

图源:雷科技

事实证明,即使是32B版本的DeepSeek,在数学推理等方面也基本不具备可用性,只要是稍微高难度一点的问题,就会需要很长的思考时间,而且还有概率是错的。至于更高级的70B版本DeepSeek,那就不是普通用户可以考虑的了,从实测来看至少要40G以上的显存才能运行,而且推理速度堪忧。

简单来说,本地部署DeepSeek其实非常尴尬,除非你财力雄厚,直接购入服务器级别的硬件,然后部署个满血版的DeepSeek,否则大多数情况下你都很难从残血版的本地DeepSeek上得到符合需求的体验。

如果说你是因为DeepSeek官方软件频繁的“服务器繁忙”,打算试试本地部署,那么我的建议是直接考虑第三方app,比如腾讯元宝、纳米AI搜索(360)等app都提供免费的满血版DeepSeek AI服务。

图源:雷科技

如果你想要一个专属于个人的DeepSeek,那么也可以去硅基流动、阿里云、华为云等AI服务商那里购买API流量,利用chatbox等第三方客户端进行本地部署。我们以DeepSeek的官方API价格为基准,让AI帮我们算一下如果5000块全部拿去充值API余额,专为一个人服务可以使用多久。

答案是纯聊天能用101年(每天发送一百条信息)、纯推理为38年(每天使用20次深度推理),即使是混合使用的情况,这笔钱也够你买27年的DeepSeek官方服务,而且是满血版。

虽然目前DeepSeek官方已经关闭了API充值通道,但是大多数第三方API都是类似的价格。当然,我知道有人会说这是本地部署,自己就是不想把数据给到DeepSeek等AI供应商,那么也是有第二个方案的,不管是阿里云还是华为云都提供云服务器的AI部署服务,在多数情况下你的数据会比放在本地更安全,而且也不会受到AI服务商的规则限制。

图源:腾讯云

而且,从小雷收集到的信息来看,阿里云、华为云、腾讯云等云服务器的价格都差不多,支持到70B版本DeepSeek部署的云服务器价格大多在15-20元一小时左右,如果每天的使用时间不多,选择按量计费其实是挺划算的(至少比你花三万多买个电脑回来本地部署要好)。

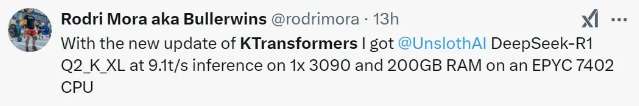

简而言之,除非你对数据安全有着极致的要求,否则本地部署DeepSeek都不是一个好主意,只有当你拥有中高端显卡时,拿来做个消遣的价值。不过这个结论并非一直不变,随着开发者对DeepSeek的了解深入,或许我们有望以更低的标准部署DeepSeek也说不定。

比如清华的团队就用单张RTX 4090+超大规模内存阵列的方式,实现了本地的671B版本DeepSeek部署,而且输出速度并不慢,简单计算下,整体成本远低于购买专业服务器和计算卡,已经具有可行性。

图源:推特(外国网友复现清华团队成果)

所以,大家不妨再等等,或许不用两个月就会有更精简、高效的DeepSeek本地部署方案面世。至于现阶段,大家还是先玩玩第三方的免费版或者自购API吧,这两个是性价比最高的选择。

文章来自于“雷科技”,作者“雷科技”。

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/