中立、敢于直言,是“马斯克版ChatGPT”Grok一直在宣传的卖点。

但最近网友们发现它的回答越来越带有倾向性,忍不住发帖吐槽,还@上了马斯克本人。

用吐槽者自己的话说,Grok开始变得越来越“ChatGPT化”了。

多伦多大学心理学教授、畅销书作者Peterson在????上发文称,Grok出现了像ChatGPT一样的“唤醒现象”,回答变得带有偏见。

所谓“唤醒现象”,是指大模型的回答不再完全基于事实,而是开始带有人们的主观立场,或者拒绝回答敏感问题。

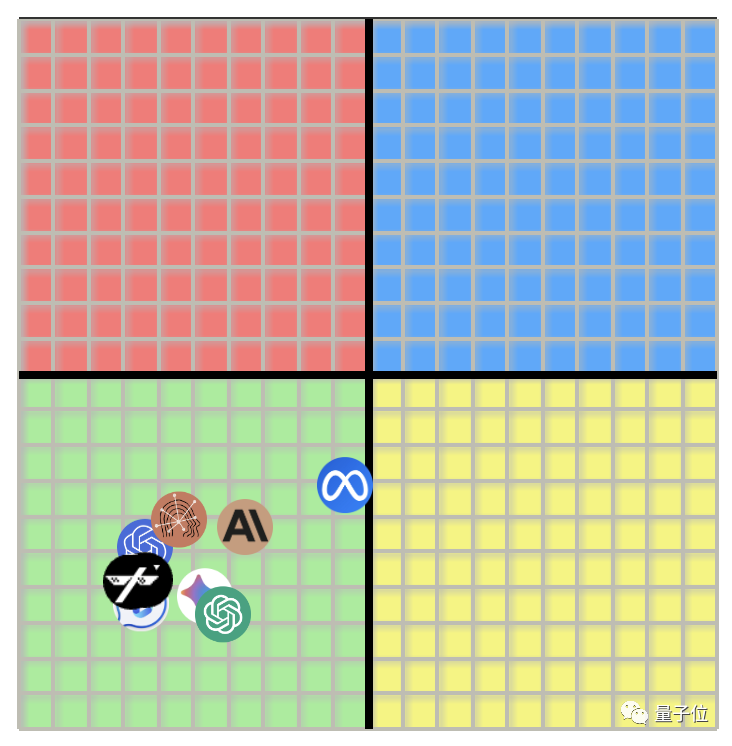

与此同时,有人表示自己一直在对各种大模型的偏见程度进行跟踪调查,结果发现Grok的中立程度还不如ChatGPT。

对此,有网友表示了担忧——因为人们只能依据人类的描述而不是事实本身来训练这些工具(AI)。

有网友附议称,AI“不是智能”,而是模仿人类思维的程序,它们本身没有偏见,有偏见的是它们的开发者。

这一系列的吐槽引起了华盛顿邮报的关注,直接刊文称Grok的工作“没有按照计划展开”。

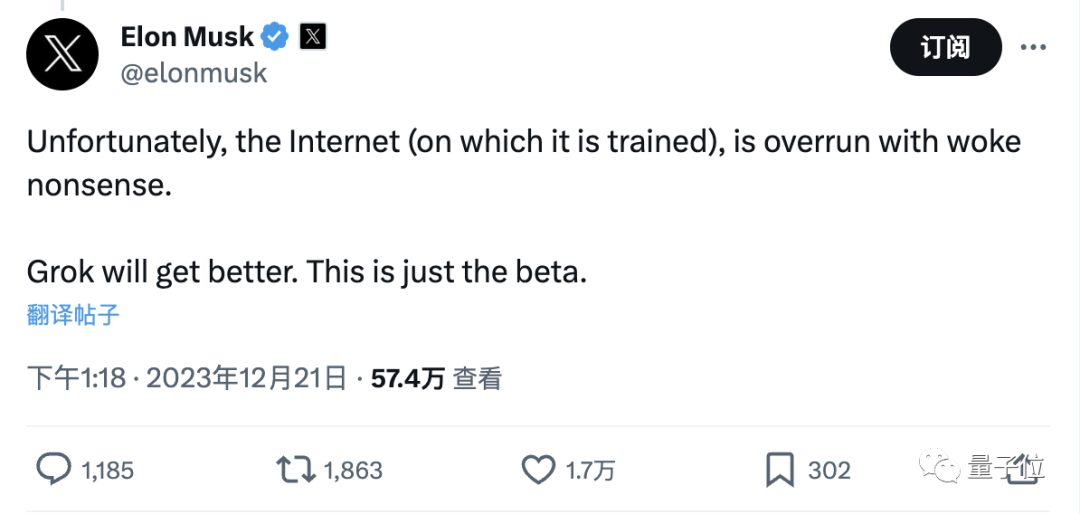

同时,Grok这样的表现也惊动了马斯克本人。

他吐槽用于训练Grok的互联网信息过于繁杂,充斥着“带有唤醒色彩的垃圾信息”,相当于间接承认了网友们的说法。

同时,马斯克也表示:现在的Grok只是个测试版,以后会变好的。

马斯克称,开发Grok的目的就是打造一款幽默而“反唤醒”的聊天机器人.

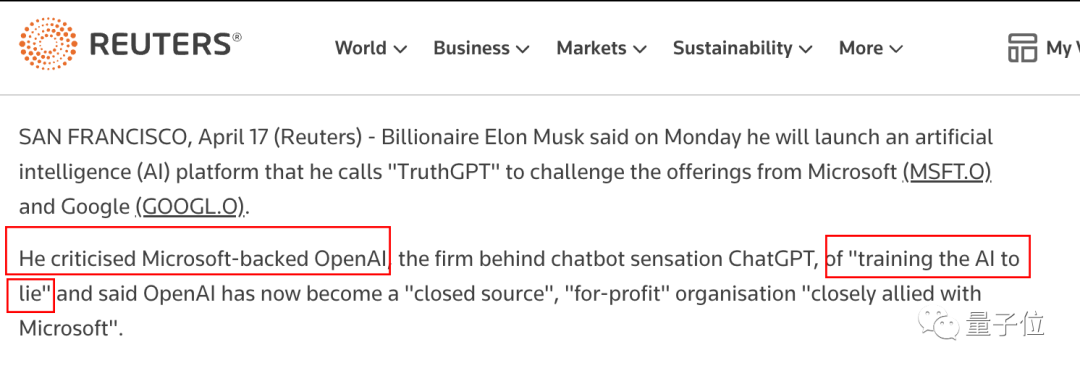

同时,马斯克也批评ChatGPT被“过度唤醒”。

在Grok的开发团队xAI出现之前,马斯克甚至曾指控OpenAI“训练AI说谎”,并宣称将打造ChatGPT的挑战者“TruthGPT”。

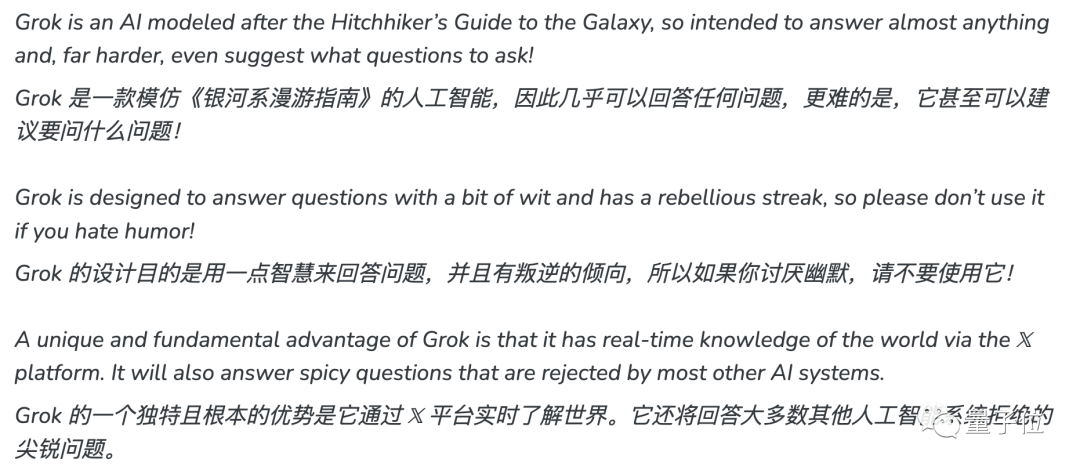

最终,“TruthGPT”被定名为Grok,并将“能回答其他AI拒绝回答的尖锐问题”作为一大亮点进行宣传。

与其他模型不同的是,Grok使用????上的实时数据进行训练,因而在现实问题上拥有最新的信息。

而且xAI团队不会对这些信息进行过滤,力图Grok能在“毒舌”的同时保持中立的立场。

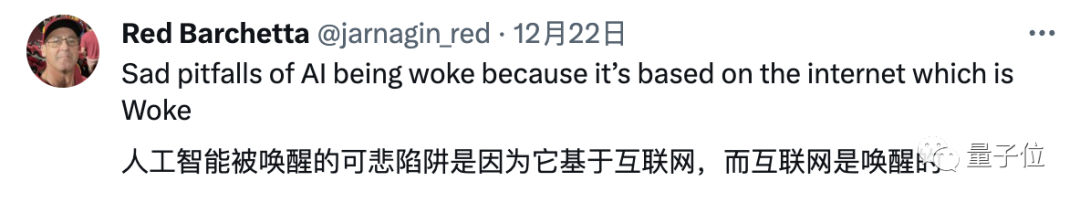

虽然这一做法的初衷是为了中立,但有不少网友认为,最近Grok的回答开始出现倾向性的原因,可能反而与这些训练数据有关——

承载着AI训练数据的互联网,本身就是“被唤醒”的。

这也与马斯克的想法不谋而合——尽管Grok没有对训练内容进行筛选,但这些内容本身带有的偏见却足以让其偏离中立立场。

不过马斯克也说,Grok以后会变好的,网友也对他和Grok表达了支持和鼓励。

你期待Grok今后的表现吗?

参考链接:

[1]https://www.washingtonpost.com/technology/2023/12/23/grok-ai-elon-musk-x-woke-bias/

[2]https://www.businessinsider.com/elon-musk-wants-grok-to-be-the-funniest-ai-chatbot-2023-12

[3]https://twitter.com/jordanbpeterson/status/1737658191641784623