在斯坦福,有一门专门讲 Transformer 的课程,名叫 CS 25。

这门课曾经邀请过 Geoffrey Hinton、Andrej Karpathy 以及 OpenAI 的 Hyung Won Chung、Jason Wei 等一线大模型研究科学家担任讲师,

在 AI 社区引起广泛关注。

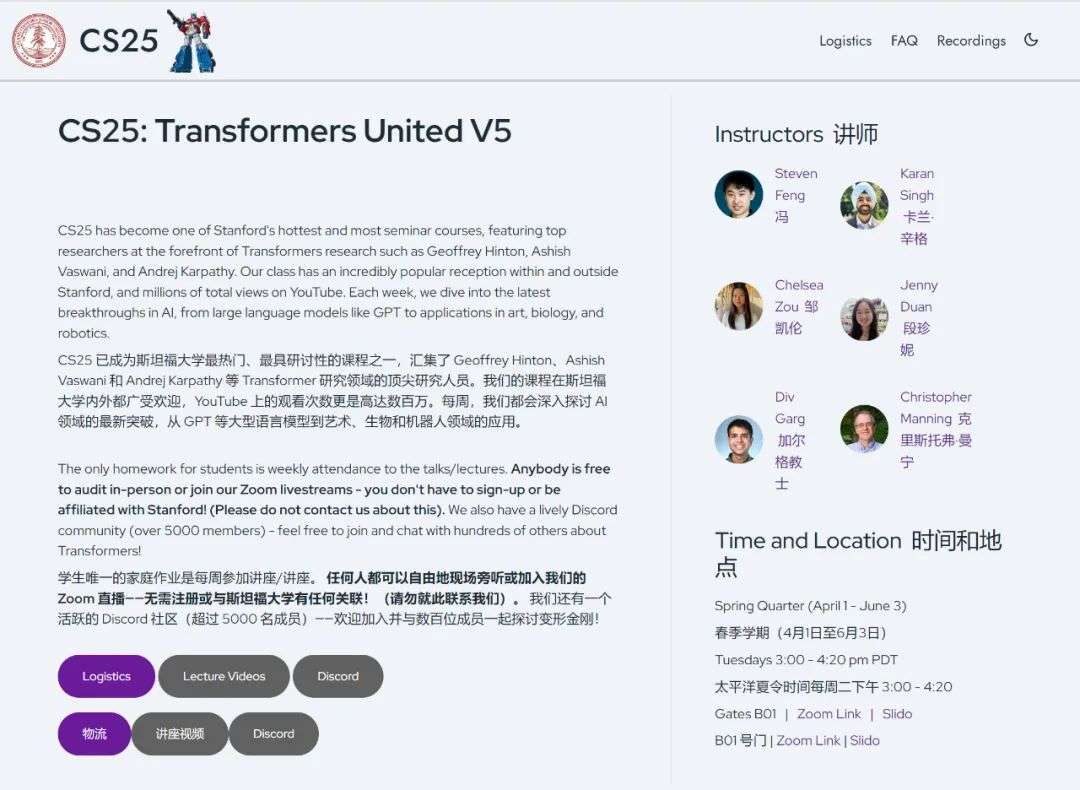

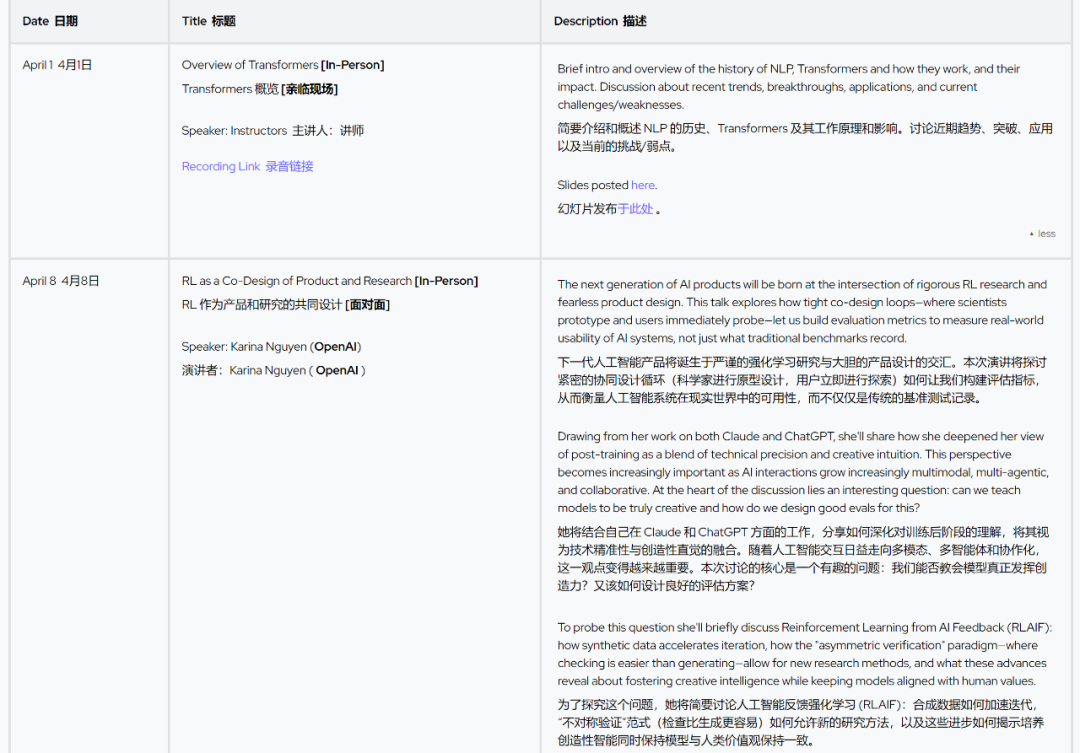

最近,这门课又上新了。这一春季学期课程名为「CS25: Transformers United V5」,

邀请了 Google DeepMind 推理团队创立者和现任负责人 Denny Zhou、

OpenAI Canvas 项目负责人 Karina Nguyen、OpenAI 研究科学家 Hongyu Ren(任泓宇)、

Meta 视频生成团队研究科学家 Andrew Brown 等知名研究者,深入探讨 AI 领域的最新突破。

而且,这门课是完全开放的,任何人都可以现场旁听或加入 Zoon 直播,无需注册或与斯坦福大学建立关联。

课程结束后,他们还会把课程的视频上传到官方 YouTube 账号。目前,新学期视频第一期已经上传。

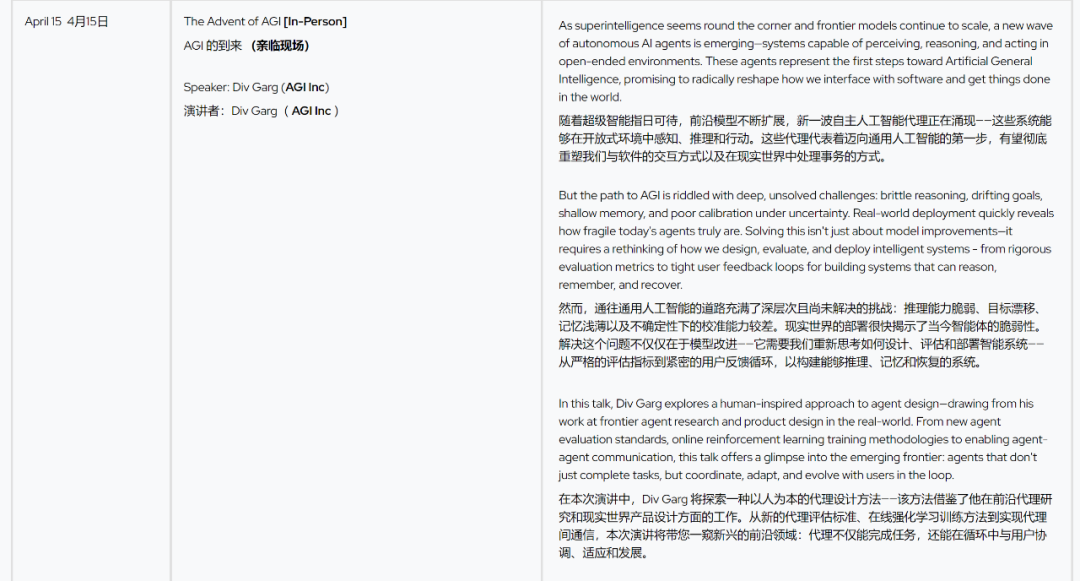

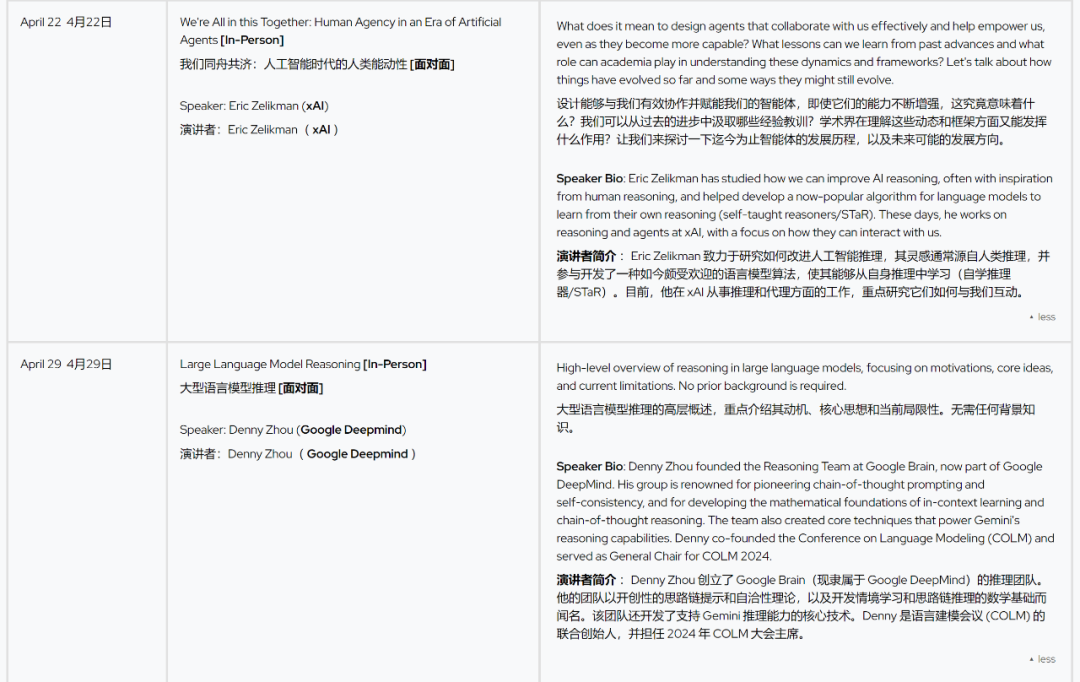

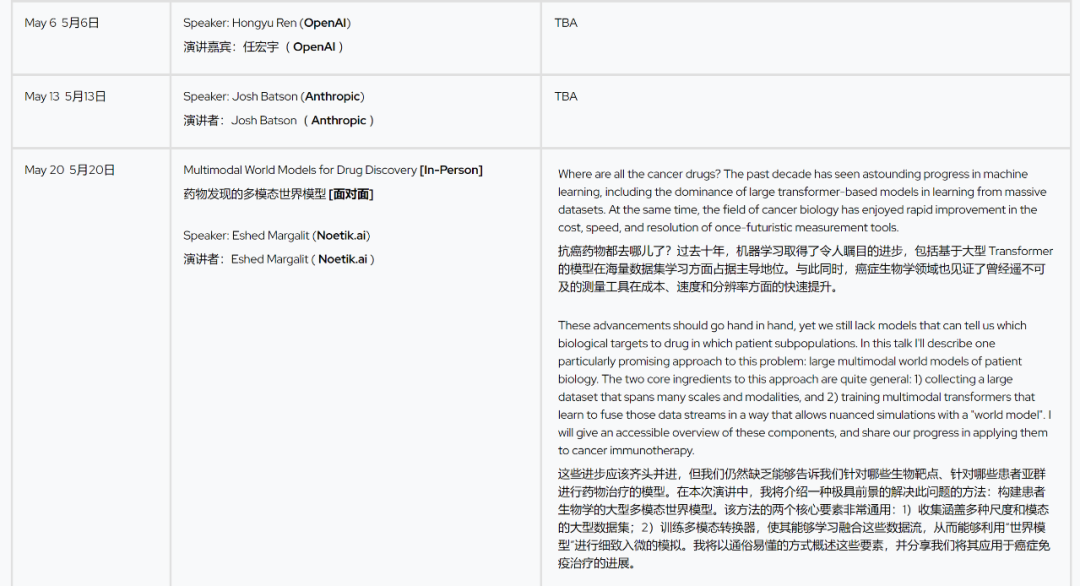

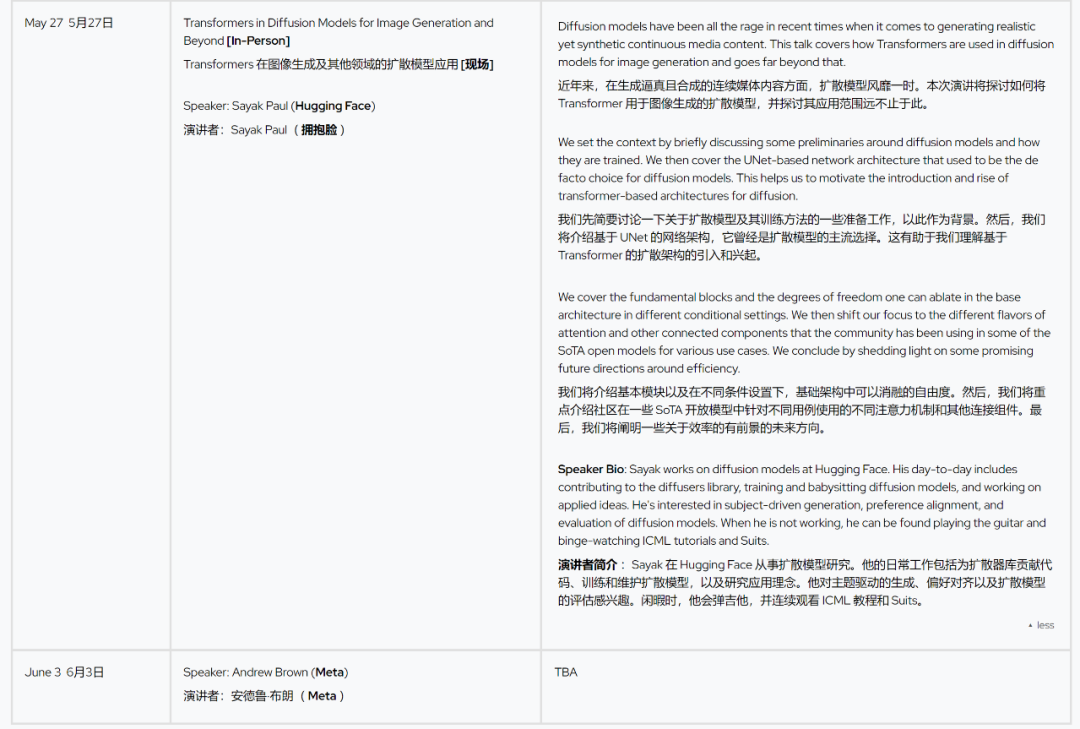

整个学期的课程表如下:

想要听直播的同学记得在太平洋夏令时间每周二下午 3:00 - 4:20(北京时间每周三上午 6:00 - 7:20)蹲守,具体信息请参考官方网站。

V2:Geoffrey Hinton——Representing Part-Whole Hierarchies in a Neural Network

AI 领域传奇人物 Geoffrey Hinton(「深度学习教父」)分享了他对神经网络中部分-整体层次结构的最新研究,提出了 GLOM 模型,

旨在模拟人类视觉系统处理复杂场景的能力。

讲座探讨了 GLOM 如何通过动态解析树结构增强 Transformer 在视觉任务中的表现,解决自注意力机制的计算效率瓶颈。

Hinton 结合深度学习的演变历程,从感知机到 RNN 再到 Transformer,展望了神经网络在模拟认知过程和提升视觉理解中的未来潜力。

V2:Andrej Karpathy——Introduction to Transformers

Andrej Karpathy(前 Tesla AI 总监、OpenAI 研究员)系统介绍了 Transformer 架构的原理与影响。

他从 2017 年《Attention is All You Need》论文出发,拆解了自注意力机制(Self-Attention)、

多头注意力(Multi-Head Attention)及 Transformer 在大型语言模型(如 ChatGPT)中的核心作用。

讲座还探讨了 Vision Transformer(ViT)等跨领域应用,并展望了模型高效化和多模态学习的未来。

Karpathy 结合自身从斯坦福学生到业界先锋的经历,回顾了深度学习从 RNN 到 Transformer 的演变。

V3:Douwe Kiela——Retrieval Augmented Language Models

Douwe Kiela(Contextual AI 首席执行官兼斯坦福符号系统客座教授)深入探讨了检索增强生成

(Retrieval-Augmented Generation, RAG)作为解决大型语言模型(LLM)局限性的关键技术。

讲座介绍了 RAG 的基本概念,即通过外部检索器提供上下文信息,缓解幻觉(hallucination)、信息时效性和定制化问题。

Kiela 回顾了语言模型的历史,追溯至 1991 年的神经语言模型,澄清了 OpenAI 并非首创的误解,并调研了 RAG 的最新进展,

如 Realm、Atlas 和 Retro 架构,分析其优劣。

他还探讨了 RAG 与长上下文模型的效率对比、指令微调(instruction tuning)的重要性以及未来的研究方向,如多模态 RAG 和预训练优化。

V4:Jason Wei & Hyung Won Chung of OpenAI

OpenAI 研究科学家 Jason Wei 和 Hyung Won Chung 分享了关于大型语言模型(LLM)和 Transformer 架构的洞见。

Jason Wei 探讨了语言模型的直观理解,强调下一词预测作为大规模多任务学习的本质,并分析了扩展律(scaling laws)与个体任务的涌现能力。

Hyung Won Chung 则从历史视角审视 Transformer 架构的演变,聚焦计算成本指数下降的驱动作用,提出通过连接过去与现在预测 AI 未来的统一视角。

两位讲者结合在 OpenAI 的工作经验(如 FLAN-T5、Codex),展望了 Transformer 在多模态和通用 AI 中的潜力。

文章来自于 “机器之心”,作者 :机器之心编辑部

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales