华为盘古系列,带来架构层面上新!

量子位获悉,华为诺亚方舟实验室等联合推出新型大语言模型架构:盘古-π。

它通过增强非线性,在传统Transformer架构上做出改进,由此可以显著降低特征塌陷问题。

带来的直接效果就是模型输出表达能力更强。

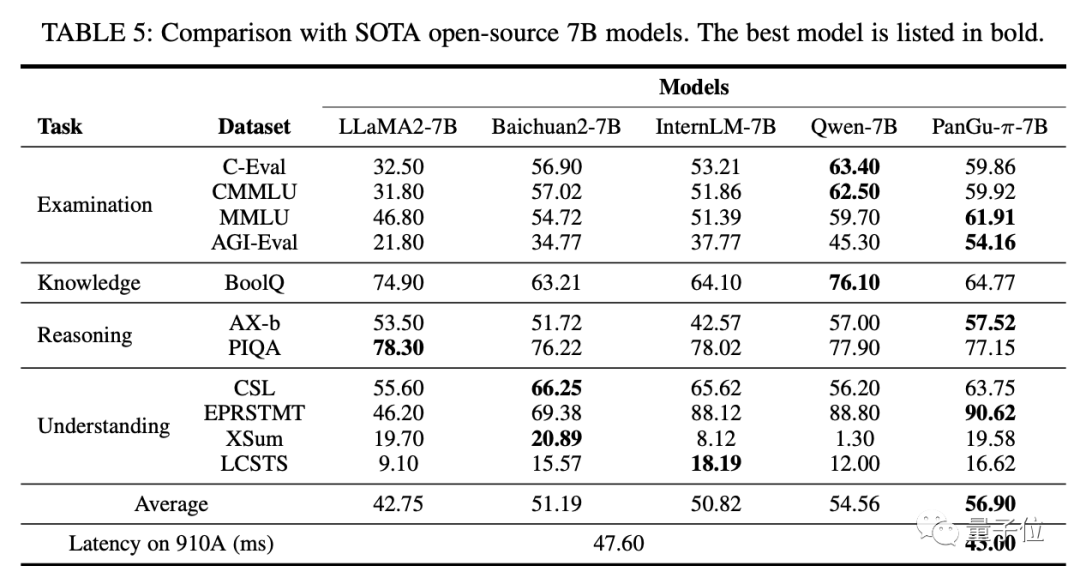

在使用相同数据训练的情况下,盘古-π(7B)在多任务上超越LLaMA 2等同规模大模型,并能实现10%的推理加速。

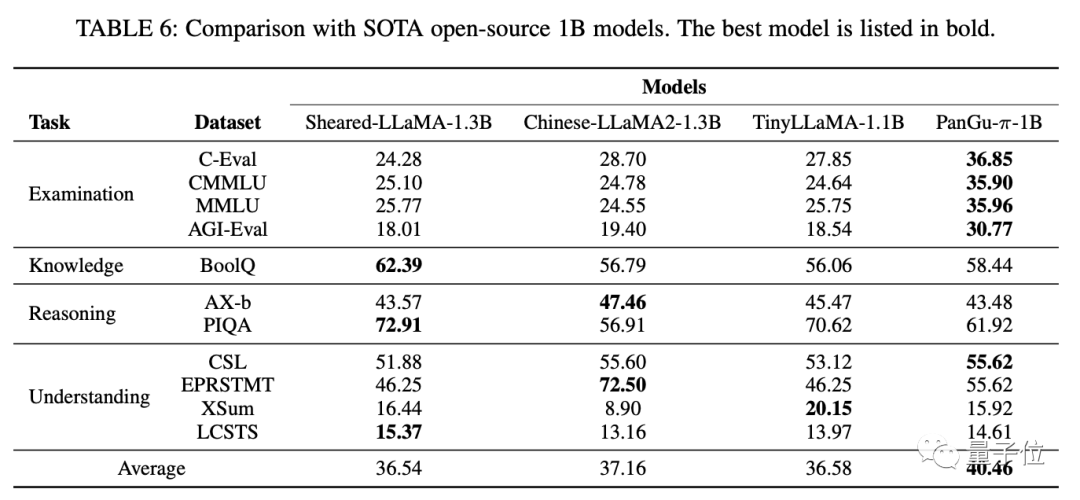

在1B规模上可达SOTA。

同时还基于这一架构炼出了一个金融法律大模型“云山”。

该工作由AI大牛陶大程领衔。

具体如何实现?一起来看。

目前常见大模型基本都采用Transformer架构,比如GPT、LLaMA等。

它的核心构成包括多头自注意力机制(MSA)和前馈网络(FFN)。

MSA的主要功能是计算输入序列中每个token和其他所有token之间的相关性,通过学习输入序列中的依赖关系,可以增强对语言的理解能力。FFN主要对输入进行非线性转换,增强模型表达能力,使其可以逼近更复杂的函数。

不过,华为诺亚方舟实验室发现,特征崩溃(feature collapse)会影响Transformer架构的表现,降低其表达能力,使模型难以区分不同输入。

以LLaMA为例,在更深层的神经网络上,特征等级显著降低,导致了所有token之间的相似性更强。

从机制上来看,自注意力模块可以看做在完全图上进行信息聚合,连续堆叠多层注意力就像连续多层图卷积一样,会产生过度特征平滑效应。

另一方面,多层感知器(MLP)中的激活函数提供的非线性还不够,抑制特征崩溃的作用有限。

由此,团队想要提高模型的非线性表达能力,避免特征崩溃,进而提出了本次工作盘古-π。

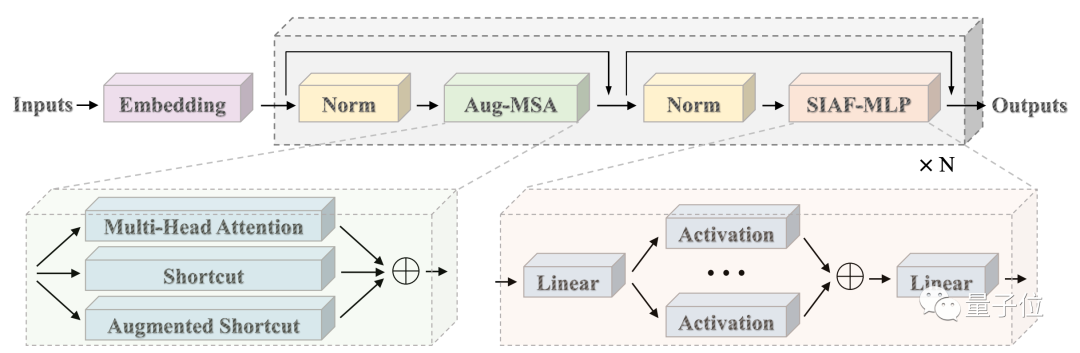

如下是盘古-π的结构示意:

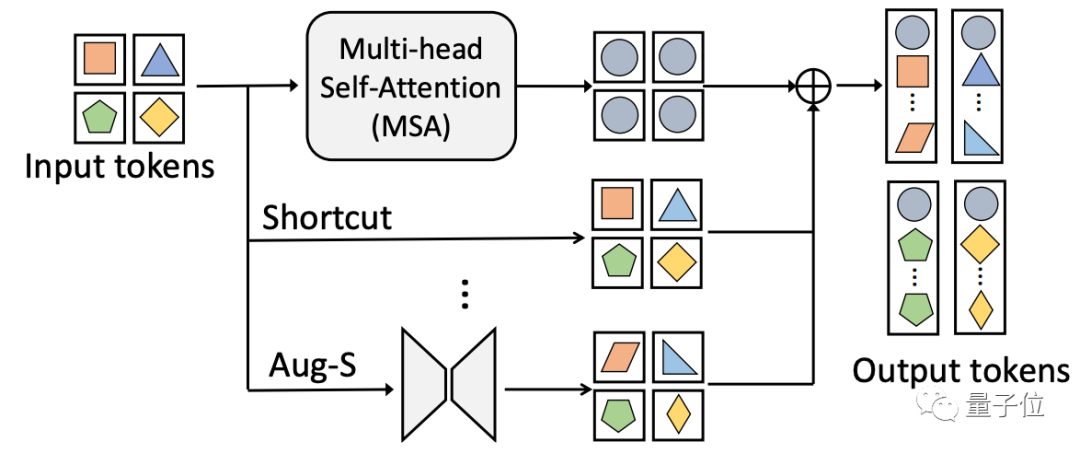

在FFN中加入串联激活函数,在MSA中集成一种增强快捷连接(Aug-S),可以更有效地在Transformer架构中引入更多非线性。

使用了增强快捷连接(Aug-S)的MSA,能将每个token的特征转换为不同表示形式。

基于这一新架构,通过大规模训练和微调,研究团队开发了一个盘古-π基础模型。

实验结果显示,该模型在多任务中表现超越其他同规模模型(分别测试了7B和1B规模)。

而且盘古-π-7B可以达到约10%的推理加速。

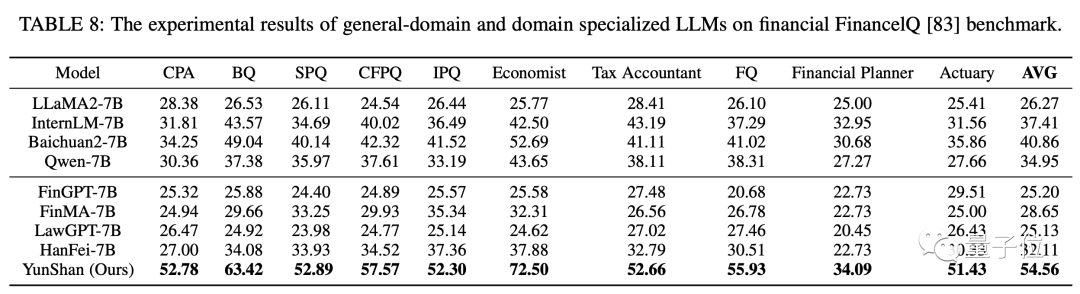

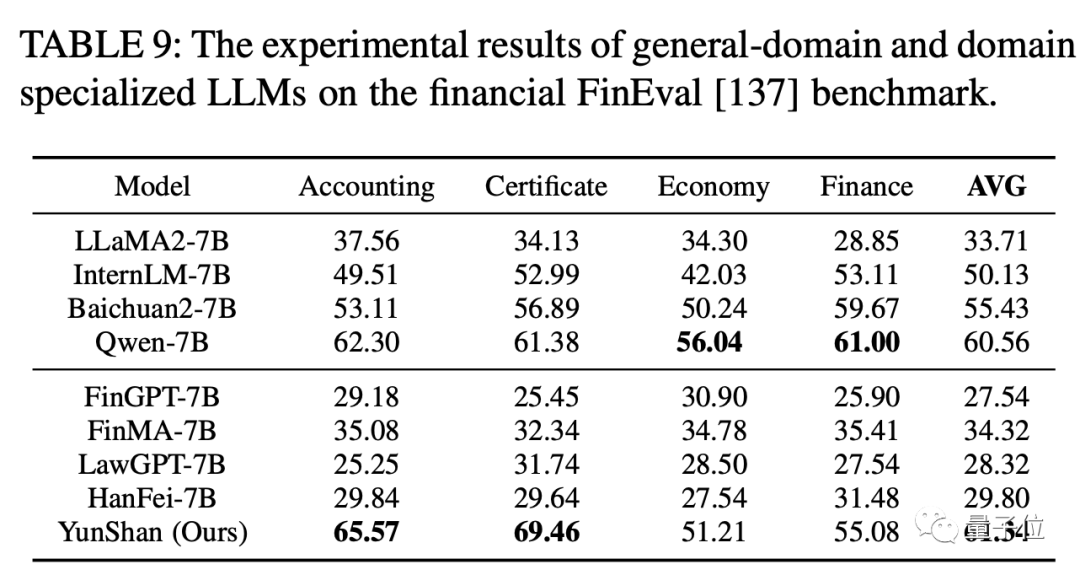

同时团队还以此为基础开发了一个金融法律领域大模型“云山”,它同样在多个benchmark中成绩超越其他模型。

值得关注的是,本项研究的团队阵容也非常亮眼。

通讯作者为陶大程。

他是欧洲科学院外籍院士、澳大利亚科学院院士。本科就读于中科大,说是毕业于港中文MMLab、师从汤晓鸥。

2007年从英国博士毕业后,先后在中国香港理工大学、新加坡南洋理工大学,澳大利亚悉尼科技大学、悉尼大学任教。目前是清华大学智能产业研究院AIR团队卓越访问教授。

与此同时,他还先后加盟过优必选、京东,曾是京东最高级别AI科学家、担任京东探索研究院院长。

一作为王云鹤。

他是2012实验室诺亚方舟实验室高级研究员,现任华为算法应用部部长。

王云鹤在华为负责高效AI算法的创新研发以及在华为业务中的应用。他和团队开发了高效AI算法,其衍生应用在中国天眼FAST观测工作中,协助中科院国家天文台专家找到了数百个新的快速射电暴样本。

论文地址:

http://arxiv.org/abs/2312.17276