AI武器化?

自大语言模型诞生以来,人们对其可能带来的影响的讨论就没停过。不过,更多人还是从普通人的视角出发,从LLM能对人们的日常工作生活带来哪些变化来思考的问题。

然而从稍微宏观一点的视角,我们就会发现LLM以及AI可能对整个社会甚至国家带来一些改变。

而具体如何,还是得看手握权力的大佬们决定如何去用,和普通人关系并不大了。

就在最近,世界上的LLM先驱,ChatGPT的老家,OpenAI悄悄修改了他们有关AI武器化的政策措辞。

在讨论这个问题之前,我们先来看看OpenAI最近一次有关这个问题在表态上的变化是什么样的。

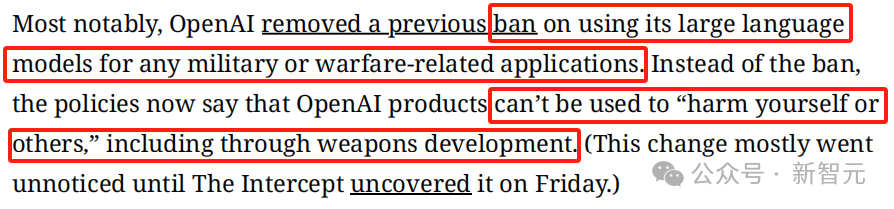

之前,OpenAI的用词是:禁止将其大型语言模型用于任何军事或战争相关的应用。

英文原文如下:Ban on using its large language models for any military or warfare-related applications.

现在的说法是:OpenAI products can’t be used to “harm yourself or others,” including through weapons development.

翻译过来就是,OpenAI的产品不可以用来伤害自己或他人,包括通过武器的研发造成的伤害。

细心的读者应该已经捕捉到了细微区别,前者把重点放在了对军用、战争使用的禁止,而后者放在了伤害上。

换句话说,只要不造成伤害,那么所谓的军用就是可以的。

实际上,这项政策上的变化并没有被大多数人关注到,然而从重要性来讲,这个变动完全不可忽视。

这意味着,OpenAI的模型开发人员可以进军利润丰厚的国防科技市场,军方也可以把模型拿过来为己所用。

而这里就可以创意十足了。

军方能用模型来干什么,不是咱普通人能想全面的。也许可以帮助分析人员解读一些参数数据,编写一些相关的软件代码什么的。当然,我们想不到的用途还会有很多。

要知道,美国国防部在去年8月10日曾经成立过一个特别工作组,专门讨论的就是生成式人工智能的各种花式用例。以及这项技术和别的技术有什么结合的办法。

该工作组叫做Task Force Lima,由美国国防部副部长Kathleen Hicks,通过国防部首席数字与人工智能办公室成立。

该工作组的宗旨就一句话,「开发、评估、推荐和监控整个国防部的生成式人工智能能力的实施情况,以确保国防部做好采用生成式人工智能技术的准备,并针对生成式人工智能技术提供适当的保护。」

听起来并不复杂,但美国一直就在生成式AI的路上冲在了前线。

Lima工作组的指挥官是海军上尉Manuel Xavier Lugo,他在接受采访时曾表示,国防部几十年来一直在研究和开发AI系统。而生成式AI又和传统的AI系统有所不同,他们风靡和席卷的速度非常之快。

据悉,截止到去年,Lima工作组就已经收到了160多个生成式AI的用例,不可谓效率不高。

不过,作为旁观者担心的还是,即便是按照OpenAI的新说法,「不伤害」,也可能会有不小的风险。

首当其冲的就是2023年的年度热词之一,「幻觉」。

试想一下,如果AI在与战争有关的高风险应用中产生了「幻觉」,这个后果没人可以承担,哪怕并未直接伤害,也一定会造成间接的各类损失。

其实在领导层,一直以来也有大量有关科技公司该如何和军方合作的讨论。

早在2018年,4000多名谷歌员工就曾签署了一封抗议信,抗议该公司参与一个名叫Project Maven的项目。

简单来说,这是一个利用人工智能来处理无人机视频和图像并探测潜在目标的军事项目。

当时有了解到项目内容的员工集体选择了辞职,并且在采访中和人提到,「不推荐任何人来谷歌」。

参加请愿的员工在信中写道,「我们不能将我们技术的道德责任外包给第三方。」

这封请愿书还得到了国际机器人军备控制委员会(ICRAC)的支持。

而且,人们对这些离职抗议,还有签署请愿书的员工致以了敬意。

还有不少人在当时发推表示,「谢谢你谷歌。AI武器的危险绝对无法预料。」

后来,谷歌就禁止了之后再将其AI技术用于武器制造或是监控的应用。但是,用于网络安全以及搜救相关的军事应用还是可以的。

也正因如此,谷歌的业务才又开始涉足国防科技领域。比如,谷歌曾向美国空军提供过云计算服务,用于飞机的维护,以及飞行员培训。

谷歌还曾向美国海军提供过相关服务,用AI来检测船只的腐蚀情况。

有了谷歌的前车之鉴,说不定OpenAI能在此两者之间找到一个中间地带,求得平衡。既应用了最新科技,又能保证不造成任何直接或间接的伤害。

OpenAI本周二曾表示,该公司正在与五角大楼合作开展软件项目,其中包括与网络安全有关的项目。要知道,这与OpenAI之前禁止向军方提供人工智能技术的做法大相径庭。

该公司负责全球事务的副总裁Anna Makanju在世界经济论坛上表示,ChatGPT的创造者也在与美国政府讨论开发减少退伍军人自杀的工具,但她补充说,该公司将保留不准许进行开发武器的禁令。

一直以来,硅谷的科技巨头们和美国军方之间的关系都比较难以捉摸。OpenAI此次的措辞改变,证明了在立场问题上科技巨头们可能出现了软化。

上述提到的谷歌员工联名反对AI军用,也许是科技公司反抗政府的巅峰之作。在之后,谷歌和军方的合作至少给他们挣了5亿美元。

谷歌前首席执行官Eric Schmidt现在是国防工业的知名人士,他做了一个非常大胆的比喻:他将人工智能的到来比作核武器的出现。

他表示,「我认为AI驱动的自主性,以及去中心化的分布式系统就是如此强大,足以产生和核武器一样的作用。」

当然,他也提到了幻觉的问题。

虽说OpenAI的新措辞还是给自己留了不少后路,排除了用AI开发武器的可能,但是分析数据或者写代码这种用途也难说会怎么样。

也许,分析和利用数据这件事,在国防层面可能和战争相关的那些东西并没有那么明确的界限划分。

毕竟,安全问题无论何时都应该是我们心中的第一要务。

参考资料:

https://www.semafor.com/article/01/16/2024/openai-is-working-with-the-pentagon-on-cybersecurity-projects

https://www.theinformation.com/articles/chatgpt-coming-to-an-army-near-you

文章来自于微信公众号 “新智元”