如果说2023年主导网络安全行业的话题是什么,那肯定是AI。这既包括对恶意行为者如何利用AI的恐惧和担忧,也包括防御者如何利用AI来降低风险、保护组织以及创新和加速传统网络安全活动。

随着企业迅速采用AI工具、平台、应用程序和服务,网络从业人员争相提高自己在AI安全方面的技能,幸运的是,他们可以利用各种资源来学习。

我们今天要讨论的是OWASP AI Exchange。OWASP将自己定位为AI安全知识的首选资源,包括在2023年发布OWASP LLM Top 10榜单,该榜单记录了LLM系统的十大风险、以及如何降低这些风险的建议。

OWASP AI Exchange是一项令人难以置信的资源,它作为一项开源协作,推动了全球AI安全标准、法规和知识的开发与共享,涵盖AI威胁、漏洞和控制措施。

下面,让我们深入了解一下OWASP AI Exchange的核心内容。

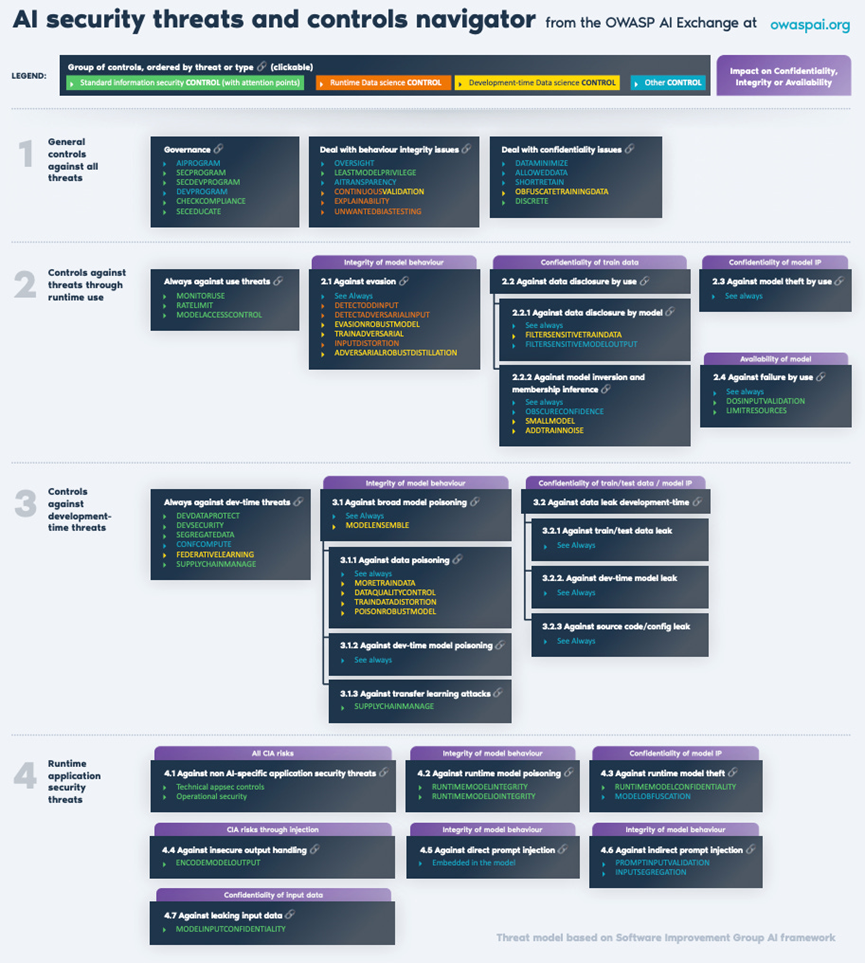

鉴于确保AI安全的复杂性,最好能有一个资源来快速概述各种威胁、控制措施以及它们之间的关系,幸运的是,OWASP AI Exchange提供了“导航器”,它涵盖了通用控制措施、针对运行时威胁的控制措施、针对开发时威胁的控制措施、以及针对运行时应用程序安全威胁的控制措施。

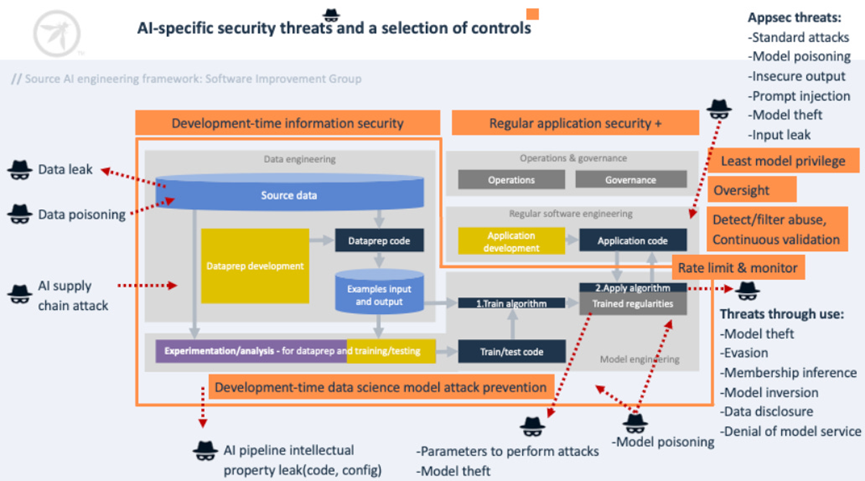

OWASP AI Exchange还首先提出了一些通用建议。这些建议包括实施AI治理、将安全和开发实践扩展到数据科学、根据AI的具体用例和细微差别增加对AI的监督等活动。AI可以而且已经有很多方式被利用,也存在各种威胁,如数据泄露、中毒甚至攻击AI供应链。如下是AI Exchange的图片。

OWASP AI Exchange还为企业识别相关威胁和相应控制措施提供了一种全面的方法。这包括通过威胁建模等活动识别威胁,确定组织内部应对威胁的责任,以及利用服务提供商、软件和供应商时的外部责任。

在此基础上,组织应选择可减轻已识别威胁的控制措施,并将这些控制措施与现有和新出现的标准相互参照。最后,组织将能够围绕风险接受度以及对已识别和接受的风险的持续监控和维护做出明智的决策。

与任何其他系统一样,AI系统开发也遵循一个生命周期,这就是为什么AI Exchange建议在AI SDLC的各个阶段开展活动。这些阶段包括安全设计、开发、部署以及运营和维护。

这些阶段在其他框架中也得到了很好的体现,例如NIST的安全软件开发框架(SSDF),该框架的各个阶段都有相应的任务和活动,以确保整个SDLC中系统和软件开发的安全。

有鉴于此,让我们来看看普遍的威胁以及与SDLC特定阶段(如开发和运行阶段)相关的威胁。

通用控制包括总体活动,如治理。这包括围绕模型和数据以及风险治理分配责任。这些工作旨在确保AI计划和使用不会作为更广泛的信息安全管理的一部分而被忽视。

具体的通用控制措施包括尽量减少应用中不必要的数据和字段,以避免潜在泄漏。它还包括确保只有经过许可和授权的数据才能用作模型训练活动的一部分或用于AI系统和平台。此外,数据应有明确的生命周期,保留或访问的时间不应超过必要的时间,以最大限度地降低风险。

可以而且应该使用标记化、屏蔽和加密等方法来保护培训数据集中的敏感信息,避免无意中泄露敏感数据。

对于企业来说,实施控制以限制意外行为的影响也至关重要,例如对训练数据的影响、对AI系统的操纵以及检测意外行为,并在意外或恶意活动产生影响之前对其进行纠正或阻止,并通知相关系统维护人员。

使用威胁的定义是通过与AI模型和系统的正常交互发生的威胁,如提供输入或接收输出。AI Exchange建议监控模型的使用,并在日志中捕获输入、日期、时间和用户等指标,以便进行事件响应。这些可能是不正常的模型运行、可疑的行为模式或恶意输入。攻击者还可能试图通过频率滥用输入,进行控制,如限制API的速率。

攻击者还可能试图影响模型行为的完整性,导致不必要的模型输出,如欺诈检测失败或做出可能影响安全和保安的决策。建议采取的控制措施包括检测奇异输入、对抗性输入和选择可规避的模型设计等。

在AI系统方面,OWASP的AI Exchange将开发期间威胁定义为常规应用程序开发范围之外用于数据和模型工程的开发环境。这包括收集、存储和准备数据和模型等活动,以及防范数据泄露、中毒和供应链攻击等攻击。

所引用的具体控制措施包括开发数据保护功能和使用加密静态数据等方法,实施数据访问控制,包括最低权限访问,以及实施操作控制,以保护存储数据的安全性和完整性。

其他控制措施包括相关系统的开发安全,其中包括人员、流程和技术。实施控制措施,如开发人员的人员安全,保护开发环境的源代码和配置,以及通过病毒扫描和漏洞管理等机制保护开发环境的端点。如果开发端点受到破坏,开发环境和相关培训数据就会受到影响。

综上所述,我们不难理解为什么零信任、DevSecOps和安全软件开发以及供应链安全等其他行业趋势对于确保AI开发和使用的安全也具有重要价值。

AI Exchange还提到了AI和ML物料清单(BOM),以协助减轻供应链威胁。它建议利用MITREATLAS的"ML供应链破坏"作为资源,以减轻对来源的担忧,并开展验证签名和利用依赖性验证工具等活动。

AI Exchange指出,AI系统归根结底也是IT系统,可能存在类似的弱点和漏洞,这些弱点和漏洞并非AI特有,但会影响AI所属的IT系统。这些控制措施当然可以通过长期的应用安全标准和最佳实践来解决,例如OWASP的应用安全验证标准(ASVS)。

尽管如此,AI系统也有一些独特的攻击载体,如运行时模型中毒和窃取,以及不安全的输出处理和直接提示注入,后者在OWASPLLM Top 10中也被提及,并在所列威胁/风险中占据首位。这是由于GenAI和LLM平台在过去12-24个月中的流行。

为了应对这些特定于AI的运行时AppSec威胁,AI Exchange建议采取运行时模型和输入/输出完整性等控制措施来解决模型中毒问题。对于运行时模型盗窃,可采取运行时模型保密性(如访问控制、加密)和模型混淆等控制措施,使攻击者难以理解部署环境中的模型,并提取洞察力来助长其攻击。

为解决不安全的输出处理问题,建议采取的控制措施包括对模型输出进行编码,以避免传统的注入攻击。

对于LLM系统来说,提示注入攻击尤其邪恶,其目的是通过直接或间接的提示注入,精心设计输入,使LLM在不知情的情况下执行攻击者的目标。这些方法可用于让LLM披露敏感数据(如个人数据、知识产权等)。

为了应对直接提示注入,OWASP LLM Top 10再次被引用,防止其发生的主要建议包括:对LLM访问后端系统实施权限控制,将外部内容与用户提示隔离,以及在LLM和外部来源之间建立信任边界。

最后,AI Exchange讨论了运行时泄漏敏感输入数据的风险。GenAI提示信息可能会被泄露给不应该泄露的一方,例如通过中间攻击者的攻击。GenAI提示可能包含敏感数据,例如攻击者可能想要捕获的公司机密或个人信息。这方面的控制措施包括通过访问控制、加密等技术保护模型参数的传输和存储,并尽量减少对摄入的提示信息的保留。

随着业界持续使用和探索AI功能,安全界必须继续学习如何确保AI系统及其使用的安全。这包括内部开发的具有AI功能的应用程序和系统,以及与外部AI平台和供应商的组织互动。

OWASP AI Exchange是一个极好的免费开放资源,从业人员可以从中更好地了解风险和潜在的攻击载体,以及应对AI特定风险的建议控制和缓解措施。正如OWASP AI Exchange的先驱和AI安全领导者Rob van der Veer最近所说,AI安全的很大一部分是数据科学家的工作,而AI Exchange等AI安全标准和指南可以提供帮助。

安全专业人员应主要关注OWASP AI Exchange Navigator中列出的蓝色和绿色控制措施,其中包括经常将长期存在的AppSec和网络安全控制措施和技术纳入使用AI的系统中。

原文链接:

https://resilientcyber.substack.com/p/digging-into-the-owasp-ai-exchange

文章来自于微信公众号 “安全喵喵站”,作者 “CHRIS HUGHES”