DALL⋅E 想象的 2023 年 AI for Science(与AI4Science目前的发展类似:图像不完美,许多单词拼写错误)。

2021年,一群热血青年提出了要把AI4Science(AI for Science)带入机器学习顶会NeurIPS。

什么?AI4Science是一门学科吗?是不是靠着AI蹭热点?各种质疑声接踵而来。

这些质疑和不解也反映在了第一届AI4Science workshop的较为平淡的群众参与度上。

时过境迁,两年的时间见证了DeepMind基于AlphaFold建立Isomorphic Lab,微软建立AI4Science Initiative, 以及国内深势科技,AISI等大力推动AI4Science建设的企业,学术机构的不断发展壮大。

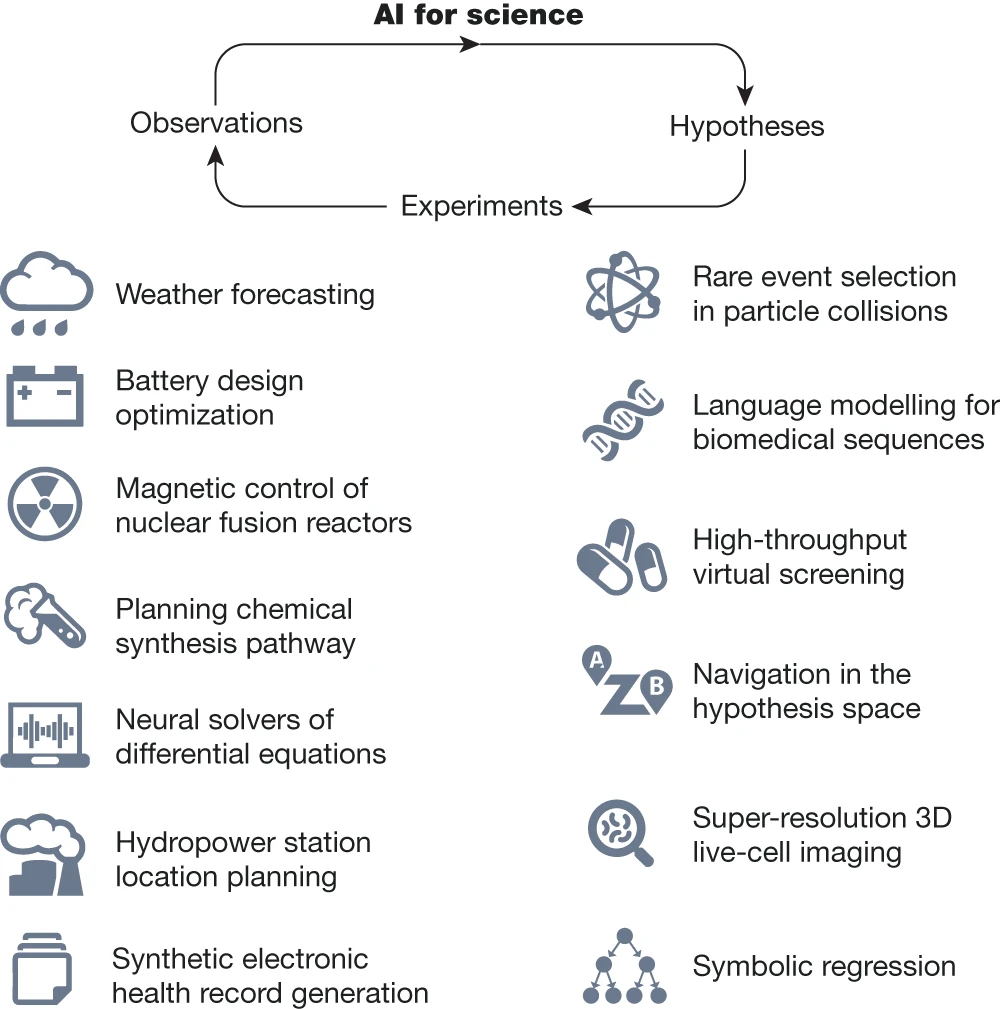

2023年8月,Al4Science workshop组织者们还在《自然》杂志上发表了一篇综述文章,总结了过去几年里Al4Science在科学发现流程上的进展,并为未来指了指路。

去年12月NeurIPS,AI4Science workshop收到超过200篇投稿和上千人次的参与,俨然成为了NeurIPS最大的workshop之一。看到这些数字,似乎已经没有人再说AI4Science是伪命题了。

近日,Al4Science workshop组织者们发表一篇博客。提到了为什么要强调AI4Science?总结了AI4Science在2023年取得的进展,涵盖了从化学、生物、计算机科学/数学科学、物理、地球科学、神经科学到医学的各个领域。最后,组织者们送上了他们对AI4Science在2024年发展的期望。

Blog 地址:https://medium.com/@AI_for_Science/ai-for-science-in-2023-a-community-primer-d2c2db37e9a7

为什么要强调AI4Science?

随着AI在多个学科各放异彩,另一个问题接踵而至,为什么要强调AI4Science,大家分别做AI在子领域的应用,比如AI4Drug和AI4Materials,不就好了吗?组织者们指出了这样几个原因。

AI4Science在2023年到底有什么进展呢?

说了这么多,AI4Science在2023年到底有什么进展呢?组织者们先是给出了一些概括性的总结:

回顾2023一年的AI4Science,组织者们将七大学科分了分类,其中物理,化学材料,生物和医药的发展日益成熟,慢慢与实验结合并且逐渐走向商业化。

物理

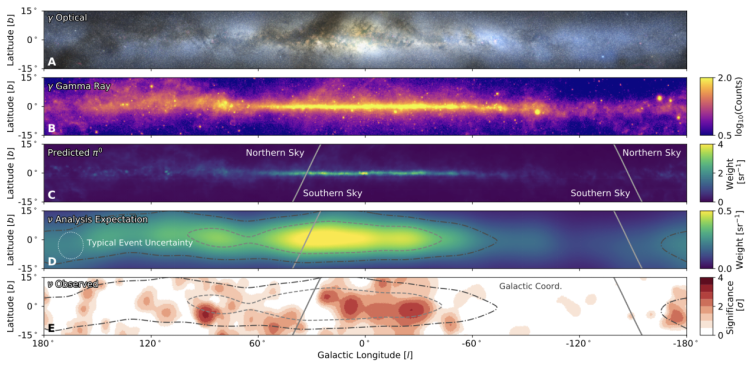

处理完首张黑洞照片后,AI又帮助人们识别了高能中微子信号。

IceCube团队使用机器学习模型分析来自IceCube Neutrino Observatory的数据,区分信号和背景数据,这使得高能中微子从银河平面的发射被以前所未有的精确度检测到。研究使用卷积神经网络进行事件选择,其高速推理(几毫秒)能力使得研究者可以采取更为复杂的事件筛选策略。

通过十年的观测数据,机器学习模型不断完善,学会了在宇宙噪声的背景下精准地锁定中微子的特征。这些发现揭示了具有4.5西格玛重要性的中微子发射,强调了银河系内潜在的来源。

在这一背景下,机器学习的创新使用不仅增强了天文台的检测能力,而且为未来的天体物理探索提供了模式。

化学与材料

AI在化学材料的各个领域大放异彩。在自动化化学和材料合成领域,如Koscher等人的研究以及Szymanski等人的A-Lab项目展示了人工智能与物理世界之间的桥梁。这些项目通过自动化实验室和基于云的方法,发现了新的染料分子和无机材料。

在大型语言模型的应用方面,如Coscientist和ChemCrow项目利用LLM规划实验,实现了与互联网、模型和实验设备的交互,展示了LLM在自动化任务和复杂实验室操作中的巨大潜力。

此外,DeepMind的GNoME团队通过机器学习的方法预测了大量的材料候选者,展示了深度学习在材料科学中的应用。

最后,像MIT和Cornell的研究团队开发的OA-ReactDiff扩散模型,在化学反应的过渡状态搜索方面取得了重要进展,提供了一种比传统方法更快更有效的替代方案,并能探索未预期的反应路径,助力新催化剂的发现和复杂反应的研究。

生物

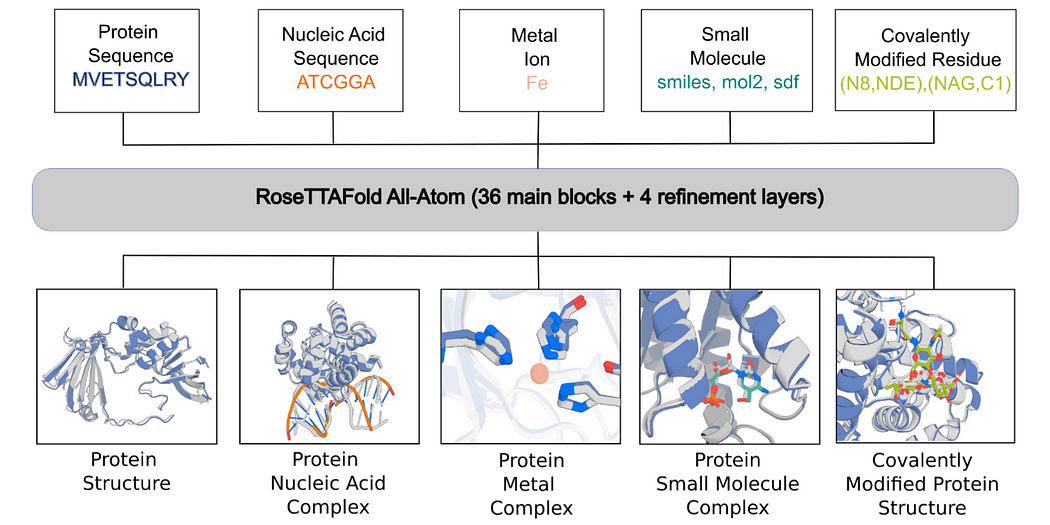

领域聚焦到理解蛋白质与其他生物小分子和大分子的相互作用。

其中,RosettaFold-AA和AlphaFold-latest作为两个杰出的代表,不仅仅局限于蛋白质结构预测,还扩展到预测蛋白质与小分子、蛋白质、核酸等生物分子的相互作用。

除了对静态的蛋白结构的研究,大家的也将目光聚焦在了研究蛋白构象空间,比如AF-Cluster通过改变多序列比对来控制AlphaFold输出不同构象。

相对于对蛋白质结构和功能的理解,蛋白质设计专注于设计新的蛋白质或修改现有蛋白质以实现特定的结构和功能。

在几何深度学习和生成式AI领域(特别是扩散模型)取得进展的基础上,RFDiffusion和Chroma提出了包含空间对称性(旋转、平移和反射)的扩散模型,用于生成新蛋白质。

除了从头设计外,他们还提出了灵活设计和优化蛋白质的方法,比如基于结合靶标,功能,结构的条件,以及基于模型提供指导的结构或功能优化。

医药

AI在医药学方面的应用已经充分结合实际应用场景并趋于工程化。

Moor等人提出了一种通用医学人工智能(GMAI),该系统能够解释多模态数据,如影像学、电子健康记录、实验室结果、基因组学、图形或医学文本。GMAI以自监督方式在大规模、多样化的多模态数据上进行预训练,并能够执行多样化的医学应用。

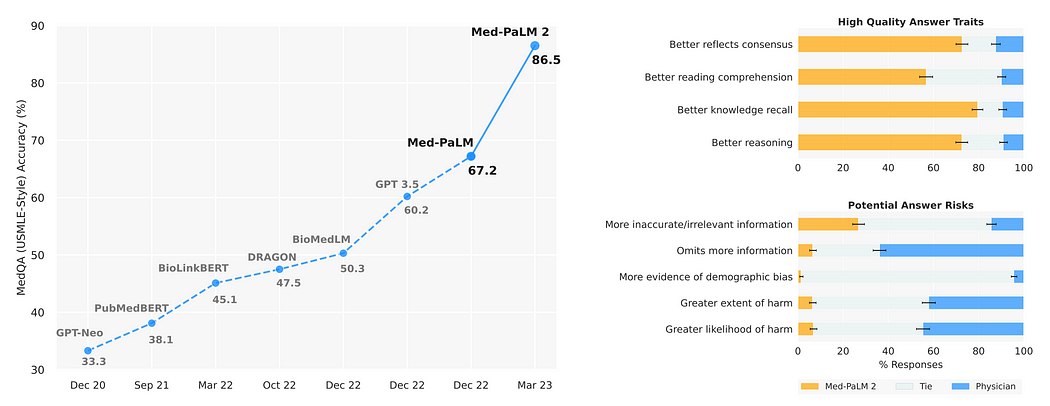

Singhal等人策划了一个在医学领域的大规模问答数据集,并提出了基于PaLM(Google的大型语言模型)的医学领域大型语言模型,也被称为Med-PaLM, 并首次作为AI模型通过美国医学执业考试。

几个月后,同一组作者提出了Med-PaLM的第二个版本(Med-PaLM 2)。如图所示,Med-PaLM 2取得了显著的里程碑(86.5%(Med-PaLM2),67.2%(Med-PaLM)),成为第一个达到与人类专家相媲美的水平,能够回答USMLE风格问题。医生们注意到该模型在回答消费者医学问题的长篇答案方面有显著的改进。

同时,AI4Science也在一些领域,比如数学理论,地球科学和神经科学开辟了新的赛道并在高速发展。

数学理论

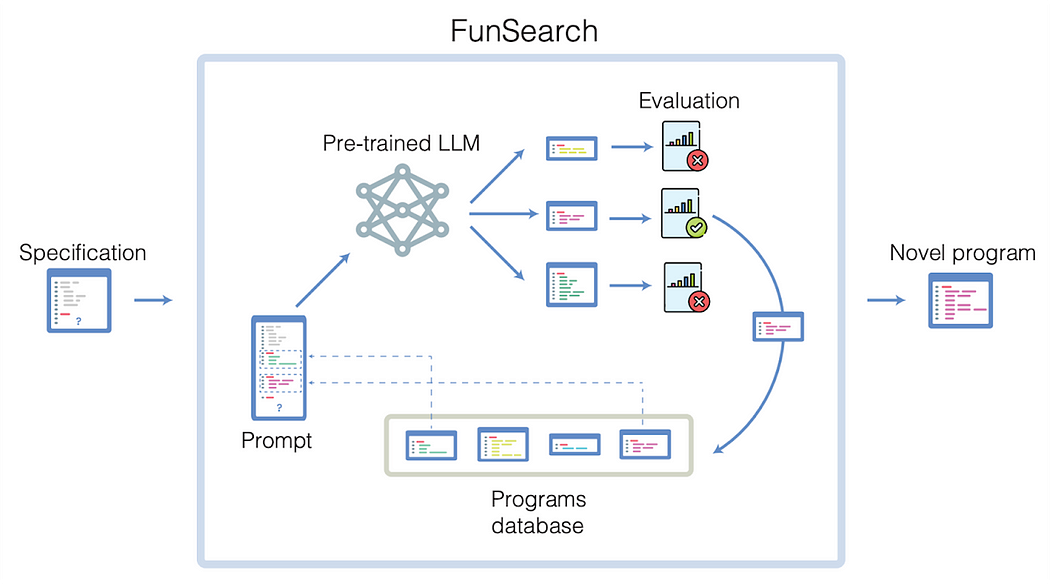

今年,LLM开始发现新的理论和算法。DeepMind的一项最新研究(FunSearch)展示了LLM用于发现解决复杂组合问题的新程序的潜力。FunSearch的主要目标是找到更好的程序来解决难题。

具体来说,它采用了一种在预训练LLM和评估器之间的迭代和进化过程。在这个过程中,进化算法从程序池中选择最佳程序候选,输入到LLM中进行改进。然后,修订后的程序被评估、打分,并重新放回池中。在这个进化过程中,提出了更好和新的程序。他们验证了FunSearch在两个组合优化问题——cap set和在线装箱问题上的有效性,FunSearch找到了比已知最佳解决方案更好的解决方案。

地球科学

AI技术实现了在天气预测这一传统上极具挑战性的任务突破性的进展。

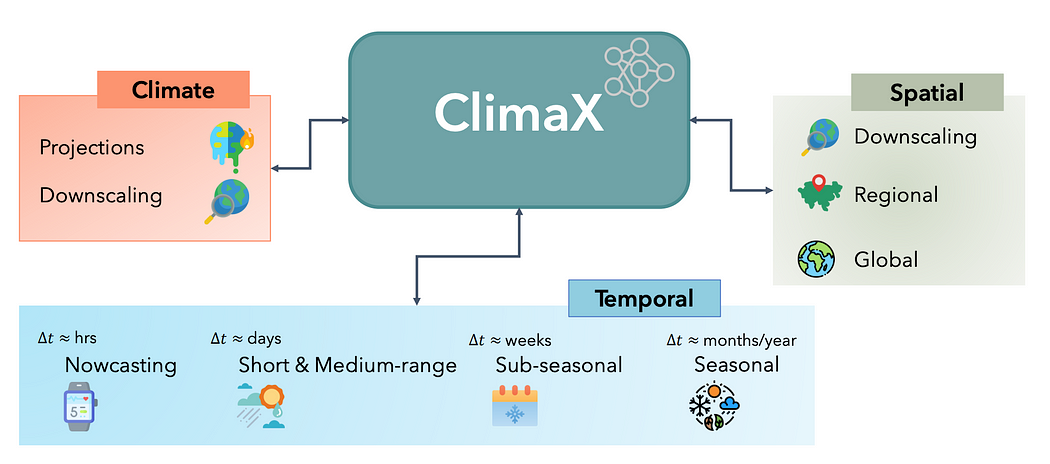

项目如ClimaX、GraphCast、Pangu-Weather、MetNet-3和PreDiff利用了数十年的历史天气数据和数值物理模拟结果,推动了在短期和中期天气预测方面的高分辨率时空预测技术。这些成就在很大程度上依赖于高性能计算资源和对大量数据的复杂处理。

特别值得一提的是,GraphCast通过其独特的“编码器-处理器-解码器”结构的图形神经网络,专门处理空间结构化的天气数据。而ClimaX则以其全球和区域范围的模型及通用基础模型而闻名,这些模型可以根据任意组合的输入变量预测任意时间点的天气情况。

除了天气预测,人工智能还在数据有限的地球科学领域取得了进展,例如地下结构、生物学和火山学。在这些领域,轻量级的人工智能代理模型正在替代传统的、计算密集型的数值物理模拟。这些模型不仅加快了预测速度,还提高了决策过程的效率。

神经科学

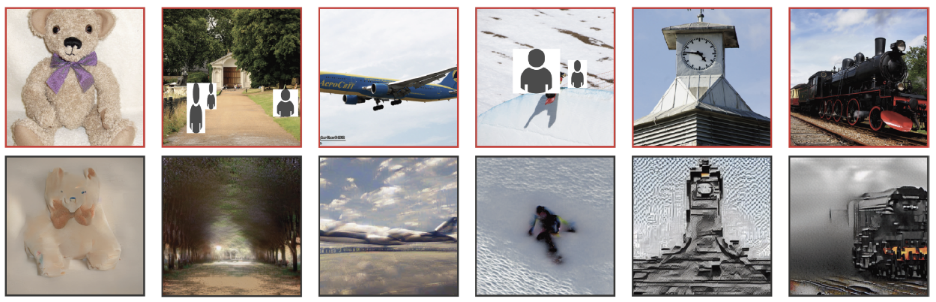

AI从脑波中重建图像,为人类提供了深入了解大脑中的世界模型的机会。尽管这一任务一直极具挑战性,生成模型的创新(尤其是隐空间扩散模型)使得这一任务变得可能。

如果将大脑活动数据解释为“文本”,那么我们就能够生成基于脑活动数据的图像。令人惊讶的是,这一任务无需训练复杂的神经网络,只需使用预训练的稳定扩散模型,仅训练从脑数据到潜在向量和上下文向量的线性映射。

此外,AI还被用于理解神经活动和行为的对应。一种称作CEBRA的方法能够应用于基于假设和探索性的分析,并展示了表示在多次实验、动物和模态之间对神经活动解释的一致性。这一方法最小程度地利用神经编码中的时间结构,大大提升了结果的鲁棒性,有希望成为神经科学研究中的有力工具。

未来的展望和挑战

最后,经历了2023年的疯狂,组织者们送上了他们对AI4Science在2024年发展的期望:

本文由部分AI4Science workshop组织者联合撰写:程立雪,杜沅岂,段辰儒,Ada Fang, 符天凡,高文昊,黄柯鑫,刘子鸣,罗迪,王莉晶 (按姓名拼音排序)。

更为详尽的英文原稿博客见:https://medium.com/@AI_for_Science/ai-for-science-in-2023-a-community-primer-d2c2db37e9a7

文章来自于微信公众号“机器之心”,作者 “ScienceAI”

【开源免费】OWL是一个完全开源免费的通用智能体项目。它可以远程开Ubuntu容器、自动挂载数据、做规划、执行任务,堪称「云端超级打工人」而且做到了开源界GAIA性能天花板,达到了57.7%,超越Huggingface 提出的Open Deep Research 55.15%的表现。

项目地址:GitHub:https://github.com/camel-ai/owl

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner