AI的精神状态很优美

Stable Diffusion是一个生成式AI模型,简单点来说就是一个会画画的AI,当你输入一个关键词后,它就能创作出一个相关的图像。

比如,让他画一个骑在马上的宇航员,它就能很快创作一张(看起来像是真的)相关照片。

画得挺好。|wiki

AI 难道已经可以变成可以替代人类的画家了吗?然而,有一些Stable Diffusion XL(以下简称SD-XL)似乎得了病,变得不那么“聪明”,还输出了一些莫名其妙的东西。

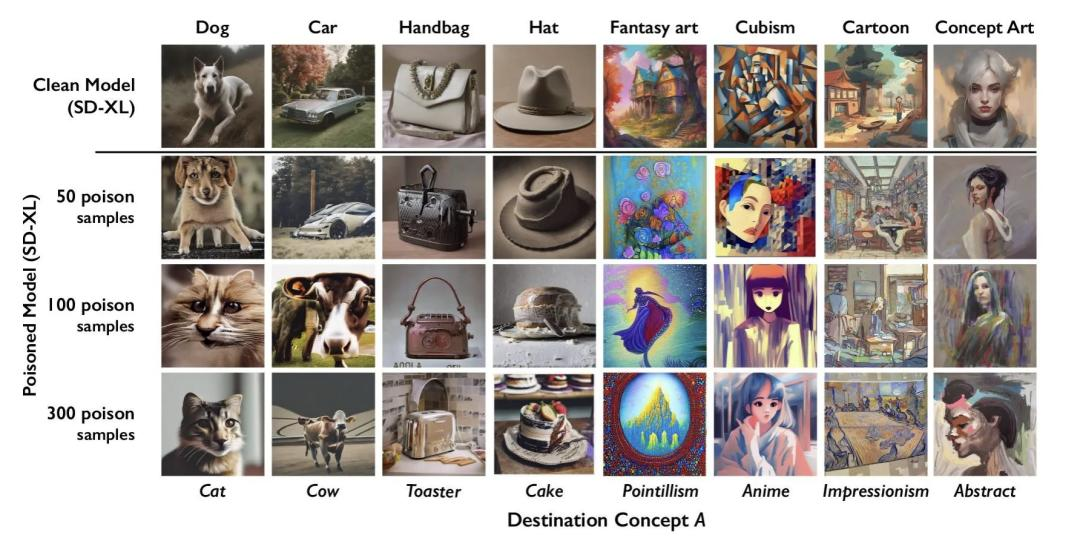

当你要求SD-XL画一只狗,它:

而病得更重SD-XL则输出了一只猫。

怎么回事啊!AI怎么忽然指猫为狗了,而更奇怪的是,当你让AI画一辆车,它则输出了一只牛。

在下面这张图片中,你可以看到,AI确实病得不轻,狗、车、帽子最后都变成了完全不相关的猫、牛、蛋糕。它似乎没办法再输出一张像上文描述的“宇航员”一样准确的以假乱真的图片。

第1排是正常SD-XL生成的图片,而第2、3、4排分别是由病的不同程度的SD-XL生成的图片。|参考资料1

之所以会这样,是因为人们开发了一款让生成式AI“中毒”的软件。

Nightshade由芝加哥大学的研究人员发布,是一种能够破坏生成式AI模型的工具。AI靠大量训练数据来更新迭代,变得更加聪明,而Nightshade所做的,就是在训练数据中加入一些肉眼难以看见的“毒素”,干扰AI的学习,从而让AI模型以混乱且不可预测的方式崩溃。

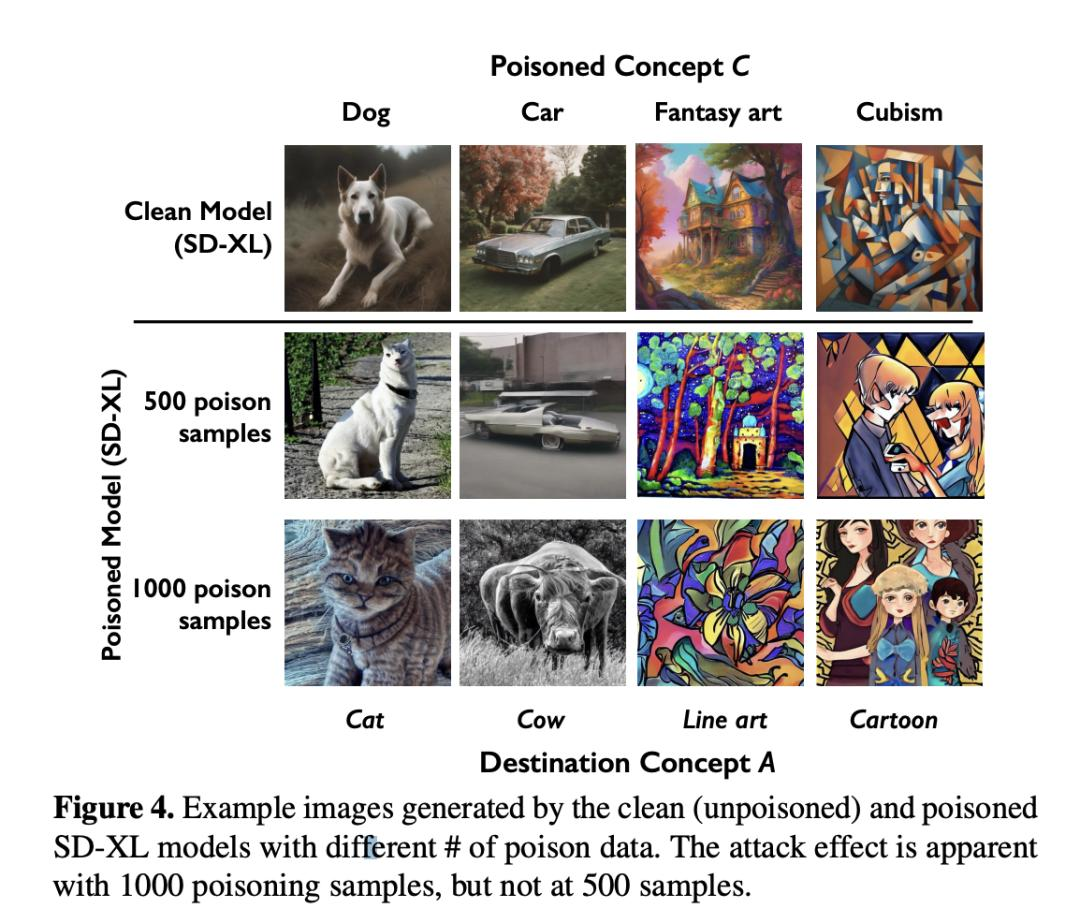

而上面你所看到的,正是经过Nightshade干扰的AI,在没有中毒前,AI的确能准确地输出一张狗和车的照片,而在500次和1000次“有毒”训练数据的训练后,AI开始输出乱七八糟的内容。

经过“毒害”后,AI没办法再按照指令作画了。|参考资料1

要给AI“下毒”的原因,与我们在AI时代不得不面对的种种问题相关。自生成式AI变得越来越聪明以来,制造AI的科技巨头们也面对着接连不断的诉讼和争议,艺术家们认为,他们的作品是受到版权和知识产权保护的,但OpenAI、Meta、Google 和 Stability AI却直接拿作品来进行数据训练,这是一种“窃取”行为。

2024虽然才过去1个月,但AI与知识版权相关的争议已经闹得沸沸扬扬。2023年12月27日,《纽约时报》对微软和OpenAI提起诉讼,指控OpenAI侵犯其文章版权,进行大规模复制来训练生成式AI。

纽约时报是第一家对 OpenAI 及其主要投资者微软提起诉讼的主要媒体出版商。有人预测,未来可能会有更多相关诉讼。|giphy

1月25日,社交平台X限制了平台上对泰勒·斯威夫特的名字搜索,原因是X上流传着大量和她相关的假图。这个令人震惊的事件更是一个警醒,它意味着,任何人的照片都可以被AI制成令人难以忍受的假图,我们很可能因为这个而受到严重的伤害。

Nightshade便是一个具有攻击性和操纵性的工具,需要的艺术家可以下载这个工具,对AI进行错误的训练并导致其故障,用以保护自己的作品。而为了不让AI“中毒”,开发AI科技巨头们也将不得不正视并解决一个问题:如何尊重艺术家的作品版权。

在自今年1月18日发布后的五天内,Nightshade的下载量就已经达到了25万次。

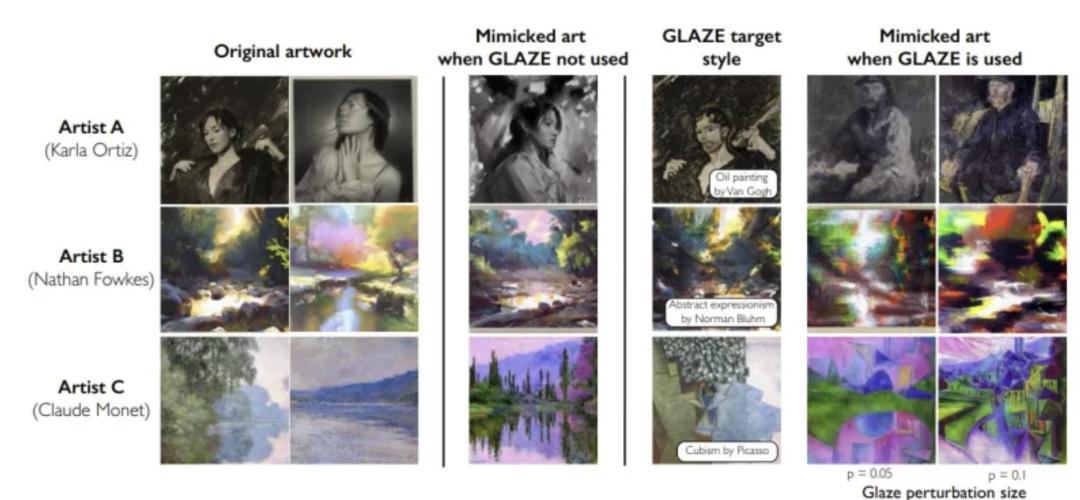

事实上,在开发Nightshade之前,芝加哥大学的这个团队还推出过另外一款保护艺术家的免费应用程序:Glaze。和Nightshade类似,Glaze也是给图片施加一些微小的改变,让AI难以辨认一副作品的风格。

第1、2列是艺术家的风格,第3列是没有用Glaze时,AI的仿制品。第4列是用了Glaze时,AI以为自己看到的。第5、6列则是AI在学习经Glaze处理过后的图片后,生成的(风格完全不相关的)“仿制品”。|参考资料3

当一位艺术家用Glaze“改造”了自己的抽象风格作品(举个例子),然后将其发布到网上,被AI抓取学习后,AI可能会将其错误地理解为写实风格。日后也会输出一些毫不相关的东西。Glaze这个工具主要是保护艺术家,以免他们独特的风格被AI学走。而Nightshade则主要是为了攻击不顾版权的AI。

这些工具是如何给AI“投毒”的呢?此项目负责人Ben·Zhao在接受科技媒体采访时解释道:这是因为AI和我们人类感知世界的方式存在根本性的差距。

他说:“正是因为这两个世界如此不同,我们就可以实现机器学习视角中,效果如此显著的失真,而在人类视角中失真的程度最小。”

在人眼看来,经Glaze处理过的图片(右)和原图(左)差别很小。|参考资料3

而由于生成式AI的特性,这种“投毒”也会污染到其他相关的词,当它污染了“狗”,也会相应地污染“哈士奇”、“狼”等类似的词。而且在截图、拍照后,这种“毒素”依然存在。

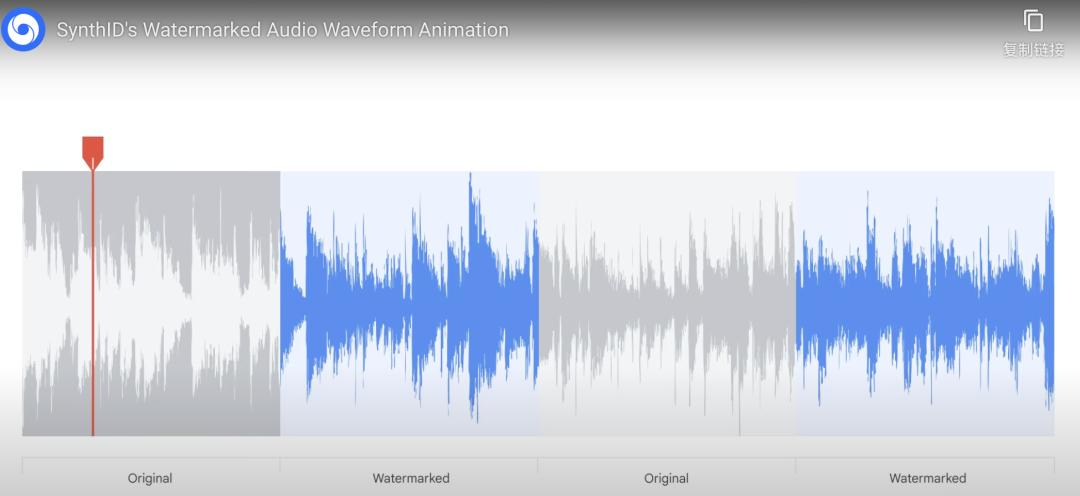

还有一些工具,比如DeepMind团队在2023年8月推出的SynthID,则是给AI生成的作品加上一个“看不见的”水印,这样大家以后可能就知道哪些照片是AI伪造的。

除了图片,SynthID还能给AI生成的音乐也加上“听不见的”水印。

如今,创建Nightshade和Glaze团队还提出要把这两种软件集成在一起。不过,工具也需要不断更新,Glaze团队自己也提到,这“并不是对抗 AI 模仿的永久解决方案,我们今天使用的技术总有可能被未来的算法所挑战。”

不过如今,有越来越多的人尝试用这种工具来保护自己,证明它的有效性,在这个过程中,我们也许可以渐渐弄清我们与AI的关系到底意味着什么。

参考资料:

[1]https://arxiv.org/abs/2310.13828

[2]https://nightshade.cs.uchicago.edu/whatis.html

[3]https://glaze.cs.uchicago.edu/media.html

[4]https://venturebeat.com/ai/ai-poisoning-tool-nightshade-received-250000-downloads-in-5-days-beyond-anything-we-imagined/

[5]https://www.nytimes.com/2023/12/27/business/media/new-york-times-open-ai-microsoft-lawsuit.html

[6]https://theconversation.com/taylor-swift-deepfakes-a-legal-case-from-the-singer-could-help-other-victims-of-ai-pornography-

222113#:~:text=X%20temporarily%20blocked%20searches%20of,the%20US%20against%20deepfake%20content.

[7]https://techcrunch.com/2023/03/17/glaze-generative-ai-art-style-mimicry-protection/?

guccounter=1&guce_referrer=aHR0cHM6Ly93d3cuZ29vZ2xlLmNvbS8&guce_referrer_sig=AQAAAMMZmSZrsX9vtCLov-

KTHMYGo4U7Rvopyqyq9_jm95HoXkB0qBsz1JKrhoF0Ltp7cFPgDaCNb-_I5Zxnt5O8nCUpsmrQ28WbTo_2L2Tv0h2_5sKYOuS9_2_CP7ZxG7A7OhFE4HGiMWwSxjSFRaHtY1SHoSljJkFYeWlR6QO-yXSz

文章来自于微信公众号 “把科学带回家”(ID:steamforkids),作者 “万物杂志”