多模态大模型,首次本地部署在安卓手机上了!

现在,对着手机AI助手,输入照片、语音,都能自如对话,所有功能完全在终端侧运行。

MWC 2024首日,高通就放大招,通通聚焦终端侧AI。

手机上能跑多模态大模型之外,全球首个在Windows PC上运行的音频推理多模态大模型演示,也来了。

它能理解音频并进行推理、可实现语音输入的多轮对话。

最后,高通还发布了面向开发者的AI Hub,让开发者可以更加方便在手机、PC上开发大模型应用,目前已支持超过75个大模型。

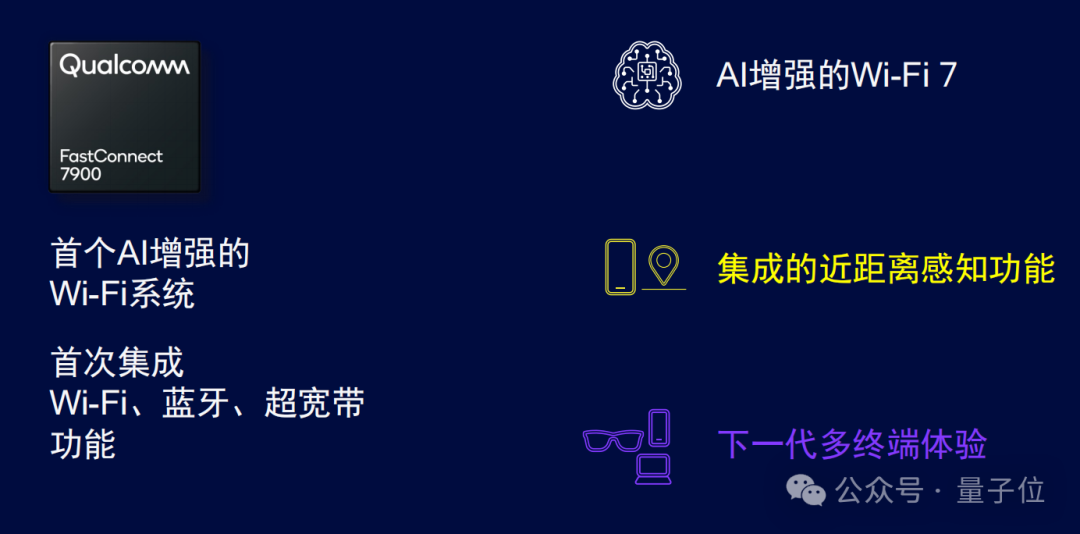

以及连WiFi系统都要被AI增强了,高通最新一代WiFi 7解决方案FastConnect 7900,同样面向混合AI时代而来,是全球首个使用了AI增强的WiFi系统。

高通这一套组合拳,只为证明一件事:终端侧AI趋势,现在已经到来。

高通这一次秀肌肉,核心展示了生成式AI在手机、PC端侧运行的新突破。

而且在官方资料中,多次强调了“所有功能完全在终端侧运行”——但尚未明确是否都是在不联网条件下实现的。

不过总而言之,终端侧能跑更多AI大模型,对于终端变革、用户价值变革,绝对都是大消息。

具体细节,来看官方放出的演示。

安卓机方面,高通将生成式AI的本地运行拉升到了多模态级别。

首个在Android智能手机上运行的大语言和视觉助理大模型(LLaVA),可接受包括文本和图像在内的多种类型的数据输入,并可基于输入内容进行多轮对话。

现在,用户可以拍一张照片向AI助手提问:

这些食材都是什么?它能做什么菜?每道菜的热量是多少?

AI助手就能基于照片信息给出回答。所有功能都完全在终端运行,可以进行多轮对话、保障响应速度。

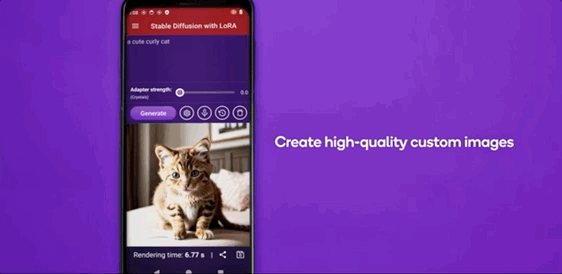

另外,高通还发布了可在安卓手机上运行LoRA的实例。

LoRA能在不改变底层模型的前提下,调节或定制模型的生成内容,通过使用大小仅为模型2%的适配器,即可个性化定制生成式AI模型。

比如Stable Diffusion就可以通过LoRA进行定制化调整。大语言模型也可以通过LoRA定制为个人助理、改进翻译能力等。

PC方面同样强调多模态能力的本地部署。

现在,在Windows PC上可以运行音频推理多模态大模型,能够实现由语音完成多轮对话。

搭载骁龙X Elite的Windows PC将可以理解鸟叫、音乐或者各种声音。比如它能听歌进行相似推荐。

与此同时,高通还“翻译”了一下什么叫真正意义上的AI PC。

骁龙X Elite的NPU运算能力高达45TOPS,两台设备同时运行集成Stable Diffusion插件的GIMP(一款广受欢迎的图像编辑器)进行AI图像生成。骁龙X Elite只需7.25秒就能生成一张图像,速度是X86竞品(22.26秒)的3倍。

开发者方面,高通推出全新AI Hub。

它支持超过75个模型,传统AI模型和生成式AI模型都有,比如ControlNet、Stable Diffusion、Baichuan-7B等,可在骁龙和高通平台上部署。

开发者选择好所需模型、所用框架,确定目标平台(比如特定型号手机或芯片)。高通AI Hub就可以为开发者提供面向指定应用、指定平台进行优化的模型。只需几行代码即可获取模型,并将模型集成进应用程序。

高通表示对AI Hub支持的每个模型都进行了优化,基于高通的AI引擎可以达到4倍推理加速,同时占用内存带宽和存储空间也将减少。

这些优化模型可在高通AI Hub、Hugging Face和GitHub上获取。

为什么要用AI增强WiFi?

因为高通认为,AI的未来是混合AI,也就是需要跨云端、终端和边缘云。

因此也给连接提出更高要求。

在MWC 2024上,高通带来全新一代WiFi 7解决方案:高通FastConnect 7900系统。

这也是全球首个AI增强的WiFi系统,集成了近距离感知功能。

此外,这也是高通首次在6nm芯片上集成了蓝牙、WiFi和超带宽,达到“以一顶三”的效果。

相较于上一代,7900采用了全新的射频前端模组和架构,在降低40%系统功耗的同时提高能效;该系统还助力减少25%占板面积,从而留出更大的电池空间以提升续航能力。

而在今年MWC上,高通不仅发布一系列终端AI技术,一系列搭载骁龙8 Gen 3的旗舰机也纷纷亮相,比如荣耀Magic6 Pro、OPPO X7 Ultra、小米14 Pro等。

它们带来了AI扩图(小米)、AI创建日程(荣耀)、AI图像消除(OPPO)等功能。

AI手机元年与否或许还有争议,但终端侧的AI落地,正在在高通的底层驱动下,走向Everywhere、Everyone……

参考链接:

https://www.qualcomm.com/news/media-center/press-kits/mwc-barcelona-2024

文章来自于 微信公众号“量子位”(ID: QbitAI),作者 “z明敏”