2024年第一个四分之一还没过完,PC市场的最热关键词,已是非「AI」莫属。

最新消息,继联想、荣耀之后,微软的首款AI PC马上也要来了。

据Windows Central爆料,微软将于3月21日发布新款Surface Pro和Surface Laptop。

两款新品围绕人工智能打造:

硬件方面,Intel版本搭载号称“AI CPU”的全新Intel Core Ultra,arm版本则用上了能把130亿参数大模型塞进PC的高通骁龙X Elite。

软件方面,两款新品均将首批支持Windows 11的“下一代”AI体验,包括一个内部名为“AI Explorer”的全新AI功能。

消息人士称,AI Explorer将会“使AI PC与非AI PC完全区分开来”,依靠自然语言交互,用户就能在PC上完成一切。

(贾维斯内味儿,这不就来了吗doge)

这还不算完,各种老牌PC玩家也都坐不住了,纷纷放出自家首款AI PC的消息。

由大模型技术风暴掀起的「模力时代」中,我们日常使用的生产工具正在加速变革。

这样的趋势,现在越发明朗。而终端产品的变革,也意味着,对于人们的日常工作生活而言,新一代的办公、学习姿势已经在酝酿之中。

那么,问题来了——

对于普通打工人而言,产品概念花里胡哨,但究竟怎样的PC,才算是真正的AI PC?

终端侧AI趋势开始后,终端、芯片、应用厂商正在用一个个面向生成式AI的芯片逐步补全关于AI PC的定义。

最先勾勒出想象的是微软。

去年9月,Colpilot正式进入Windows 11,成为电脑系统的AI助手。

这彻底掀开PC上自然语言交互的序幕,更改设置、整理桌面、打开软件都能通过聊天的方式实现。

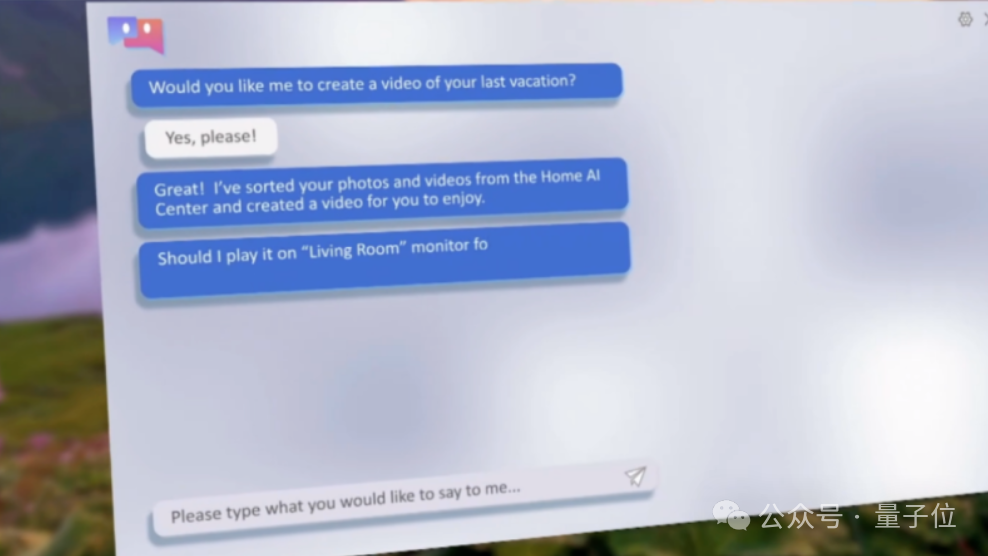

联想紧随其后,推出首款AI PC,展示了大模型运行在本地后,给用户带来更加专属化的体验。

基于用户个性化信息创建本地知识库,量身定制完成一系列新任务。

比如基于电脑上的家庭照片和视频,创作一段“智能剪辑”。

再或者是成为更本地化的工作助手,帮助写文档、总结知识点、提升生产力。

与此同时,最关键的底层芯片也重大更新。

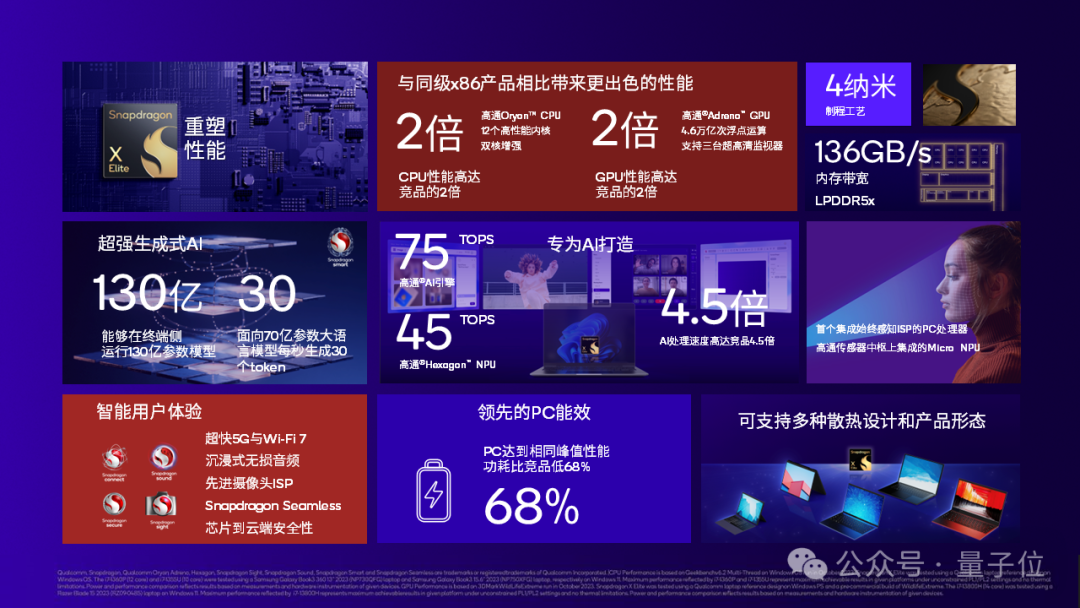

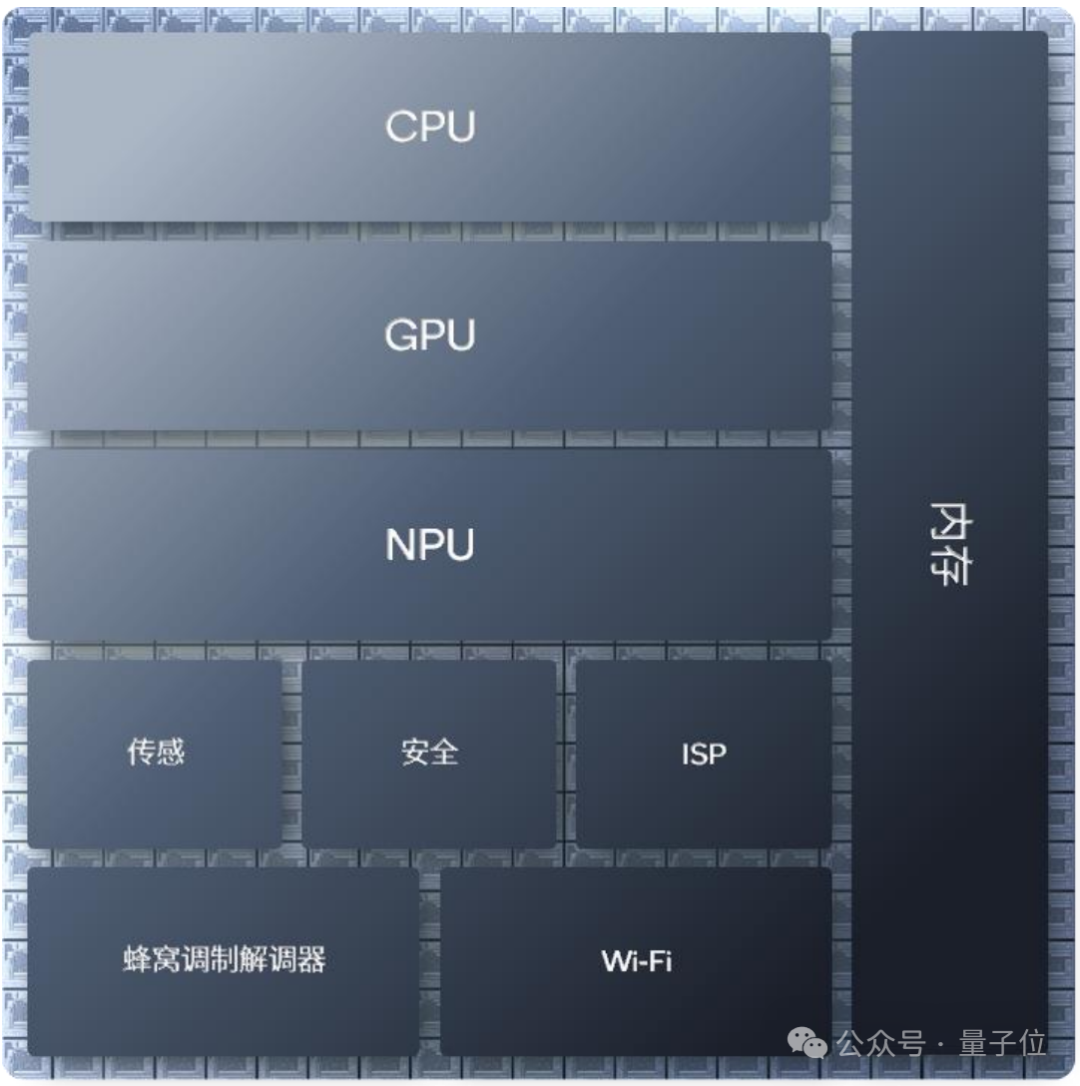

高通发布骁龙X Elite,就从底层角度给出了关于AI PC的一系列思考。

这块4nm制程的CPU支持130亿参数大模型的本地运行,70亿参数模型可每秒生成30个token。

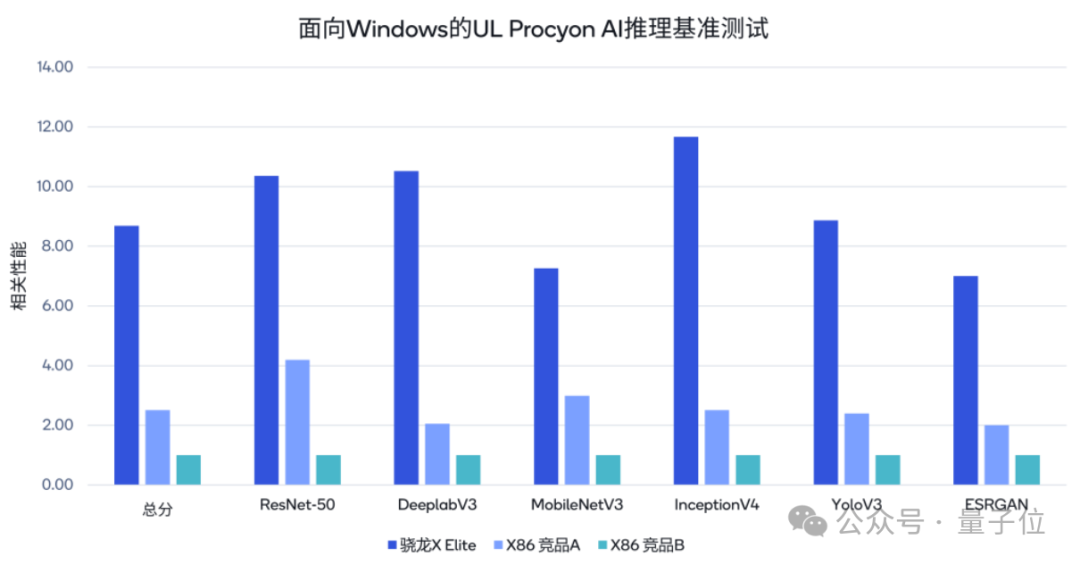

AI引擎算力可达75TOPS,AI处理速度可达竞品的4.5倍。

CPU、GPU性能均是竞品的2倍,相同峰值性能功耗比竞品低68%。

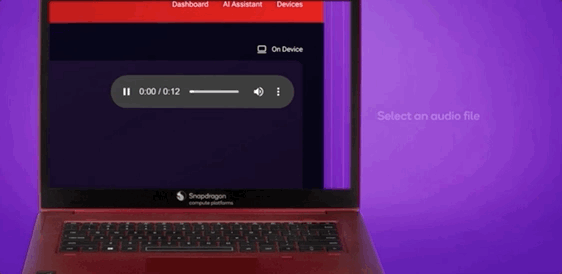

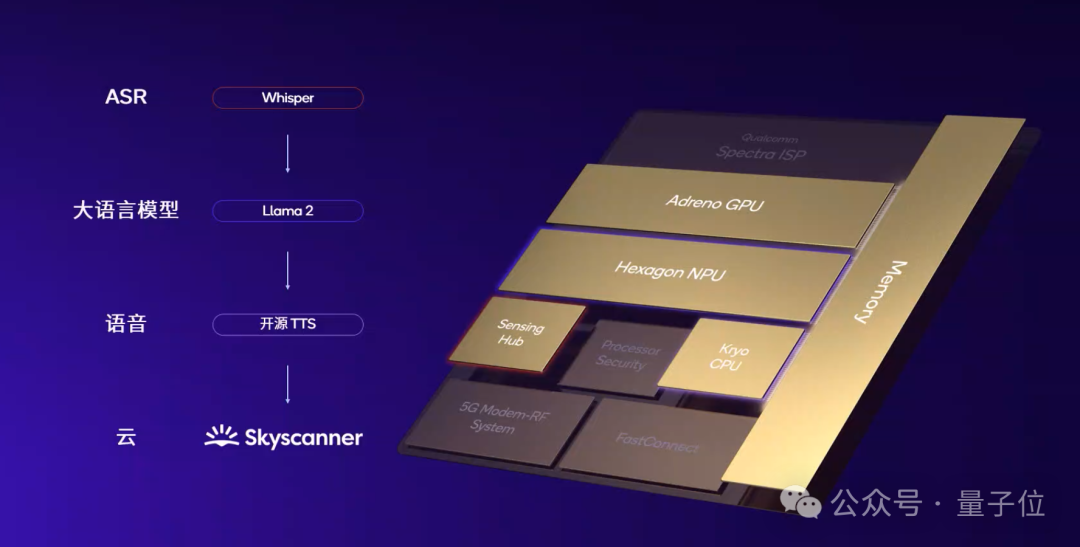

除此之外,刚落幕不久的MWC 2024上,高通还展示了多模态大模型在PC本地运行的示例。

它能理解音频并进行推理,可实现语音输入的多轮对话。

这意味着,AI PC趋势和多模态趋势正在交汇融合,传统PC的交互方式将发生更加彻底的变革。

透过厂商们的实际动作,一些关于AI PC的初步共识已逐渐清晰。

即AI PC应该成为一个用户专属的个人助理,它具备强大的AI能力和底层计算能力,将人类从日常生活中常规的、重复性的、看似琐碎的工作中解放出来,转而从事更加具有创造性、求变的工作。

但问题是,现在的传统PC如何才能走到这一步?哪些地方已经悄然发生改变?

技术趋势给出了一定答案。

面向生成式AI,PC要经历的是一场全新计算架构的变革。从底层硬件到上层应用,都正在发生变化。

因为生成式AI浮现出的典型场景,给计算连接等都提出新要求。

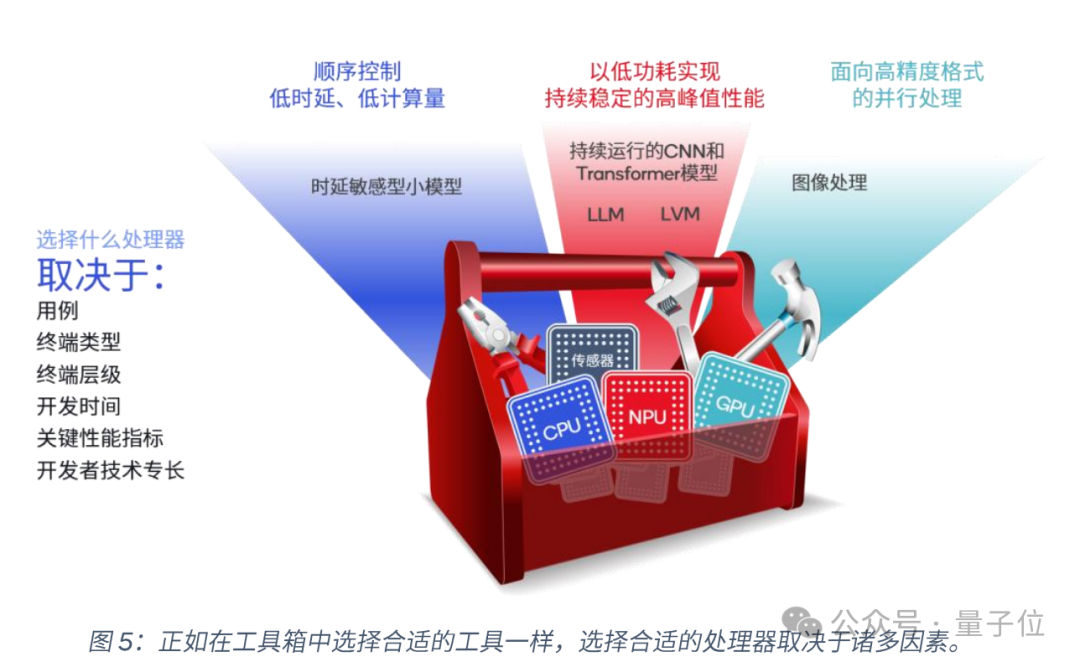

高通最新公布的《通过NPU和异构计算开启终端侧生成式AI》白皮书中总结,生成式AI用例可分为三类:

这些情况都面临两大关键挑战。

第一,考虑到终端的功耗和散热问题,通用CPU和GPU难以满足这些AI任务的计算需求。

第二,生成式AI应用还在不断丰富,不能在功能完全固定的硬件上进行部署。

硬件方面,NPU和异构计算成为应对挑战的关键。

在终端侧AI趋势兴起后,原本更常出现在手机芯片上的NPU,也开始在电脑芯片上发挥更加重要的作用。

NPU(Neural Processing Unit)专门为加速神经网络和AI任务而生,可以快速处理AI推理任务。它不易于编程,但能实现更高的峰值性能、能效和面积效率,从而运行机器学习所需的标量、向量和张量数学运算。

随着AI趋势演变,NPU的设计也发生了一系列变化。比如2015年时,NPU主要面向音频和语音AI设计,用于简单CNN并主要需要标量和向量数学运算。

后面随着AI在拍照和视频中的使用增多,以及Transformer、RNN、LSTM和高维度CNN等模型相继出现,NPU又增加了张量加速器和卷积加速,可以降低内存带宽占用和能耗。

发展到大模型时期,低时延、续航、内存、等因素共同要求下,NPU往往比GPU表现出更好的能效和性能,也使得NPU成为生成式AI终端上不可或缺的部分。

举例来看,骁龙X Elite上集成的Hexagon NPU算力达到45TOPS。

在不损失太多精度的情况下,Fast Stable Diffusion能够在0.6秒内生成一张512×512分辨率的图像。

但随着生成式AI终端逐渐发展,端侧运行的模型可能规模还将继续扩大,多模态趋势已经显现,还有可能会搭载多个大模型。

仅靠NPU来支撑生成式AI任务,可能还不是最佳方案。

目前厂商们已经开始通过异构计算,让不同处理器分别处理擅长的任务,也就是让全部处理器都来支持生成式AI任务。这一直是高通坚持且擅长的赛道。

GPU不仅用于处理图像任务,也能用于以高精度格式进行AI并行处理,支持FP32、FP16、INT8运算。

CPU则能用于计算量低、要求低时延的AI任务上,如高通Oryon CPU性能达竞品的2倍,功耗还降低了三分之二。

处理器之间的相互配合,可以进一步释放AI引擎性能,超越单NPU效果。

与此同时,软件层面也受到AI影响发生改变。

一方面,生成式AI终端需要软硬结合才能更充分释放性能;另一方面,开发者也需要适宜当下的工具,能够更快速将大模型加入到应用中。

在MWC 2024上,高通宣布推出的AI Hub正是这样一个平台。

它是一个全面的模型优化库,为开发者提供超过75个主流模型,如Stable Diffusion、ControlNet、Baichuan-7B等。这些模型全部经过优化,可以充分利用高通AI引擎内所有核心的硬件加速能力,实现4倍推理速度提升。开发者能快速将大模型无缝集成到应用程序中,缩短产品面市时间。

同时这些优化后的模型也同步上线到GitHub、Hugging Face。开发者可在搭载高通和骁龙平台的云托管终端上自行运行模型。

更早推出的高通AI Stack可全栈支持主流AI框架(如TensorFlow、PyTorch、ONNX和Keras)和runtime。集成高通神经网络SDK,面向Android、Linux和Windows不同版本。

此外还提供一系列量化、压缩开发工具,能够在尽量不降低模型精确度同时压缩模型。一些生成式AI模型由此可以量化至INT4。

总之,从底层硬件到上层软件,都在以生成式AI为中心进行快速变革。

巨头们脚步一致,纷纷加速All in AI,也让生成式AI带来的变革更加迷人。

AI变革究竟会如何影响每一个人的生活?

AI PC展现出的演进过程,已经给大家做了一些小剧透。

细数起来,AI PC从概念兴起到初步产品落地,刚刚过去半年的时间。

高通产品管理高级副总裁兼AI负责人Ziad Asghar将其类比为“人们刚刚能够实现手机上网”的阶段:数十亿人都能够通过手机连接到网络,奠定了此后移动互联网应用大爆发的格局。

我想如果我们能够在终端侧实现AI的发展,就可以把生成式AI的能力和优势充分发挥出来,打破所有的界限,利用生成式AI的能力让我们在生活、工作、娱乐、医疗等各个方面都获得更好的体验。

换言之,AI重构PC,现在正是打地基的阶段。

从上述各大厂商的动作之中,可以梳理出几个关键的环节:

前两者不再做过多赘述,设备互联,则关系到生成式AI的发展从第一阶段走向第二阶段的实质:

数据在哪里,AI推理就在哪里进行。

短期来看,终端生成式AI基础能力的构建,能在手机、PC这样的生产力终端上率先带来应用的爆发,提高生产效率、带来新的创新机会——

对于普通用户,人机交互方式彻底变革,自然语言操作一切,带来的是更高的终端使用效率。

对于开发者而言,新一轮的AI原生应用爆发机遇,已经是现在进行时。AI搜索应用Perplexity,刚刚被曝估值将破10亿美元,跻身独角兽行列。

而对于终端厂商而言,从底层芯片到操作系统的变革,也将带来重塑市场格局的机会。

从更长期来看,更重大的影响则是,AI PC、AI手机的背后,真正的私人AI助理将会出现:用户能够在本地打造专属的Agent,而通过终端设备互联,AI Agent将可以渗透到生活的方方面面。

工业革命的核心,是生产力的突破和生产方式的变革。AI掀起的技术风暴,概莫能外。

而就像从纸质办公到网络办公,处在当下的我们还无法窥见未来的全貌,但可以预见的是,以人为中心,AI将自然流转于手机、PC、智能车、AR/VR,乃至全新的AI硬件之上,构建起真正的万物互联。

身处这样的时代,对于直面风暴的技术厂商们而言,如何跟上趋势,已有高通这样的先行者给出参考。

而对于我们每一个普通而言,更重要的是,认真思考如何拥抱新变革的时间点,已经到来。

毕竟先拥抱新趋势的人,先享受世界。

文章来自于微信公众号“量子位”(ID: QbitAI),作者 “鱼羊 、明敏”

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/