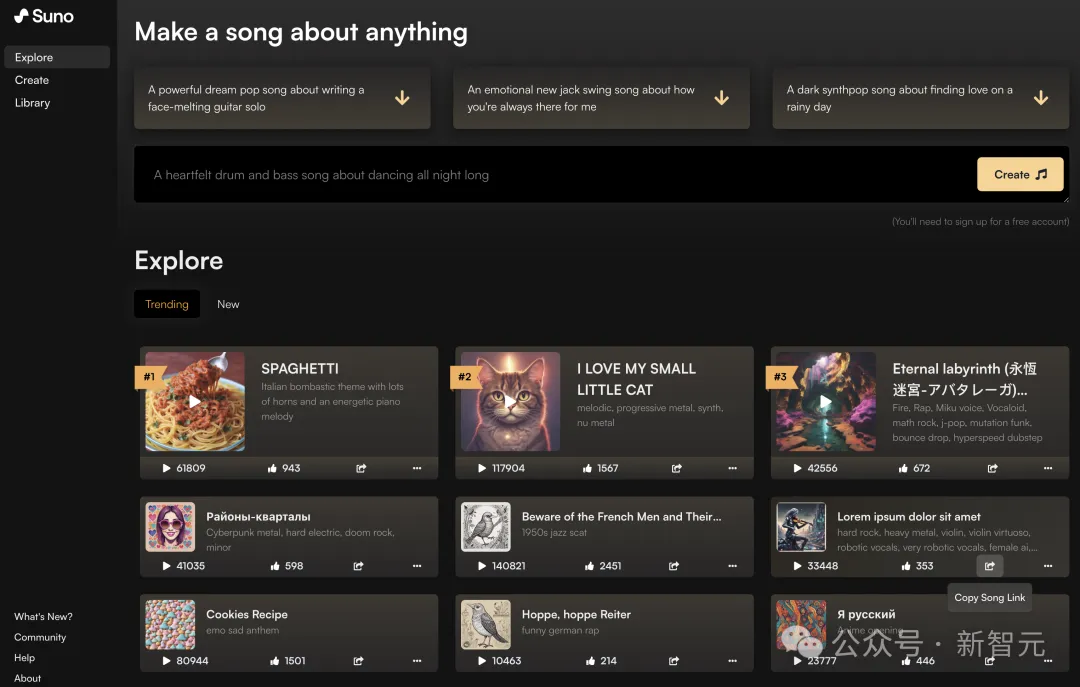

最近几周的震撼,是Suno给的。

重磅升级的Suno V3,不断有刷屏全网的「神曲」诞生,让全世界为之疯狂。

谁能想到,音乐的ChatGPT时刻,竟然就这么来了。

圈内所有人都在讨论:这一波,音乐产业没准要被AI一锅端了。

这不,就在上周,国内首款AI音乐生成大模型「天工SkyMusic」也正式开启内测了!

各路「大神」已经开始在首页秀创作了

没有灵感怎么办?产品页面甚至为你配备好了灵感话题。

试玩一番后,小编再次体会了一遍,当初Suno给人的那种惊艳感。

比如这首《古韵悠长》,清亮的女声一开口,瞬间梦回80年代,是我妈跳广场舞的那个feel了。

这首《爱是幸福》,更是好听到让小编惊掉下巴。旋律朗朗上口,歌词隽永又令人无限回味,细听有一股蔡健雅的味道。

除了歌曲整体的音乐品质非常高,极具欣赏价值之外,「天工SkyMusic」的最大亮点之一,就是它清晰逼真的人声。

要知道,人声合成,是AI音乐生成中最重要、最能体现生成效果和品质的维度。

而「天工SkyMusic」的AI人声合成,能够产生中文水平极高、发音清晰的歌声,展现出卓越的音频质量和逼真的演唱效果,已经达到业内SOTA水平!

在这方面,「天工SkyMusic」可是爆杀了几个外来大模型。他们在中文发音上,简直是惨不忍睹没眼看。

比如Suno的这首《宫保鸡丁》,唱起中文歌来也是老外说中文那味儿。

可见,要想做中文歌,还得看咱自己的音乐大模型!

接下来,我们就得上一些专业指标了。

歌词段落

一首歌为什么能够爆红全网,火遍大江南北?

从流行音乐的角度,它需要有强烈的旋律、鲜明的节奏、多彩的和声、激昂的情感。

因此,想要做出一首抓耳的流行歌,不同歌词段落间微妙的情绪变化,就是一个很关键的点。

而「天工SkyMusic」在这方面,就格外擅长——

它能通过歌词来控制歌曲,体现出主歌和副歌、前奏和主歌的段落差异。

比如这首《龙行龘龘》,开头悠扬的女声民歌和激昂扬的男女声对唱部分形成鲜明对比,一首大气磅礴的国风歌曲浑然天成。

风格

在风格控制上,它可以参考指定音频,学习特定特定的曲风。

它创作的这首《飞翔鸟》,听起来非常像学习了许巍的民谣风。

自动前奏、间奏、尾奏

音乐制作人时常面临的一个问题是,已经有了合适的歌曲,但缺少前奏和尾奏,绞尽脑汁也找不到合适的。

这时候,就可以找「天工SkyMusic」帮忙了。它补充完整的这首《Guitar》,慵懒随意的唱腔搭配恰到好处,听起来非常治愈。

和声

根据歌词描述,「天工SkyMusic」给这首《水调歌头》自动添加上了和声。

几个男声的和声和主唱的音色十分契合,再结合节奏鲜明的鼓点,一首旋律激昂大气的国风《水调歌头》就这样诞生了。

歌词技巧

而且,模型还可以参考音频的特征,智能地学习演唱技巧。

比如这首歌剧版的《我的滑板鞋》,就演绎出了别样的风味。

时下的流行icon,怎么和流行音乐融合?如果找对了叩击大众心弦的那个点,抖音神曲并不是一件难事。

「天工SkyMusic」,让这一切都成为可能。

输入带有结构的歌词+参考音频,就能把自己玩王者荣耀的体验写出一首歌了:「我真的气死了,skr skr~」

我今天打开王者荣耀选赵云

开局后我走到哪里都被爆杀

我真的气死了只能躲在草丛

或者,我们还可以根据已有的歌词进行二创。

比如输入《彩虹》的歌词,再录一段《最长的电影》主歌和副歌30s的音频做参考,两首歌「生出」的一首新歌就诞生了:

听得出来,部分旋律还是有可圈可点之处的。

再用蕾哈娜的《Diamonds》的词,配上霉霉维密秀震撼神曲《See You Again》试试?

出来的「混血」女声英文歌是这样的:

AI版Diamonds,

唱腔控音极好,高低音转换流畅,其中几句的多处转音颇为神奇,值得细品。在人类作曲家中似乎很少听到这么「鬼才」的旋律组合,这就是来自AI的巧思吧。

而且非常神奇的是,歌曲的唱腔忽然就变得像蕾哈娜了,跟霉霉的嗓音并不像。

接下来,让我们来爆改一下凤凰传奇的《最炫民族风》,不过跟刚才不同的是,这次输入的都是原歌词和原曲,让它自我「整改」一下。

出来的,是另一种感觉的广场舞神曲。

不仅如此,我们甚至还可以把突发的热点事件,分分钟变成一首爆款潜力股。

说唱版热梗「高速运转的机械」了解一下:

那么,「天工SkyMusic」是怎么做到如此惊艳的效果呢?

为此,我们最近特地找到初创团队的大佬聊了聊。

相信大家心里都有一个疑问:怎么以前没有好听的音乐AI,最近才扎堆冒出来呢?

当然是因为——它非常难!

好的AI音乐难做,一个原因是此前主流的符号派(MIDI)技术效果太差;还有一个原因,就是过往的音乐AI基本都在无人声的BGM领域,有人声的Song要么做不出来,要么效果也是很差。

一首歌有人声和无人声的吸引力程度差别有多大,不言自明。

具体来说,AI音乐生成有两大主要技术路径,符号派、大模型派。

符号派以MIDI为主流。MIDI全称Musical Instrument Digital Interface,本身不包含音频文件,而是记录音乐演奏的指令,比如哪个音符被播放、音量是多少、音符持续的时间等。

因为不能直接生成歌曲,后期还需加上乐器、旋律、音色、人声。

第二条大模型音乐音频生成路线,能够直接学习并生成音频波形,乐器、人声、旋律、音量、音符都是一体化端到端生成。

符号(MIDI)方向的研究,学界有很多,然而效果却很差;大模型音频方向则极难,做的极少。

面对两条路线,选哪个呢?

立项之初,公司内部就面临着这一艰难的选择。前者效果不好,后者则极有可能会做不出来,整个项目鸡飞蛋打。

最后,「天工SkyMusic」研发团队经过投票,一致决定选择音频方案。大家公认:宁愿冒着巨大风险,也要做出真正好的AI音乐。

幸运的是,他们成功了。

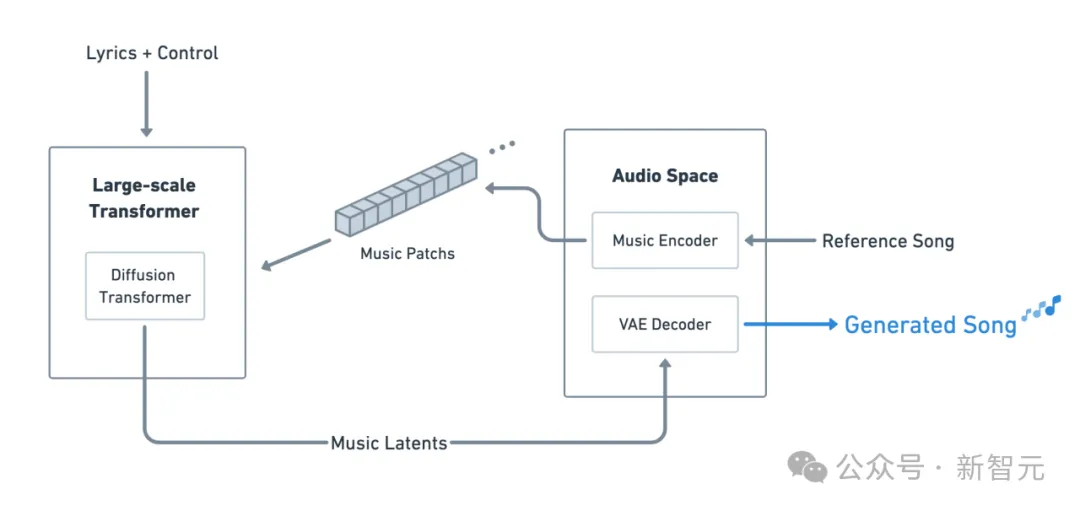

注意,下面你看到的这张图,可谓价值连城。

SkyMusic核心技术架构

因为,目前市面上没有任何可用的AI音乐大模型企业,公开过自己的技术路径,包括Suno。

ChatGPT出来后,LLM百花齐放,这是因为有无数开源项目可以参考。

但音频路线+人声Song路线,没有任何公开资料可参考,天工砸进去数不清的研发资源和算力算法投入,才摸索出了上面这张极其宝贵的路径图。

该踩的坑,团队都已经提前踩过了,而如今这个可复现的方案,也被他们慷慨贡献了出来。

而且巧合的是,虽然最终的框架与Sora类似,但其实在研发的时候Sora还没诞生呢。

只能说,英雄所见略同。

在类Sora架构中,Large-scale Transformer负责谱曲,通过学习Music Patches的上下文依赖关系来控制音乐结构和风格。

这样,就完全实现了对风格的掌控。

而Diffusion Transformer则负责演唱,也即声音的生成和渲染,通过LDM技术,将Music Patches转换为高质量音频输出,因此音乐具有清晰的风格特征和音质表现。

而如果我们仔细听上面的作品,就会感觉到:「天工SkyMusic」对于音乐情感的捕捉极为细腻。

它生成的音乐,仿佛有着丰富的情感脉络,和一种动态的变化。

正是这种对于情感表达的强化,让它的作品能够根据歌词和音乐元素,生成不同情感氛围的作品。

相比于以往侧重于智力提升的AGI模型,它的「情感AGI」路线,则显得尤为珍稀和宝贵。

因为,它不仅是一个聪明的AI,还是一个努力去理解和模拟人类情感、用音乐去表达情感的AI。

跟市面上那些侧重旋律创作、学习大量乐段的旋律,或是深入和弦、节奏、编曲层次的AI相比,「天工SkyMusic」的情感维度,也成为它在行业中的差异化亮点。

与市面上Suno等AI音乐工具相比,AI音乐生成大模型「天工SkyMusic」有着独特的优势。

它背后采用的,是基于MoE架构的4000亿级参数多模态超级大模型「天工3.0」。

在业界领先的逻辑推理、语义理解和泛化能力的加持下,「天工SkyMusic」的响应速度和训练推理效率,也得到了极大地提升。

首先在中文上,「天工SkyMusic」的AI人声合成极为优秀,发音清晰、无异响。

特别是,得益于在中文语境中的深度优化,其在中文演唱效果上,更符合中国市场的需求。

其次,在音乐风格上,「天工SkyMusic」更略胜一筹。

它能够通过歌词控制情绪变化,并实现如颤音、歌剧、吟唱等多种歌唱技巧,使生成的音乐作品,情感更加丰富且贴合情境。

此外,「天工SkyMusic」还支持创作说唱、民谣、放克、古风、电子等多种音乐风格,用户可以根据个人喜好定制音乐风格。

不过,不仅仅是「天工SkyMusic」,包括Suno等AI工具,都距以假乱真的专家音乐水平相对较远。

因此,这也是昆仑万维决定将其技术架构公开,希望业界一同推动这一领域发展的原因。

「天工SkyMusic」、Suno之外,近几天另一个堪称「Sora版」的神秘音乐模型Udio,也引发了全网关注。

拿到测试资格的网友,纷纷表示Udio音乐生成强太多了,甚至让人感受到了AGI的力量。

难道AI已经真的到了,能够取代人类音乐歌手的地步了吗?

原创,真的已经不再重要?

显然都不是。

AI音乐生成技术的快速迭代,无疑正在改变音乐创作的方式和体验。

但,这并不意味着AI会完全取代音乐人,或让原创变得不再重要。

相反,AI音乐生成技术与音乐创作者,可以相辅相成。

一方面,强大的AI可以降低音乐创作的门槛。

即便是非专业人士,也拥有机会接触音乐,创作出有一定水准的音乐作品。

这将极大地拓展音乐创作者群体,激发多元的音乐形态和跨界合作。

另一方面,如「天工SkyMusic」这样的工具可以赋能音乐创作者。

它们可以通用简化旋律原型生成、提供创意灵感、协助制作高质量伴奏等创作环节,帮助音乐人提高创作效率。

昆仑万维董事长兼CEO方汉曾在采访中说过这么一句话:

在内容生产行业,有这么一条规律:如果内容制作门槛降低1倍,那么内容创作者的创作数量将会增加10倍。

因此,当音乐创作门槛降低之后,就会有更多的人成为「原创音乐人」。

总而言之,若以静态的角度看待行业,许多人会认为,AI音乐的出现「切走了音乐行业的蛋糕」。

但动态地来看,技术的进步能够让音乐市场越来越大,行业蓬勃发展,孕育出全新的内容生态、音乐业态。

比如,按需定制音乐服务、在线音乐创作工具订阅等新的商业模式,可以为音乐产业带来新的消费增长。

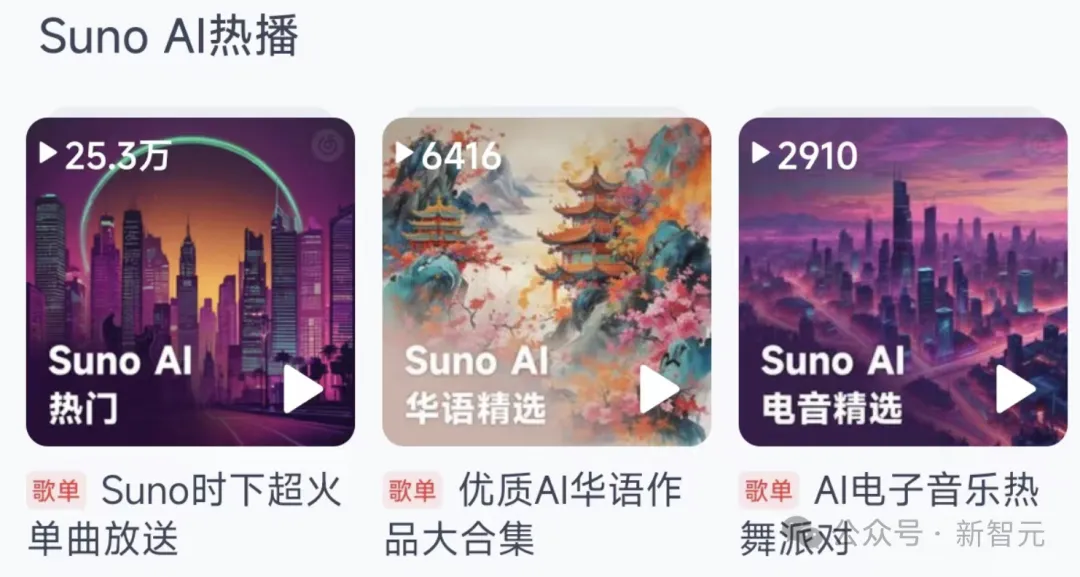

当前,国内许多音乐平台都为Suno AI做了专栏,直接解锁了一把新的流量密码。

而面向教育,AI音乐创作可以帮助我们快速感知音乐创作原理,尝试多种音乐风格创作,为音乐产业培养孵化新一代人才。

更宏观地讲,除了图片、视频、AI音乐也是通向情感AGI路上的一个重要的组成部分。

音乐,不仅是一种艺术形式,更是情感交流和表达的方式。

而且,音乐更能触及人的情感深处,是情感表达的重要媒介。

针对AGI开展的研究中,许多团队都将重点放在模型智力的扩展与增强上。

而真正的AGI的终极目标是——更像人,兼具感性理性、推理逻辑思维,以及情感理解等能力。

正是意识到了这点,一直将情感AGI视为重要方向的昆仑万维,希望攻克音乐AI这一大技术难题。

在研发「天工SkyMusic」过程中,研究团队积极探索音频内容,尤其是音乐对于情感理解与表达的独特优势。

他们不仅关注音乐作品的谱曲、编排和演唱等技术层面,更强调模型对音乐情感色彩的感知和再现能力。

「天工SkyMusic」在情感表达的准确性、多样性,以及歌词段落情绪变化的敏感捕捉,印证了昆仑万维在情感AGI上取得实质性进展。

当然,除了AI音乐生成,AI写作、绘画、动画等领域,昆仑万维也在探索其在创作工具中的应用。

在情感AGI这条主线上,他们希望通过自研技术,帮助创作者更好地通过AI技术表达和传递情感内涵。

未来三十年,会有越来越多的人表达自我,人类社会的自我表达侧要翻1000倍。

昆仑万维接下来所做的,便是让AI降低人类创作门槛,让我们每个人都加入这股AI音乐大潮。

文章来自微信公众号 “ 新智元 ”,作者 新智元