这就是微软与中国科技大学、香港中文大学(深圳)和浙江大学等机构合作,推出的NaturalSpeech 3系统。

该系统采用了创新的属性分解扩散模型和属性分解语音神经编解码器FACodec,从“表示”和“建模”两个维度对语音数据进行深入研究。通过数据/模型的规模化方法,在多说话人数据集LibriSpeech上首次实现了零样本的人类水平语音合成。

文本到语音合成(TTS)技术作为生成式人工智能的关键分支,在大型语言模型(LLM)的推动下近年来迎来了突飞猛进的发展。特别是随着语音合成技术的进步,它为大模型带来了声音交互的新维度,受到了业界的高度重视。在这一领域内,微软一直是技术研究与产品开发的积极参与者,旨在创造出高度自然的人类语音。为此,微软启动了NaturalSpeech研究项目(https://speechresearch.github.io/)。

该项目为实现其目标,制定了分阶段的实施路线图:

2.随后,项目目标升级,旨在高效生成具有多样化特征的人类语音,如不同说话人、韵律、情感和风格等。2023年,通过引入扩散模型,NaturalSpeech 2实现了零样本的语音合成,标志着技术的进一步突破。

3.推出NaturalSpeech 3系统。

NaturalSpeech 3的”Natural”的一大核心体现就是在LibriSpeech数据集上实现了零样本语音合成达到人类水平。

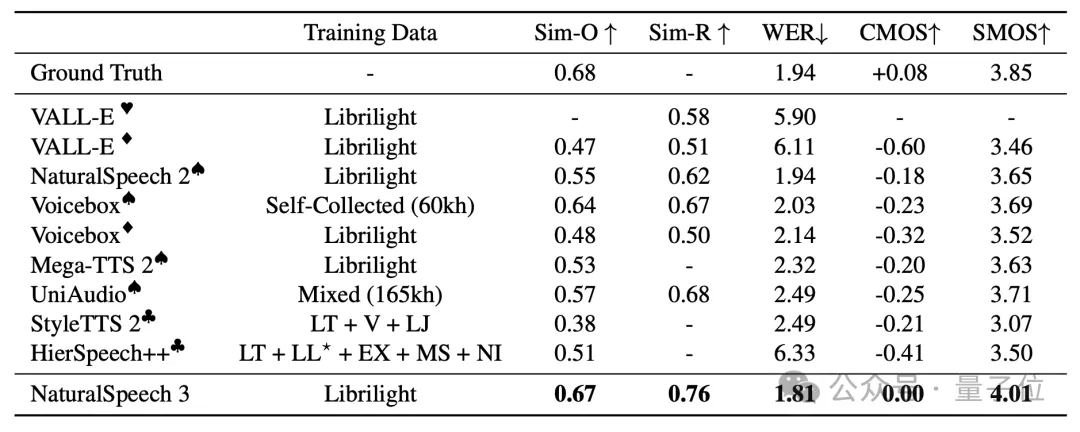

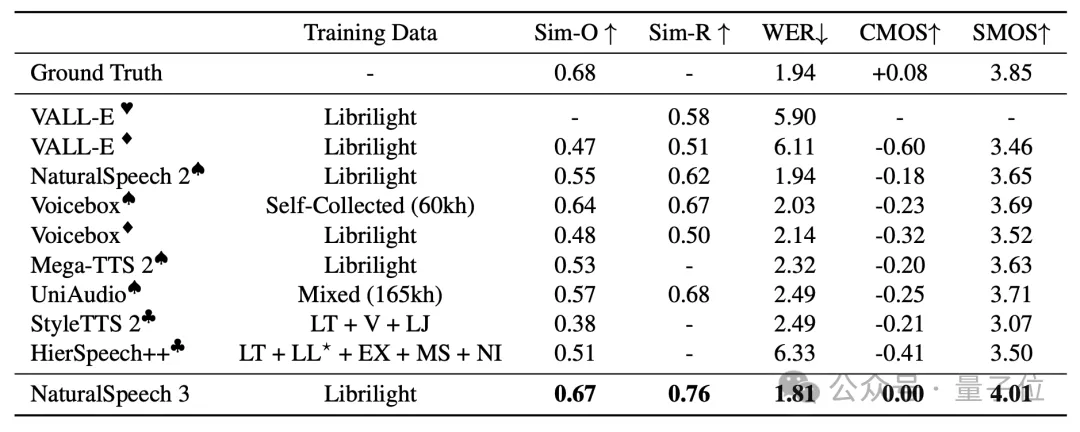

NaturalSpeech 3在LibriSpeech数据集上实现了零样本语音合成对人类录音的-0.08 CMOS(此前的 SOTA 结果为 -0.18)以及超过人类录音的4.01 SMOS (人类录音结果为3.85,而此前的SOTA为3.71),而在WER上,NaturalSpeech 3实现了比人类录音结果(1.94 WER)更低的1.81 WER。

实验结果表明,NaturalSpeech 3的零样本语音生成结果在LibriSpeech数据集上和人类录音水平已经没有统计学上的显著差异。

NaturalSpeech 3的自然不仅体现在能够完美的克隆音色上,还体现在能够自然的模仿提示音频的韵律、情感等,让AI生成的声音具有人类的情绪。

NaturalSpeech 3的技术实现允许对生成的语音进行细致的属性控制,这种方法提供了对语音合成过程中各个维度的精准调节能力。

通过引入特定属性的提示,比如采用语速较快的声音样本作为时长(duration)控制的参考,NaturalSpeech 3能够在保持其他声音属性不变的情况下,精确调整生成语音的语速。

NaturalSpeech 3的成功秘诀来自于基于属性分解的Codec+Diffusion建模范式以及Data/Model Scaling。

传统TTS系统因训练数据集有限,难以支持高质量的零样本语音合成。而最近的研究通过扩大语料库,虽有所进步,但在声音质量、相似性和韵律方面仍未达到理想水平。

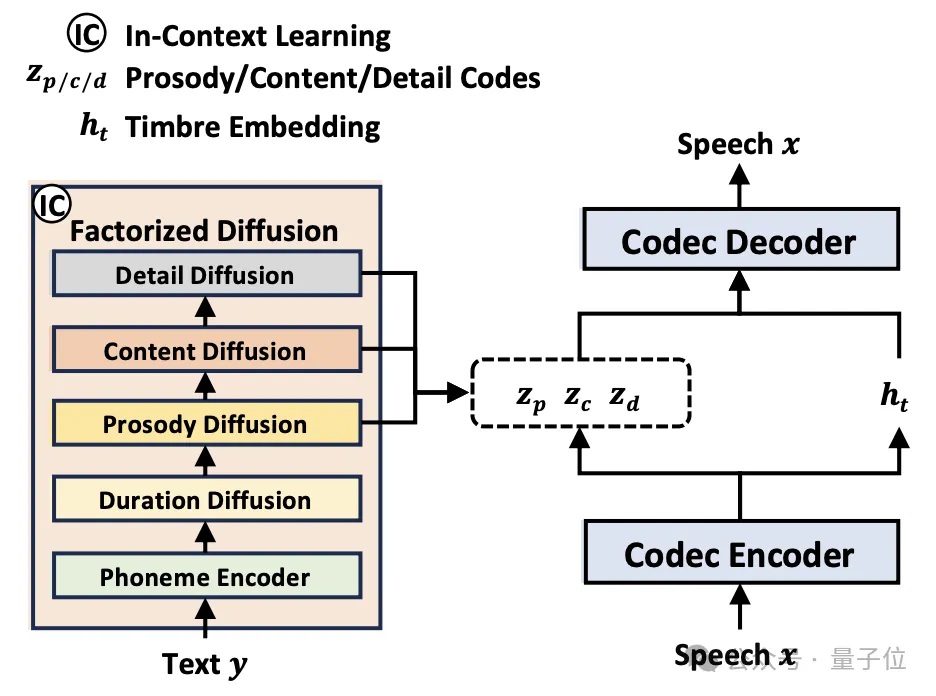

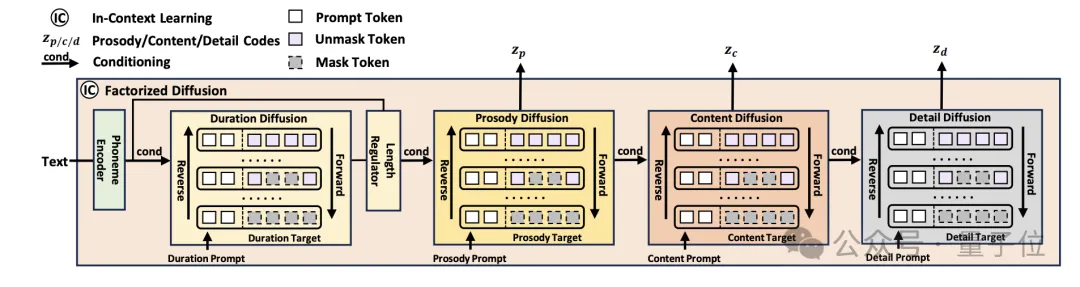

NaturalSpeech 3提出创新的属性分解扩散模型和属性分解神经语音编码器FACodec,通过将语音分解成不同属性的子空间并根据不同的提示(prompt)分别生成,有效地降低了语音建模难度,从而大大提高了语音合成的质量和自然度。

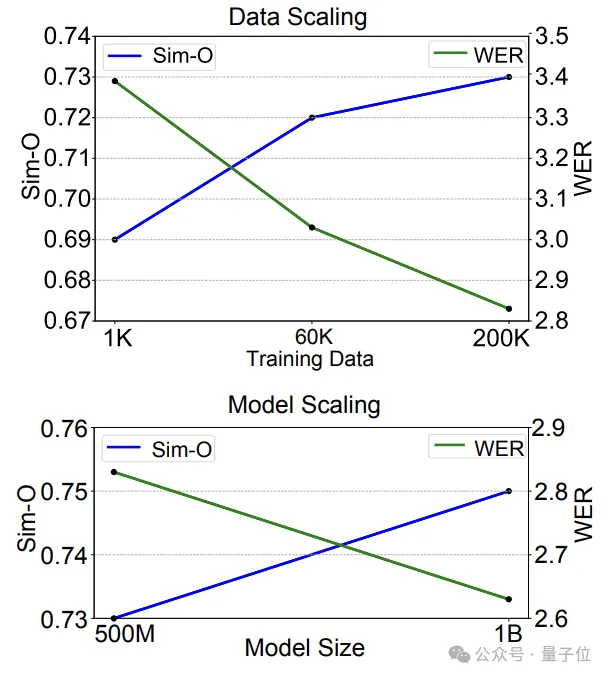

与此同时,NaturalSpeech 3通过将训练数据扩展到20万小时(这是迄今为止公开的研究工作中使用的最大规模数据)以及将模型大小扩展到1B(2B甚至更大的模型正在训练中),进一步提升语音合成的质量和自然度。

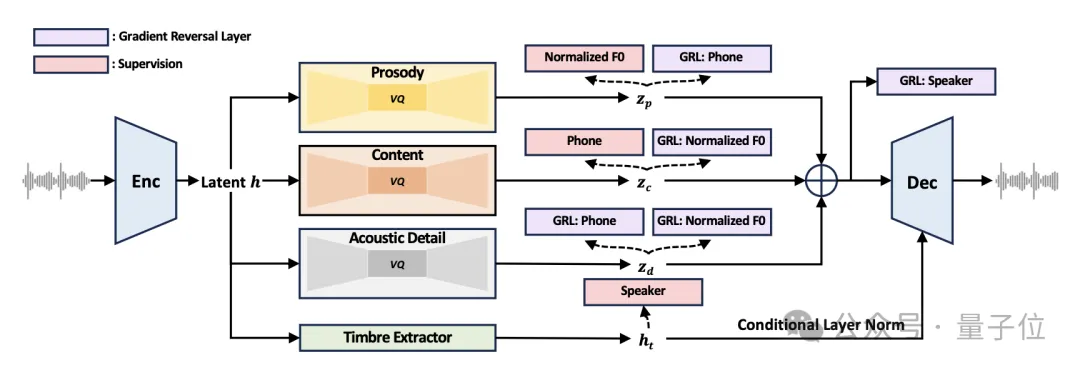

NaturalSpeech 3采用的属性分解神经语音编解码器(FACodec)是一项创新技术。

FACodec的核心在于将复杂的语音波形转换为多个解耦子空间,这些子空间分别代表语音的不同属性,如内容、韵律、音色和声学细节。这样的设计使得FACodec能够更精准地控制和重构语音的各个方面,从而生成更自然、更高质量的语音输出。

FACodec通过以下几个关键组件实现其功能:

此外,FACodec还结合了多种训练技术,以优化这些组件的性能和相互作用,确保生成的语音既自然又符合目标属性。

这种属性分解和重构的方法不仅简化了TTS对语音表示的建模过程,而且大大增强了语音合成的可控性和灵活性。用户可以通过调整不同的语音属性来生成满足特定需求的语音,如调整音色以模仿特定的说话人,或修改韵律以改变语音的情感表达。

目前语音开源项目Amphion已经支持NaturalSpeech 3的核心组件FACodec,并且已发布预训练模型。

NaturalSpeech 3的另一个创新之处在于其对属性分解扩散模型的采用,这种方法为语音合成带来了新的维度。

通过使用统一的扩散模型并合集多个扩散阶段,分别针对音素持续时间、韵律、内容和声学细节进行建模,NaturalSpeech 3能够更细致且有效地控制语音生成的各个方面。

与传统的语音合成方法相比,这种模块化的扩散模型架构提供了更高的灵活性和精确度,使得生成的语音既自然又富有表现力。

在这种架构中,音色作为一种重要的语音属性,其特征可以直接从提供给系统的提示(prompt)中提取,而不需要像其他属性那样通过独立的模型来建模。

这种设计简化了系统的复杂度,同时保证了音色的一致性和自然性。每个扩散模型只需要接受与其对应的语音属性相关的提示,从而实现了对特定语音属性的精准控制和可控性生成。

SOTA的语音合成效果:经过大量的实验验证,NaturalSpeech 3在语音质量、相似性、韵律和可懂度方面均超越了现有最先进的TTS系统。特别是,在LibriSpeech测试集上,NaturalSpeech 3已经达到了人类录音水平。

Data/Model Scaling:值得一提的是,NaturalSpeech 3还将模型拓展到 1B 大小、数据量拓展到 20万小时左右,在提升合成语音质量,相似度,可理解性方等面的令人期待的结果,展示了较强的Scaling能力。

该研究团队正在招聘以下方向的研究员和研究实习生:

1)音频(语音/音乐/音效)理解和生成;

2)视频(虚拟人/通用视频)理解和生成;

3)大模型。

研究员工作地点:西雅图;研究实习生工作地点:北京。

本文来自微信公众号”QbitAI",作者 量子位

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales