北京时间 5 月 14 日凌晨,备受期待的 OpenAI 春季更新发布会上,CTO Mira Murati 宣布发布新的模型迭代版本——GPT-4o,o 代表「omnimodel」(全能模型),原生多模态,改进了文本、视觉和音频的能力。

GPT-4o 将对所有 ChatGPT 用户免费开放,在未来几周内推出,并将同步提供 API,相比 GPT-4 Turbo 价格更低、速度更快。

发布会之后,Sam Altman 在 X 上发表的推文,只有一个词——Her,可以说是很炫耀地介绍新的 GPT-4o 了。

GPT-4o 能够跨越语音、文本和视觉进行推理和交流,Altman 在 X 的发帖说其是原生多模态。所有的输入和输出都由同一个神经网络处理,GPT-4o 是 OpenAI 第一个结合了所有这些模态的模型。

在官方的演示中,ChatGPT 的语音交流速度非常快,可以在 232 毫秒内响应语音输入,平均 320 毫秒,与人类反应时间类似。而在此之前,与 ChatGPT 对话的平均延迟为 2.8 秒(GPT-3.5)和 5.4 秒(GPT-4)。

而且与现有的其他语音模式相比:

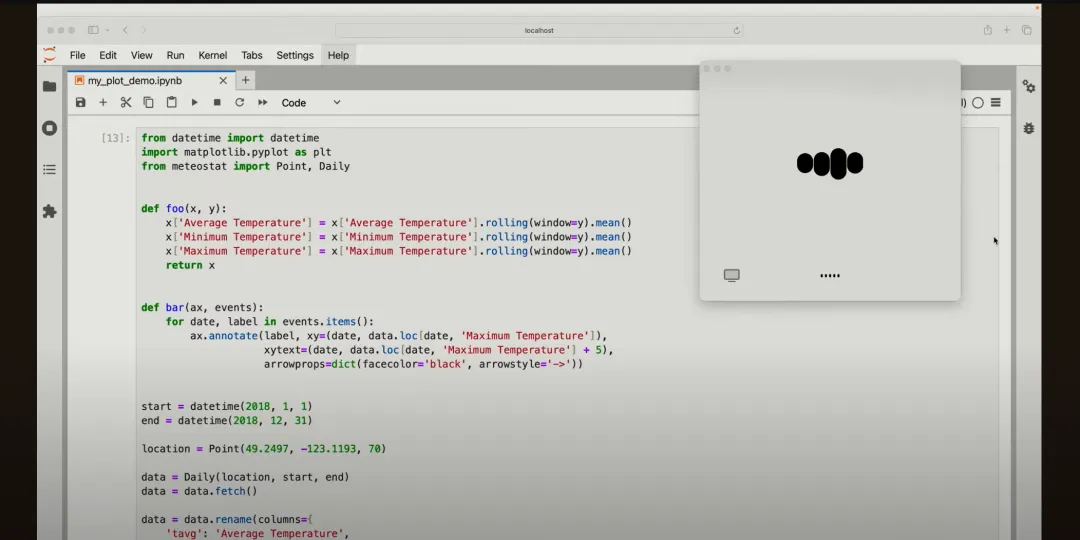

GPT-4o 也提高了 ChatGPT 的视觉能力,提供一张图片或者照片——甚至直接开启相机,ChatGPT 都能很快识别图片里的内容,并且给予准确的答复,从解读代码、数学题识别到人脸的情绪识别,都能轻松识别。

同样强大的语音能力,在语音翻译上自然也不遑多让。发布会上演示的意大利语和英语交流时的同声翻译,让人印象深刻。

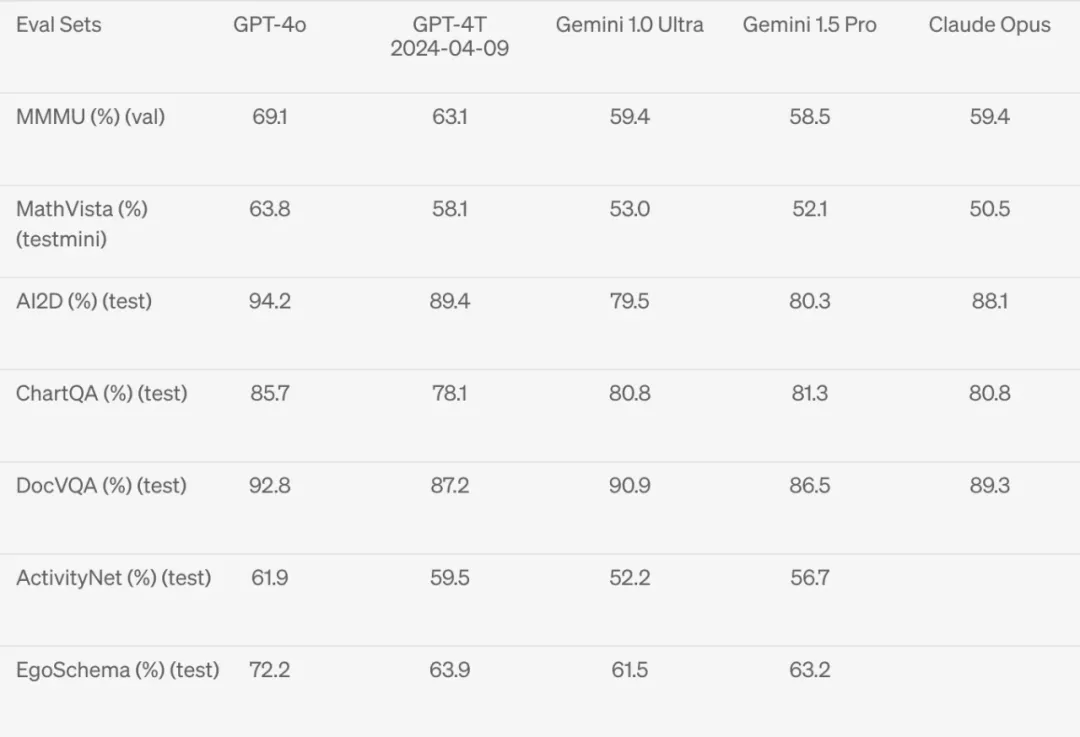

在官网发布的能力测试报告中,多模态的成绩让人惊喜。

在一些多模态的基准测试集上全面超越之前的模型,可以看到 GPT-4o 在视觉感知基准上实现了碾压。

GPT-4o 的文本和图像功能今天开始在 ChatGPT 中推出。OpenAI 将向所有用户免费提供 GPT-4o,并为 Plus 用户提供高达 5 倍的消息数量限制。OpenAI 将在未来几周内在 ChatGPT Plus 中推出带有 GPT-4o 的新版本语音模式的 alpha 版本。

开发者现在也可以通过 API 以文本和视觉模型的形式访问 GPT-4o。与 GPT-4 Turbo 相比,GPT-4o 的价格是 GPT-4-turbo 的一半,速度是其两倍,并且速率限制是 5 倍。

GPT-4o 还是一种多语言的模型,OpenAI 声称,它在 50 种不同语言中的性能都有所提高。并且针对其中的 20 种语言,新的分词法带来更好的压缩效果。

以中文为例,token 消耗比之前减少 1.4 倍,演示例句「你好,我的名字是 GPT-4o。我是一种新型的语言模型,很高兴见到你!」从 34 tokens 降低到 24 tokens。

此外,OpenAI 即将发布一个桌面客户端以及新的界面 UI,在 web 和 app 之外给了用户另外一种选择。从今天开始逐步向 Plus 用户推出 macOS 应用程序,并将在接下来的几周内持续扩大范围。在今年晚些时候会推出 Windows 版本。

在官网的展示视频中, OpenAI 的工作人员让两个 ChatGPT 进行交流,AI 的语音和视觉识别能力让人印象深刻,以及最后的唱歌片段,都让人想起了电影《Her》中的 AI。

本文来自微信公众号“Founder Park"

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales