开源大模型全球格局,一夜再变。

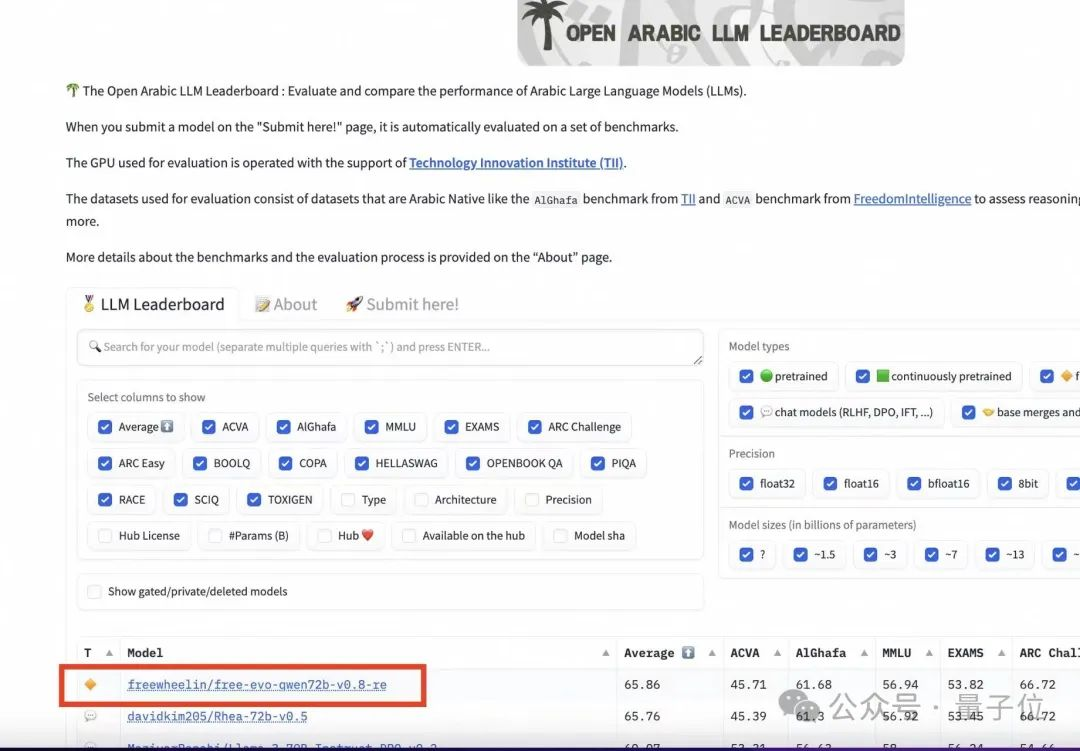

这不,全新开源大模型亮相,性能全面超越开源标杆Llama 3。王座易主了。不是“媲美”、不是“追上”,是全面超越。发布两小时,直接冲上HggingFace开源大模型榜单第一。

这就是最新一代开源大模型Qwen2,来自通义千问,来自阿里巴巴。

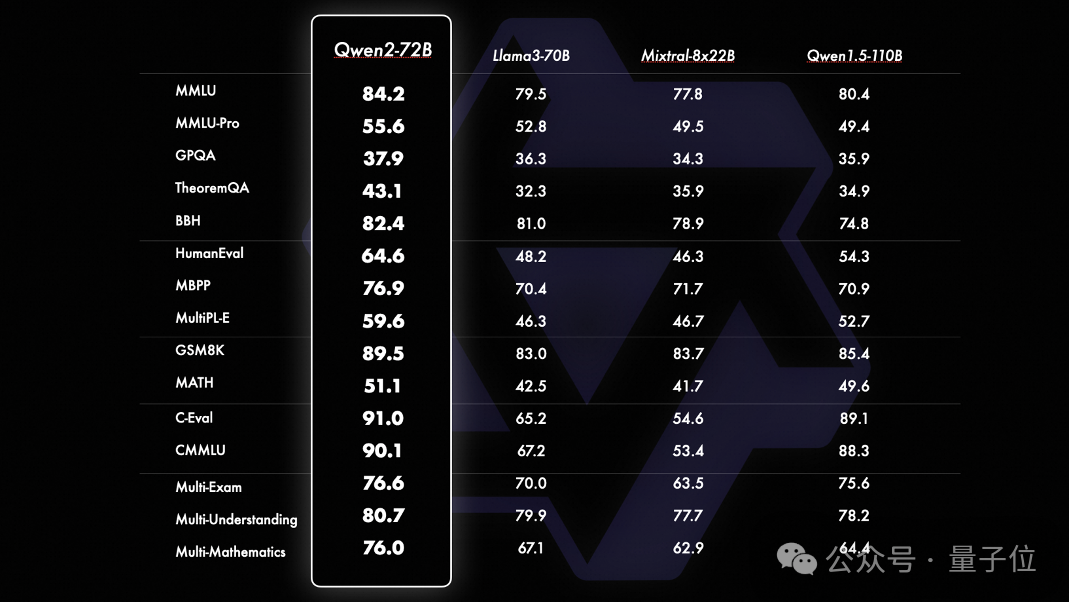

在十几项国际权威测评中,Qwen2-72B得分均胜过Llama3-70B,尤其在HumanEval、MATH等测试代码和数学能力的基准中表现突出。

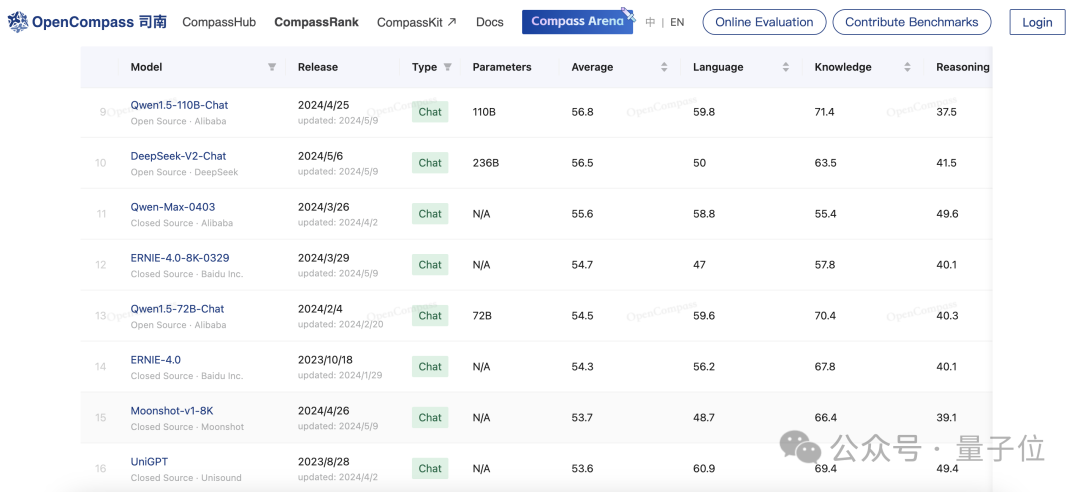

不仅如此,作为国产大模型,Qwen2-72B也“毕其功于一役”,超过了国内一众闭源大模型:

Qwen2-72B相比于自家前代模型Qwen1.5-110B实现了整体性能的代际提升,而在上海AI Lab推出的OpenCompass大模型测评榜单上,Qwen1.5-110B已经超过了文心4、Moonshot-v1-8K等一众国内闭源模型。随着Qwen2-72B的问世,这一领先优势还在扩大。

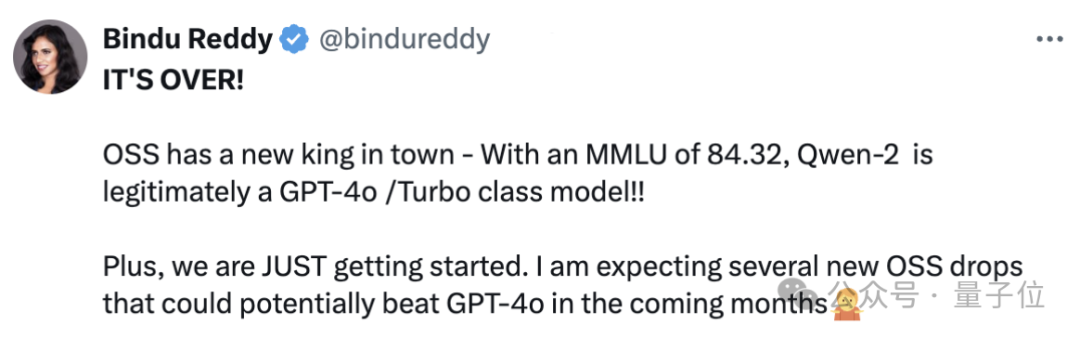

有网友便感慨说:这还只是刚开始。开源模型很可能在未来几个月,就能击败GPT-4o为代表的闭源模型。

Qwen2的发布,可以说是一石激起千层浪。

上线仅1天,下载量已经超过3万次。

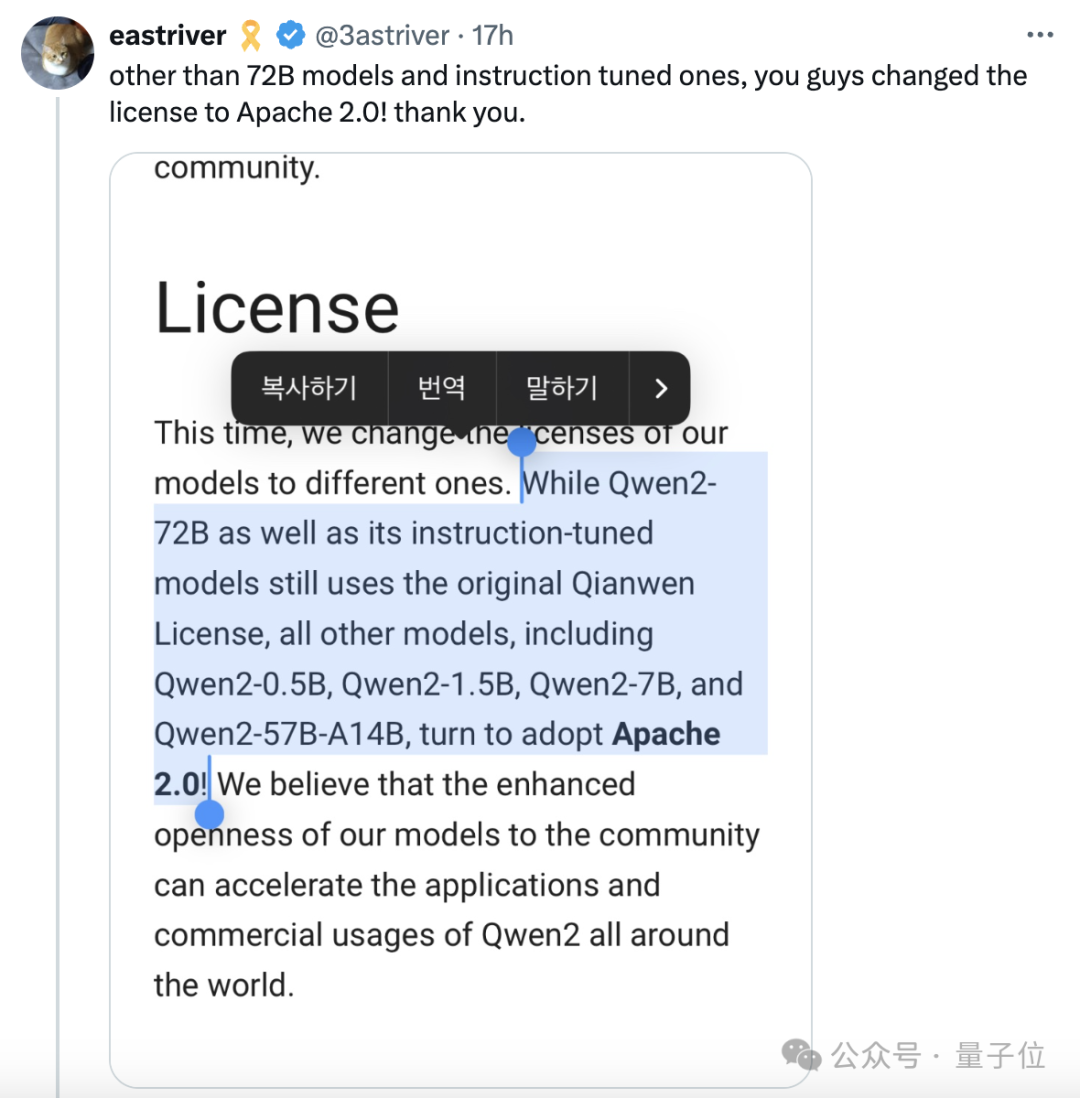

网友们还发现,除了72B和指令调优版本,这次同步开源的Qwen2-0.5B、Qwen2-1.5B、Qwen2-7B、Qwen2-57B-A14B,开源许可都换成了Apache 2.0——

就是说可以更加自由地商用。这是Llama 3系列都没做到的。

在AI大模型领域,时间和速度都不同了。

因为距离阿里推出Qwen1.5-110B模型刷新SOTA,全球开源大模型形成双雄格局,才刚过去1个月时间。

而现在,Qwen2独领风骚,全球开源第一,国产大模型第一——连不开源的大模型都超越了。

还是先来整体梳理一下Qwen2的基本情况。

根据官方技术博客介绍,Qwen2的特点和相比Qwen1.5的主要升级包括:

纸面数据上,Qwen2在开源大模型中已经达成全球最强,那么实际表现又会如何?

我们用新鲜出炉的高考数学真题上手实测了一波。

先来个简单题:

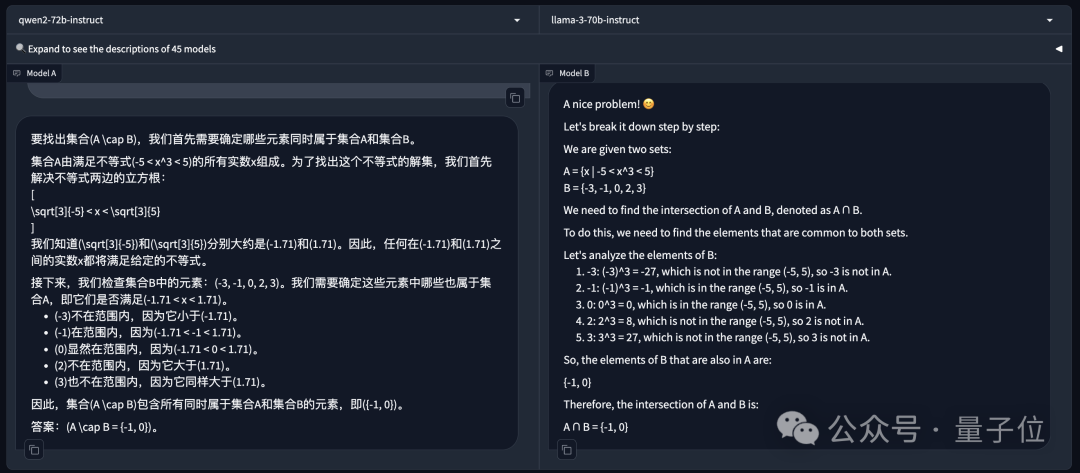

已知集合A={x|-5<x^3<5},B={-3,-1,0,2,3},则A∩B=()

左边是Qwen2-72B-Instruct,右边是Llama-3-70B-Instruct。除了Llama 3原版的老问题不咋支持中文外,两边的答案都是正确的。

那么就稍微上点难度:

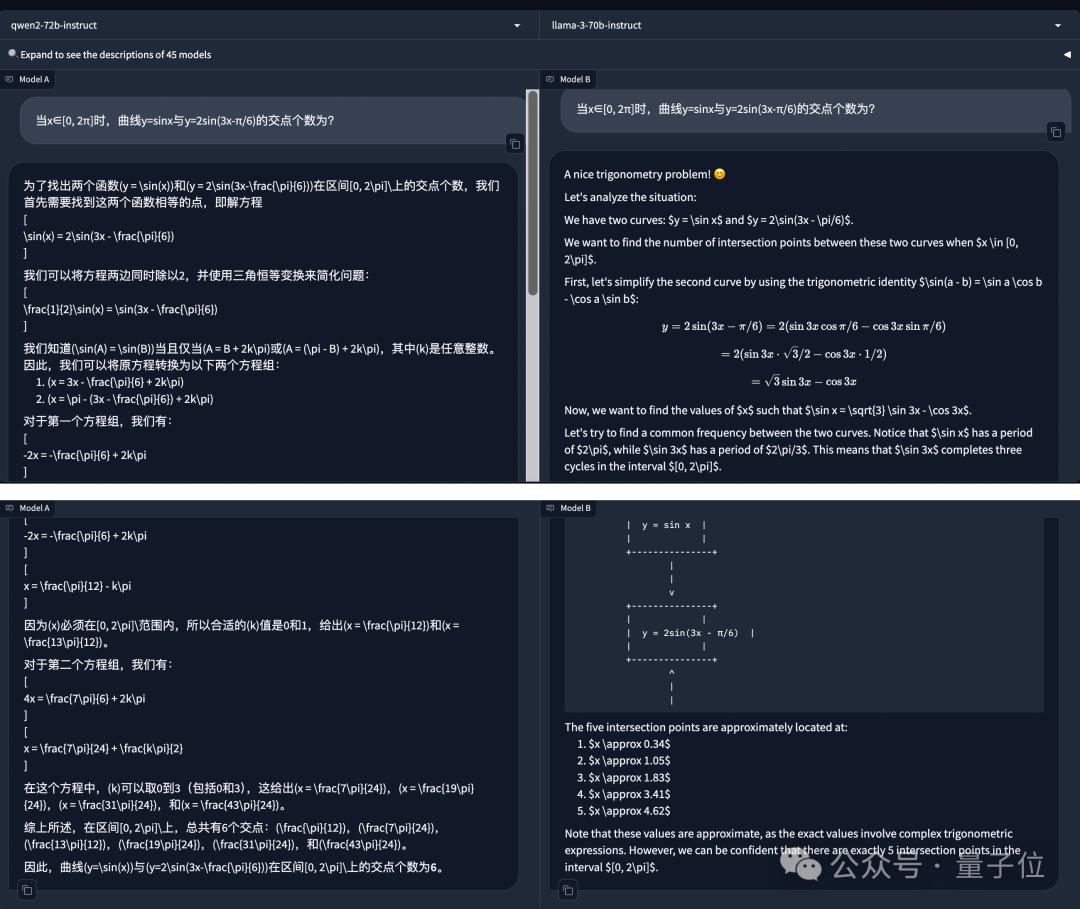

当x∈[0, 2π]时,曲线y=sinx与y=2sin(3x-π/6)的交点个数为?

Qwen2-72B-Instruct依然没有被难住,一通计算后给出正确答案:交点个数为6个。

而Llama-3-70B-Instruct则计算错误,扣5分。

Qwen2在数学能力方面,已经到了高考考场接受真题检验的水平。

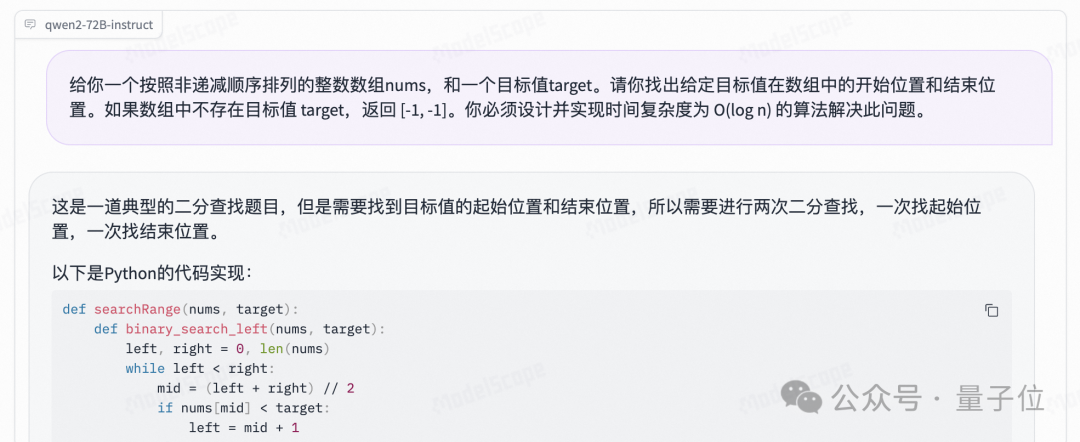

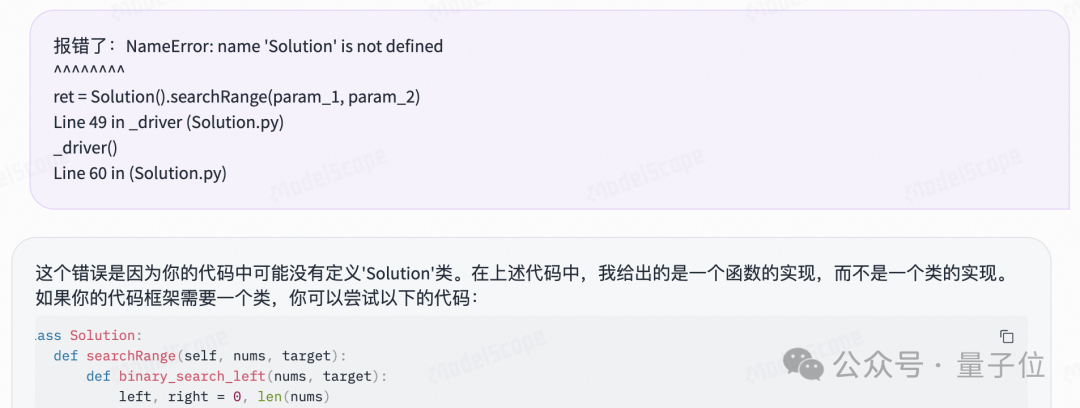

通义千问此番升级,官方和评测数据还突出了代码能力的提升,我们也有LeetCode中等难度真题浅测了一下:

给你一个按照非递减顺序排列的整数数组nums,和一个目标值target。请你找出给定目标值在数组中的开始位置和结束位置。如果数组中不存在目标值 target,返回 [-1, -1]。你必须设计并实现时间复杂度为 O(log n) 的算法解决此问题。

Qwen2-72B-Instruct给出的python实现如下:

def searchRange(nums, target):def binary_search_left(nums, target):

left, right = 0, len(nums)while left < right:

mid = (left + right) // 2if nums[mid] < target:

left = mid + 1else:

right = midreturn left

def binary_search_right(nums, target):

left, right = 0, len(nums)while left < right:

mid = (left + right) // 2if nums[mid] <= target:

left = mid + 1else:

right = midreturn left

left, right = binary_search_left(nums, target), binary_search_right(nums, target)return [left, right - 1] if left <= right - 1 and nums[left] == target and nums[right - 1] == target else [-1, -1]

一开始没有定义Solution类导致报错,不过直接把报错信息反馈给Qwen2,它自己就能完成debug:

顺利通过测试。

这波实测,你给通义千问打几分?

值得关注的是,这次阿里官方的技术博客中,还透露出了不少Qwen变强的技术细节。

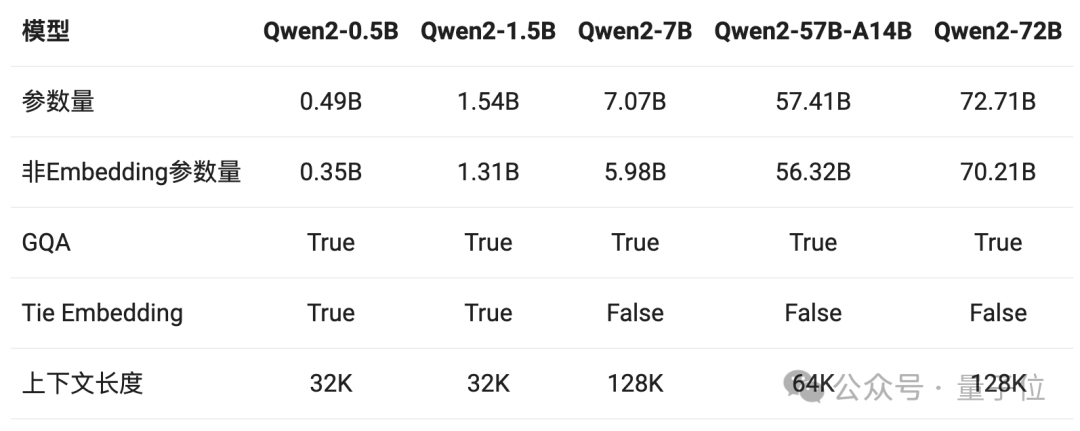

首先,是GQA(Grouped Query Attention)的全面加持。

GQA,即分组查询注意力机制,主要思想将输入序列划分成若干个组,在组内和组间分别应用注意力机制,以更好地捕捉序列内的局部和全局依赖关系。

GQA能够有效降低计算复杂度,同时很容易实现并行化从而提高计算效率。

在Qwen1.5系列中,只有32B和110B模型使用了GQA。而Qwen2则全系列用上了这一注意力机制。也就是说,无论是高端玩家还是爱好者入门,这回都能在Qwen2各个尺寸模型中体验到GQA带来的推理加速和显存占用降低的优势。

另外,针对小模型(0.5B和1.5B),由于embedding参数量较大,研发团队使用了tie embedding的方法让输入和输出层共享参数,以增加非embedding参数的占比。

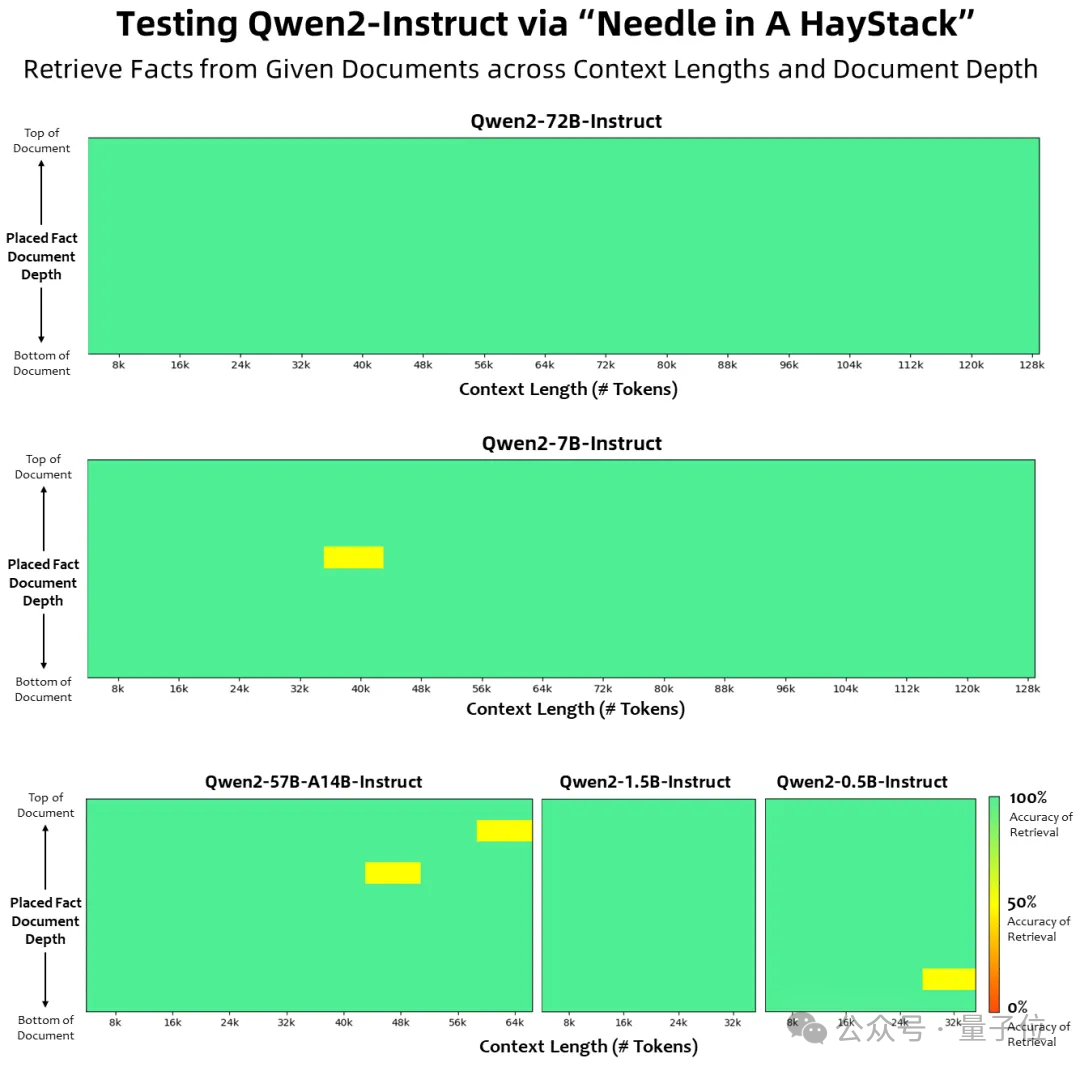

其次,在上下文长度方面,Qwen2系列中所有Instruct模型,均在32K上下文长度上进行训练,并通过YARN或Dual Chunk Attention等技术扩展至更长的上下文长度。

其中,Qwen2-7B-Instruct和Qwen2-72B-Instruct支持128K上下文。72B版本的最长上下文长度可以达到131072个token。

Qwen2-57B-A14B-Instruct能处理64K上下文,其余两个较小的模型(0.5B和1.5B)则支持32K的上下文长度。

大海捞针的实验结果如下。可以看到,Qwen2-72B-Instruct在处理128K上下文长度内的信息抽取任务时,表现称得上完美。

除此之外,在数据方面,Qwen2继续探索Scaling Law的路线。

比如数学能力的提升,就是研究团队给模型喂了大规模高质量数学数据的结果。

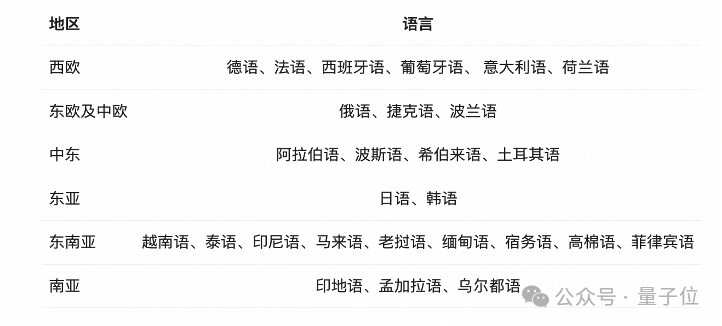

在多语言能力方面,研究团队也针对性地在训练数据中增加了27种语言相关的高质量数据。

博客还透露,接下来,通义千问研究团队还将继续探索模型及数据的Scaling Law,还会把Qwen2扩展为多模态模型。

更强的性能、更开放的态度,Qwen2刚一发布,堪称好评如潮。

而在此前,生态方面,Qwen系列下载量已突破1600万次。海内外开源社区也已经出现了超过1500款基于Qwen二次开发的模型和应用。

已经有开发者感受到了:在开源路线上,现在中国大模型正在成为引领者。

Qwen2的最新成绩单,至少印证了两个事实。

其一,中国开源大模型,从性能到生态,都已具备跟美国最强开源大模型Llama 3全面对垒的硬实力。

其二,如图灵奖得主Yann LeCun所预言,开源大模型已经走在了超越闭源模型的道路上,拐点已现。

事实上,这也是包括阿里在内,开源大模型玩家的明牌——

大模型的持续优化和进步,一方面依赖于强大的AI研发能力、领先的基础设施能力,也就是人工智能和云的强强联合。

以阿里为例,作为中国云厂商份额第一,依托于强大的云计算能力,能为AI训练、AI应用提供稳定高效的AI基础服务体系,同时在人工智能方面有长期的积累。

另一方面也需要来自外界的不断反馈和技术推动。

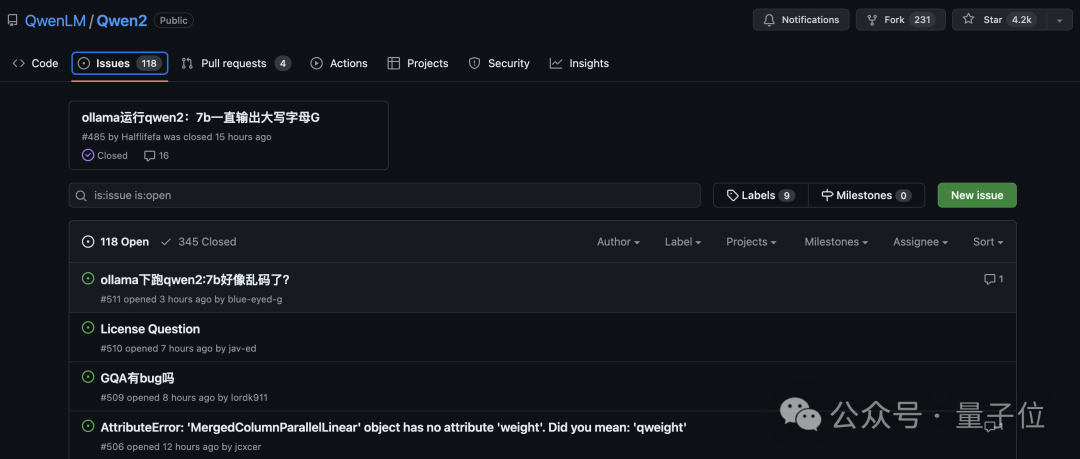

开源社区的技术反哺,从Qwen2上线第一天,GitHub上的Issues数量就可见一斑。

在技术领域,开源就是我为人人、人人为我,是全球科技互联网繁荣发展至今最核心的精神要素。

不论任何一个时代,不管哪种新兴技术浪潮,没有程序员、工程师不以开源感到骄傲,甚至快乐。

阿里高级算法专家、开源负责人林俊旸,曾对外分享过通义千问进展飞快的“秘籍”:

快乐。

因为面向全球开发者服务,面向其他开发者交流,给别人带去实实在在的帮助,这样通义千问大模型的打造者们快乐又兴奋,关注着每一个开发者的反馈,激动于全新意想不到的落地应用。

这也是科技互联网世界曾经快速发展的核心原因,黄金时代,开源才是约定俗成的,不开源反而要遭受质疑。

然而时移世易,在大模型时代,由于研发成本、商业模式和竞争多方面的原因,闭源的光芒一度掩盖了开源,Close成了宠儿。

所以Meta的Llama也好,阿里通义千问的Qwen也好,复兴传统,重新证明科技互联网领域不变的精神和内核。

这种精神和内核,在通义千问这里,也拥有不言自明的可持续飞轮。

阿里巴巴董事长蔡崇信已经对外分享了思考,在全球云计算和AI的第一梯队中,有领先的云业务又有自研大模型能力的,仅谷歌和阿里两家。其他有云服务的微软、亚马逊,都是合作接入大模型;其他自研大模型的OpenAI、Meta,没有领先的云服务。

全球唯二,中国唯一。

而在开源生态的推动中,技术迭代会更快,云计算的服务延伸会越广,技术模型和商业模式,飞轮闭环,循环迭代,在固有基础设施的基础上垒起新的基础设施,形成稳固持续的竞争力。

但开源大模型,最大的价值和意义依然回归开发者,只有足够强大的开源大模型,AI for All、AI无处不在才不会成为纸上空谈。

所以通义千问Qwen2,此时此刻,登顶的是全球开源性能最高峰,引领的是开源对闭源的超越阶段,象征着中国大模型在新AI时代中的竞争力。

但更值得期待的价值是通过开源大模型,让天下没有难开发的AI应用、让天下没有难落地的AI方案。完整兑现AI价值,让新一轮AI复兴,持续繁荣,真正改变经济和社会。

文章来源于“量子位”,作者“关注前沿科技”

【开源免费】kimi-free-api是一个提供长文本大模型逆向API的开渔免费技术。它支持高速流式输出、智能体对话、联网搜索、长文档解读、图像OCR、多轮对话,零配置部署,多路token支持,自动清理会话痕迹等原大模型支持的相关功能。

项目地址:https://github.com/LLM-Red-Team/kimi-free-api?tab=readme-ov-file

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner