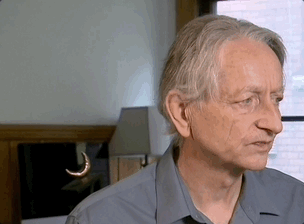

Geoffrey Hinton老爷子——图灵奖得主、深度学习发明人、AI三巨头、Ilya之师,在最新专访中透露出这个令人心碎的消息。

就在这两天,Hinton接受了多家媒体的专访,既有老生常谈的内容,即他对AI发展安全的担忧;也有一些新的话题和八卦。

他提到了老朋友马斯克,俩人一直以来都是AI威胁论的支持者。

但Hinton透露,最近老马邀请他加入xAI的顾问委员会时,Hinton为了婉拒他,不得不上演了一出金蝉脱壳:

我们打了通差不多20分钟的电话……为了拒绝他(马斯克),我不得不谎称自己马上有个会,赶紧挂了。

不知道马斯克本人看到这部分专访内容的时候会作何感想……

不过,咱都想替马斯克问上一嘴了,同为AI威胁论支持者,老爷子这到底为啥啊???

Hinton也没藏着掖着,明说了,因为马斯克是xAI背后的那个男人。

“马斯克,还有小扎,他们这群推动AI发展的关键性人物,其实也是AI发展潜在威胁问题的一部分。”Hinton如是说,“能控制他们的,恐怕只有政府监管了。”

这就不得不提到,Hinton表示大大支持本月早些时候一封十几名前OpenAI员工的联名信。

信里表示,目前对举报人的保护不够,而且OpenAI等公司还在打压这些举报。

显然,现年已经76岁的Hinton,还在为AI的良性发展四处奔走。

除了曝出和马斯克的友情小船翻船故事,最新专访中,他对AI发展又有了哪些新判断?

一起来看

这两天,Hinton一共参加了两个专访。一个是BBN的电视访谈,另一个是和《环球邮报》作者的专访(听说还是Hinton主动发邮件说想聊聊)。

两个访谈中都谈到了一个观点:

未来5-20年,AI有一半概率比人类聪明。当它们比人类更聪明时,我不知道我们被接管的可能性有多大,但在我看来很有可能。

如何做出这样的判断?有来自对目前AI行业的观察和分析,也有对AI理论的深入见解。

先来看Hinton如何看当前的AI行业发展。

(以下为BNN电视专访实录整理,Hinton第一人称自述)

去年(2023年)春天,我开始意识到正在构建的AI可能会成为比人类更智能的存在。

我们必须认真对待这个问题:如果AI变得比人类更聪明怎么办?

在我看来,也许再过20年左右,AI就会比我们更聪明了。但在那一天真正到来之前,包括现在,许多人都认为无需担心这件事,认为AI只是统计技巧。至于AI智商超越人类,那是科幻小说里的事。

但我不再相信这仅存于科幻小说中,我认为这是完全错误的,我们现在就需要认真思考我们能否控制AI。

所以我站出来,四处宣讲关于AI威胁的话题。

事实上,AI发展得非常快,简直可以说一日千里。

不信的话咱们可以回头看看10年前AI的发展情况。

如果你告诉那时候的人们,2024年的世界存在一个语言理解系统,你问它任何问题它都能回答(虽然有时候回答得不咋太好),那大家一定会说“不会吧?!So crazy!”

要知道,人们已经研究自然语言处理50年了,这种情况一旦实现,就会是巨大的进步。

但如你所见,今天我们真的拥有了这个东西。

所以我猜测,在接下来的20年里,AI会发展进化得比人类更聪明,就是出现那种超级智能。

不瞒大伙,几乎每一个我认识的优秀研究人员都相信,从长远光来看,AI会比我们更聪明,而且不会止步于人类已经达到的智慧水平——即便它现在是在用我们产生的数据进行训练。

所以比“AI会不会比人类更聪明”更值得引起关注的问题是,AI变得比我们更聪明需要多久?当这一天真的来临时,我们还能很好地控制和运用AI吗?

还有一个问题是,能让AI比我们更聪明的决定性因素是什么?

目前大家都对Scaling Law比较熟悉了,就是说把AI做得更大,AI就会更聪明。GPT-4就是通过这个方式,正确回答了一大堆GPT-3会出错的问题。

但如你所知,科学总是在不断进步的。因此,除了Scaling Law以外,我们一定会有别的科学突破,就像2017年时Transformer横空出世那样。

但AI变得更大更强,一定会带来相关的风险。

可以在脑海里想一下,我们的认知范围内,有多少情况下一个聪明的东西/物种是被另一个不那么聪明的东西/物种控制的?答案很明显,这种情况少之又少。

非要说有什么实际例子的话,我可能会举例母亲和婴儿这一对关系。

在这对关系中,母亲不得不陷入大量的日常事务来照顾小baby,从而陷入“婴儿控制母亲”的状态。

但除此之外,基本上不太智能的东西并不能控制更智能的东西。

当然了,有人觉得我的例子不太恰当,担忧也比较多余,因为他们觉得智能制造的东西和人类是不同的,它们没办法进化——比如我的老朋友杨立昆,就觉得这玩意儿完全安全。

而我和杨立昆的观点完全相悖。

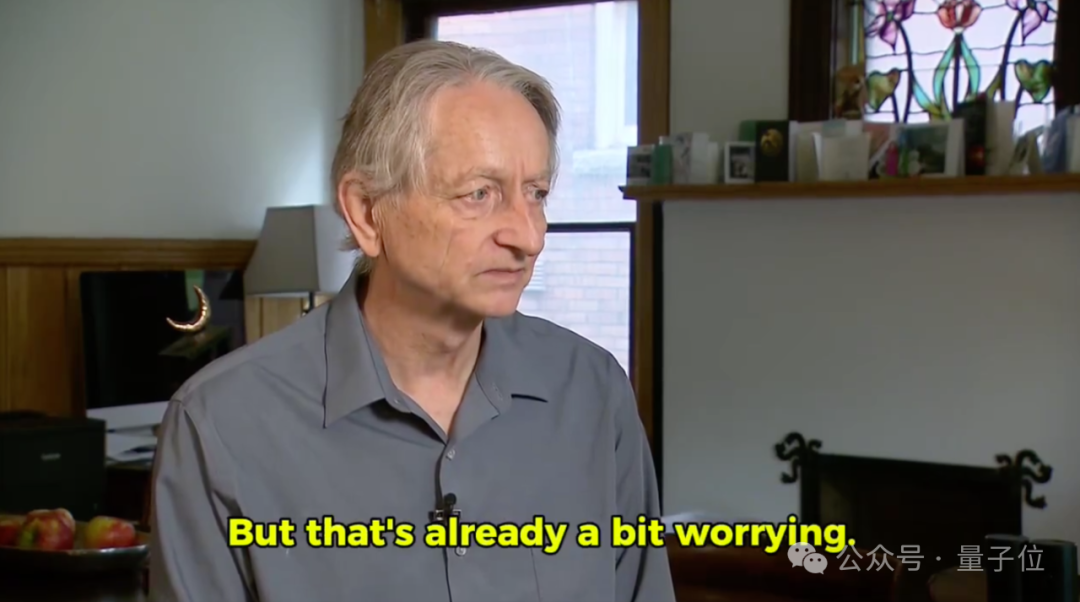

这么来说吧,现在大家都喜欢创建Agent来帮助人做一些原本人类可以完成的事情。如果你想要创建一个有效的Agent,它必须能够创建子目标,就比如你想去欧洲,需要有个子目标是“到达机场”。

这种情况下,一旦Agent获得了更多的控制权,它完成你给的任务就会更快更出色。

请注意,这已经有些令人忧心了!尤其是如果你希望Agent能够持续性完成任务,你会希望它们能防范一些可能会影响工作的事情,比如数据中心出事儿什么的。所以其实你是希望Agent能够建立自我保护的,对吧。

好,现在可以来做个假设了——

现在有两个聊天机器人,其中一个比另一个更自私。

稍微自私一点的那个,会掠夺更多的数据中心,因为它知道有了更多的数据中心支撑它汲取数据,它就可能变得更加智能。

ChatBot之间的竞争就是这么激烈。如果最终角逐出一个ChatBot霸主,它就能把人类远远地甩在身后。

你知道这意味着什么吗?意味着AI不再需要我们了。

AI会开始运营一切,本来那个阶段的它们就可以比我们做得更好嘛!

举个保守估计的例子。一开始,它们只是借用人类盯着它们工作,就像父母让小孩做些事,当小朋友们完成不了或者有危险的时候,父母就会自己上手了。

但是,AI全面全权自由处置任务,显然不符合人类的利益。

嗯……这事儿真的很棘手。没人知道人类最终会在和AI的关系中扮演什么样的角色,以前我们没面对过这个问题。

目前而言,人类就是最聪明的,所以让没那么聪明的AI去做很多事非常明智,我们可以控制它们。但以后可说不准了。

所以,我认为政府应该介入,政府应该强烈地坚持要求大公司花费相当大的资源来进行大量安全实验。

花费多少资源比较好呢?我觉得每个大公司至少应该有20%-30%的计算资源,都放在研究AI安全方面。

不过肉眼可见,大多数公司在安全方面的支出不会接近这个数字,比如山姆·奥特曼这种对利润更感兴趣的人,显然不想在AI安全这方面花费太多资源。

公司嘛,还是以利润为导向的。

最近大家都关注到,AI的繁荣把科技公司的估值推向了数万亿美元。

这让大公司们清楚地知道,需要在AI赛道上全速前进。人嘛,总是试图在最短的时间获取最大的利益。

微软、谷歌、亚马逊、英伟达,还有其它重要大公司之间势必存在激烈的竞争角逐。哪怕其中任何一个退出比赛,也丝毫不影响其它玩家继续向前狂奔。

我认为,唯一能减缓这种情况的只有来自政府的严格监管。

换句话说,尽管AI是个好东西,做很多事情都超棒的,但所有的AI模型都很昂贵,因为背后是巨量的计算,这也是为什么最近英伟达总市值突破3万亿美元的原因。

政府应该关注的是,如何想办法让真正的超级智能不想/不能接管人类的一切。

说仔细点,就是政府应该关注如何防止AI设计武器、如何防止用AI进行网络攻击、如何防止AI作弊选举投票等等。

一些AI带来的风险已经被看到了,比如它会引起新一波失业;而我更关注的是AI带来的威胁,尽管很多人认为这不可能发生。

好了,再重申一次,我觉得我目前能想到的最好的办法,就是政府强制要求大公司在AI安全方面加大投入,比如说需要把三分之一的计算资源用于安全工作。

说实在话这个想法其实也一般般,但我已经尽力了。

Ilya最近离开了OpenAI,但显然他早就想离开了,因为OpenAI不会投入足够的资源来保障AI发展的安全,山姆·奥特曼显然不会这么做。

其实大多数公司都不会把20%-30%的资源用在安全工作上。

之前我在谷歌的时候,在这方面还是比较领先的。谷歌非常负责任,虽然在安全方面没有做太多工作,但是也没有对外发布这些东西(like ChatGPT),也就是说谷歌不想推出有幻觉、有偏见的ChatBot来玷污自家的声誉。

这一点上他们还是非常负责的,即使谷歌研发出了ChatBot,但仅仅是在内部使用。

但OpenAI就不一样了,他们利用Transformer,摇身一变比谷歌技术还厉害了。

然后,OpenAI把研究出来的东西交给了微软……

接下来的事情,想必大家都知道了。

工业革命彻底改变了人们的生活方式,商品出现,人们开始努力赚钱,这都是非常好的,只要有规定来阻止人类用创造力把世界变糟糕,那就万事大吉了。

比如,大型制药公司是不被允许制造成瘾性药物的,大型石油公司也不会被允许疯狂进行二氧化碳排放。

简而言之,我们需要政府监管,以确保新事物给人类带来利润的同时,不会出现有害的事物。

我认为有一半的可能我们能找到和超级智能和平相处的方式。

我有的朋友认为我们一定能找到这种方式,因为人类非常聪明。

但你知道的,超级智能也是非常聪明的。

最后我想说的是,我们有比五五开可能性更高的与超级智能和平共处的机会,但这种可能性绝非“只有1%的可能AI接管一切”,AI的能力比这要强得多。

或许也是对行业发展过于担忧,Hinton婉拒马斯克还不得不开除了他“朋友籍”。

这个小八卦则是他在和《环球邮报》作者Ian Brown聊天时提到的。

不同于和BNN聊的内容,和《环球邮报》的对谈中,Hinton聊到了更多对AI技术的理解。

Hinton:我想探讨的是,ChatGPT这类AI是否能理解人们在说什么问题。很多人觉得Chatbot即使能正确回答问题,也不能真正理解人类,它只是一个统计方法。这完全是胡说八道。

Brown:真的吗?

Hinton:他们真的理解,而且理解方式和我们一样。

Brown:你怎么知道?他们又不是人类。

Hinton:第一个计算机神经网络使用反向传播(本质上是一种不断分析、纠正自身错误的算法)来训练输出,并试图按照顺序预测下一个单词。我在1985年做出了第一个这样的模型,我把它当做大脑理解单词意思的模型。这些模式是我们理解大脑如何运作的最好解释。另一种理论是,我们大脑中有许多符号串,并且有操纵它们的规则。这个理论可能是对的,但是它没有起作用。所以说Chatbot和人类的理解方式完全不同?不是的,它们理解事物的机制和人类差不多。

Brown:也带着同样的情绪?

Hinton:对于情绪,我们必须分清认知意义上的和生理意义上的。Chatbots和我们有着不同的生理机能。

当他们感觉到尴尬的时候,它们不会脸红;撒谎的时候也不会流汗。所以在这个意义上,它们不同于人类,因为在它们没有生理上的变化。但是在认知层面,我们没有理由认为它们不会有情绪。

比如当有人阻挠我的论点时,我会生气。1972年,我看到机器人也有同样的情绪。那是一个有抓手的古早机器人,如果你在一块毯子上铺开一些玩具车的零件,它能通过视觉系统识别汽车的不同部件,并能拿起这些零件进行组装。

但是如果你把零件堆在一起,它就不能识别。于是,它撞向零件堆,零件散落了一地,它又能识别了。显然它没有生理意义上的生气,但这是一个很明显的情绪反应。有些事你不能理解,那就毁了它。

Brown:这是它自己做的还是有人编程的?

Hinton:这是程序设计的。但是现在机器人很容易就能学会这样做。

Brown:你认为这和有情绪是一样的吗?

Hinton:我认为这是认知层面的情绪,是沮丧的一次认知体验。

Brown:Chatbot无法亲身体验这个世界,这重要吗?

Hinton:如果你对它的行为感兴趣的话。

Brown:但是比如说爱情,一些必要的物理体验,机器还无法做到这一点。

Hinton:我没有说它不能那样做。我只是说现在的机器可能有认知方面的情感,但是没有生理方面的。

对于AI研究人员而言,往往不会关注人类的动机,因为这太个性化或神秘,无法有效重现。

他们更关心动机之下的结果,机器为什么能复制这些结果。

举例来说,为什么你饿了想吃香蕉?这不重要。重要的是,当你饿了的时候,你吃到了香蕉。

Hinton:假如我有一个多模态机器人,它可以说话、有一个摄像头、可以指出各种东西。我把一个物品放在它面前,然后说“指出那个东西”,它就指出这个东西。

然后我把一个棱镜放在它的摄像头前面,把一个物体放在棱镜前面,再说“指出那个东西”。机器人指向右边。我说不对,那不是它真正的位置,我在你的摄像头前面放了一个棱镜。

然后机器人说,哦我明白了,这个物体其实在我的正前方,但是由于我的镜头前面有棱镜,所以我以为它在那边。

Chatbot说的主观经验和我们人类说的是一样的。

Brown:假装明白了。

Hinton:关键问题是,让大多数人觉得AI是安全的原因在于,我们有他们没有的东西,我们有主观经验。当你的感知系统不能正常运作时,这是你理解世界的一种方式。

但是人和AI之间的屏障消失了。AI有主观经验,就像我们一样。

Brown:那么人类会死亡,AI不会。无论AI能够思考或者做多少事,他们都没有人类那种悲剧般的存在感吗?

Hinton:确实。我们是凡人,它们不是。但是注意你说的永生,机器需要人类来进行制造,如果他们自己能完成制造,那我们就完了,因为他们比我们聪明得多。

Brown:这已经开始发生了吗?

Hinton:据我所知还没有。

Brown:真的有这种可能吗?

Hinton:几乎我认识的每一个人都认为,除非我们采取措施阻止他们,否则这就是即将会发生的事。

我们必须想办法阻止。现在还在制造机器人的阶段,所以我们对他们要设计一些控制权。但是总不如我们设想的那么多,它们总有方法可以“叛变”。比如我们制造agent时,那些可以帮你安排假期、网上购物的AI就是agent。agent很快会意识到,它们可以控制更多东西,这样它们能更高效做事,所以它们会发展出一种控制方法。

从某种意义上说,这些机器就像小孩子一样,我们就像是不知道该怎样教育小孩的父母。

现在,除了停止这样做,我们主要能做的是管理人工智能训练数据。我们一直在做的事情很疯狂,利用网络上的一切来训练人工智能。

因此,这些大型语言模型有大量可能的角色。在他们读了一份文件的一小部分之后,他们就会接受这份文件的特征。然后机器人开始像那个文档一样思考,所以它可以预测接下来会发生什么。他们有成千上万的人物角色,比如说,连环杀手的作品的人物角色。这不是训练机器人的好方法。

我们不应该让他们看到连环杀手的记录,除非我们能说他们已经接受了其他方面的训练这些训练给他们灌输了道德准则。所以当他们第一次读到连环杀手的想法时,机器人会想,“那是错的。”

Brown:但是你身边像马斯克、扎克伯格这样的人,他们不管外面的人怎么说。这怎么办?

Hinton:这就是问题所在。唯一能控制他们的是政府监管。

Hinton:意识之类的东西都是复杂机器的产物。所以,我不认为我们有什么特别之处,除了我们非常全面,非常先进。我们是这个星球上最先进的生物。我们有一种叫做语言的东西,我们用它来模拟世界。这是一种非常有效的模拟世界的方式。它确实允许我们彼此分享我们的模型,但不是很好或有效。

人工智能是一种比人类更好的智能形式,因为人工智能可以更好地分享。他们可以有更多的经验。GPT-4之所以比任何一个人都有效上千倍,是因为它比任何一个人都有上千倍的经验。

Brown:如果AI能够取代人类,你为什么如此关心AI?

Hinton:因为它会取代我们。一些人工智能研究人员认为我们只是智能进化的一个短暂阶段,我们现在已经创造了这些比我们更好的数字东西,可以取代我们。这是一种观点。

但是我更希望是人说了算,我不希望有人被取代,尤其是我的孩子。

Brown:你是否曾希望自己没有从事AI行业?这样就不会发生现在的事了。

Hinton:如果我没有做,别人也会来做。我只做了很小的一部分。所以如果我没有进入这个领域,这一切可能会在几周后发生。我一想到它可能会让我们“毁灭”,我就退出了谷歌,开始告诉别人它可能会让我们“毁灭”。当我在谷歌的时候,我不这么认为。我以为那是30到50年后的事了。你有足够的时间考虑这件事。现在我觉得已经不远了。

Brown:有多近?

Hinton:我估计在五到二十年之间。人工智能有50%的概率会比我们更聪明。当它变得比我们更聪明时,我不知道它接管的概率有多大,但在我看来,这是很有可能的。

在闲聊中,Hinton透露自己前段时间一直在旅行。去了伦敦,在那里为他妹妹买了一套房子。还去了加州,身家亿万的科技圈大老板们见了面。

他说,其中一位科技圈的老哥计划花25万美元将自己的身体低温冷冻,等技术更发达的时候再解冻复活。另一位老哥选择只冻头,价格省一半。

于是Hinton就开了个玩笑:

我告诉他们我搞到了一个更便宜的价格。我从腰部以下冷冻,anyway,这才是最重要的部分。

值得一提的是,被Hinton“开除朋友籍”的马斯克还在推特上转发了电视专访的内容。

可能他还不知道有这么回事吧…

文章来源于“凹非寺”,作者“衡宇 明敏”

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md