就在昨晚,谷歌的明星开源大模型系列,又迎来两位新成员——Gemma 2 9B和Gemma 2 27B!

四个月前谷歌宣布重磅开源Gemma,四个月后Gemma 2上线,专门面向研究和开发人员。

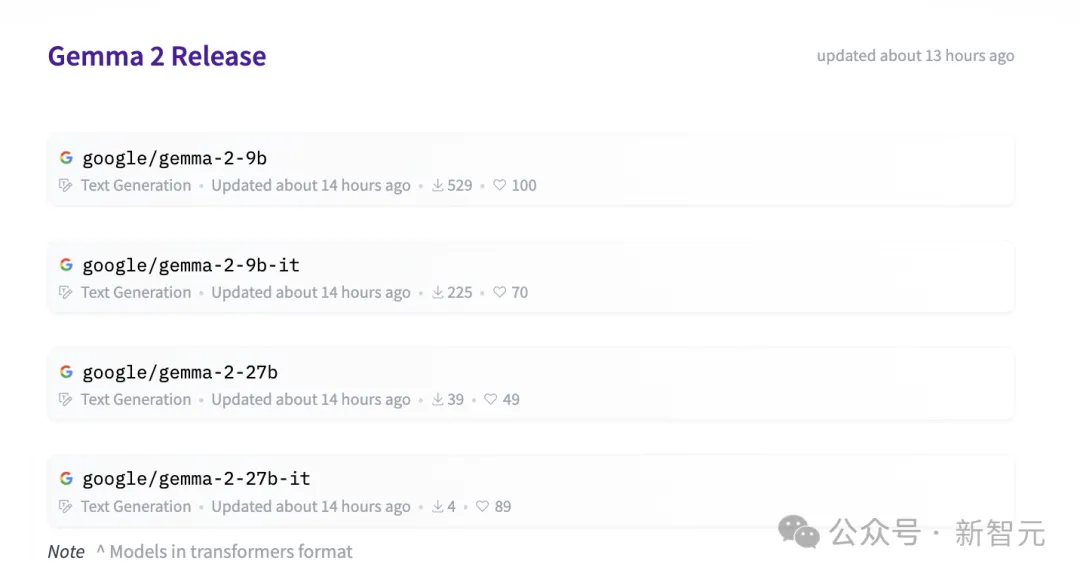

目前,模型权重已经在HuggingFace上公开。

项目地址:https://huggingface.co/collections/google/gemma-2-release-667d6600fd5220e7b967f315

Gemma 2的核心亮点概括来说就是:参数虽小但性能极佳。

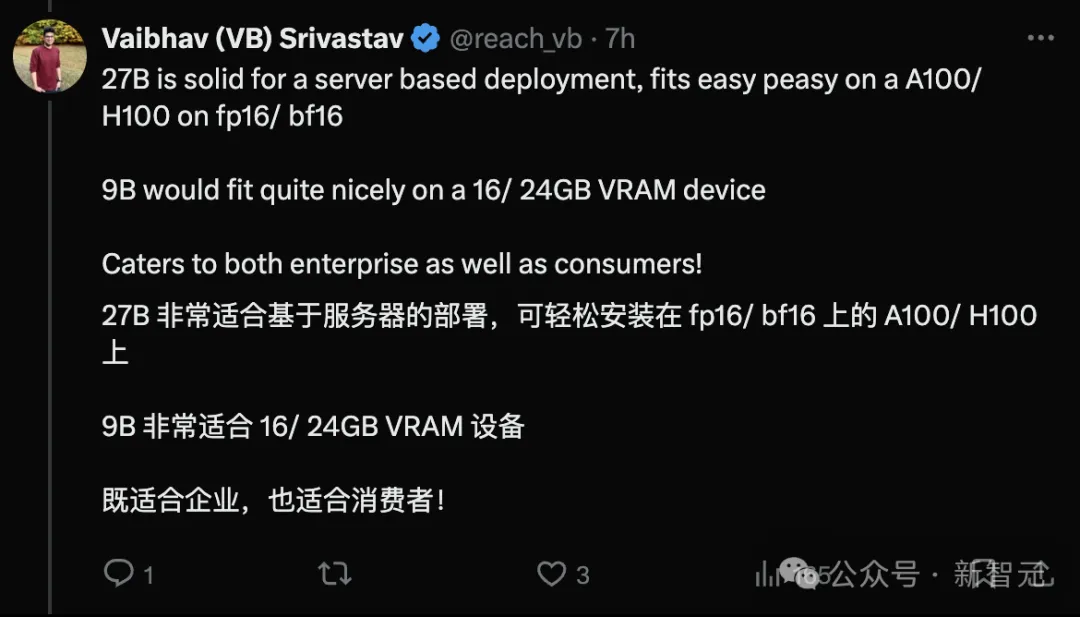

而且,27B模型甚至可在单张谷歌云TPU、英伟达A100 80GB GPU或英伟达H100 GPU上,以全精度高效运行推理。

Gemma 2在设计的架构上均有创新,旨在实现卓越的性能和提高推理效率。

在技术报告中,Gemma 2最引人注目的三大创新优势在于:

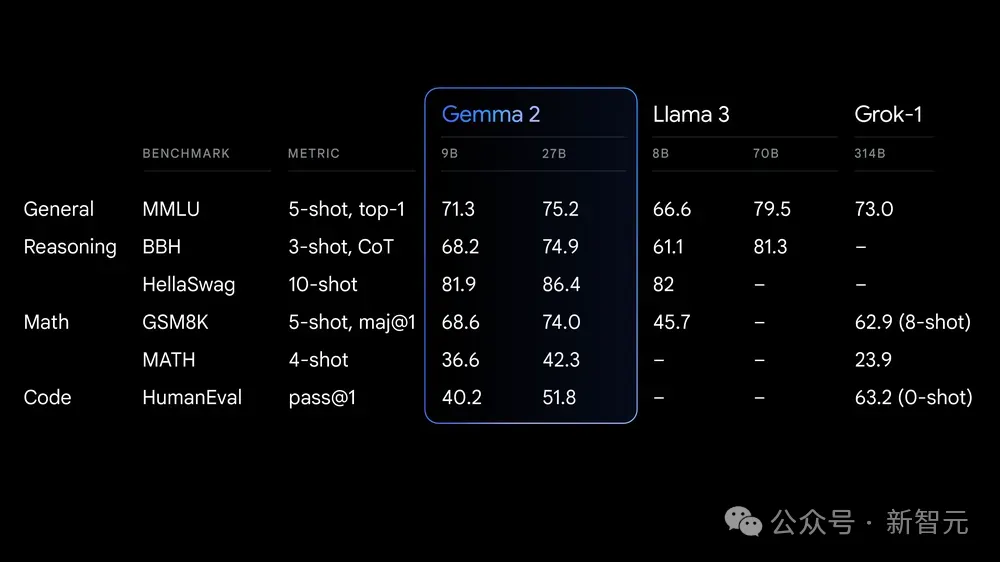

Gemma 2 27B在同类产品中性能最佳,甚至能挑战规模更大的模型。

Gemma 2 9B的性能在同类产品中也处于领先地位,超过了Llama 3 8B和其他同规模的开源模型。

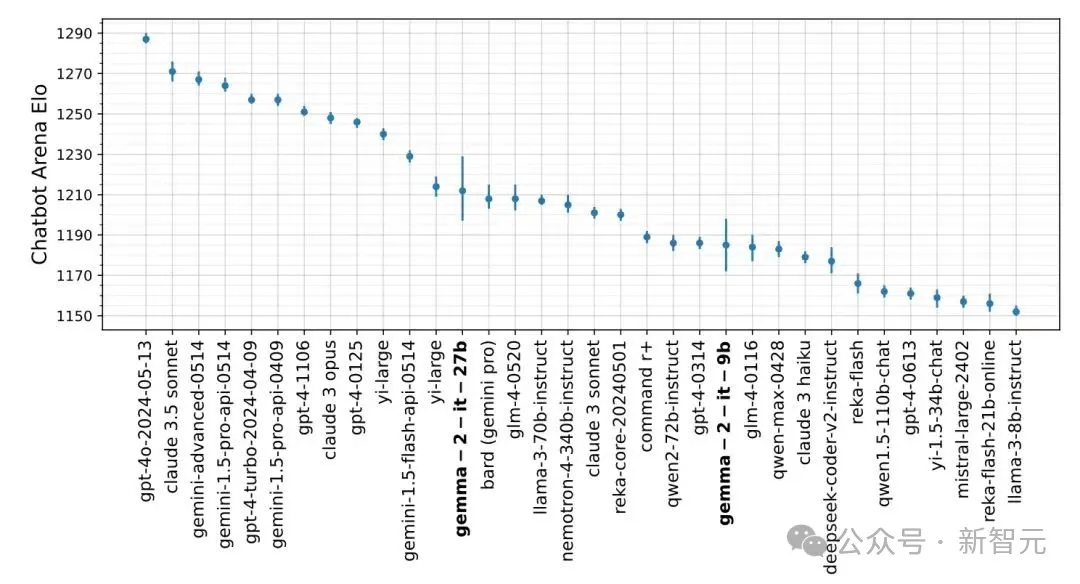

与其他大模型在Lmsys同场竞技,同等规模模型中Gemma 2的性能「一览众山小」。

27B模型可用于在单个谷歌Claude TPU主机或NIVIDIA H100 GPU上以全精度高效运行推理,从而在保持高性能的同时大幅降低成本。

用较小的模型规模能够在更广泛的硬件上部署,对于开发者和研究人员带来许多便利。

Gemma 2经过优化,可在各种硬件上以惊人的速度运行。

比如在Google AI Studio中尝试全精度的Gemma 2,在CPU上使用量化版本 Gemma.cpp解锁本地性能,或通过 Hugging Face Transformers库在配备英伟达RTX或GeForce RTX的家用电脑上,均可使用。

Gemma是谷歌团队推出的一系列轻量级、先进的开源模型,基于与Gemini模型相同的研究和技术构建的文本生成解码器大型语言模型。

Gemma 2训练数据量大约是第一代的两倍,并沿用了上一代的基本架构,但进行了全方位的改良。

Gemma 2交替使用局部滑动窗口注意力和全局注意力层级进行切换,局部注意力层的滑动窗口大小设置为4096个token,而全局注意力层的设置为8192个token。

在正确捕捉文本细节的同时,又能保持对上下文和全局的正确理解。

按照Gemini 1.5版,Gemma对每个注意层和最终层的logit进行软封顶。

通过将logits设置在一个合理的固定范围内,可以有效提升训练的稳定性,防止内容过长。

为了使训练更加稳定,Gemma 2运用了RMSNorm对每个转换层、注意层和反馈层的输入和输出进行归一化。

这一步和Logit软上限都使得模型训练更稳定平滑,不易出现崩溃。

GQA通过对于注意力分组,将算力用于一组注意力的组内。

在计算时显示出更快的数据处理速度,同时还能保持下游性能。

传统训练大语言模型的方法主要是根据上一个Token,预测下一个Token,需要大量的数据进行训练。

但是,人类的学习过程并不依赖走量的知识输入。比如,一位学生由于阅读原著的需要学习一门外语,他并不需要看遍所有的书籍,只需要以一本书为纲,通过理解后融会贯通。

而知识蒸馏法与人的学习过程更加类似。一个小模型向另一个已经进行过预训练的大模型学习,通过这种方式助产小模型对于Token的预测。

站在老师模型的肩膀上,学生模型能用较少的训练数据达到更好的效果。

人工智能有可能解决人类一些最紧迫的问题,但前提是每个人都拥有使用人工智能的工具。

因此,Gemma 2非常注重实用性,轻量级且开源是Gemma 2最核心的两个关键词。

Gemma 2同样沿用了Gemma 1的许可证,使开发人员和研究人员能够共享他们的创新成果并将其商业化。

此外,Gemma 2具有广泛的框架兼容性。

Gemma 2可通过本地Keras 3.0、vLLM、Gemma.cpp、Llama.cpp与Ollama、Hugging Face Transformers等主要人工智能框架兼容,从而轻松地将 Gemma 2与个人偏好的工具和工作流程结合使用。

从下个月开始,Google Cloud客户将能够在Vertex AI上轻松部署和管理Gemma 2。

例如,用户可以自己探索新的Gemma Cookbook,其中包含一系列实用示例和codebook;也可指导构建自己的应用程序,并针对特定任务微调Gemma 2模型。

因此,Gemma 2对于个人使用非常便利,能够轻松地将Gemma与各类工具结合使用,包括用于精准检索等常见任务。

Gemma 2在实用高效的同时,也从安全角度做出了新举措。

谷歌提供了「负责任的生成式AI工具包」,LLM Comparator可以让开发人员和研究人员深入评估语言模型,使用实用工具的同时保证安全部署。

就个人用户而言,可以使用配套的Python库对模型和数据运行比较评估,并在应用程序中将结果可视化。

另外,在训练Gemma 2时,预训练数据都经过了严格的筛选,并根据一套安全指标进行严格的测试和评估,以识别并降低潜在的偏差和风险。

可以看出,AI安全在成为越来越多人关注的问题后,谷歌着重平衡了智力进展和安全保障。希望在后续的网友测评中,不会再出现Gemini 1.5 Pro的翻车案例了。

Gemma首次推出后,下载量超过1000万次。

全球各地都使用Gemma制作项目。例如,Navarasa利用Gemma创建了一个植根于印度语言多样性的模式。

Gemma 2目前可以在Google AI Studio中使用,在Gemma 27B下测试其全部性能,而无需硬件要求。

此外,为方便研发人员使用,Gemma 2还可通过Kaggle或谷歌Colab免费获取。

参考资料:

https://blog.google/technology/developers/google-gemma-2/

文章来自于微信公众号“新智元”,作者 “耳朵”

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner