只需几分钟、一张图或一句话,就能完成时空一致的4D内容生成。

注意看,这些生成的3D物体,是带有动作变化的那种。也就是在3D物体的基础之上,增加了时间维度的运动变化。

这一成果,名为Diffusion4D,来自多伦多大学、北京交通大学、德克萨斯大学奥斯汀分校和剑桥大学团队。

具体而言,Diffusion4D整理筛选了约81K个4D assets,利用8卡GPU共16线程,花费超30天渲染得到了约400万张图片,包括静态3D物体环拍、动态3D物体环拍,以及动态3D物体前景视频。

作者表示,该方法是首个利用大规模数据集,训练视频生成模型生成4D内容的框架,目前项目已经开源所有渲染的4D数据集以及渲染脚本。

过去的方法采用了2D、3D预训练模型在4D(动态3D)内容生成上取得了一定的突破,但这些方法主要依赖于分数蒸馏采样(SDS)或者生成的伪标签进行优化,同时利用多个预训练模型获得监督不可避免的导致时空上的不一致性以及优化速度慢的问题。

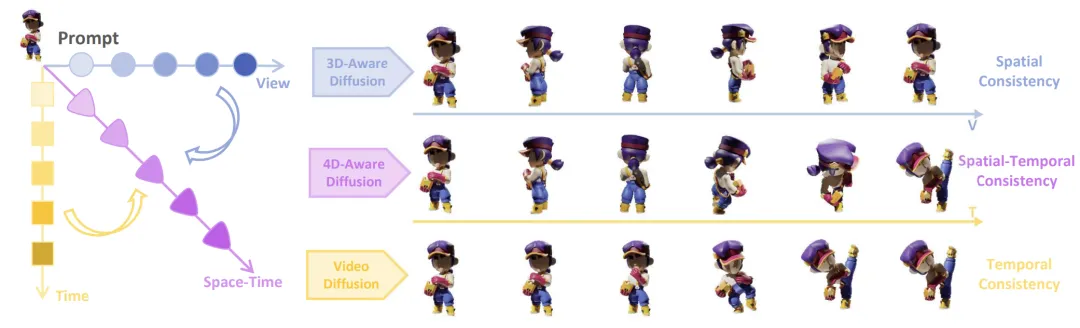

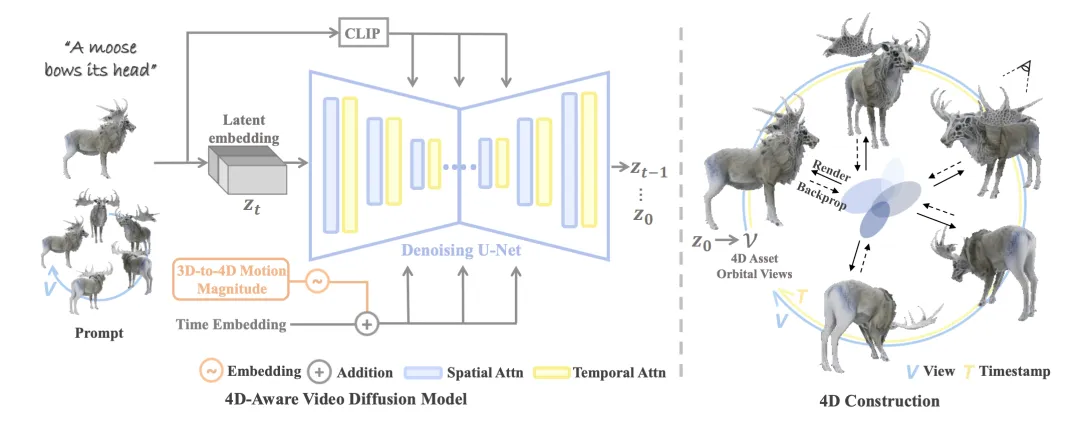

4D内容生成的一致性包含了时间上和空间上的一致性,它们分别在视频生成模型和多视图生成模型中被探索过。基于这个洞见,Diffusion4D将时空的一致性嵌入在一个模型中,并且一次性获得多时间戳的跨视角监督。

具体来说,使用仔细收集筛选的高质量4D数据集,Diffusion4D训练了一个可以生成动态3D物体环拍视图的扩散模型,而后利用已有的4DGS算法得到显性的4D表征,该方法实现了基于文本、单张图像、3D到4D内容的生成。

为了训练4D视频扩散模型,Diffusion4D收集筛选了高质量的4D数据集。

已开源的Objaverse-1.0包含了42K运动的3D物体,在Objaverse-xl中包含323K动态3D物体。然而这些数据包含着大量低质量的样本。对此,研究者们设计了运动程度检测、边界溢出检查等筛选方法,选取了共81K的高质量4D资产。

对于每一个4D资产,渲染得到了24个静态视角的图(上图第一行),24个动态视角的环拍图(上图第二行),以及24个正面动态图(上图第三行)。总计得到了超过四百万张图片,总渲染消耗约300 GPU天。

其他数据集细节可以参考项目主页(文末附上),目前所有渲染完的数据集和原始渲染脚本已开源。

有了4D数据集之后,Diffusion4D训练具有4D感知的视频扩散模型(4D-aware video diffusion model)。

过去的视频生成模型通常不具备3D几何先验信息,但近期工作如SV3D,VideoMV等探索了利用视频生成模型得到静态3D物体的多视图,因此Diffusion4D选用了VideoMV作为基础模型进行微调训练,使得模型能够输出动态环拍视频。此外设计了如运动强度(motion magnitude)控制模块、3D-aware classifier-free guidance等模块增强运动程度和几何质量。得益于视频模态具备更强的连贯性优势,输出的结果具有很强的时空一致性。

输出得到动态视角环拍视频后,Diffusion4D借助已有的4D重建算法将视频建模得到4D表达。具体来说采用了4DGS的表征形式,以及使用粗粒度、细粒度的两阶段优化策略得到最终的4D内容。从生产环拍视频到重建4D内容的两个步骤仅需花费数分钟时间,显著快于过去需要数小时的借助SDS的优化式方法。

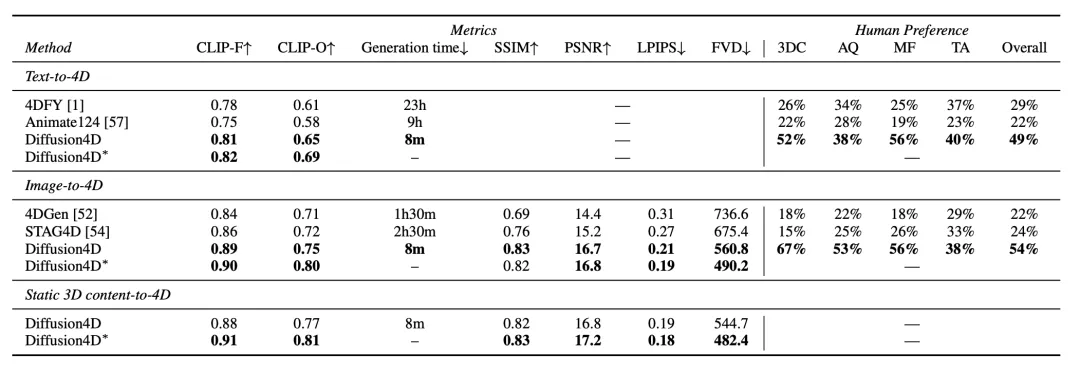

根据提示信息的模态,Diffusion4D可以实现从文本、图像、3D到4D内容的生成,在定量指标和user study上显著优于过往方法。

在生成质量上,Diffusion4D有着更好的细节,更为合理的几何信息以及更丰富的动作。更多可视化结果可以参考项目主页。

Diffusion4D是首个利用视频生成模型来实现4D内容生成的框架,通过使用超81K的数据集、以及精心设计的模型架构实现了快速且高质量的4D内容。未来,如何最大程度发挥4D数据集价值,如何生成多物体、复杂场景的4D内容仍有很大的探索空间!

项目地址:

https://vita-group.github.io/Diffusion4D/

论文地址:

https://arxiv.org/abs/2405.16645

文章来自于微信公众号“量子位”,作者 “Diffusion4D团队”