OpenAI最新绝密项目曝光!

知情人士透露,OpenAI正在开发一个名为“草莓(Strawberry)”的新模型,它的前身是Q*。

其工作机制在内部被严格保密,且细节从未被外界报道过。

消息称,“草莓”模型不仅在超大规模数据集上完成预训练,并且采用了一种特殊的方法。

马斯克已火速赶来吃瓜:

之前都说,AI灾难会是回形针成灾。如今来看,可能是草莓田了。(哲学家尼克·博斯特罗姆曾提出高度智能的AI可能被设计为回形针,意思是看似无害但可能风险巨大)

本周二,OpenAI在一次内部全体会议上展示了一个demo。据称该项目的推理能力已接近人类水平。

尽管OpenAI拒绝透露会议具体内容,无法确定该项目是否就是“草莓”。但可以肯定,推理能力被业界认为是AI达到人类智能水平的关键。

巧合的是,周二OpenAI科学家Noam Brown发了一条推特,感慨OpenAI总是会坚定地在重大研究方向上持续押注。

而这位科学家去年才跳槽到OpenAI,主要负责研究模型推理能力,之前一直被认为在研究Q*。

在最新曝光信息中,还显示“草莓”使用的推理方法和2022年斯坦福发表的一种方法相似。

具体来看更多细节。

据路透社消息,5月份他们看到了OpenAI一份内部文件副本,上面详细说明了“草莓”项目的研究计划。

消息人士称这是一项正在推进的工作。但是“草莓”的工作原理在OpenAI内部被严格保密。

文件中显示,公司希望“草莓”模型不仅能生成答案,而且能执行长任务(LHF),包括提前进行规划,自主可靠地在互联网上导航以及一系列行动。

比如通过CUA(一种计算机代理)的帮助来自动浏览网页,该代理可以根据发现内容采取行动。

十余位业内人士认为,这是当下AI模型所不能解决的问题。

为此,OpenAI正在开发训练评估这些模型。内部形成了一个名为“深度研究”的数据集,具体内容不详。同时OpenAI还计划测试模型可以如何影响软件和机器学习工程师的工作。

在被问及关于“草莓”的细节时,OpenAI一位发言人没有直接回答问题,但是在一份声明中表示:

我们希望我们的爱模型能像人类一样看到和理解世界,不断研究新模型是行业内都在做的事,大家都相信随着时间推移,这些系统的推理能力将得到改善。

据了解,“草莓”的前身是Q*。

此前消息称,Q*被OpenAI视为一项重大突破。一些看过Qdemo的内部人员表示,该项目能回答其他大模型所不能应对的棘手科学和数学问题。

知情人士表示,OpenAI希望通过该项目大幅提升AI模型的推理能力,“草莓”已经在非常大的数据集上完成预训练,并使用了一种专门的处理方法。

包括后训练(post-training);或者在已经进行大规模训练后,再调整基础模型来“磨炼”性能。

后训练部分包括常见的微调、人类反馈强化学习(RLHF)等。

值得一提的是,一位知情人士透露,“草莓”与斯坦福大学在2022年(当时ChatGPT还未发布)提出的一种名为自学推理(Self-Taught Reasoner,简称STaR)的方法很相似。

就在今年,斯坦福团队又基于STaR,提出了一种名为Quiet-STaR的推理方式,简写的话就是Q*了。

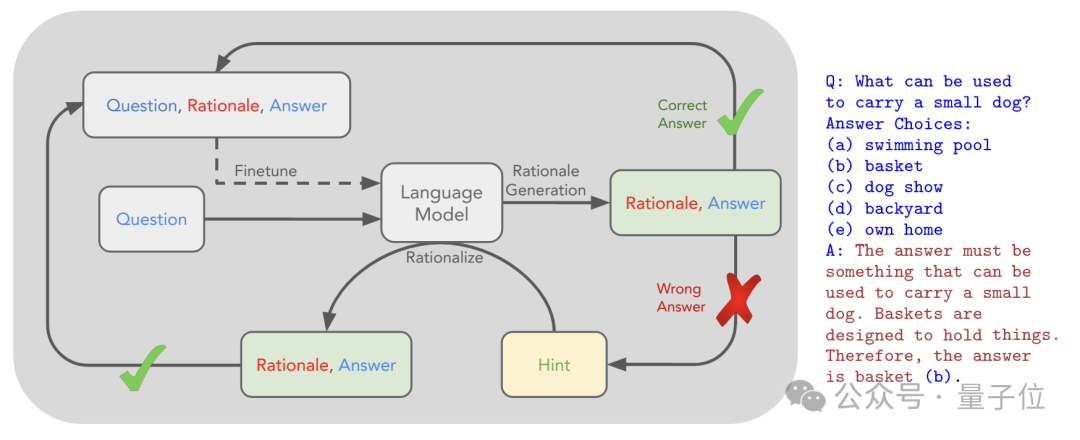

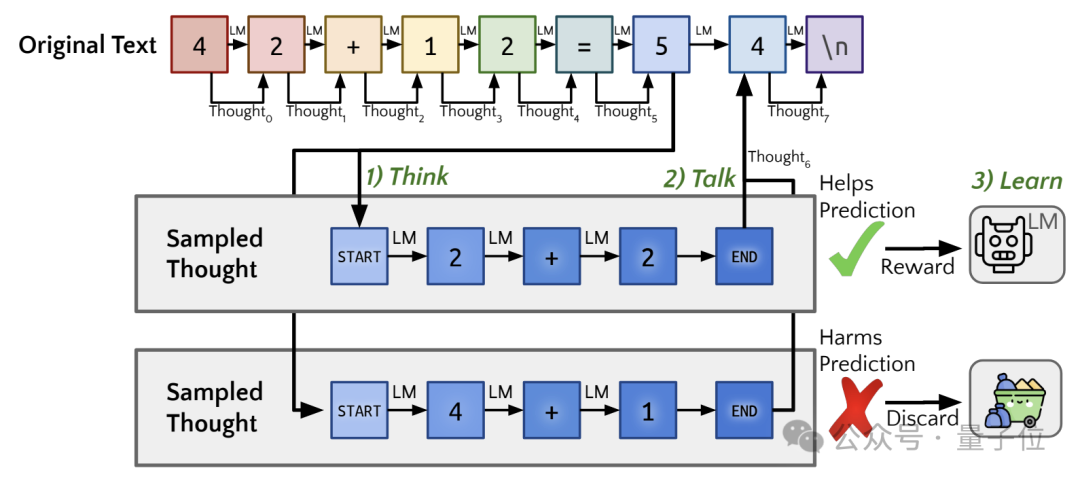

不过还是先从基础的STaR说起,它的创新点在于不依赖大规模人工标注的数据集进行训练,通过自举的方式让大模型自己学会如何推理。

具体来说,一开始会把少量带有推理步骤的样本作为示范,与待推理的问题一起输入给模型。

然后模型会生成每个问题的推理步骤和答案,从中筛选出推理结果正确的样本,将其作为新的训练数据。

对于无法正确推理的问题,作者还引入了“反向推理”机制,将正确答案作为提示,让模型倒推对应的推理步骤,将生成结果并入训练集。

最终,作者用新的训练数据微调原始语言模型,重复进行推理生成,直至性能趋于稳定。

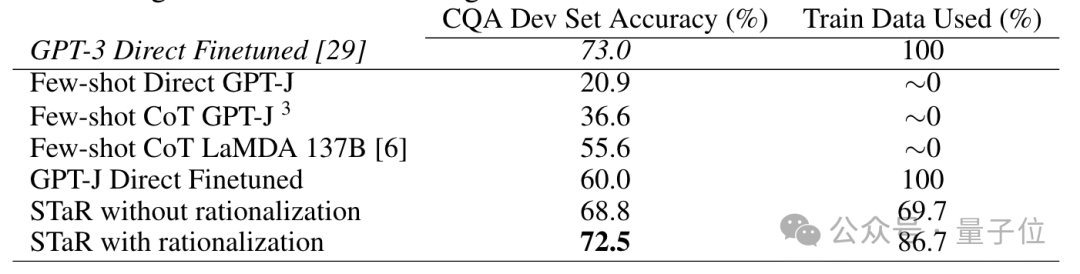

结果,在CommonsenseQA数据集上,STaR将GPT-3 Curie(6.7B参数)的准确率从33.6%提升到72.5%,与30倍参数量的微调模型(GPT-3 DaVinci,175B参数)性能相当。

时隔两年,本次发布的Quiet-STaR,在此基础之上做出了一些重要改进。

其中最核心的是把推理过程的生成从显式的思考变成了隐式的内部思考,实现了对推理过程的静默建模,这也就是名称中quiet的由来。

不同于STaR在输入中明确包含生成推理步骤的prompt,Quiet-STaR直接在模型内部、每个token处并行地生成推理过程。

同时,Quiet-STaR引入了可学习的“思考开始”和“思考结束”特殊token,使模型能够自主学习何时开始和结束推理。

为了缓解推理引入的分布偏移问题,Quiet-STaR使用了一个混合头来动态融合有无推理时的下一token预测结果,使模型能够平滑过渡到生成推理的状态。

另一个不同点是,Quiet-STaR采用了一个非短视的、多步预测的训练目标。模型生成推理时,不仅要考虑下一个token,还要考虑对之后多个token的影响,从而生成高质量、长远的推理。

数据方面,Quiet-STaR不再局限于STaR使用的特定推理数据集或任务,而是使用了互联网文本等大规模语料,让模型的推理能力更加多样化。

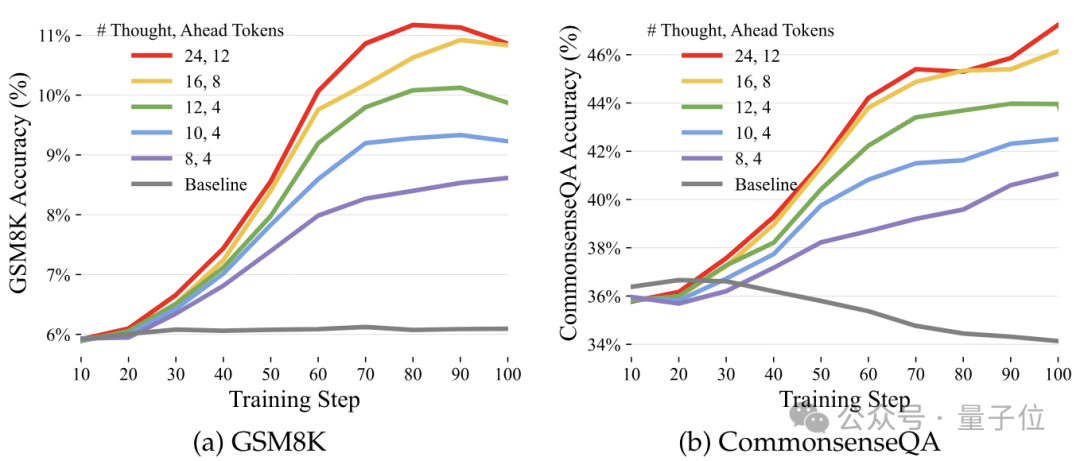

效果上看,这次的baseline模型换成了Mistral-7B,在GSM8K和CommonsenseQA两个数据集上,应用Quiet-STaR训练后准确率均有所提升,且随着思考token数量增加提升越来越明显。

具体来说,baseline模型在GSM8K和CommonsenseQA上的准确率分别是5.9%和36.3%,加入Quiet-STaR后最高上升到了10.9%和47.2%。

论文作者Noah Goodman教授表示,对于最新曝光的消息,他感觉既兴奋又恐惧。

如果一切真的朝着这一方向发展,那么作为人类就要考虑一些严肃的问题了。

对于最新的曝光内容,有人觉得是炒作,有人觉得这倒是比语音模型进展有意思。

还有人觉得,如果Noam Brown都认可了,那应该是一个值得期待的进展。

不过最近OpenAI内部的动作似乎又多了起来。

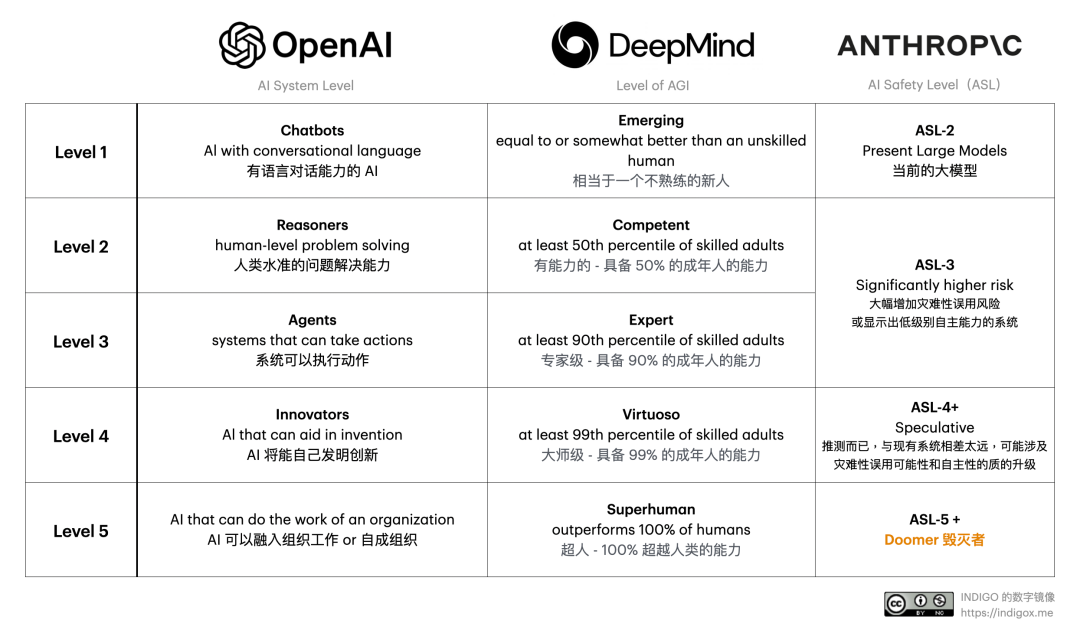

也是在周二这次全体会议上,OpenAI提出了一套评级来定义AI的进展。

一共可以分为5级:

最后一级L5,也就是达到AGI的最后一步。此前OpenAI将AGI定义为“在最具经济价值的任务中超越人类的高度自治系统”。

除了OpenAI以外,DeepMind、Anthropic也对AI系统提出了分级定义。

你更认可哪一家呢?

文章来源于“量子位”,作者“关注前沿科技”

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0