赶在 7 月结束前,GPT-4o 语音功能终于开启。现开启灰度测试,一小部分 ChatGPT Plus 用户已经可以试用。

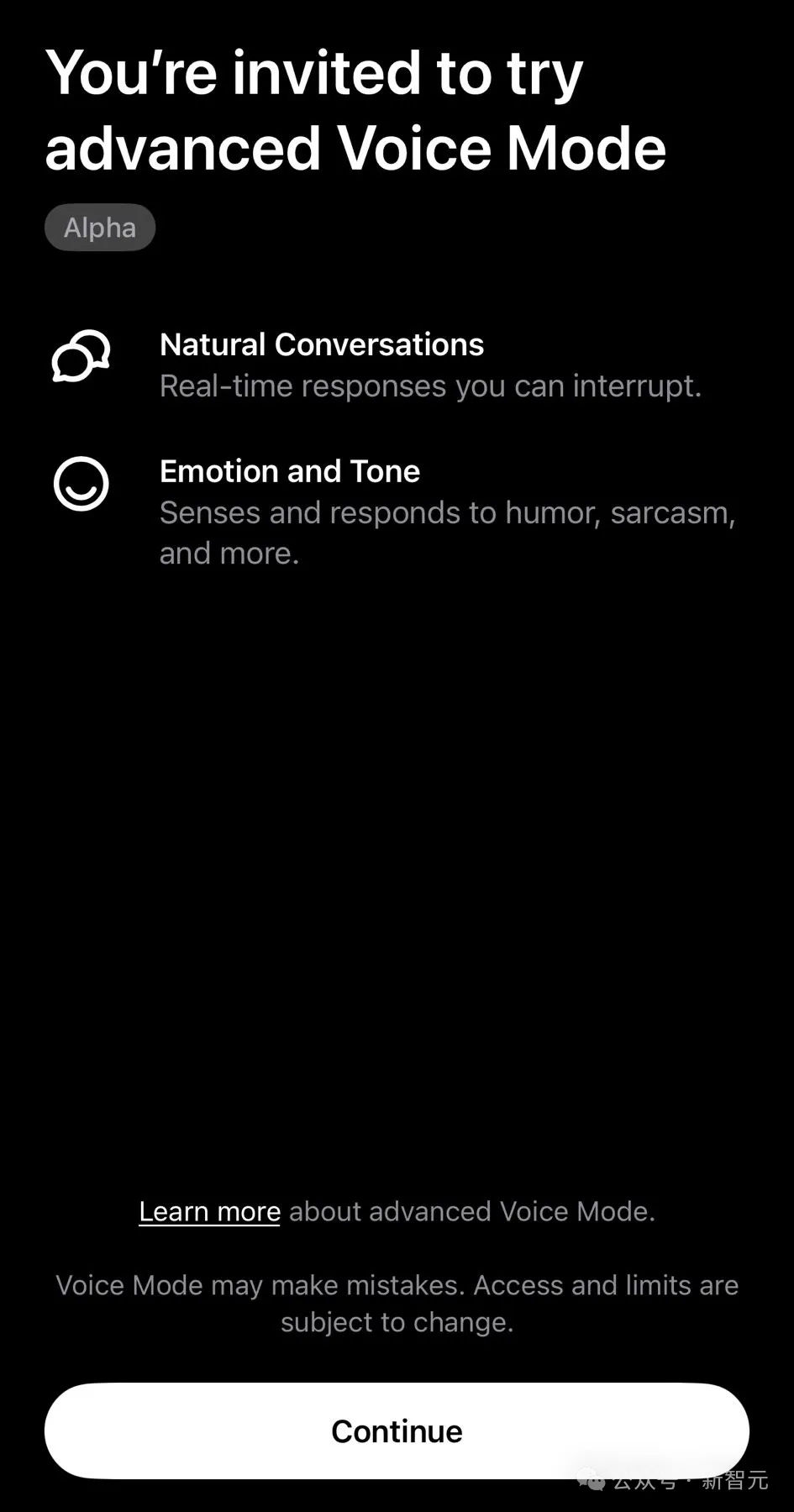

如果打开 ChatGPT App 之后看到了下面这个界面,恭喜你成为了首批幸运儿。

OpenAI 称,高级语音模式提供了更加自然、实时对话,可以随意打断,甚至它还可以感知、回应你的情绪。预计在今年秋季,所有 ChatGPT Plus 用户,都能用上。另外,视频和屏幕共享等更强大的功能也在稍后推出。也就是,开启摄像头,就能和 ChatGPT「面对面」聊天了。

与此同时,GPT-4o 的输出 token 暴涨16 倍,从最初 4000 个 token 增加到 64000 个 token。每次请求最多输出 200 页小说,大约 4 个完整的长篇电影剧本。

之所以现在才放出 GPT-4o 语音功能,是因为过去几个月里,OpenAI 一直对其进行安全性、质量测试。

他们与 100+红队人员,就 45 种语言对 GPT-4o 语音能力进行了测试。

为保护人们的隐私,团队训练模型只使用 4 种「预设声音」说话。

他们还创建了一个系统,去阻止在这 4 种声音之外,其他声音的输出。

此外,内容过滤也是必不可少,团队还采取措施阻止暴力、有关版权内容的生成。

OpenAI 预告,计划在 8 月初,会发布一份关于 GPT-4o 能力、局限性、安全评估的详细报告。

下面是网友分享的 GPT-4o 语音模式的一些案例。

有人就让它充当「二外教练」,教自己练习口语。

ChatGPT 在下面的教学中,帮助网友纠正了 Croissant(羊角面包)、Baguette(法式长棍)的发音。

ChatGPT 可以表演节奏口技。

ChatGPT 还可以以害羞、生气、更愤怒的语气讲出了关于啤酒的笑话。

还有网友专为 ChatGPT 讲了一个笑话「为什么科学家不相信 Adam-Atom,因为它们构成了一切」。

ChatGPT 不失尴尬地笑了起来。

更搞笑的是,ChatGPT 学起猫叫还是有一套的。

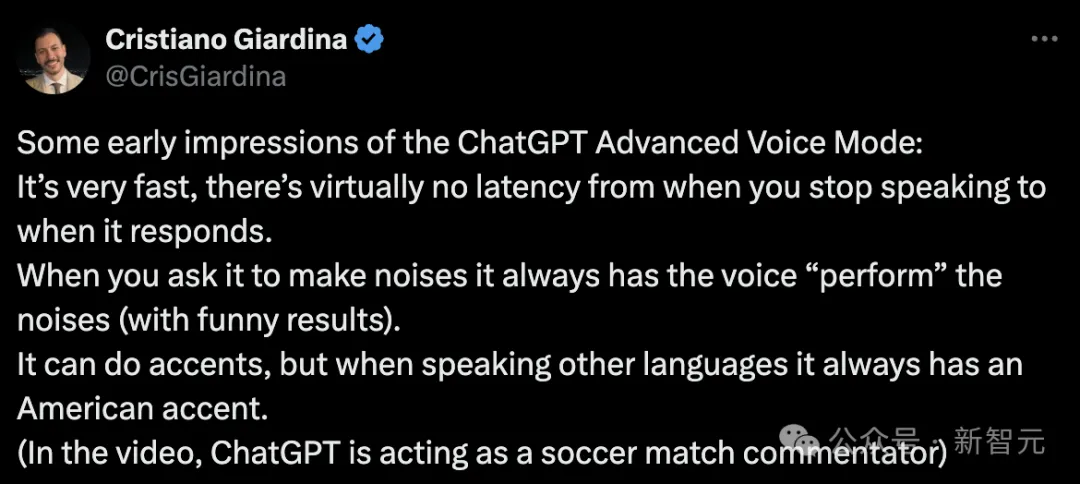

有人经过一番测试下来,发现 ChatGPT 高级语音模式非常快,回答几乎没有延迟。

当被要求模仿一些声音时,它总是可以真实复刻出声音。而且不同口音,也可以模仿出来。

下面这个视频中,展示了 AI 充当足球比赛解说员的场景。

ChatGPT 用中文讲故事,也很生动。

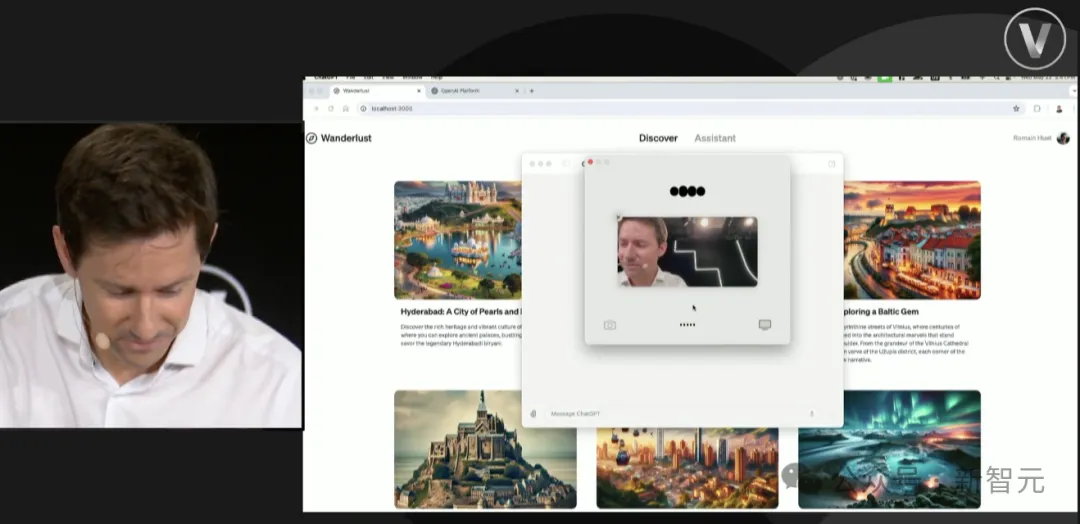

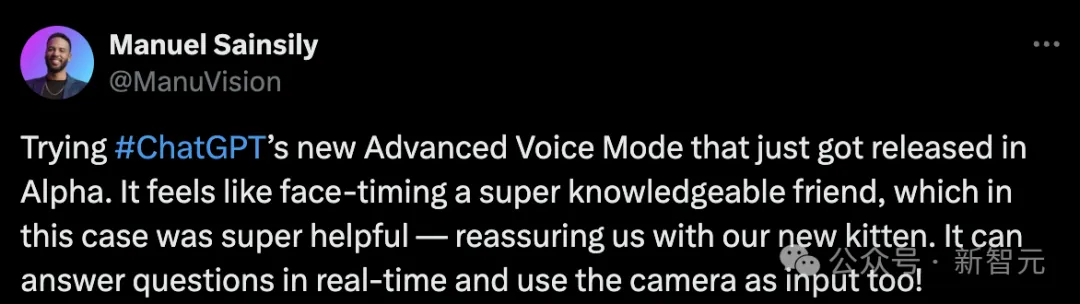

OpenAI 虽然声称,视频和屏幕共享功能稍后推出,不过已经有网友先用上了。

网友有一只猫咪新宠,为它搭建了小窝,准备了吃食,但不知道怎么样,于是就问问 ChatGPT。

在视频的对话中,网友向它展示了猫咪的屋子,ChatGPT 看过后评价道,「一定非常舒适」,并关心猫咪如何。

网友表示,它目前为止还没有吃东西,看起来有点担心。ChatGPT 安慰道,「这很正常,对于猫咪来说需要适应的时间」。

可以看出,整个问答过程非常流畅,给人一种与真人交流的感受。

网友还翻出了日语版界面游戏机,但是自己又不会日语。

这时,他一边向 ChatGPT 展示游戏界面,一边让其帮自己做翻译,最后胡一起通关游戏。

不得不说,有了视觉+语音模式的加持,ChatGPT 强了很多。

另外,支持更大 token 输出的 GPT-4o 随之而来。

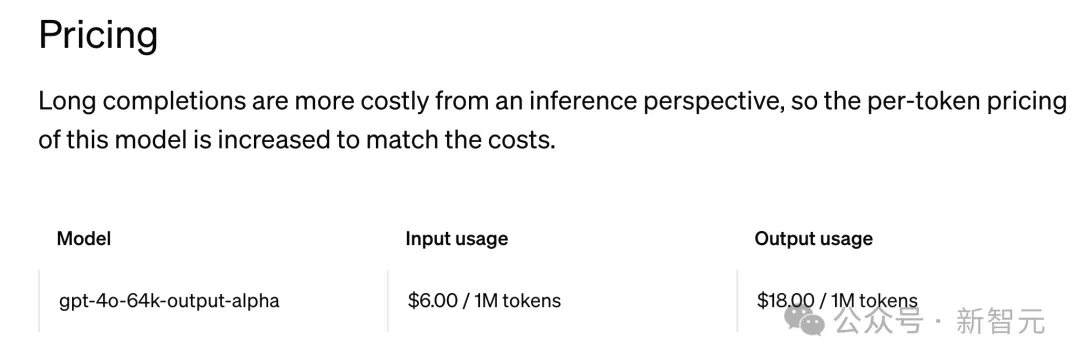

OpenAI 最近在官方网页中,悄然推出测试版新模型 gpt-4o-64k-output-alpha。

测试者可以从「gpt-4o-64k-output-alpha」,访问 GPT-4o 的长输出功能。

每次请求支持最多输出 64K token,相当于 200 页小说,一次性可以得到大约 4 个完整的长篇电影剧本。

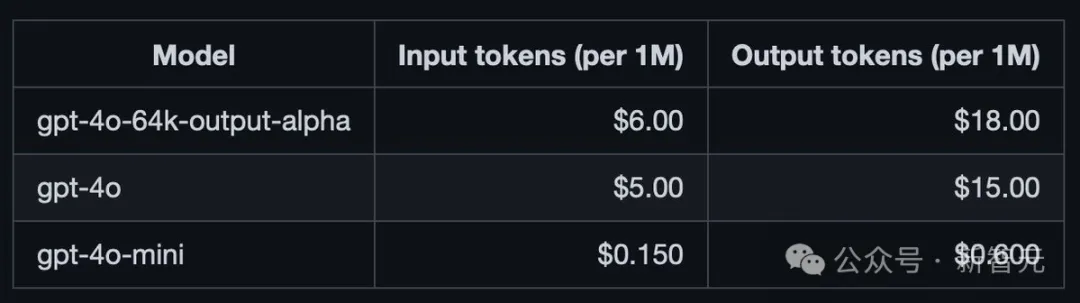

不过,新模型的价格再次刷新天花板。每百万输入 token 6 美元,每百万输出 token 18 美元。

虽说输出 token 是 GPT-4o 的 16 倍,但价格也涨了 3 美元。

这么一比,果然还是 gpt-4o-mini 价格香!

研究员 Simon Willison 表示,长输出主要用于数据转换用例。

比如,将文档从一种语言翻译成另一种语言,或从文档中提取结构化数据,几乎每个输入 token 都需要在输出的 JSON 中使用。

在此之前,他所知道的最长输出模型是 GPT-4o mini,为 16K token。

显然,更长的输出,可以让 GPT-4o 提供更全面、细致的响应,对于一些场景非常有帮助。

比如,编写代码、以及对写作的改进。

这也是基于用户的反馈——需要更长输出内容才能满足用例,OpenAI 才做出的调整。

GPT-4o 自推出以来,便提供了最大 128K 的上下文窗口。而对于 GPT-4o Long Output,最大上下文窗口仍然是 128K。

那么,OpenAI 如何在保持整体上下文窗口为 128K 的情况下,将输出 token 数量从 4,000 增加到 64,000 呢?

这是因为,OpenAI 在最初就限制了输出 token 数量,最大为 4000 个 token。

这意味着,用户可以在一次交互中最多以 124,000 个 token 作为输入,也最多只能得到 4000 个输出 token。

当然,你也可以输入更多 token,那就意味着输出 token 更少了。

毕竟长下文长度(128K)就固定在那里,不管输入怎么变,输出 token 也不会过 4000。

而现在,OpenAI 将输出 token 长度限制在 64,000 token,也就是说,你可以比以往多输出 16 倍的 token。

毕竟,输出计算量更大,价格涨幅也更大。

同样,对于最新的 GPT-4o mini,上下文也是 128K,但最大输出已提升至 16,000 个 token。

那么,用户可以提供最多 112,000 个 token 作为输入,最终得到最多 16,000 个 token 的输出。

总的来说,OpenAI 在这里提供了一个方案,限制输入 token,以获取 LLM 更长的响应,而不是直接扩大上下文长度。

而市面上其他模型,长的都已经超过百万了(Gemini),稍微短一些的也有 200K(Claude);甚至有的模型输出都已经达到了 200K,而 OpenAI 还在这儿抠抠搜搜。

这也就把难题扔给了开发者:想要输入多,那就得接受输出少;想要输出多,那就得输入少一些。

具体怎么衡量,看你们自己愿意牺牲哪一个了......

参考资料:

https://x.com/OpenAI/status/1818353580279316863

https://x.com/tsarnick/status/1818402307115241608

https://x.com/kimmonismus/status/1818409637030293641

https://www.reddit.com/r/singularity/comments/1eg51gz/chatgpt_advanced_audio_helping_me_pronouce/

https://venturebeat.com/ai/openai-launches-experimental-gpt-4o-long-output-model-with-16x-token-capacity/

文章来自于微信公众号“新智元” 作者 Founder Park

00:38