检查内容是否用了ChatGPT,准确率高达99.9%!

这个工具,正是来自OpenAI。

它能专门用来检测是否用ChatGPT水了论文/作业。早在2022年11月(ChatGPT发布同月)就已经提出想法了。

但是!

这么好用的东西,却被内部雪藏了2年,现在都还没对外公开。

为啥?

OpenAI对忠实用户做了调查,结果发现近三分之一的人都表示如果用了反作弊工具,他们就弃了ChatGPT。而且还可能对非英语母语的用户影响更大。

但公司内部也有人提出,使用反作弊方法对OpenAI生态有好处。

双方一直争执不下,该水印检测工具因此未发布。

而除了OpenAI,如谷歌、苹果也都准备了类似工具,有一些已开始内测,但都未正式上线。

ChatGPT大火后,不少高中生大学生都拿它来写作业,所以如何甄别AI生成内容也成为了圈内的热议话题。

从最新曝光的信息来看,OpenAI早在ChatGPT发布前就考虑到了这一问题。

当时开发这项技术的人是Scott Aaronson,他在OpenAI从事安全方面的工作,也是德克萨斯大学计算机科学教授。

2023年初,OpenAI联合创始人之一John Schulman,在一份Google文档中概述了该工具的优缺点。

随后公司高管决定,在采取进一步行动之前,他们将征求一系列人士的意见。

2023年4月,OpenAI的一项委托调查显示,全球范围内仅有1/4的人支持增加检测工具。

同月,OpenAI又对ChatGPT用户进行了调查。

结果显示,有近30%的用户表示,如果ChatGPT部署了水印,他们会减少使用ChatGPT。

此后,围绕这项工具的技术成熟度以及用户喜好的争议一直不断。

今年6月初,OpenAI召集了高级员工和研究人员再次讨论该项目。

据称最后大家一致认为,虽然技术上已经成熟了,但去年的ChatGPT用户调查结果还是无法忽视。

内部文件显示,OpenAI认为他们需要在今年秋天之前制定一项计划,以影响公众对人工智能透明度的看法。

不过直到目前消息曝出,OpenAI仍未透露出相关对策。

总结OpenAI迟迟不公开这项技术的原因,主要有两方面:一是技术,二是用户偏好。

先说技术,早在2023年1月,OpenAI就开发了一种甄别多个AI模型(包括ChatGPT)文本的技术。

这项技术利用了一种类似“水印”的方法,把看不见的标记嵌入文本中。

这样,当有人用检测工具分析文本时,检测器可以提供一个分数,表示文本由ChatGPT生成的可能性有多大。

不过当时成功率只有26%,仅过了7个月,OpenAI就撤回了。

后来OpenAI逐渐将技术的成功率提到了99.9%,从技术上讲,该项目大约一年前就已经可以发布。

然而,围绕技术的另一个争议是,内部员工认为该技术可能会损害ChatGPT写作质量。

同时,员工们还提出了一些关于“人们可能规避水印”的潜在风险。

比如大学生都会的“翻译术”,将文本翻译成另一种语言,然后通过类似谷歌翻译的方式再次翻译回来,从而有可能被擦除。

再比如有人搞个“上有政策下有对策”,一旦公开使用水印工具的人多了,网友们指定分分钟搞出破解版。

除了技术,另一大阻碍因素就是用户了,OpenAI的多项调查显示,用户们似乎并不看好这项技术。

这也不得不提到用户们到底拿ChatGPT在干啥?

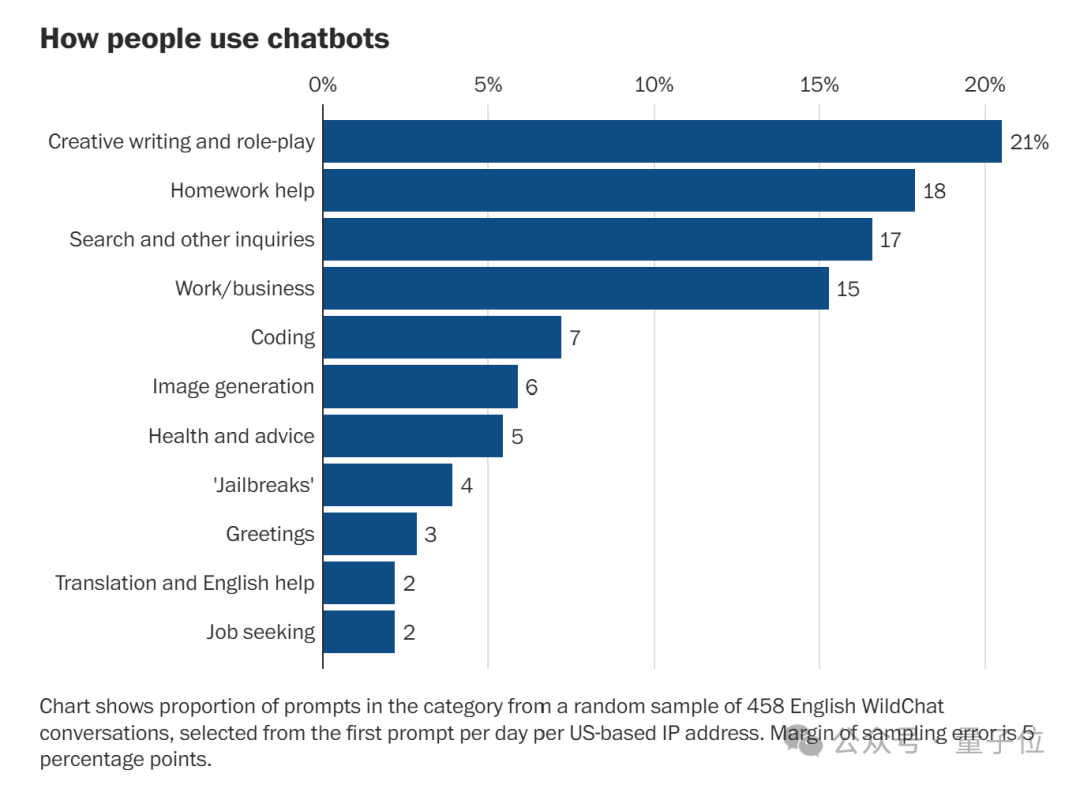

这个问题可以参考《华盛顿邮报》的一项调研,他们从数据集WildChat中查看了近200,000个英语聊天记录,这些对话由人类与两个基于ChatGPT构建的机器人生成。

可以看出,人们主要用ChatGPT来写作(21%)以及帮助完成家庭作业(18%)。

这样看来,人们反对这项检测技术好像也不难理解。

那么,你同意在使用ChatGPT这类工具时增加水印吗?

文章来源于“量子位”,作者“关注前沿科技”