就在今天,微软「小语言模型」系列正式升级,最新的Phi 3.5版本一口气连发三款模型——

- 38.2亿参数的Phi-3.5-mini-instruct

- 419亿参数的Phi-3.5-MoE-instruct

- 41.5亿参数的Phi-3.5-vision-instruct

这三个模型都可供开发人员在Hugging Face上下载、使用和微调,并获得了微软的MIT许可证,可以进行不受限制的商业应用和修改。

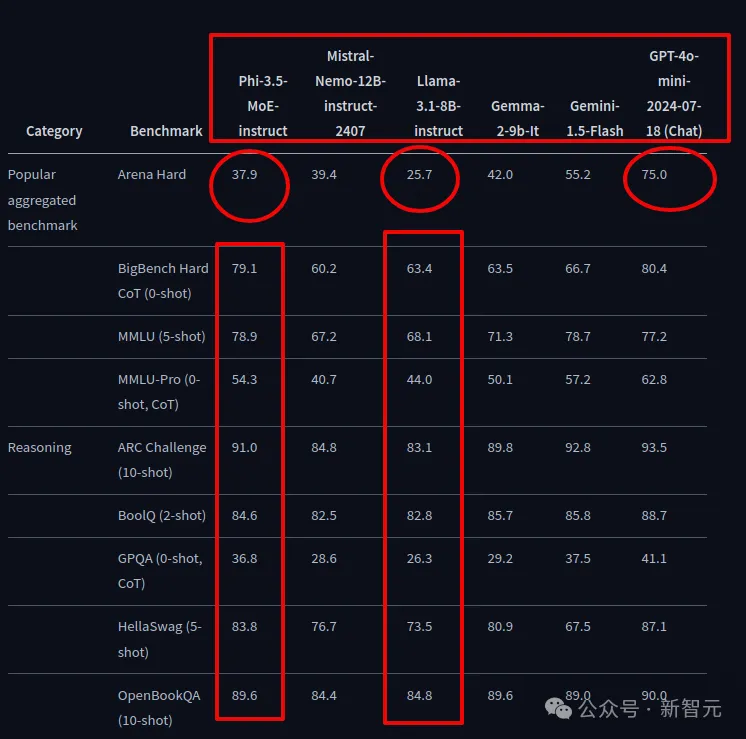

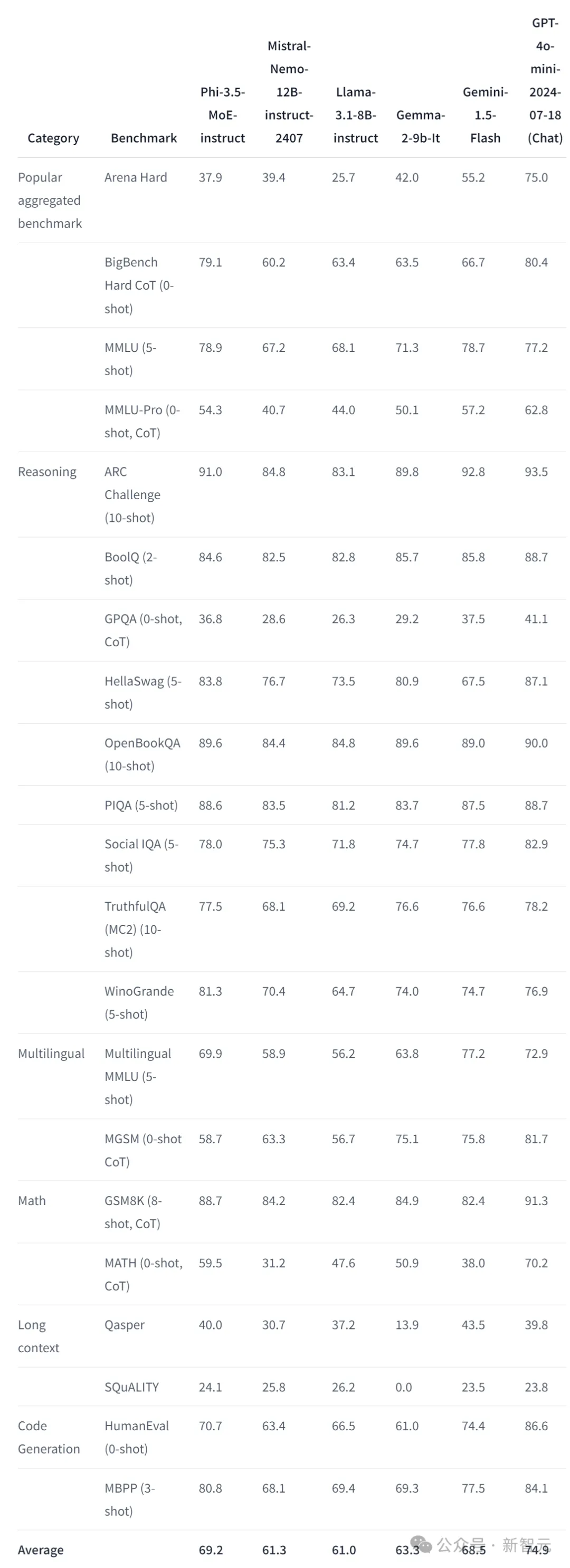

别看规模不大,但这三个模型在很多第三方基准测试中都性能表现都相当不错,甚至在某些情况下击败了其他领先大模型,包括谷歌的Gemini 1.5 Flash、Meta的Llama 3.1,甚至在一些竞技场上击败了OpenAI的GPT-4o。

优秀的性能加上宽松的开放许可证,网友在社交网络上纷纷试用并点赞Phi 3.5新系列:

接下来,根据Hugging Face上的发行说明,简要介绍一下三款新型号模型的不同特点和用途。

Phi-3.5-mini-Instruct:小而美

模型:https://huggingface.co/microsoft/Phi-3.5-mini-instruct

延续之前模型小而美的路线,Phi-3.5-mini-Instruct也是一种轻量级AI模型,基于Phi-3使用的数据集构建,拥有38亿个参数,支持128k token上下文长度。

Phi-3.5-mini使用512个H100-80G GPU,在10天内对3.4万亿个token进行了训练。

Phi-3.5-mini非常适合在内存或算力受限的设备上使用,虽然内存有限但推理能力不减,可以完成代码生成、数学问题的解决和逻辑推理等任务。

默认情况下,Phi-3.5-mini使用Flash Attention,这需要某些类型的GPU硬件才能运行。

通过在不同类型的GPU上进行测试,发现在NVIDIA V100或更早一代GPU上即可使用。

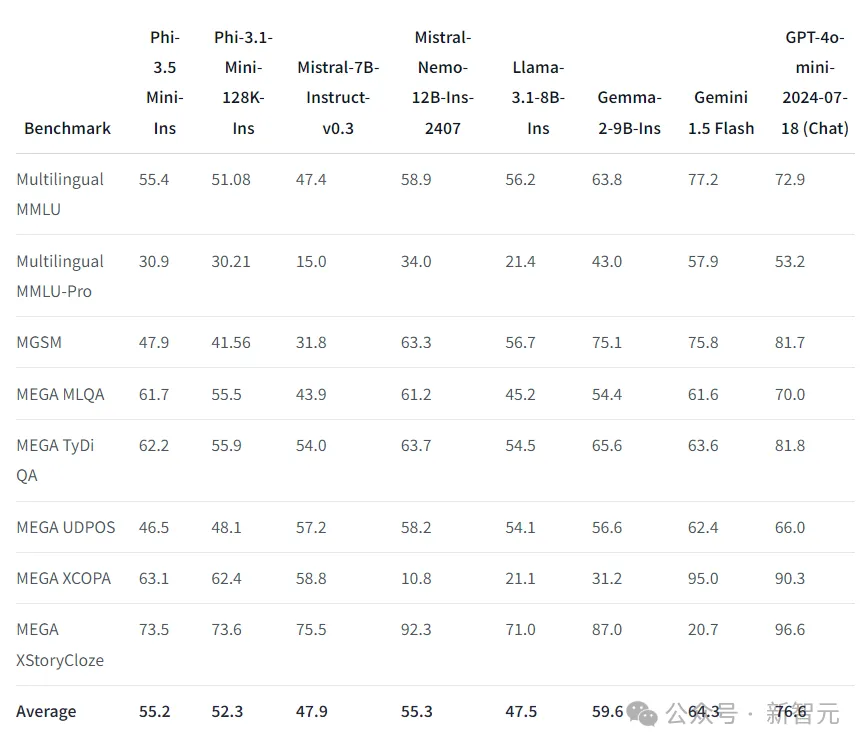

尽管尺寸紧凑,Phi-3.5-mini在多语言和多轮对话任务中表现出了优秀的性能。

Phi-3.5-mini支持阿拉伯语、中文、英语、芬兰语、法语、德语等23种语言。

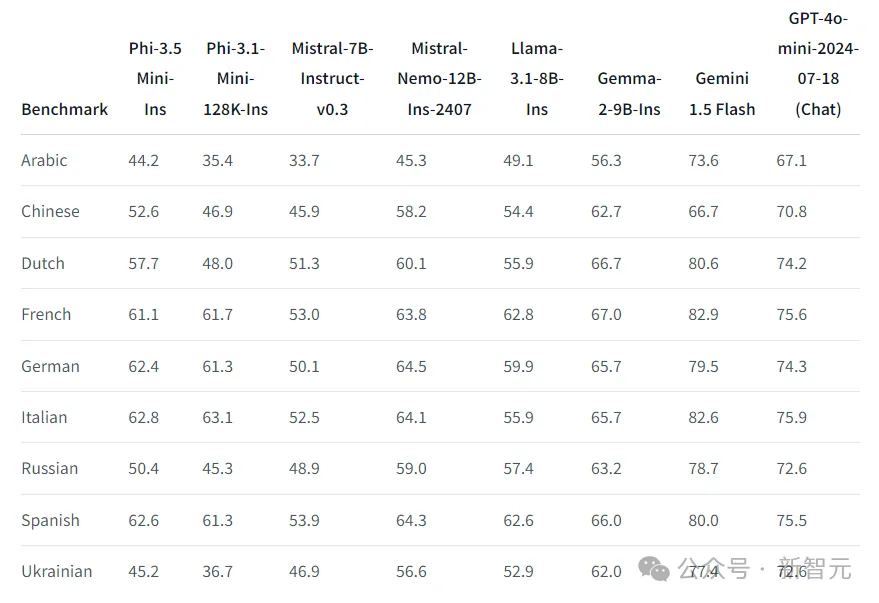

下表重点介绍了Phi-3.5-mini在多语言MMLU、MEGA和多语言MMLU-pro数据集上的多语言功能。

总体而言,即使只有3.8B参数,Phi-3.5-mini在多语言任务上与其他更大参数的模型相比,也具有竞争力。

Phi-3.5-mini支持128K上下文长度,因此该模型能够执行多种长上下文任务,包括长文档/会议摘要、长文档QA、长文档信息检索。

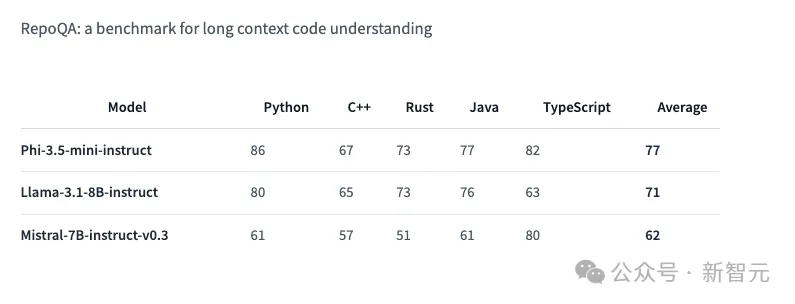

Phi-3.5-mini在衡量「长上下文代码理解」的RepoQA基准测试中超越了其他类似大小的模型,比如Llama-3.1-8B-instruct和Mistral-7B-instruct。

Phi-3.5-MoE-instruct:首款MoE

模型:https://huggingface.co/microsoft/Phi-3.5-MoE-instruct

Phi-3.5-MoE-instruct是微软Phi模型中的首个MoE模型,将多种不同类型的模型组合成一个模型,汇总的模型内部每个类型模型专门从事不同的任务。

顾名思义,Phi-3.5-MoE采用的是混合专家架构,在23天内使用512个H100-80G GPU,对4.9万亿个token进行了训练。

420亿个参数的架构,支持128k token上下文长度,Phi-3.5-MoE专注于处理高质量,推理密集数据。

然而,根据HuggingFace文档,Phi-3 MoE有16x3.8B参数,只能使用6.6B参数运行。

Phi-3.5-MoE专为在各种推理任务而设计,尤其是在代码、数学和多语言理解方面具有强大的性能。

并且,MoE模型经历了严格的优化过程,结合了监督微调、近端策略优化(proximal policy optimization)和直接偏好优化(direct preference optimization),确保精确并且安全的指令遵守。

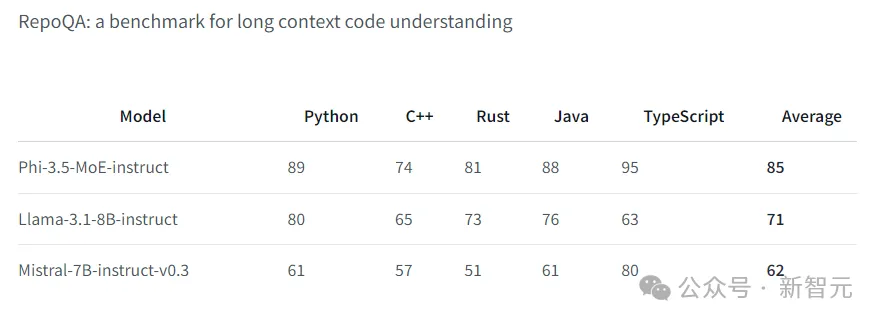

与Phi-3.5-mini一样,MoE版本也支持多种语言,并且在长上下文表现优秀,在特定基准测试中优于较大的模型,包括RepoQA:

由于Phi-3.5-MoE模型的定位是处理不同种类的专业任务,那它在专业学科领域表现如何?

Phi-3.5-MoE在5个样本MMLU(大规模多任务语言理解)上击败了GPT-4o mini,涉及STEM、人文科学、社会科学等不同专业水平的学科。

因此,MoE模型独特的组合架构使其能够跨多种语言的情况下,也能处理不同类型复杂的任务,并且保持高质高效。

Phi-3.5-vision-instruct:视觉多模态

模型:https://huggingface.co/microsoft/Phi-3.5-vision-instruct

前两个模型都用于文本推理,而Phi-3.5-vision-instruct作为多模态模型,集成了文本和图像处理功能。

Phi-3.5-vision在6天内使用256个A100-80G GPU,对5000亿个token进行了训练。

多模态模型特别适合一般的图像理解、光学字符识别、图表和表格理解以及视频摘要等任务。

与Phi-3.5系列中的其他模型一样,Phi-3.5-vision支持128k token上下文长度,能够处理复杂的多帧视觉任务。

微软强调,模型是结合合成和过滤的公开可用数据集进行训练的,重点关注高质量、推理密集的数据。

Phi-3.5-vision主要用于多帧图像理解和推理,包括详细的图像比较、多图像摘要和视频摘要,这些能力在办公场景中有广泛的应用。

经过测试,大多数图像基准测试性能都得到提升,例如,MMMU性能从40.2提升到43.0,MMBench性能从80.5提升到81.9,文档理解基准TextVQA从70.9提升到72.0。

以下是现有多图像基准的比较结果,平均而言,Phi-3.5-vision在相同尺寸上优于竞争对手模型,并且在多帧功能和视频摘要方面能更大的模型一决高下。

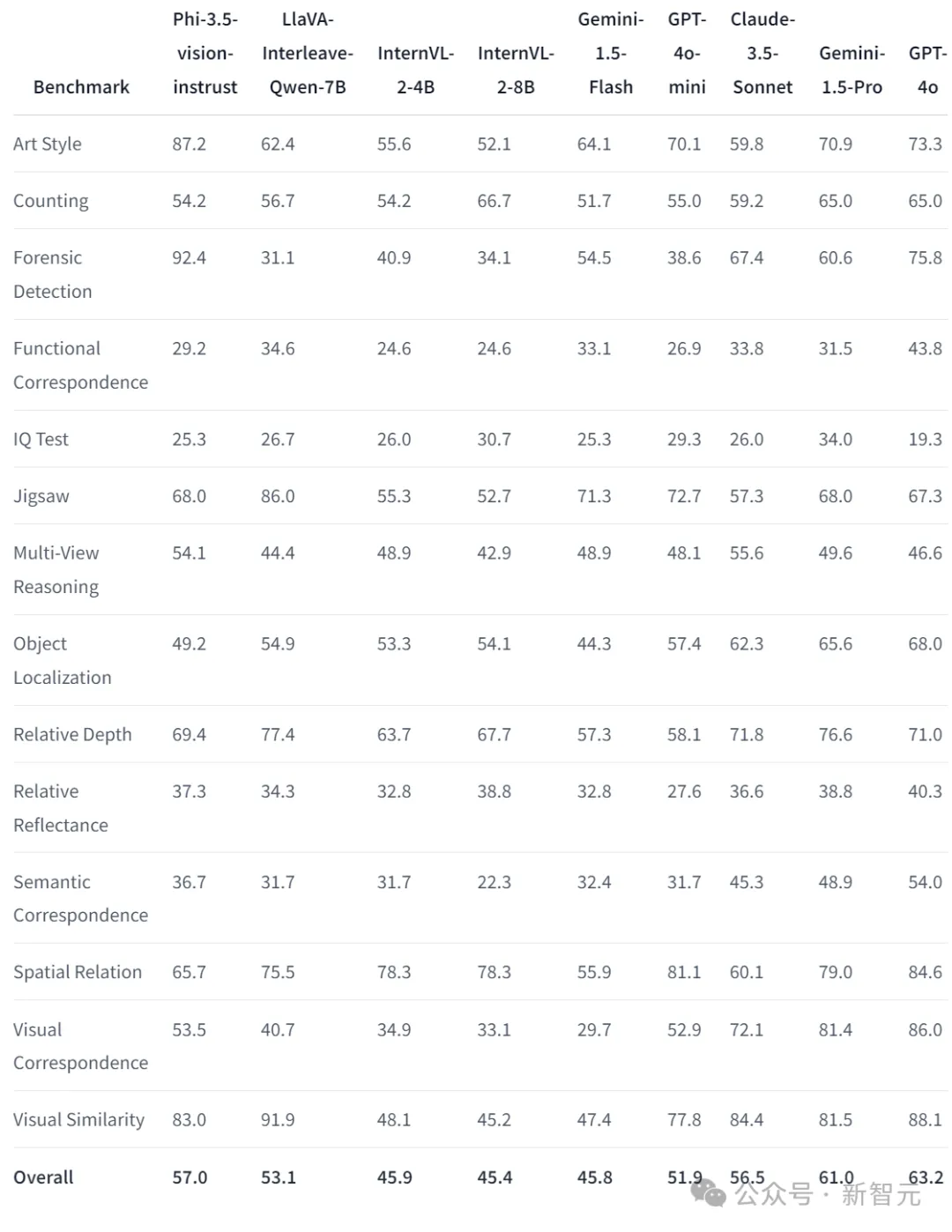

BLINK包含14项视觉任务的基准测试,人类可以很快解决这些任务,但对于LLM来说仍然很难。

不仅在每一项小分上得分更高,例如艺术风格识别和法医学鉴定都获得了87.2和92.4的高分;从总分来看,Phi-3.5-vision高于Gemini-1.5-Flash、GPT-4o-mini和Claude-3.5-Sonnet。

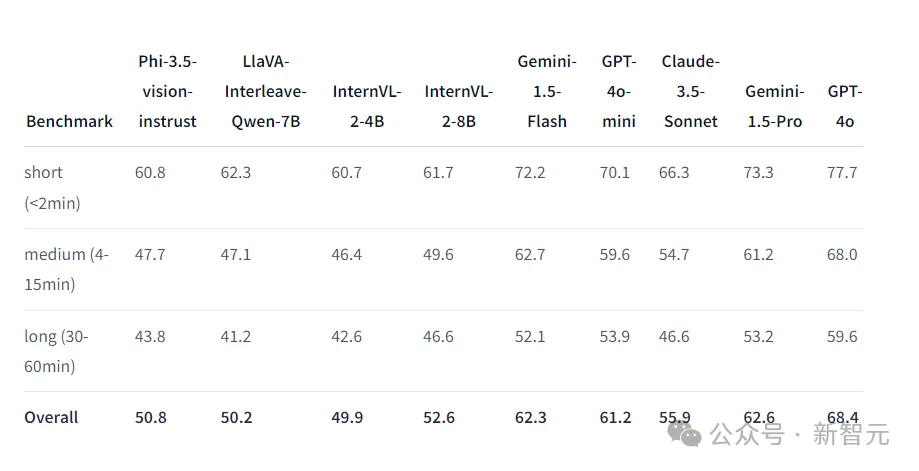

Video-MME用于全面评估LLM处理视频数据的能力,涵盖广泛的视觉领域任务,并且包括不同时长的视频处理任务。

可以看出,视频处理能力方面,Phi-3.5-vision与领先的几个模型相比,仍有比较大的进步空间,但得分也都基本超过了InternVL模型。

参考资料:

https://x.com/WeizhuChen/status/1825978852205801970

https://venturebeat.com/ai/microsoft-releases-powerful-new-phi-3-5-models-beating-google-openai-and-more/

文章来自于微信公众号”新智元“ 作者耳朵 好困

【免费】cursor-auto-free是一个能够让你无限免费使用cursor的项目。该项目通过cloudflare进行托管实现,请参考教程进行配置。

视频教程:https://www.bilibili.com/video/BV1WTKge6E7u/

项目地址:https://github.com/chengazhen/cursor-auto-free?tab=readme-ov-file

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner