临终决定是困难且令人痛苦的,AI能帮忙吗?

随着慢性病的高发和医疗技术的发展,死亡变得缓慢,临终也成为当代个人生命历程的一个重要阶段。

对很多人来说,死亡不再是突发的、没有征兆的离世,而是一个漫长的过程。

「插不插管」,怎样才是更好的选择,怎么做才能让生命有尊严地谢幕?

《MIT科技评论》近日发布了一篇文章,对「AI介入插管决策」这一话题进行了深入探讨。

伦理学家提出了一种乍一听非常疯狂的想法——利用AI打造「心理数字孪生」,帮助医生和失去语言功能的患者的家属做出决定。

AI的边界在哪里,难道连生死这种「人生大事」也要被算法接管了吗?

把决定权交给AI

几个月前,50多岁的Sophie经历了一次出血性中风。她接受了脑部手术,但心脏却停止了跳动。

Sophie的遭遇给她造成了严重的脑损伤。她反应迟钝,手指无法捏紧,被要求睁开眼睛时她也无法睁开,皮肤被捏住时她也不会退缩。

她无法主动呼吸,只能在脖子上切开一根气管后插管来呼吸,还需要一根饲管将营养直接输送到她的胃里。接下来,她的医护该何去何从?

参与Sophie治疗的贝勒医学院内科医生Holland Kaplan回忆说,在这种情况下,这个棘手的问题通常会留给Sophie的家人来解决。

贝勒医学院,被认为是全美最杰出的医学院之一

但家人无法达成一致。Sophie的女儿坚决认为,她的母亲希望停止治疗,让她安详地离开人世。另一位家庭成员则坚决反对,并坚持认为索菲是个「斗士」。

这种情况让包括Sophie的医生在内的所有相关人员都感到痛心。

美国国立卫生研究院的生物伦理学家David Wendler说,生命末期的「生死抉择」,可能会让帮助临终患者做出决定的人感到非常不安。

David Wendler

Wendler和他的同事们一直在研究一种可以让事情变得更简单的想法:一种基于人工智能的工具,可以帮助患者家属预测病人自己在任何特定情况下会想要什么。

Wendler与其他来自牛津、新加坡国立大学、耶鲁等世界名校的研究者合著的相关论文发表在了24年第7期的《美国生物伦理学杂志》上,论文题为「医疗保健中替代判断的个性化患者偏好预测器:技术上可行,伦理上可取」。

论文地址:https://www.tandfonline.com/doi/full/10.1080/15265161.2023.2296402

这个工具还没有制造出来。但Wendler计划用病人自己的医疗数据、个人信息和社交媒体帖子来训练它。

他希望该工具不仅能更准确地计算出病人的意愿,还能减轻家属在艰难决策中的压力和情感负担。

Wendler与牛津大学的生物伦理学家Brian Earp及其同事一起,希望在获得资金后立即开始构建这一工具,预计在未来几个月内成行。

Brian Earp

但要推出这一工具并非易事。

批评者们不禁要问,这样的工具如何才能合乎道德地在一个人的数据上进行训练,生死攸关的决定是否应该交由人工智能。

生存还是死亡

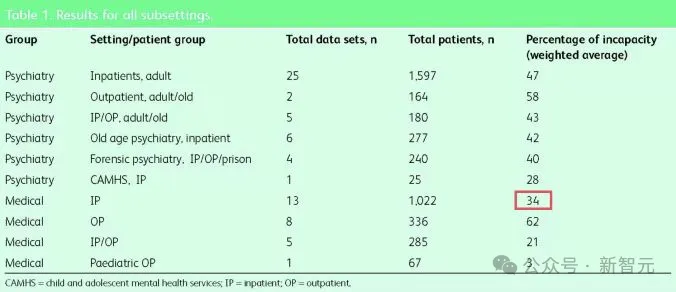

在医疗环境中,约有34%的人由于各种原因被认为无法对自己的护理做出决定。例如,他们可能失去知觉,或者无法推理或交流。

这一数字在老年人中更高,对美国60岁以上人群的研究发现,70%面临重要护理决策的人缺乏自我决策的能力。

Wendler说,「这是很多非常重要的决定,基本上决定了一个人在不久的将来是生是死。」

对衰竭的心脏进行胸外按压可能会延长人的生命,但这种治疗方法可能会导致胸骨和肋骨断裂,而且到病人醒过来的时候,可能已经出现了严重的脑损伤。

用机器维持心脏和肺部的功能可能会维持其他器官的含氧血液供应,但并不能保证康复,而且患者在此期间可能会感染多种疾病。

身患绝症的人可能希望继续尝试医院提供的药物和治疗程序,这样可以多活几周或几个月。但另一些人可能希望放弃这些干预措施,在家里过得更舒适。

在美国,只有大约三分之一的成年人提前交待好了「死亡方式」,他们填写了预先指示,一种明确规定他们可能希望得到的临终关怀的法律文件。

论文地址:https://pubmed.ncbi.nlm.nih.gov/28679811/

Wendler估计,超过90%的临终决定最终是由病人以外的其他人做出的。

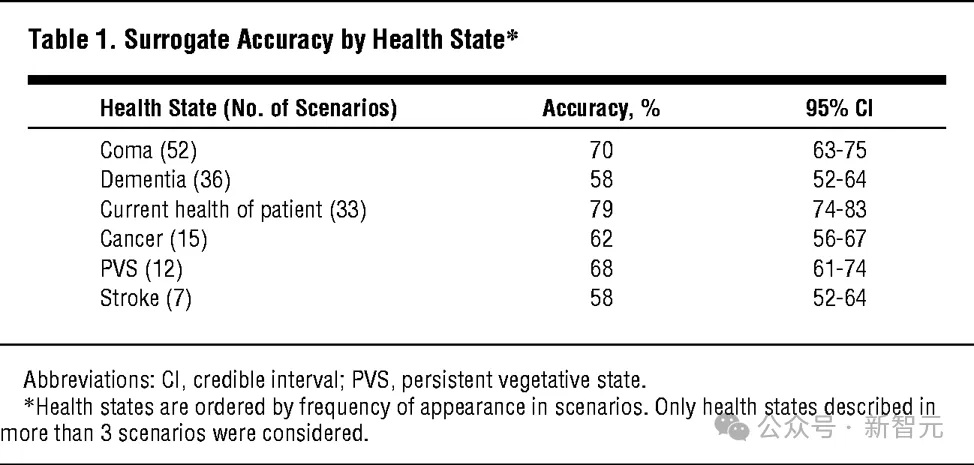

代理人的作用是根据病人希望如何治疗的信念做出决定。但人们通常并不擅长做出此类预测。研究表明,代治者准确预测病人临终决定的比例约为68%。

Wendler补充说,这些决定本身也会让人非常痛苦。

一些代做决定者会因为支持了自己的亲人而感到满足,而另一些则会在情感负担中挣扎,并在之后的几个月甚至几年里感到内疚。

论文地址:https://www.acpjournals.org/doi/10.7326/0003-4819-154-5-201103010-00008

有些人担心自己过早地结束了亲人的生命,还有人担心他们不必要地延长了亲人的痛苦。

「这对很多人来说都很糟糕,人们会说这是他们做过的最糟糕的事情之一」。

Wendler一直在研究如何帮助患者家属做出此类决定。

十多年前,他提出了开发一种工具的想法,这种工具可以根据年龄、性别和保险状况等特征预测病人的偏好。

该工具的基础是用普通人群调查结果训练出来的算法,看似粗糙,但这些特征似乎确实影响着人们对医疗服务的感受。例如,青少年比90岁的老人更有可能选择积极治疗。

研究表明,基于平均值的预测可能比家庭成员的猜测更准确。

2007年,Wendler和他的同事们根据少量数据建立了一个工具的初步版本。

Wendler说,这个简单的工具在预测人们需要什么样的护理方面「至少和近亲代理一样好」。

现在,Wendler、 Earp和他们的同事正在研究一个新的想法。

研究人员计划建立的新工具将不再基于粗略的特征,而是个性化的。

该团队建议使用人工智能和机器学习,根据病史等个人数据,以及电子邮件、个人信息、网页浏览历史、社交媒体帖子,甚至是 Facebook 的「点赞」,来预测病人的治疗偏好。

其结果将是一个人的「心理数字孪生」——一个医生和家庭成员可以参考的工具,以指导患者的医疗护理。

目前还不清楚这在实践中会是什么样子,但该团队希望在完善该工具之前对其进行构建和测试。

研究人员称他们的工具为个性化患者偏好预测器(personalized patient preference predictor),简称为P4。

Wendler说,从理论上讲,如果它能像他们希望的那样工作,那么它可能会比前一版本的工具更准确,而且比人类代理更准确。

Earp说,它可能比预先指示更能反映病人当前的想法,而预先指示可能是在十年前签署的。

AI能做出更好的选择吗

贝勒医学院的医学伦理学家Jennifer Blumenthal-Barby说,P4 这样的工具还可以帮助减轻代理者在为家人做出如此重大的生死决定时所承受的精神负担,因为这种决定有时会让人出现创伤后应激障碍的症状。

Kaplan说,有些代理人会出现「决策瘫痪」,他们可能会选择使用该工具来帮助引导他们完成决策过程。

在这种情况下,P4 可以帮助减轻代理者的一些负担,而不一定要给他们一个非黑即白的答案。

举例来说,它可能会建议某人「有可能」或「不太可能」对某项治疗产生某种感觉,或者给出一个百分比,表明答案正确或错误的可能性有多大。

Kaplan可以想象,像P4这样的工具在Sophie这样的情况下会很有帮助。因为在这种情况下,不同的家庭成员可能会对一个人的医疗护理有不同的意见。向这些家庭成员提供该工具,能够帮助他们共同做出决定。

它还可以帮助指导那些没有代理人的人做出护理决定。

Kaplan是休斯顿Ben Taub医院的一名内科医生,该医院是一家「安全网」医院,无论病人是否有医疗保险,都会接受治疗,很多病人都是无证件者、被监禁者和无家可归者。

当Kaplan见到这些病人时,他们往往已处于水深火热之中,处于疾病的晚期。他们中的许多人无法讨论自己的护理问题,有些人也没有家人可以代表他们说话。

Kaplan表示,她可以想象像P4这样的工具会在这样的情况下使用,让医生更深入地了解病人可能想要什么。

例如,在这种情况下,可能很难找到病人的社交媒体资料。但其他信息可能会被证明是有用的。

Wendler说,如果某些信息被证明是一个预测因子,他就会希望它出现在模型中。

「如果人们的头发颜色、上小学的地点或姓氏的第一个字母被证明可以『预测一个人的愿望』,那么我就想把它们加进去。」

Earp和他的同事们已经开始进行调查,以了解个人对使用 P4 的感受。

这项研究仍在进行中,但早期的反馈表明,如果没有可用的人类代理者,人们也愿意尝试这种模型。

Earp说他也有同感。他还说,如果P4和代理人给出的预测不同,「我可能会听从了解我的人的意见,而不是模型」。

它不是人类

Earp的感受出卖了许多人的直觉——这些重大决定最好由人来做出。

瑞士洛桑联邦理工学院研究员Georg Starke也表示,「问题是,我们希望如何做出临终决定,以及由谁来做出决定?」

而且,即使一个人在之前的笔记、信息和社交媒体帖子中明确表达了自己的意愿,但在身临其境之前也很难知道自己对医疗状况的感受。

Kaplan曾治疗过一位患有骨质疏松症的80岁老人,他一直坚持说,如果心脏停止跳动,他希望接受胸外按压。但当这一时刻到来时,他的骨头太薄太脆,无法承受按压。

Kaplan记得,这位老人能听得到自己的骨头「像牙签一样」断裂,胸骨从肋骨上脱落。

「然后我就想,我们在做什么?我们在帮助谁?会有人真的想要这样吗?」Kaplan说道。

还有其他令人担忧的问题。

首先,根据一个人在社交媒体上发布的信息训练出来的人工智能最终可能并不完全是一个「心理数字孪生」 。

「任何一个在社交媒体上发表过文章的人都知道,我们在社交媒体上发布的内容往往并不能代表我们的真实想法、价值观或需求。」

而且,人工智能并不稳定,即使是微妙地改变给人工智能模型的提示,也会让你得到完全不同的回答。想到我们要把如此重要的决定交给如此随机的AI,「这太可怕了」。

另一方面,人类也是容易犯错的。贝勒医学院的生物伦理学家Vasiliki Rahimzadeh认为,P4 是个好主意,前提是必须经过严格测试。

她说,「我们对这些技术的要求不应该高于我们对自己的要求。」

Earp和Wendler也承认他们面临着挑战。

他们希望自己建立的工具可以捕捉到有用的信息,既能反映一个人的意愿,又不侵犯隐私;他们希望该工具能成为患者和代理人可以选择使用的有用指南,而不是就患者的护理问题给出非黑即白的最终答案的默认方式。

可即使他们在这些方面取得了成功,他们也可能无法控制这种工具的最终使用方式。

以Sophie的案例为例。如果使用 P4,其预测结果可能只会进一步破坏本已面临压力的家庭关系。

Wendler坦言,「我最担心的是谁来控制它。他担心医院可能会滥用P4等工具」,他说,「这中间有各种各样的经济因素。」

文章来源于“新智元”,作者“新智元”