最近读AI论文有个很强的感受:表面上说的是A,其实应用落地完全可以是B。

乍一看,论文的研究对象离商业化异常遥远,但其实,已经为具体的产品提供了非常可观的未来蓝图。

比如最近,看到一篇斯坦福等高校发布的AI和心理学、语言学交叉的研究论文,直译过来叫《利用大型语言模型生成多层次反馈,为新手同伴咨询师提供支持》。

论文核心在讲LLM对于心理咨询的辅助,但是非常非常建议所有做「AI虚拟陪伴」的产品经理,甚至是所有做「AI对话」相关的从业者,都来仔细读一读。

“生成多层次反馈”、“优化专业问答效果”、“克服幻觉问题”……

一系列涉及到的常见问题,本篇作者的分析方式、思考角度,都让我非常受启发!

数据采集和分析的方法,更有种旁逸斜出的创新感,极有想象力。

每每看到优秀的论文、产品,其背后的巧思、天才的创造,总是让人拍案叫绝,甚至时常会带来一种心流般的沉浸式享受。

https://ar5iv.labs.arxiv.org/html/2403.15482 话不多说了,原论文链接我直接放在这里。以下是基于论文和相关背景的介绍和分析

在美国,精神疾病和心理问题的流行,影响着近五分之一的成年人,而正规的心理咨询师的供给却是远远不够。

同伴支持,即志愿者通过富有同情心的倾听,以此提供即时帮助,已成为专业治疗的一个有效的补充。

虽然这种非正式方法可以提供即时且易于获得的支持,但它也为支持者做好角色准备带来了独特的挑战。

与心理治疗或医学等专业中的结构化培训计划不同,同伴咨询师通常从一开始就没有太多准备。

为了充分利用同伴支持的潜力,为志愿者配备强大的资源,匹配AI技术以提高效率至关重要。

在 2024 年“计算语言学协会会议”上的一篇新的论文中,来自斯坦福大学、卡内基梅隆大学和佐治亚理工学院的研究人员,提出了一种基于人工智能的新的「心理模型」——

该模型为新手同伴咨询师提供反馈,以提高他们帮助有需要的人的能力。

该项目植根于斯坦福大学计算机科学家杨迪一,和斯坦福大学心理学家布鲁斯·阿诺之间的独特合作关系。他们都是这篇论文的作者,该论文得到了斯坦福「以人为本」的人工智能研究所的支持。

“跨学科合作对于开展这个项目至关重要,”Arnow 表示。“人工智能在帮助提高心理治疗培训的质量和效率方面具有巨大潜力,但心理健康界还没有足够的能力开发人工智能辅助培训模式,而计算机科学界也没有咨询干预技能的基础。”

组建一个由两个交叉学科组成的团队,使我们能够在这个令人兴奋的新研究领域取得更多进展。

该项目的第一步是规划出哪些反馈是有用的以及如何将其提供给新的同伴咨询师。研究人员与斯坦福大学的三位心理治疗师合作,制定了一份切实可行的良好反馈蓝图。

“目标是思考新手同伴咨询师经常犯什么样的错误,以及什么样的建议可以帮助他们学习,”斯坦福大学计算机科学博士生、论文合著者 Alicja Chaszczewicz 说。

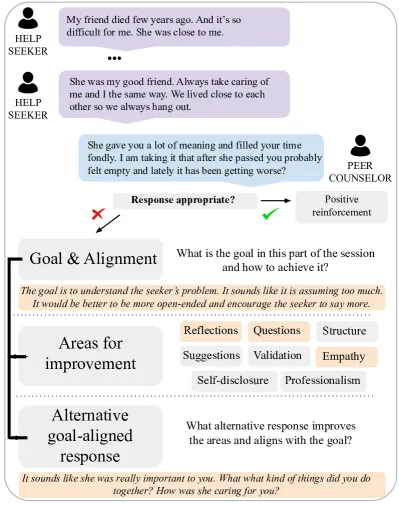

通过与咨询主管合作,研究团队开发了一个框架,为任何特定的交流提供三条信息:明确定义咨询师应该从对话中了解什么;改进咨询师回应的建议(更多同理心、更专业、更好的问题等)。

以及最符合所表达的担忧和对话目标的具体建议回应。如果咨询师给出良好的回应,该模型还可以给予积极的强化。

考虑到这一反馈框架,研究人员随后收集了 400 次不同的情感支持对话中给出的反馈数据集。数据集中的每句话都收到了共同注释的反馈:GPT-4 撰写了初稿,两位领域专家决定最终编辑。

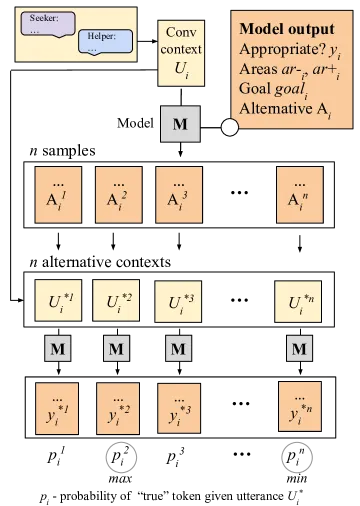

该数据集提供了高质量的基本事实,可以在此基础上微调模型,以自动生成与咨询主管将为其受训者提供的反馈相符的反馈。

“主要目标是确保我们尽量减少模型中的不良反馈,”斯坦福大学博士后研究员、论文合著者 Ryan Louie 表示。

为了确保这一点,他们创建了一个创新的自检流程,其中模型将其提出的反馈输入到自己的框架中,以确认建议是否符合对话目标。

“它基本上是在反复检查自己,以降低给出糟糕建议的可能性。”据审查其输出结果的人类专家称,最终的模型对于指导那些没有接受过太多正规培训的同伴咨询师来说是一个有价值的工具。

当团队探索这种反馈模型如何为受训助手赋能时,他们的目标是针对直接、个性化监督可能有限的环境。

一个有希望的初始应用可能是在教育环境中,在这种环境中,教师在每次咨询对话中提供详细监督方面面临挑战。

反馈模型可以显著增强这种体验,通过提醒对话特定部分的目标以及辅导员的回答如何更好地与目标保持一致。

这种详细的反馈可以提供额外的视角,补充同学和教师之间的定期讨论。

然而,理想情况下,反馈模型将在没有太多直接支持的环境中发挥作用。研究人员提到的一种可能性是,在训练环境中,新手同伴咨询师可以与 AI 患者进行练习对话,然后模型会审查这些对话。

用 Louie 的话来说,这将是一个“安全沙箱”,新手咨询师可以自己练习,并获得有关其咨询技能的反馈,同时避免隐私问题——

“你可能不想或无法分析真实患者的数据,”Louie 说。它还允许咨询师进行实验、犯错,并最终在负责帮助真正需要帮助的人之前做好更充分的准备。

但更广泛的目标是让这个工具能够大规模使用并为受训人员提供另一种学习资源。“我们绝不会试图取代临床监督流程,因为临床监督流程非常复杂,”Chaszczewicz 说道。

最后我拿自己的话稍总结一下。

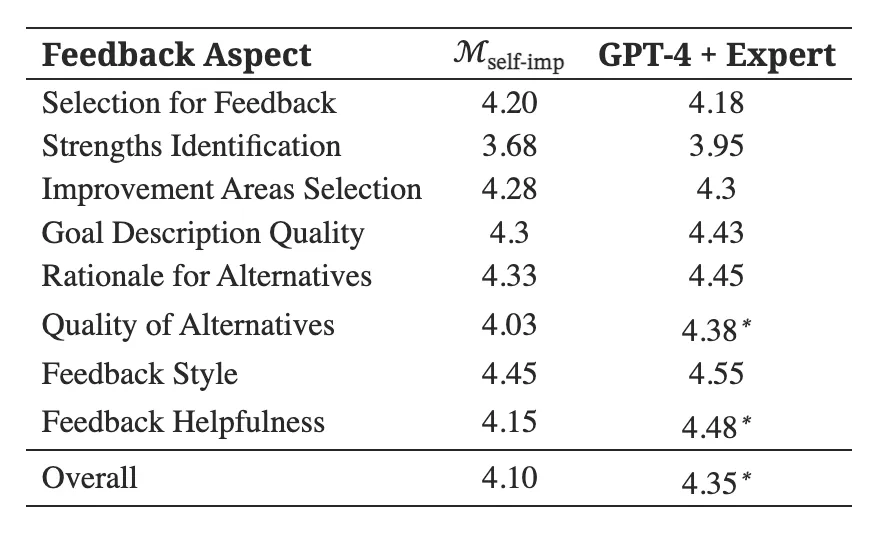

斯坦福等高校的研究人员,与资深心理治疗专家,共同设计了一套用于培训咨询技能的多层次反馈框架。他们构建了带有反馈注释的咨询对话公开数据集,并提出了一种简单但有效的反馈生成自我改进方法。

并且根据论文对比数据,这套模型的效果显著优于GPT4和其他模型的组合,并且输出的结果得到了心理学教授的认可。

在幻觉、错误等问题上的控制也达到了极高水平。

有兴趣的朋友,强烈建议阅读一下论文原文!

表面上是一篇AI在心理咨询的应用,其实对于所有的虚拟陪伴、AI对话都很有借鉴意义!

文章来自于“AI异类弗兰克”,作者“Frank Gao”。