端云结合是长期状态

腾讯研究院大模型研究小分队x“普通人的AI自由”公众号联合研究

北京时间9月10日凌晨,苹果正式发布了iPhone 16,这是苹果第一款真正意义上的 AI iPhone。Apple Intelligence采用“端侧大模型+云端大模型”的方式,将为用户带来更丰富的智能体验。而这仅仅是端侧智能的开始,未来我们可以想象,一个由大模型带来的移动智能生态正在缓缓打开。

太长不看版:

1.技术:端侧模型短期能力有限,端云结合是长期状态

●手机大模型的瓶颈排序:

○电池容量和发热

○芯片计算速度

○现有架构下,8G+内存是最低要求

○内存读写速度可能需要进一步技术突破

●~1B量级模型能力有限,性能提升空间不乐观

●手机端侧模型有实际价值 -> ~10B模型塞到手机里 -> 估计3~4年

●云+端混合将是长期主流

○端侧模型 + 云上模型 的配合能力将是核心技术点之一

○从用户价值看,端侧模型并不是必要路径

○端侧模型存在合理性是1) 降低推理成本,2) 响应速度更快3)更好保护隐私

2.产品:短期以小功能为先导,长期价值期待释放

●当前AI 手机以功能探索为主,用户价值有待更多释放;对于硬件,会有明确的产品价格提升,因此行业会坚定推进

○短期 = 新功能亮点提升产品售价+FOMO(Fear of Missing Out)

○长期 = 争夺新的流量入口

●LLM是端侧模型重点;多模态生成在端侧的用户价值有限,更大的价值在于多模态理解

●硬件粘性和价值 > 模型品牌吸引力

●未来具备用户价值潜力的新领域:AI原生OS

○理解用户 + 智能唤醒APP(siri升级)

○直接access APP内的数据和服务,可能绕过APP的UI,直接完成用户指令

○拆解指令,多APP共同完成任务(严重依赖AI Agent的能力提升)

○(optional)对于常用服务手捏个人APP

引子:

<问题1>从用户角度出发,“智慧手机”的“价值”是什么?

●从“智障”到“智能”

○从“物品”到“帮手”的转变

●是否会有全新的交互方式?什么是最“自然”的交互方式?

○翻阅式->搜索式->推荐式->服务式(秘书+陪伴)

<问题2>对于用户来讲,为什么要在端侧搭载模型?

●网络延迟+极端环境:端侧模型有优势,但场景很小,因为大多数生活场景对于大几百毫秒延迟可以接受

●数据隐私:端侧模型多了一层对于个人数据的保护

●个性化:在本地和云上都可以实现,但本地会更有数据优势

●从技术角度来看,端侧可能做到什么?

○~1B级别=“锦上添花”:P图,聊天,搜索支持……

○~10B级别 = 效果会更好,也有不确定性;要看哪些是这个级别也可以实现的新能力

○~100B级别 + AI Agent = AI原生体验的潜力

<问题3>从厂商角度出发,手机端侧模型的“价值”是什么?

●带来更多新功能、新体验,提升手机价值

●控制云上推理成本

●端云混合模式中,云上模型服务可以另收费

●获取新流量入口

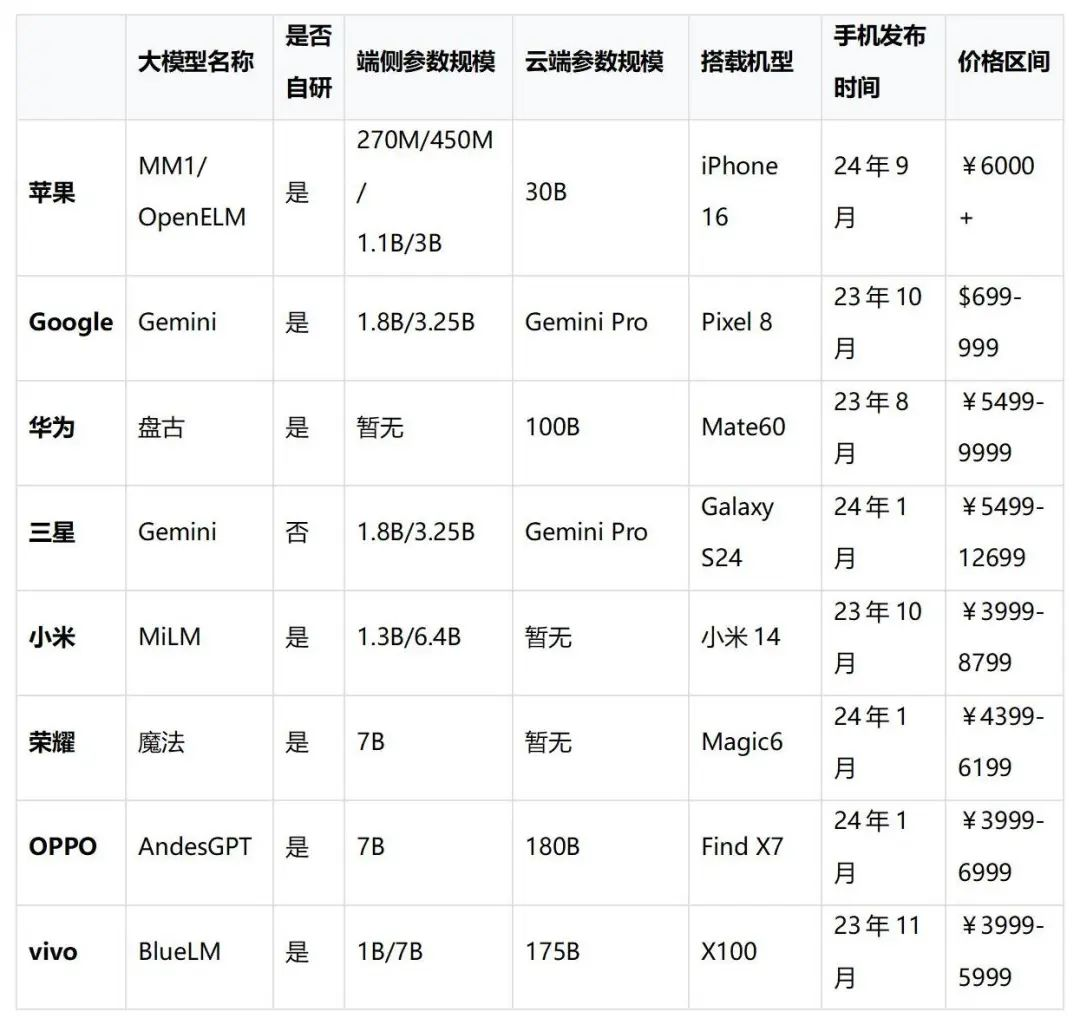

去年以来,各厂商已经推出了多款端侧大模型手机。

●参数量级:以1~3B为主,如Google Gemini 3.25B等

●是否自研:Google、苹果、华为等厂商推出了全自研模型

●价格区间:国内售价4000元+,即主流旗舰机价格

●总市场份额:2023年该细分市场出货量约2700万台,占国内安卓手机出货量约12%(苹果手机23年暂未部署端侧大模型)

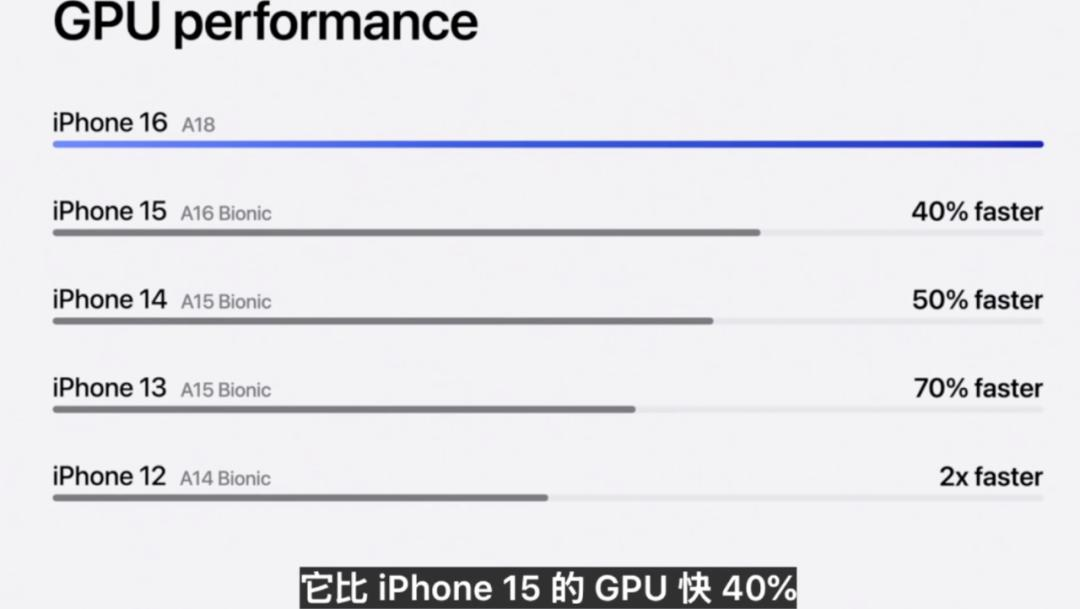

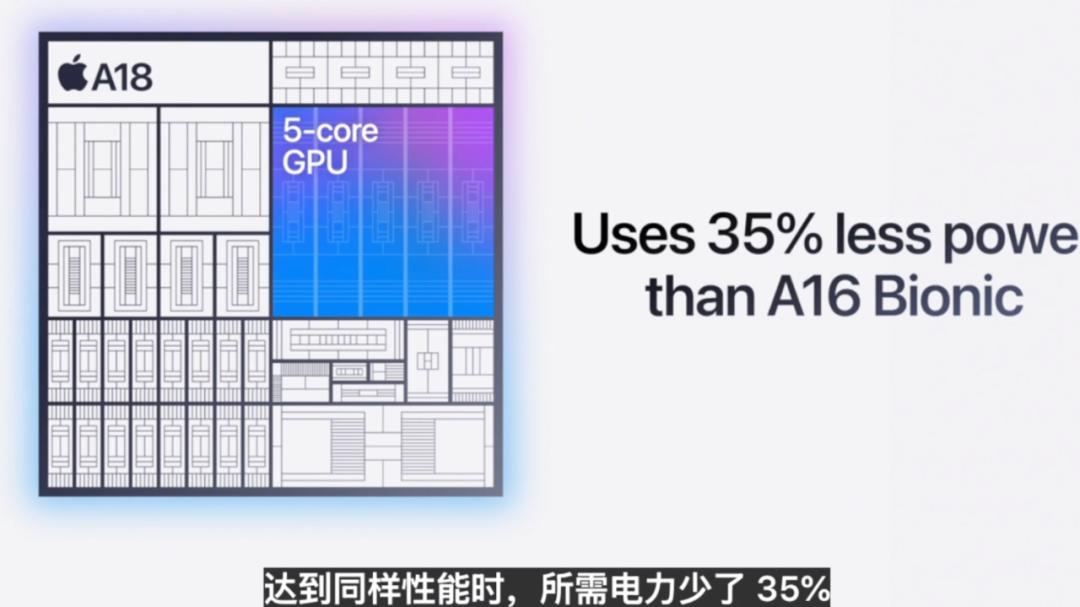

苹果的新款iphone16搭载了更快的CPU、GPU,且在能耗上有更好的表现。以GPU为例,A18芯片是四前iphone 12的A14芯片速度的2倍。

相比去年A16芯片,在速度提升40%的同时,功耗下降了30%,为大模型的本地运算提供了更好的电源保障。

利用端侧大模型,iphone16 不仅可以生成、润色文字、总结文本、回复邮件等,还可以生成表情符号,搜索照片、视频等,并执行多种任务。

发布会中最为惊艳的功能之一,是视觉智能。比如,当你看到一家餐厅,你可以通过按压相机控制按钮拍下餐厅,然后就能通过 Apple Intelligence获得该餐厅的营业时间以及点评,并查看菜单或预订餐厅。

该功能也支持和第三方 APP 联动,比如,看到你喜欢的自行车,只需点击一下,即可快速Google到类似的自行车并购买。

除了苹果,去年以来,各大手机厂商已经陆续发布了其端侧大模型的产品:

1.参数规模:“智商”水平至关重要,端侧模型任重道远

为什么“智商”重要?“锦上添花” vs “底层革命”

大参数+量化 vs 小参数:大参数+量化效果上优于小参数

当前量化已到极限:BF16量化基本安全;INT4量化是当前大多手机使用的方式,但经常出现过拟合和稳定性问题;当前在探索INT8量化的折衷方案

●FP32精度下,1B模型占用~4GB内存,而推理运行需要更多内存,这对目前8~16GB的手机主流内存是有挑战的

●Int4量化后,效果衰减~10%,占用内存减少~80%,同时推理速度提升~50%;但量化测试数据有overfitting的嫌疑

●目前高通、联发科已经支持INT4,Google已经支持INT8,实践中为保证效果还要使用混合精度,进一步提升空间有限

~10B模型是当前模型能力分水岭

●Phi3-3.8B等模型打榜结果还可以,但实测过拟合情况较为严重

●~1B量级模型在理解能力、稳定性上都和7-13B的模型有明显差距

●但并不能保证~10B模型在未来足以进化出接近人的智慧水平

提升参数规模的瓶颈包括计算、内存读写和能耗,其中能耗最难突破

●芯片计算速度:手机算力30~50TOPS,PC是手机的20~40倍

●内存读写速度:手机带宽40~80GB/S,PC是手机的10~20倍

●内存容量:手机内存已到16GB甚至更高,与PC可以相比;未来还有扩展的空间

●能耗:发热&续航:对标游戏运行,续航仅有3~4小时,且手机明显发热

2.推理速度:良好用户体验的基准是20token/s,目前刚刚达标

现状推理速度:最高达20token/s,刚刚达到可用门槛,仅有PC端的20%,差距明显

●miniCPM-2B Int4量化在部分主流机型上测试的推理吞吐速度,除iPhone外均在7token/s以下

●当前在英伟达RTX4090运行Llama 7B 4bit的推理吞吐速度为100tokens/s以上

●最新一代的高通或联发科芯片在芯片厂商的测试中Llama 7B INT4量化的推理速度能达到20token/s

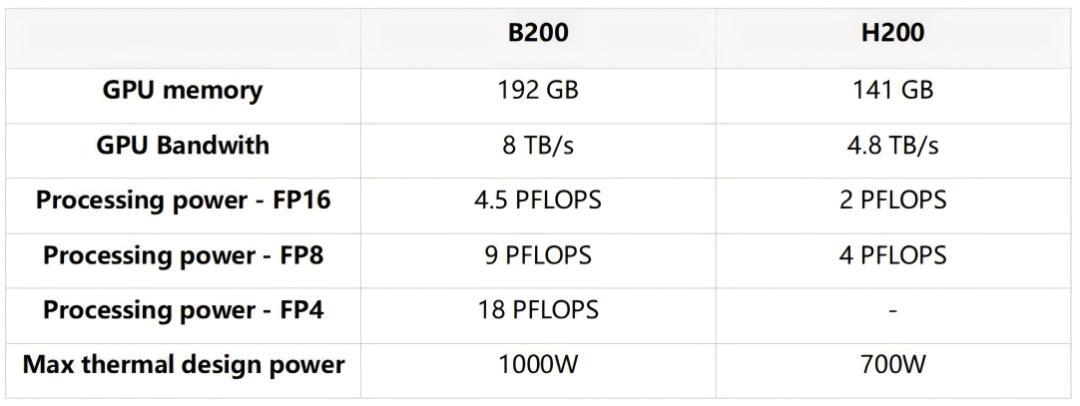

●目前没有明确的SOC AI推理加速定量证据,我们采用NVIDIA数据中心B200(vs H200)作为参照,认为每代更新可以有50%+的功耗效率提升和10%+的推理速度提升

●推理运算加速:Google TPU的MXU(Matrix multiplication unit)Nvidia的Tensor Cores针对神经网络中大量的张量计算的加速;联发科针对transformer架构的Softmax+LayerNorm算子的加速;高通骁龙Gen3的微型区块推理单元,将大模型分解为可以独立执行的部分。

●内存读写速度优化:Google TPU使用大规模片上内存,减少数据在HBM(High Bandwidth Memory)和VEM(Vector Engine Memory)之间传输的次数;苹果探索通过窗口化(Windowing)和行列打包(Row-Column Bundling),在闪存中存储模型参数,并在推理过程中按需将这些参数加载到DRAM中。

●其他技术进展:联发科NeuroPilot Fusion基于低秩自适应(LoRA)融合技术,基于一个基础大模型,通过云端训练,在端侧完成多个功能的融合,从而赋予基础大模型更全面、更丰富的生成式AI应用能力。

AI agent的推理速度要求:50~100 tokens/s

●目前国内商用LLM API输入处理速度可达数千tokens/s,生成速度平均在30-50 tokens/s,最快可以达到70 tokens/s(如abab-6.5s和智谱GLM3.5-turbo)。

●用户体验角度,假设一次Agent操作要调用5次大模型,则需要速度达到100 tokens/s。

3.能耗:发热&续航表现短期不会大幅优化,是手机端侧大模型的主要瓶颈

现状:目前没有大规模测试端侧模型推理的功耗;以游戏运行为benchmark,功率大约在4~7W,续航时间仅为3~4小时

崩坏:星穹铁道最高画质各机型实测结果(by 小白测评数据库,续航时间基于标准输出电压3.7V估算)

电池容量增长分析预测:未来每年增长不超过5~10%

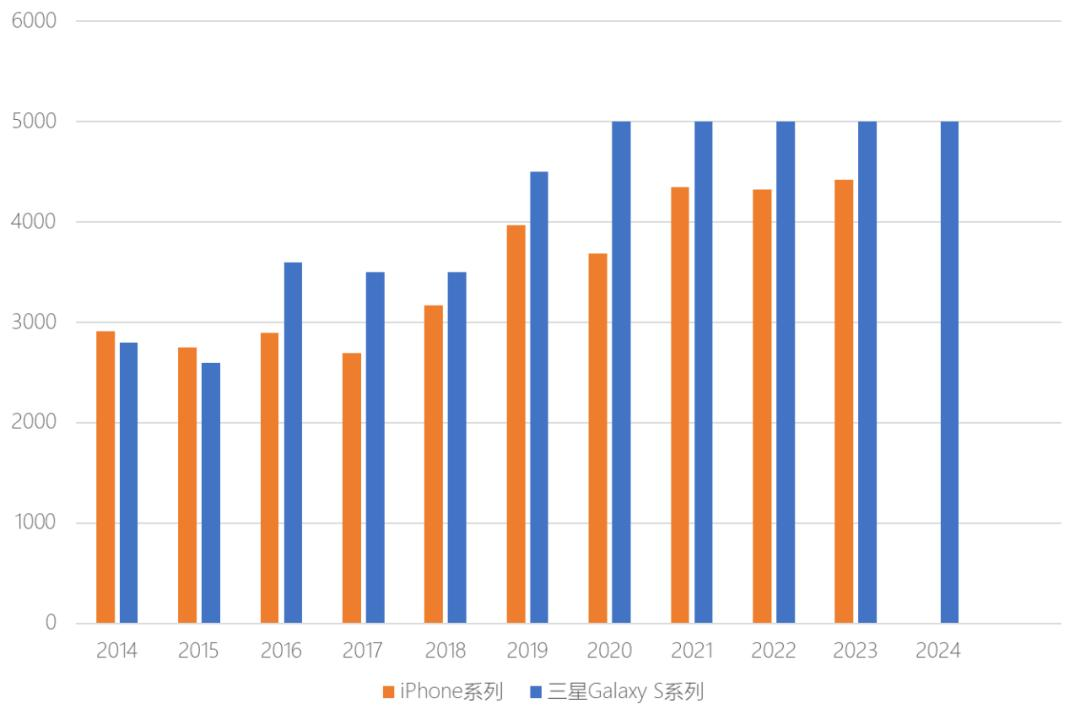

以iPhone和三星galaxy为例,近10年平均每年增长5~6%,尤其是21年以来,手机尺寸不再增大后电池容量也几乎没有增长

注:电池容量单位mAh,每年取该系列电池容量最高的机型数据

制约手机电池电量增长的因素包括:

●电池体积:提升电池体积会影响产品重量和厚度

●电池材料进化:固态电池材料和半固态材料,目前仍在科学研究阶段,暂未看到大规模商用

●同样电池材料下实现能量密度提升:持续有小幅改善,但不明显

4.搭载~10B模型的时间预计 = 3~4年

●推理速度提升:每1~2年(每代)10%

●单位功耗提升:每1~2年(每代)50%

●电池容量提升:每年5~10%

3-4年后:

●推理速度x2是最低要求,可能需要x3-5倍速度才能支持简单Agent

●7B模型能力不一定可以支持Agent,有可能需要13B-30B规模

●算力做到x16(700TOPS)有很大不确定性;x8甚至x4是大概率事件;在这种情况结合推理加速x1.5,极限可以支持模型吞吐速度要求

●因此7-10B模型大概是可支持的极限,大量超越10B会比较困难

●在这些极限假设下,续航时间可以满足8-10h要求,并缓解发热问题

3年内看不到纯端侧模型驱动的AI原生OS,复杂任务都需要云上实现

5.端侧多模态大模型:端侧的价值主要在多模态理解,而不在多模态生成

●多模态生成不在端侧

价值有限:端侧多模态能完成的生成场景(例如修图),已有CV技术也能解决;新的生成功能(例如AI扩图)需要上云

吃算力:多模态模型的推理,占用的算力可能会数倍于大语言模型

●目前技术路线:端侧多模态 = LLM + 多模态理解

基于LLM-backbone,在输入端增加多模态编码器和输入投影,参数量增加~10%

以开源模型MobileVLM为例;1.4B和2.7B两个版本,输入投影~20M,图像编码器~300M

其中,1.4B版本INT4量化,在骁龙888(20年,RAM8GB,26TOPS)上速度21.54 tokens/s

●因此,端侧算力瓶颈,在LLM而不在多模态

●当前多模态理解的主要应用是录屏理解;不过这是个过渡方案,远期会被更直接的数据获取方式取代

录屏理解的目标是辅助用户进行手机操作,广义上属于操作系统的一部分

手机厂商通过合作等方式获取root授权,然后在APP内操作,这是更加AI原生的OS实现方式

具体节奏除了取决于技术进展,还取决于手机厂商和APP厂商的合作探索

长期端侧多模态模型的任务则退化为读取、 理解APP内部的图片、视频等信息(非截图),不一定需要重大技术突破

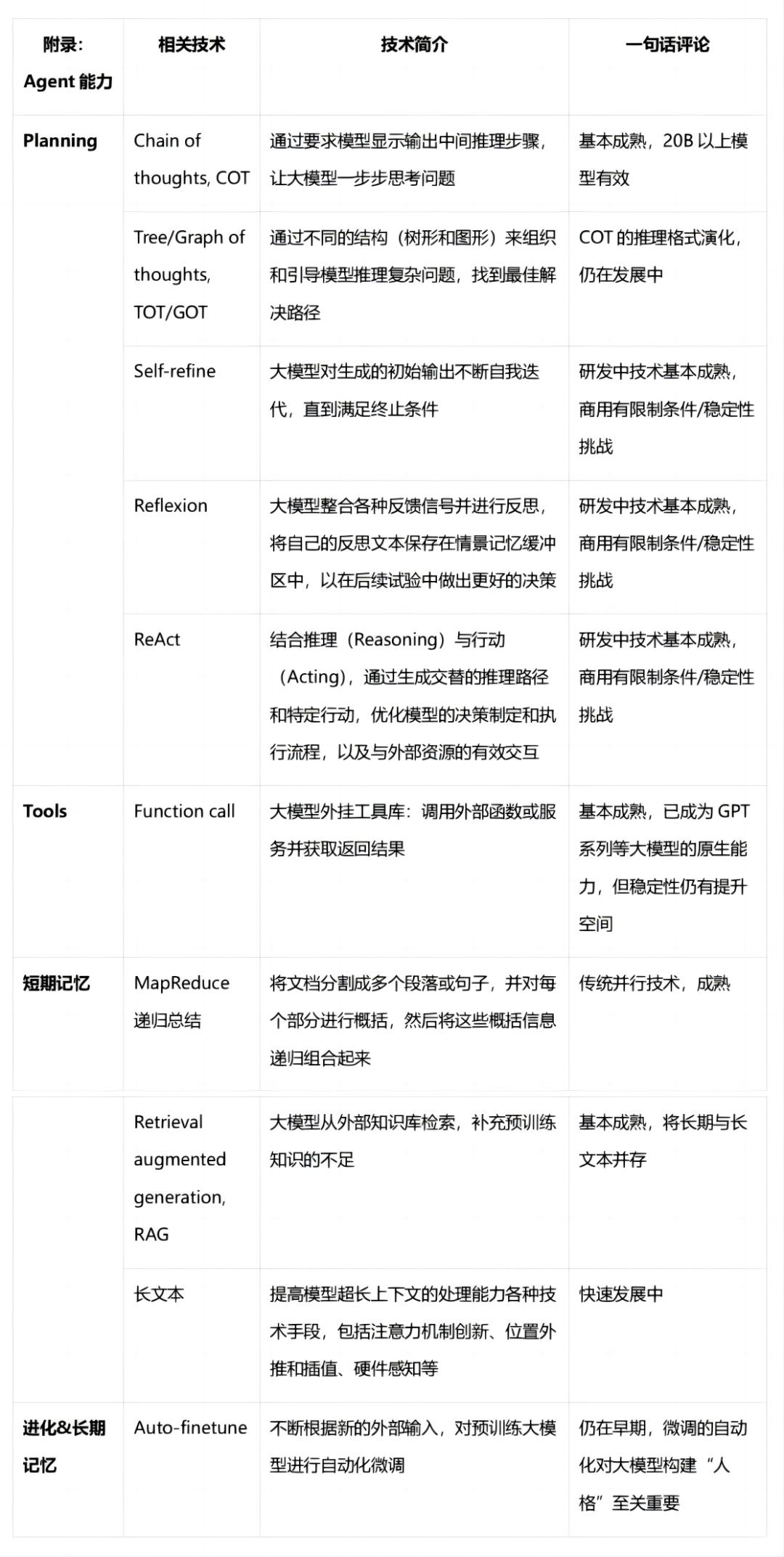

AI Agent:正长期持续快速发展;但到达大学生智能的Agent还有距离

1.Agent = 通用-自动化-决策&执行 能力

●是对大模型能力的扩充,是在模型达到AGI之前的中间阶段

●不是一项单独的技术,而是多种技术的组合创新

●误解:“既然是Agent了,就应该什么都能做”

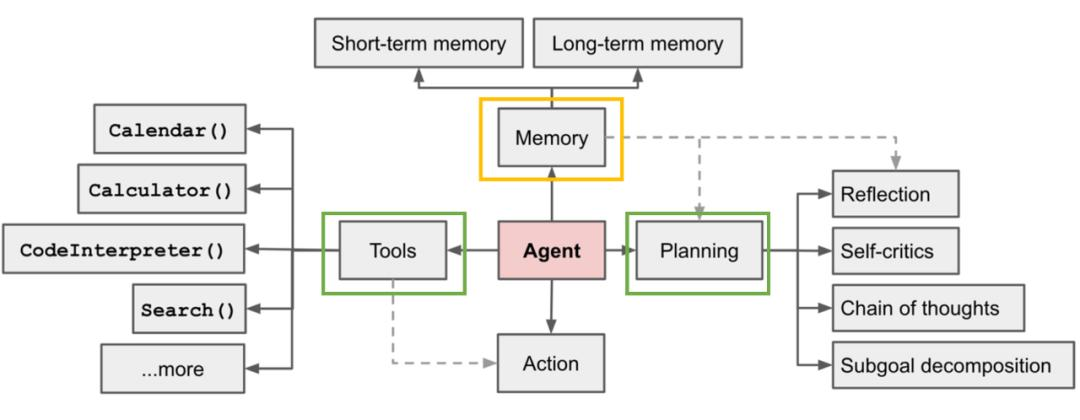

2.Agent需要包含哪些部分

Lilian Weng (OpenAI) 对Agent能力的拆解

https://lilianweng.github.io/posts/2023-06-23-agent/

●记忆问题是思考能力的源头,也是当前研发难点

●计划:决定“做什么”

●工具调用:找到“怎么做”

●执行

3.有关“记忆”

●感觉(视觉、听觉、触觉、其他sensor……)

●短期记忆(工作记忆)

●长期记忆

事实性记忆(概念、事实)

程序性记忆(事情的先后顺序)

非描述性记忆(骑自行车、潜意识)

当前处理“记忆”的主流方案https://arxiv.org/abs/2312.10997

但现状做法有很多“不自然”的地方:

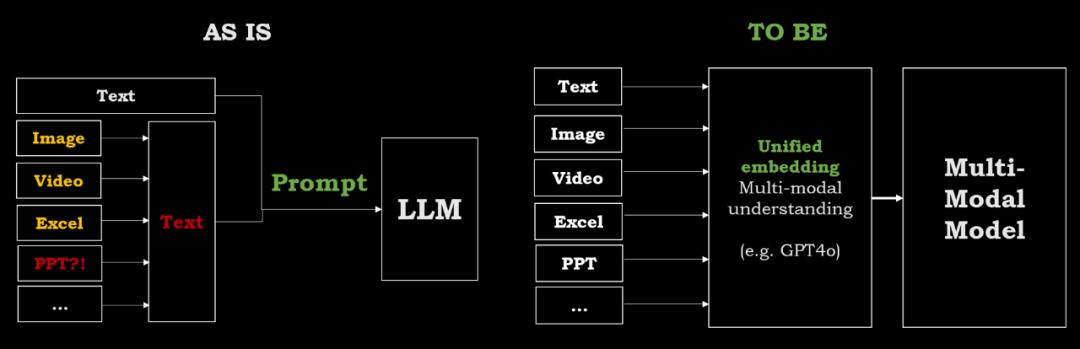

●转Text导致的信息丢失 -> Unified Embedding (e.g. GPT4o)

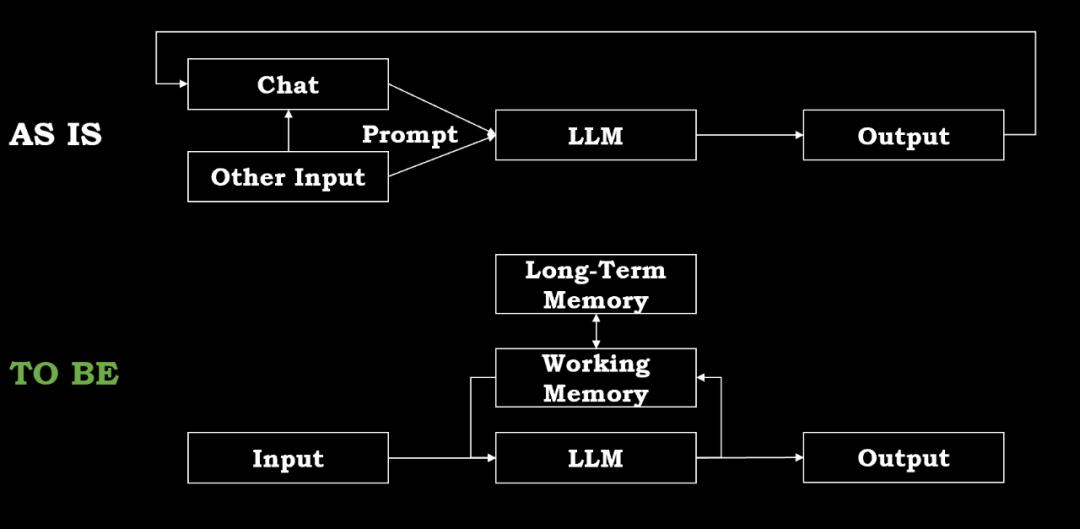

●信息以prompt方式为主进入模型 -> 长期记忆+短期记忆的交互机制

4.Agent的发展阶段

1.Agent 1.0(现状)

●工具调用:趋于成熟,且可通过微调7B模型+retrieval,在端侧实现

前置工具描述数据集 + Retrieval做update

但受制于前置工具集的文档精确性、及时性;当前的成功的比例仍难以直接满足商用

大模型self-instruct指令生成工具调用数据集,对agent进行微调

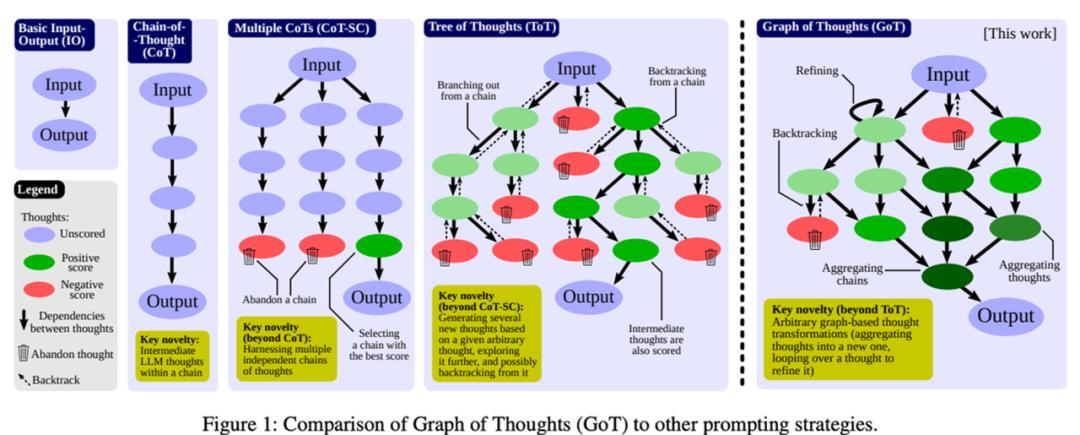

●Planning:基本的给定范围内的拆解能力,成功率&稳定性需要提高

通过System prompt预先设定agent的角色、工作流程、能力栈等

基本的任务拆解(CoT)

通过Self-refine/Reflexion/ReAct增加可靠性

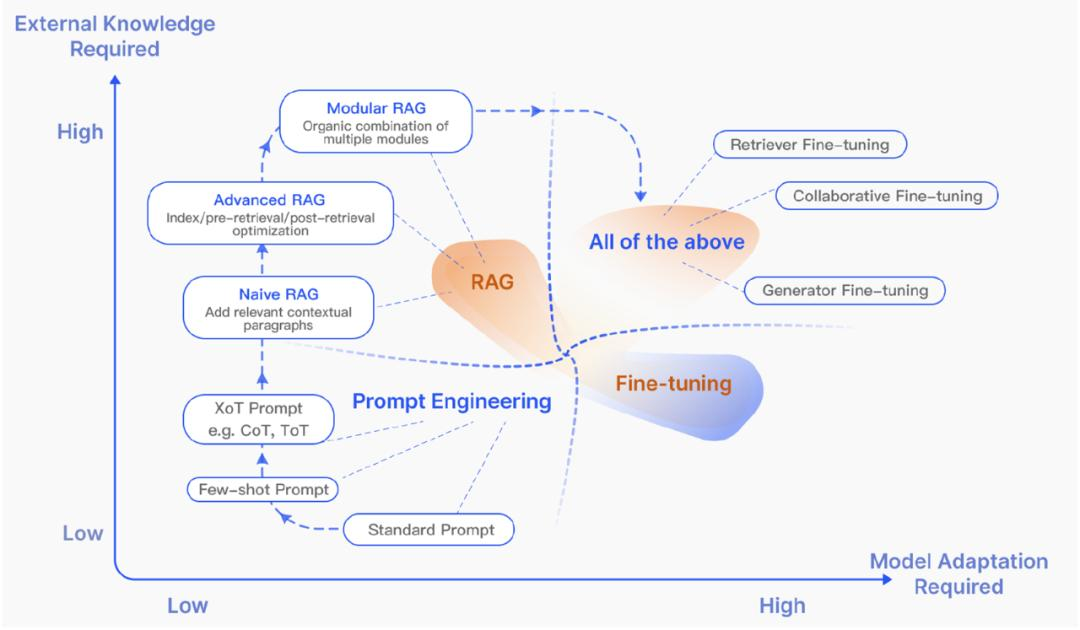

●短期记忆:各类RAG为主;知识图谱&前置分类器是上一代技术

●长期记忆:

Finetune作为一种方式,但目前成效有限

有思路认为通过“超长文本”,可以不解决长期记忆问题。“把人类一生的经历都用文本框输入,就不用记忆了”

2.Agent 2.0(未来1~2年)

●Planning:复杂任务拆解能力提升->成熟

●多Agent协作

目标线性拆解

群聊总结

3.Agent 3.0 (3+年)完全自主?

●长期记忆:自我学习构建“人格” (e.g. Auto-finetune)

●自我进化能力

●Agent创建Agent

●Agent管理Agent团队

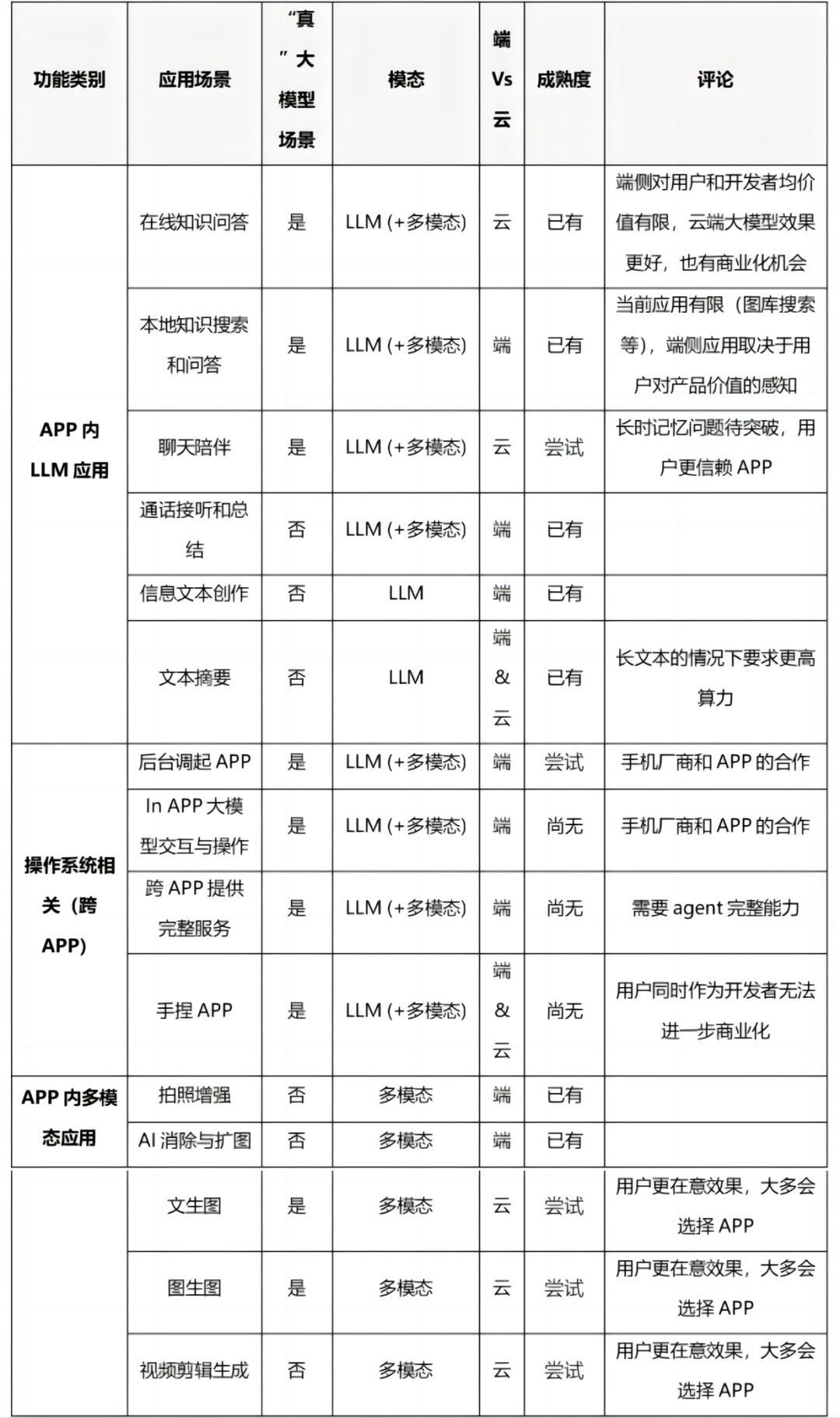

1.现状是云上为主,端侧为辅

●真正的大模型场景,是过去NLP/CV做不了、有了大模型才能做的场景;“假”场景则是过 去NLP/CV就能做的场景

●目前已成熟的“真”场景局限于:知识问答、聊天陪伴、总结、brainstorm图/文生图等,均 属于APP内应用

2. 端侧 & 云上的长期并存是大势所趋

既定事实:1)端侧模型能力<云上模型能力2)手机模型训练/精调只能在线上

2.1 技术限制

a.算力:复杂任务(长Token,Agent等)需要依赖云上模型

b.电池能耗:复杂任务需要依赖云上模型

c.存储:需要读写大量数据的任务需要依赖云上

2.2用户价值

d.网络延时:离线模型可以提升网络不佳情况的效果

i.需要技术:线上任务 & 离线任务 热迁移

e.权限&隐私

i.APP内信息/服务access:可能端侧模型更容易访问;取决于APP与手机厂商的协商

ii.本地数据访问:本地设置了加密的数据,可以要求只有端侧模型能访问

iii.在线数据访问:不需要端侧模型

f.个性化

i.Prompt里加入个人信息可以“假装”个性化体验

ii.也可以用线上账号的方式实现;且训练/精调只能在线上

2.3 商业价值

g.流量/收数

i.AI原生OS是手机厂商与APP生态建设的重点

ii.AI OS的功能理论上可以通过云上模型解决,但端侧+云上的模式会是多方协商合作的结果

h.变现:

i.端侧模型 = 手机价格提升的增值

ii.端侧 + 云上搭配 = 云上服务可以收订阅费用

i.成本:端侧模型降低云上推理成本支出

●从技术的角度,端侧大模型不是孤立的技术,而是跟AI芯片(GPU/TPU等)、操作系统共同形成一个完整的技术体系。

●手机端侧模型在未来3~5年的天花板可能在~10B级别,这意味着仍然需要与云上大模型配合,才能实现通用Agent、复杂COT/TOT、超长文本等高级功能。

●从用户的角度,对硬件的粘性远超软件。端侧模型是否真正能为用户创造价值还有不确定性;与OS的结合似乎是必经之路。

●大模型(不管是端侧还是云上)都为生态带来了新的变量。以前的“APPx硬件”流量入口格局还要加上“模型”。

文章来自于“腾讯研究院”,作者“腾讯研究院”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0