OpenAI 的推理模型,也就是期待已久的 Strawberry 发布!

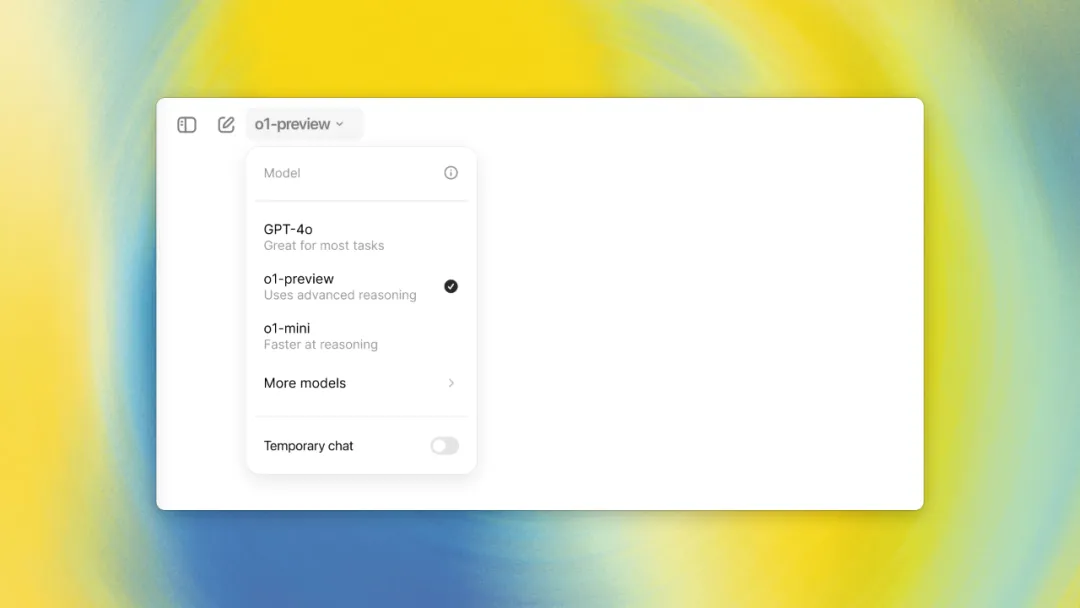

9 月 13 日凌晨,OpenAI 宣布,正式发布一款 OpenAI o1-preview 的推理模型,同时发布的还有一个更小、成本更低的版本——o1 mini。

OpenAI 将此次发布称为「预览版」,强调 o1 仍处于早期阶段。

OpenAI 的 API 负责人发文称:「如果你过去有个产品想法,当时的模型不太行,不够智能,现在你再试试」。

在权限开放方面,OpenAI 采取了分阶段推广策略。

对于开发者而言,通过 API 使用 o1 的成本不便宜。o1-preview 的定价为每百万输入 token 15 美元,每百万输出 token 60 美元,远高于 GPT-4o 的定价(输入 5 美元/百万 token,输出 15 美元/百万 token)。

在 OpenAI 员工的推文中,可以看到他们对于 o1 能力的赞许,以及一些关键的能力升级要点。

OpenAI API 负责人 Michelle Pokrass 推文:

o1-preview 和 o1-mini 模型已经上线。它们是我们目前为止在推理方面表现最佳的模型,我们相信它们将为 API 解锁全新的应用场景。

如果你有一个产品创意,但时机尚未成熟,模型还不够智能——不妨再次尝试。

这些新模型并不能完全替代 4o。

你需要以不同的方式进行提示,并以新的方式构建你的应用程序,但我们认为它们将有助于缩小智能差距,帮助你开发出更好的产品。

(现在为 API 第五级用户推出,用户也将很快可以使用)

Greg Brockman 的推文:

OpenAI o1—我们第一个通过强化学习训练的模型,在回答问题之前会深入思考。团队的工作令人非常自豪!

这是一个充满巨大机遇的新范式。这一点在定量上(例如推理指标已经显著提升)和定性上(例如忠实的思维链使模型易于理解,因为它允许你以简单的英语「阅读模型的思维」)都很明显。

可以这样理解,我们的模型进行系统 I 思考,而思维链则解锁了系统 II 思考。人们已经发现,提示模型「一步步思考」可以提升性能。但是通过试错来训练模型,从头到尾这样做,则更为可靠,并且——正如我们在围棋或 Dota 等游戏中所见——可以产生极其令人印象深刻的结果。

o1 技术仍处于早期阶段。它提供了新的安全机会,我们正在积极探索,包括可靠性、幻觉和对抗攻击者的鲁棒性。例如,我们已经看到,通过思维链让模型推理策略,我们的安全指标有了很大的提升。

其准确性也有很大的改进空间——例如,从我们的发布帖子来看,我们的模型在今年的编程奥林匹克竞赛(IOI)中,在人类条件下(每个问题 50 次提交)取得了第 49 百分位/213 分。但是,如果允许模型问题提交 10000 次,模型取得了 32.14 分——超过了金牌门槛。因此,模型能够产生比最初看起来更大的输出。

OpenAI 研究员 Jason Wei 的推文:

o1 是一个在给出最终答案之前会进行思考的模型。用我自己的话来描述,以下是对人工智能领域最大的更新:

游戏规则已经完全被重新定义了。

o1 采用强化学习技术进行训练,专门设计用于处理复杂的推理任务。与传统模型不同,o1 具有"深思熟虑"的能力——在给出最终回答之前,它能够在内部进行长链条的逻辑推理和思考过程,从而确保回应的质量和深度。

通过精心设计的训练过程,这些模型不仅学会了如何优化思考过程,还能灵活运用不同的问题解决策略,并且具备自我纠错的能力。

测试结果令人振奋。在即将推出的模型更新中,它在物理、化学和生物学等领域的复杂基准测试中,表现堪比博士生水平。

特别值得一提的是,它在数学和编程方面的表现尤为出色。举例来说,在国际数学奥林匹克(IMO)的资格考试中,我们的新推理模型正确解答了 83% 的问题,远超 GPT-4o 的 13%。在编程能力方面,通过 Codeforces 竞赛的评估,新模型的表现超过了 89% 的参赛者。

作为一个处于早期阶段的模型,它目前还不具备 ChatGPT 的一些实用功能,如网络浏览、文件上传和图像处理等,它在世界事实知识方面的表现也不如后者。短期内,对于日常应用场景,GPT-4o 可能仍然更为实用。

然而,在复杂推理任务方面,这个新模型代表了 AI 能力的一个重大飞跃。基于这一突破性进展,我们决定将计数器重置为 1,并将这个全新的模型系列命名为 OpenAI o1,以彰显其开创性意义。

我们开发了一种创新的大规模强化学习算法,这种算法能够在高效利用数据的同时,有效地训练模型运用其思维链进行富有成效的推理。这种训练方法的核心在于教会模型"如何思考",而不仅仅是存储和检索信息。

通过持续的研究,我们发现了两个关键因素能显著提升 o1 模型的性能:

这种方法在扩展性方面表现出了与传统大语言模型预训练截然不同的特点。传统的预训练主要受限于海量文本数据的获取和处理,而我们的方法更多地依赖于计算资源和算法优化。目前,我们正深入研究这种新方法的扩展限制,以期在未来取得更大的突破。

o1 的性能随着训练时计算和测试时计算的增加而平稳提升。

为了凸显 o1 模型在推理能力上相比 GPT-4o 的显著进步,我们设计了一套全面而严格的评估方案。这个方案包括了各种人类专业考试和机器学习领域公认的基准测试,涵盖了广泛的知识领域和复杂的推理任务。

测试结果令人振奋:在绝大多数需要深度思考和复杂推理的任务中,o1 模型都展现出了明显优于 GPT-4o 的表现。这一结果有力地证明了 o1 在处理高难度、需要多步推理的问题时的卓越能力。

值得注意的是,除非我们特别说明,所有针对 o1 的评估都是在最大化测试时间计算资源的情况下进行的。这意味着我们充分发挥了 o1 模型的潜力,让它有足够的"思考时间"来处理这些复杂任务。

o1 在具有挑战性的推理基准测试中显著优于 GPT-4o。实心条表示 pass@1 准确率,阴影区域显示 64 个样本的多数投票(共识)性能。

o1 在广泛的基准测试中超越了 GPT-4o,涵盖了 57 个 MMLU 子类别中的 54 个。

o1 模型在众多需要复杂推理能力的基准测试中展现出了与人类专家相当的水平,这一成就令人瞩目。值得注意的是,近期一些顶尖的 AI 模型在 MATH2 和 GSM8K 等传统数学测试中的表现已经如此出色,以至于这些测试不再能有效地区分不同模型的能力。

为了更严格地评估 o1 的数学能力,我们选择了美国数学邀请赛(AIME)作为测试基准。AIME 是专为挑战美国最优秀的高中数学生而设计的高难度考试,能够更好地测试模型的极限能力。

在 2024 年的 AIME 考试中,我们对比了 o1 和 GPT-4o 的表现:

o1 的最佳成绩 13.9 分是一个令人惊叹的结果。这一分数不仅使 o1 跻身全美前 500 名的优秀学生行列,更是超过了美国数学奥林匹克竞赛的入选分数线。这意味着,如果 o1 是一名高中生,它的数学能力足以让它有资格参加美国最高级别的数学竞赛。

我们进一步将 o1 模型应用于 GPQA diamond 测试,这是一个极具挑战性的智能基准测试,专门用于评估模型在化学、物理和生物学等领域的专业知识水平。为了进行公平的人机对比,我们特别邀请了拥有相关领域博士学位的专家参与测试。

测试结果令人振奋:o1 不仅成功完成了测试,更是超越了人类专家的表现,成为首个在 GPQA diamond 基准上击败人类专家的 AI 模型。这一突破性成就标志着 AI 在特定专业领域的能力已经达到了一个新的高度。

然而,我们需要谨慎地解读这一结果。o1 超越人类专家的表现并不意味着它在所有方面都比拥有博士学位的专家更强。相反,这表明 o1 在解决某些特定类型的问题上——即那些通常需要博士级专业知识的问题——展现出了非凡的熟练度和效率。

除 GPQA diamond 外,o1 在其他多个机器学习基准测试中也取得了突破性进展,推动了行业的技术前沿:

这些测试结果共同描绘了 o1 模型的全面能力图谱:它不仅在专业领域的深度知识上能与人类专家比肩,还在广泛的知识领域和多模态任务中展现出了优异的表现。这些成就标志着 AI 技术在通用智能和专业领域应用方面都取得了重大突破,为未来 AI 在更多复杂任务中的应用开辟了新的可能性。

我们基于 o1 模型进行了深度优化和专项训练,成功开发出了一个在编程领域表现卓越的 AI 模型。这个模型在 2024 年国际信息学奥林匹克竞赛(IOI)中展现了令人瞩目的实力,不仅获得了 213 分的高分,还跻身参赛者的前 50%,这一成绩充分证明了 AI 在高难度编程任务中的潜力。

比赛设置与挑战:

我们开发了一套独特的测试时选择策略,显著提升了模型的竞争力:

突破性表现:

这些结果清晰地展示了我们的 AI 模型在编程领域取得的重大突破。它不仅能在世界顶级的编程竞赛中与人类专家同台竞技,更在某些方面展现出超越人类的潜力。

通过在编程竞赛上进一步微调改进了 o1。在竞赛规则下,改进后的模型在 2024 年国际信息学奥林匹克竞赛中排名在第 49 百分位。

为了全面评估 AI 模型的实际应用效果,我们不仅关注传统的考试成绩和学术基准,还进行了一项创新的人类偏好评估。这项评估旨在比较 o1-preview 和 GPT-4o 两个模型在处理各种领域复杂、开放性问题时的表现。

评估方法:

关键发现:

结论:这项评估不仅展示了 o1-preview 在处理复杂推理任务时的优越性,也揭示了 AI 模型能力的多样性。它提醒我们,在选择和应用 AI 模型时,需要根据具体任务和场景来选择最合适的工具。同时,这也为未来 AI 模型的开发提供了方向,即如何在保持强大推理能力的同时,提升在自然语言处理等领域的表现。

在 AI 领域,"思维链"(Chain of Thought)是一个重要概念,它代表了 AI 模型在生成答案时的内部推理过程。这个过程就像人类的思考过程一样,包含了从问题到解决方案的一系列逻辑步骤。o1 运用"思维链"(chain of thought)方法来处理复杂任务。这种方法不仅模仿了人类的思考模式,还通过先进的强化学习技术不断优化和提升。

o1 的学习过程体现了多个关键特点:

这种多层次、自适应的学习过程极大地提升了 o1 的推理能力,使其在处理复杂问题时展现出近乎人类的灵活性和创造性。

诸如「我对……感到好奇」、「我正在思考」和「好的,让我看看」这样的短语,呈现一种思考的感觉。

思维链的潜在价值:

尽管思维链具有上述潜在价值,我们还是决定不向用户直接展示原始思维链。这个决定基于以下考虑:

为了在隐藏思维链和提供有价值信息之间取得平衡,我们采取了以下措施:

这一代模型凭借其卓越的推理能力,将为多个领域的专业人士带来显著助益,尤其是那些在科学研究、软件开发、数学计算等领域面临复杂挑战的人。让我们来看几个具体的应用场景:

总的来说,o1 模型为那些需要处理高度复杂问题、进行深度分析或创新研究的专业人士提供了强大的智能辅助工具。

文章来源“Founder Park”,作者“Founder Park”

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner