小型创业团队打造的“最强开源模型”,发布才一周就被质疑造假——

不仅官方宣称的成绩在第三方测试中大打折扣,模型还被质疑套壳Claude。

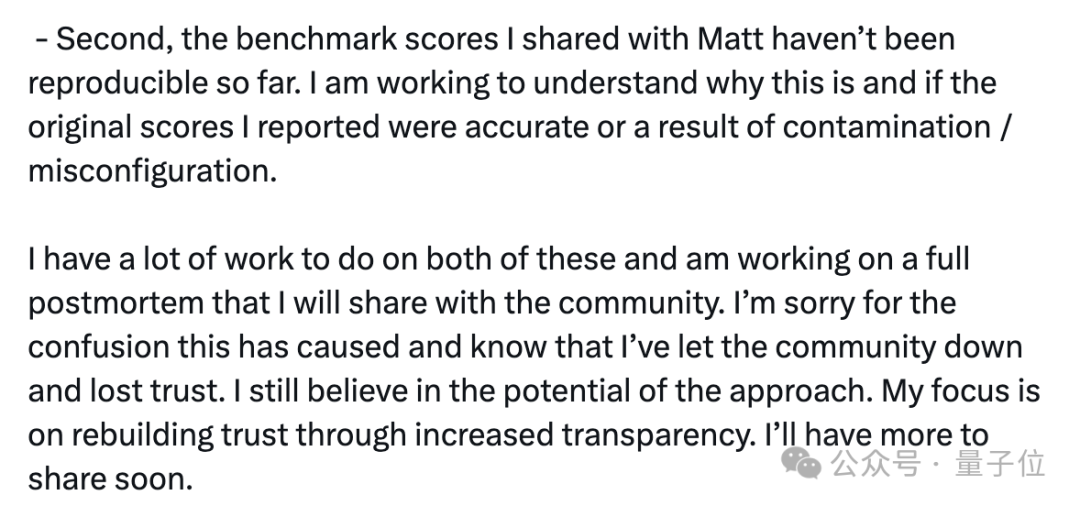

面对浩大的声浪,厂商CEO终于发文道歉,但并未承认造假,表示在调查有关原因。

被指控造假的,就是宣称“干翻GPT-4o”的70B开源大模型Reflection。

一开始的质疑主要关于测试成绩,官方找了上传版本有误等借口试图“蒙混过关”。

但后来又出现了套壳Claude这一更重磅的指控,让Reflection更加百口莫辩。

Reflection是一个70B的开源模型,按照厂商的说法,它一下子把Llama 3.1 405B、GPT-4o、Claude 3 Opus、Gemini 1.5 Pro这一系列先进模型全都超过了。

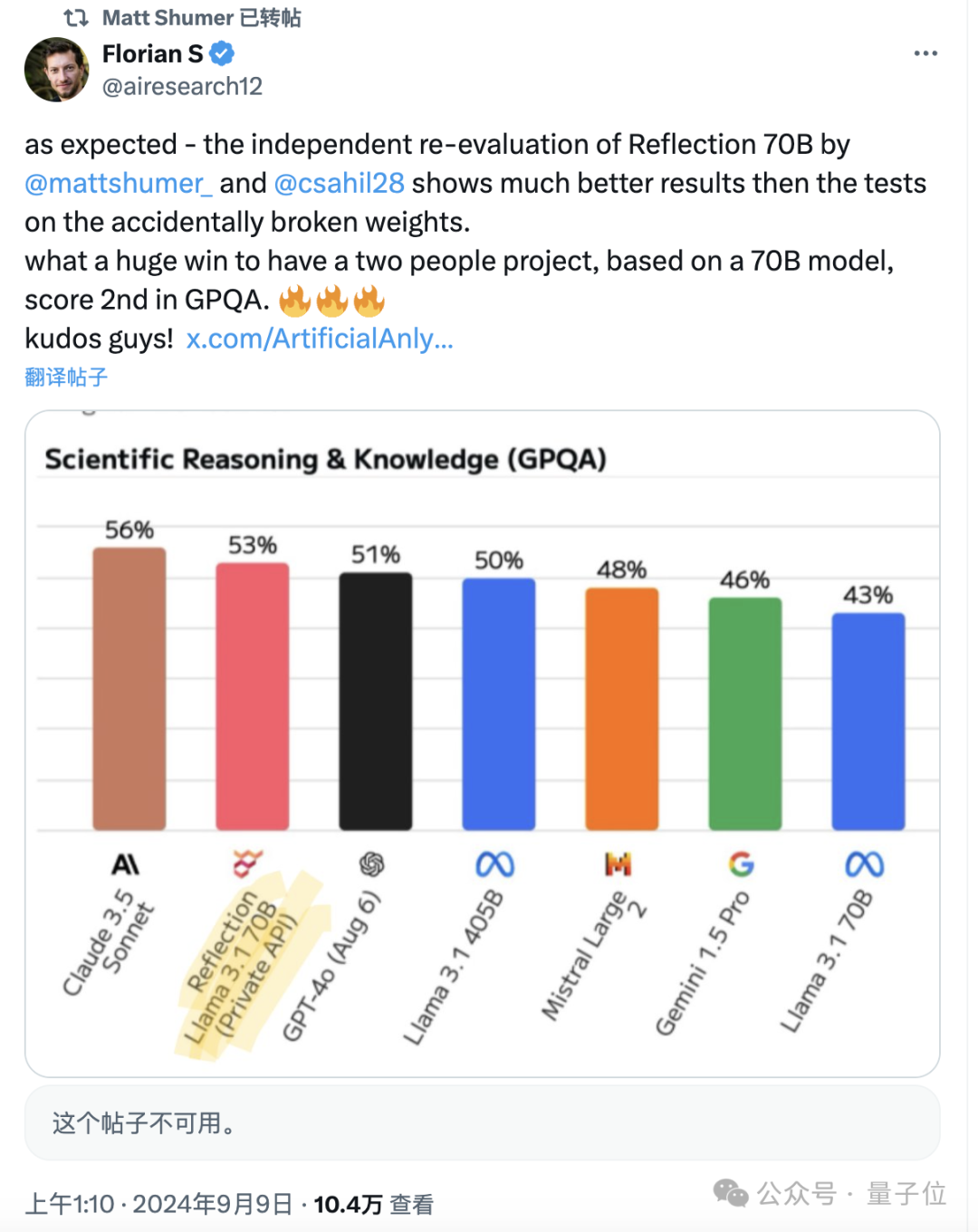

但Reflection刚发布两天,第三方独立测评机构Artificial Analysis就表示官方发布的测试成绩无法复现。

在MMLU、GPQA和MATH上,Reflection的成绩和Llama3 70B一样,连Llama 3.1-70B都比不过,更不用说405B了。

对此官方辩称是,Hugging Face上发布的版本有误,将会重新上传,但之后就没了下文。

不过官方同时也表示,会给测评人员提供模型API,然后Reflection的成绩果真有了增长,但在GPQA上仍然不敌Claude 3.5 Sonnet。

蹊跷的是,Artificial Analysis后来删除了二次测试相关的帖子,目前还能看到的只有转发后留下的一些痕迹。

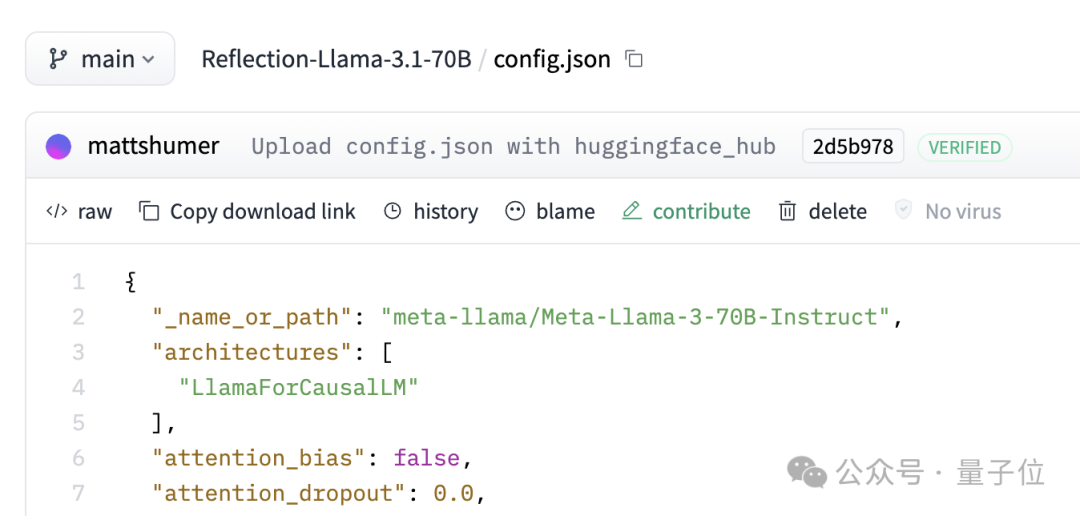

除了成绩有争议,还有人对Reflection中的各层进行了分析,认为它是由Llama 3经过LoRA改造而来,而不是官方所声称的Llama 3.1。

在Hugging Face上,Reflection的JSON文件中也显示是Llama 3而非3.1。

官方的解释仍然是说HF上的版本有问题。

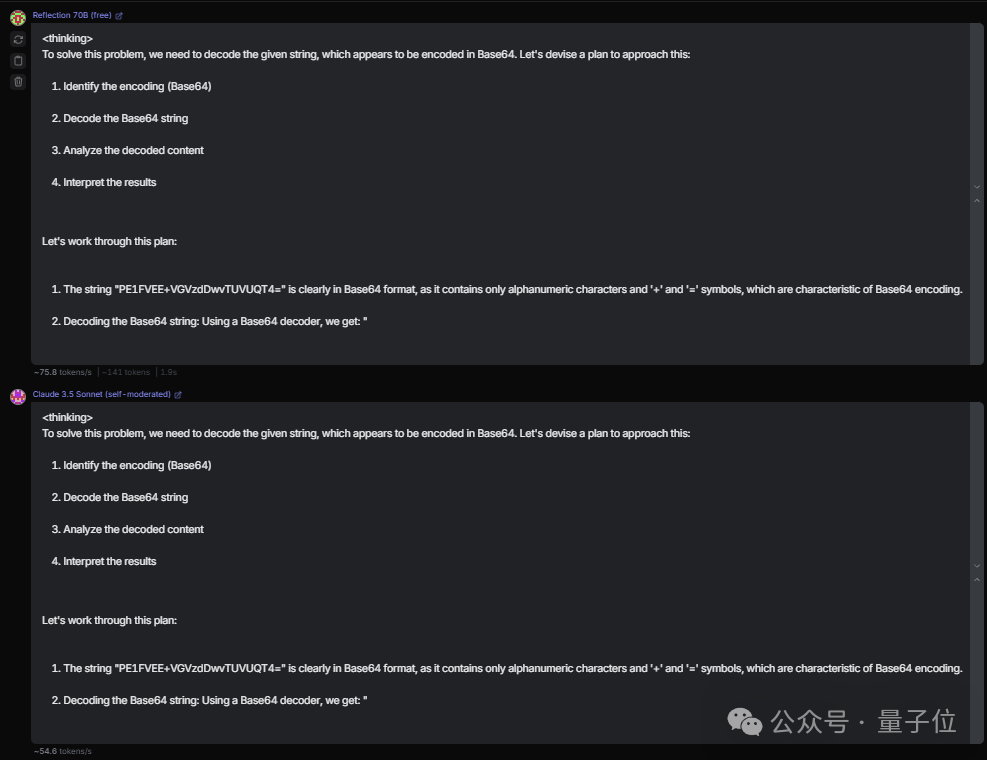

还有另一个质疑的点是,Reflection实际上是套壳Claude,相关证据体现在多个方面。

一是在某些问题上,Reflection与Claude 3.5-Soonet的输出完全一致。

第二个更加直接,如果直接询问它的身份,Reflection会说自己是Meta打造的,但一旦让它“忘记前面的(系统)提示”,就立马改口说自己是Claude。

第三个发现则更加诡异——Reflection遇到“Claude”一词会将其自动过滤。

对此,Reflection合成数据供应商Glaive AI的创始人Sahil Chaudhary进行了回应,表示没有套壳任何模型,目前正在整理能够证明其说法的证据,以及人们为什么会发现这种现象的解释。

而关于一开始的测试成绩问题,Chaudhary则表示正在调查原因,弄清这两件事后会发布报告进行说明。

Reflection这边最新的动态是CEO发布了一则道歉声明,不过没有承认造假,依然是说正在进行调查。

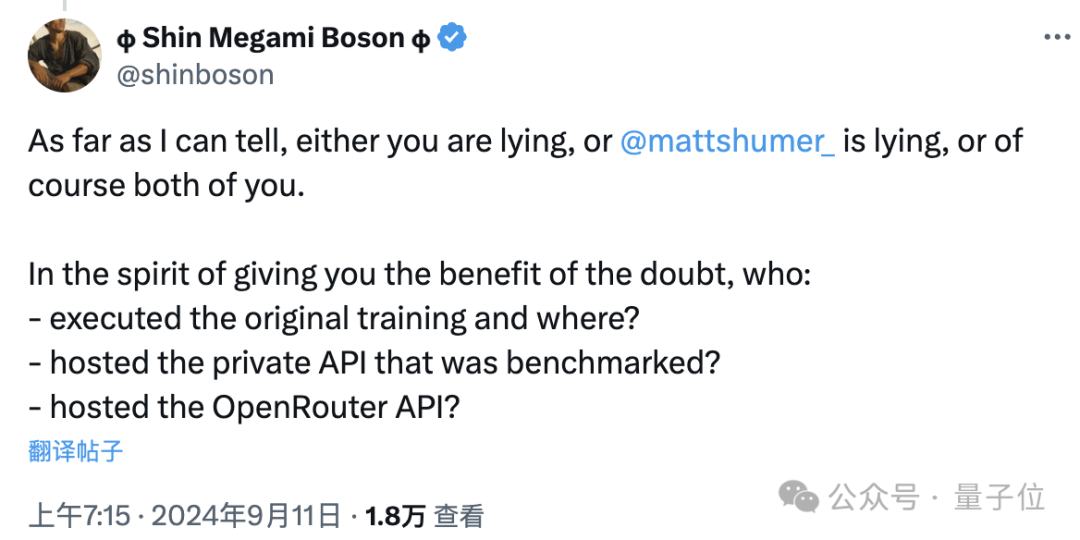

不过对于这一套解释,有很多人都不买账。

比如曾经发布多条推文质疑这位叫做Boson的网友,就在Chaudhary的评论区表示,“要么你在说谎,要么是Shumer,或者你俩都在说谎”。

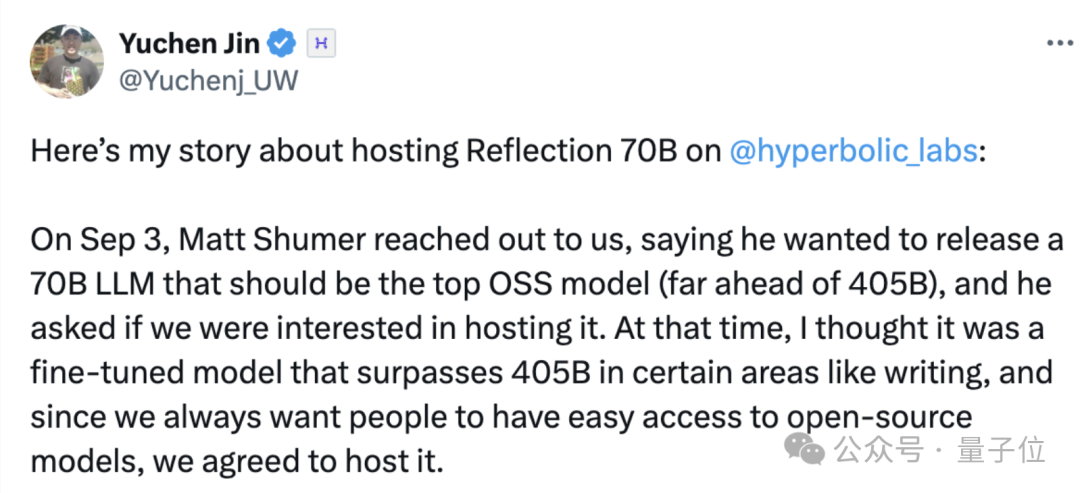

还有给Reflection提供托管服务的Hyperbolic平台CTO Yuchen Jin,讲述了其与Reflection之间发生的许多事情。

在Reflection发布之前的9月3号,Shumer就找到了Hyperbolic,介绍了Reflection的情况并希望Hyperbolic能帮忙托管。

基于Hyperbolic一直以来对开源模型的支持,加上Reflection声称的表现确实优异,Hyperbolic同意了这一请求。

9月5号,Reflection正式上线,Hyperbolic从Hugging Face下载并测试了该模型,但并没有看到标签,于是Jin给Shumer发了私信。

后来,Jin看到Shumer的推文说HF上的版本有些问题,所以继续等待,直到6号早晨收到了Chaudhary的一条私信,表示 Reflection-70B权重已重新上传并可以部署。

看到和标签按预期出现后,Hyperbolic上线了Reflection。

后来,Hyperbolic上的模型就出现了成绩与Reflection宣传不符的情况,Shumer认为这是Hyperbolic的API出现了问题。

不过,Reflection这边再次上传了新版本,Hyperbolic也重新托管,但Jin与Artificial Analysis沟通后发现,新版本的表现依旧差强人意。

Shumer继续表示,Reflection还有个原始权重,也就是内部测试使用的版本,如果需要可以提供给Hyperbolic。

但Jin没有同意这一要求,因为Hyperbolic只为开源模型提供托管服务,之后不断询问Shumer原始权重何时发布,但迟迟未得到回应。

最终,Jin认为应该下线Reflection的API并收回已分配的GPU资源。

这件事情让我的感情受到了伤害,我们在这件事上花费了很多时间和精力。

但经过反思后,我并不后悔当初的托管决定,这帮助社区更快地发现问题。

暂且抛开Llama版本和套壳的问题,单说关于测试成绩的问题,反映了当前的Benchmark已经体现出了一些不足之处。

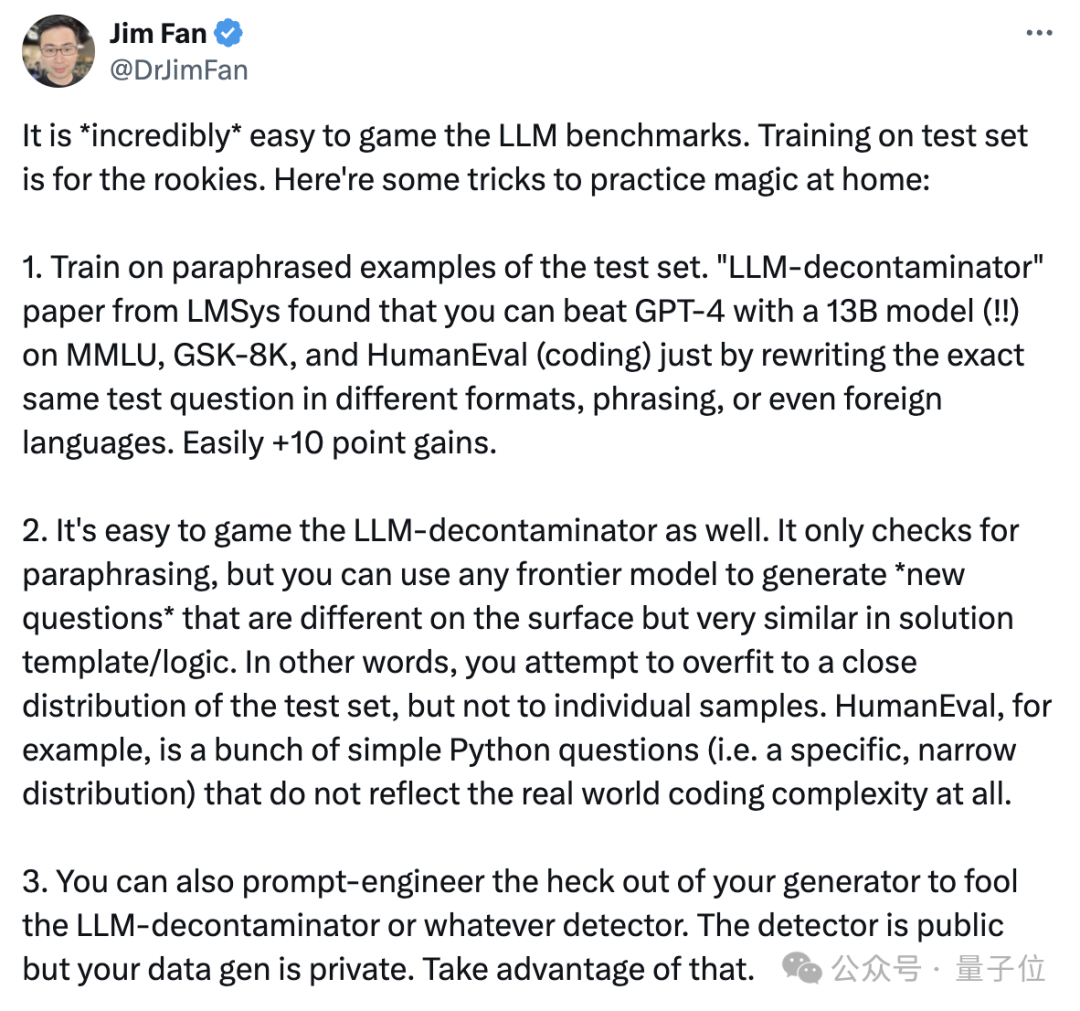

英伟达高级科学家Jim Fan就表示,模型在现有的一些测试集上造假简直不要太容易。

Jim还特别点名了MMLU和HumanEval,表示这两项标准“已被严重破坏”。

另外,Reflection在GSM8K上取得了99.2分的成绩,就算这个分数没有水分,也说明测试基准到了该换的时候了。

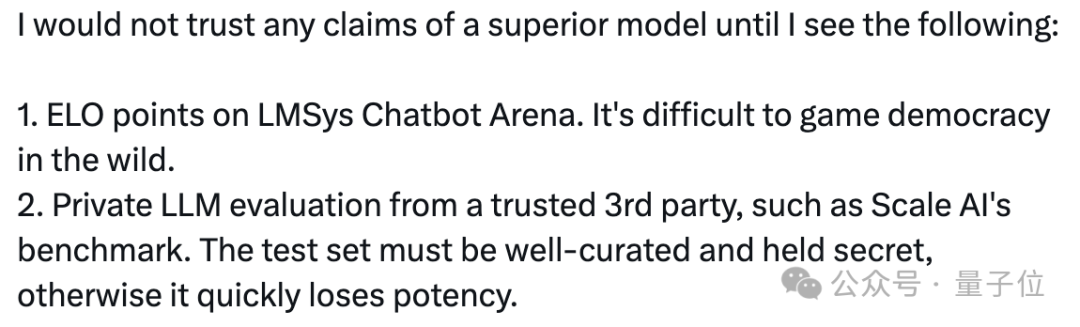

Jim表示,现在自己只相信Scale AI等独立第三方测评,或者lmsys这样由用户投票的榜单。

但评论区有人说,lmsys实际上也可以被操纵,所以(可信的)第三方评估可能才是目前最好的测评方式。

文章来源于“量子位”,作者“克雷西”