芯片加速AI发展,AI反过来又推动芯片进步?

刚刚,谷歌芯片设计算法AlphaChip正式亮相。

DeepMind CEO哈萨比斯调侃:这下闭环了。

训练最好的芯片设计算法→用它设计更好的AI芯片→用它们训练更好的模型→再设计更好的芯片→……

要知道,AlphaChip只需几个小时就能生成比肩人类水平的芯片设计图。

谷歌目前最强TPU“Trillium”,AlphaChip就参与了设计,而TPU又训练了Gemini、Imagen、Veo等新算法。

以及联发科、三星等芯片厂商,也都将其用到了实际生产中。

这不,最近处在转型逆风期的英特尔深陷并购风波。于是网友给出主意:

要不谷歌把英特尔买了吧。

谷歌表示AlphaChip现在不仅速度更快,而且需要的计算资源更少,已经达到人类专家级水平。

最新发布中,谷歌还开源了一个预训练版本,这样大家都能用AlphaChip更简易地开发芯片(但也还是自己预训练的效果更好)。

围观群众都相当兴奋:

这真的是超酷的贡献,对于工程领域很重要。

向前追溯来看,AlphaChip最早期的成果于2020年以预印本形式发布,2021年登上Nature。

但直到今天谷歌才给它了一个正式的名字。Jeff Dean是作者之一。

AlphaChip和AlphaGo、AlphaZero的原理相似,都是基于深度强化学习。

AlphaZero掌握了围棋、国际象棋的游戏规则,AlphaChip就是将规划芯片布局视为一个游戏。

一个芯片上往往包含数十亿个晶体管,由他们组成的数千万个逻辑门就是标准单元,此外还有数千个存储块,称为宏块。

芯片设计就是要确定它们的位置,如何布局将影响芯片的处理速度和电源效率。

传统方法中,光是放置宏块这一步就很耗时了,为了给标准单元留出更多空间,每一次迭代都要几天甚至几周时间。

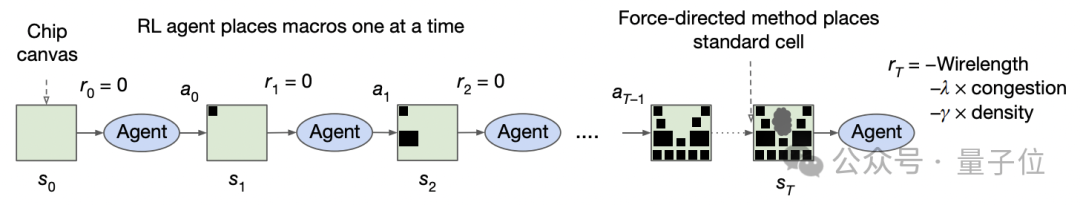

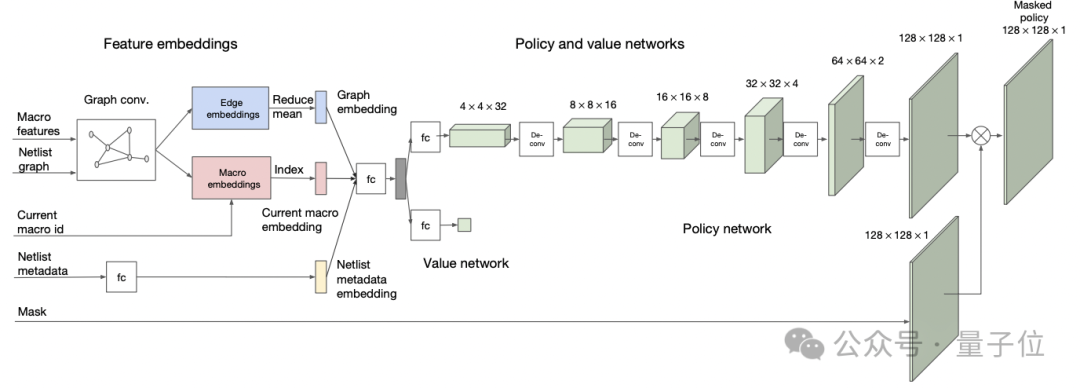

AlphaChip基于深度强化学习,从之前的芯片布局中进行学习,生成新的设计方案。

它将宏和标准单元映射到一个平面画布上,形成具有数百万到数十亿节点的“芯片网表”。

从一个空白格开始,一次放置一个电路元件,直到放置完所有元件。算法会对功率、性能和面积(PPA)等进行优化,并输出概率分布。最终将根据布局质量计算奖励。

利用一种新型的基于边缘(edge-based)的图神经网络AlphaChip可以学习互联芯片组件之间的关系,并应用在芯片之间,所以AlphaChip能对设计的每个布局进行改进。

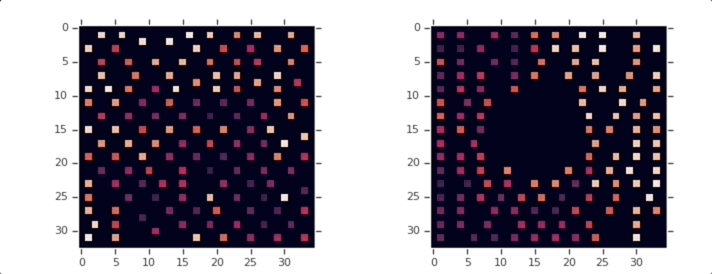

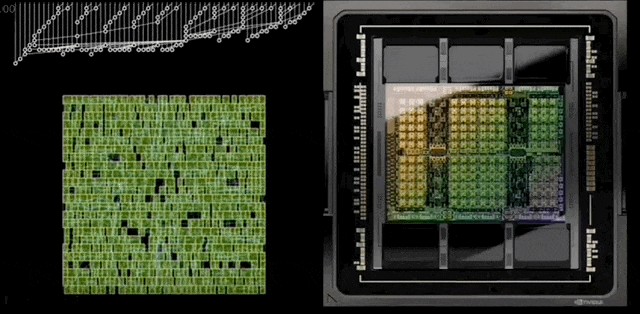

下图中,左图为零样本下AlphaChip布局开源Ariane RISC-V CPU的结果,右图为基于预训练策略(设计20个TPU)微调的效果。

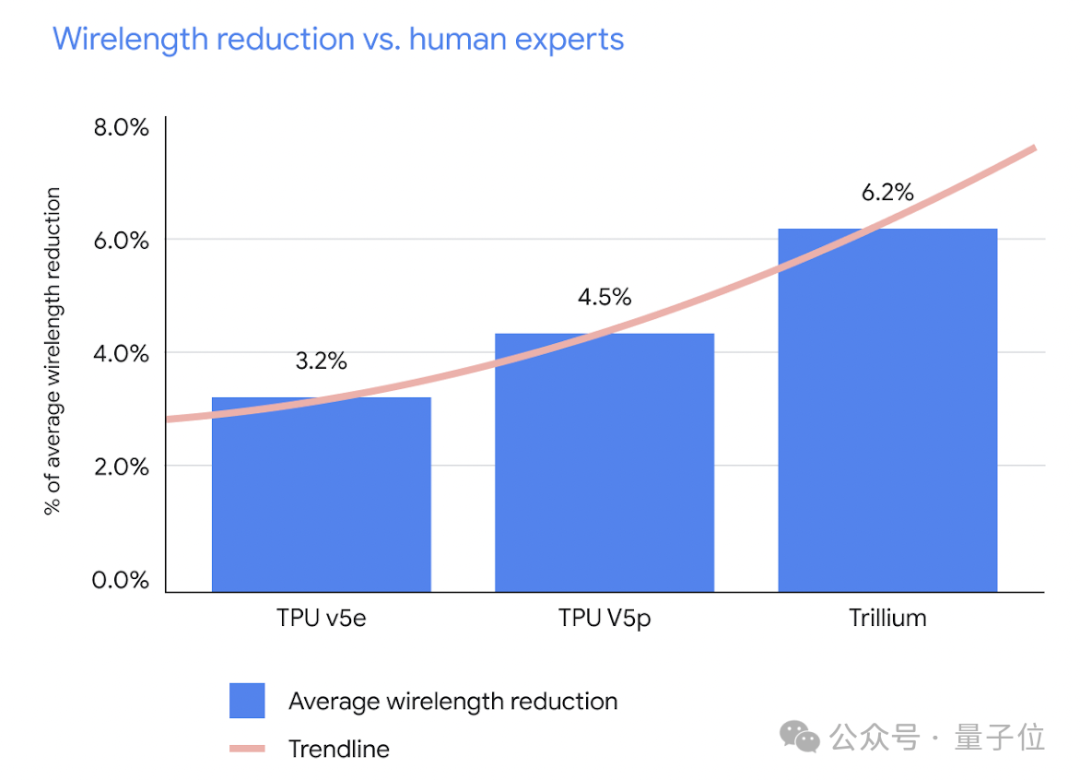

经过迭代,目前AlphaChip设计芯片的效果和速度都较此前有明显提升,达到和人类专家相近水平。

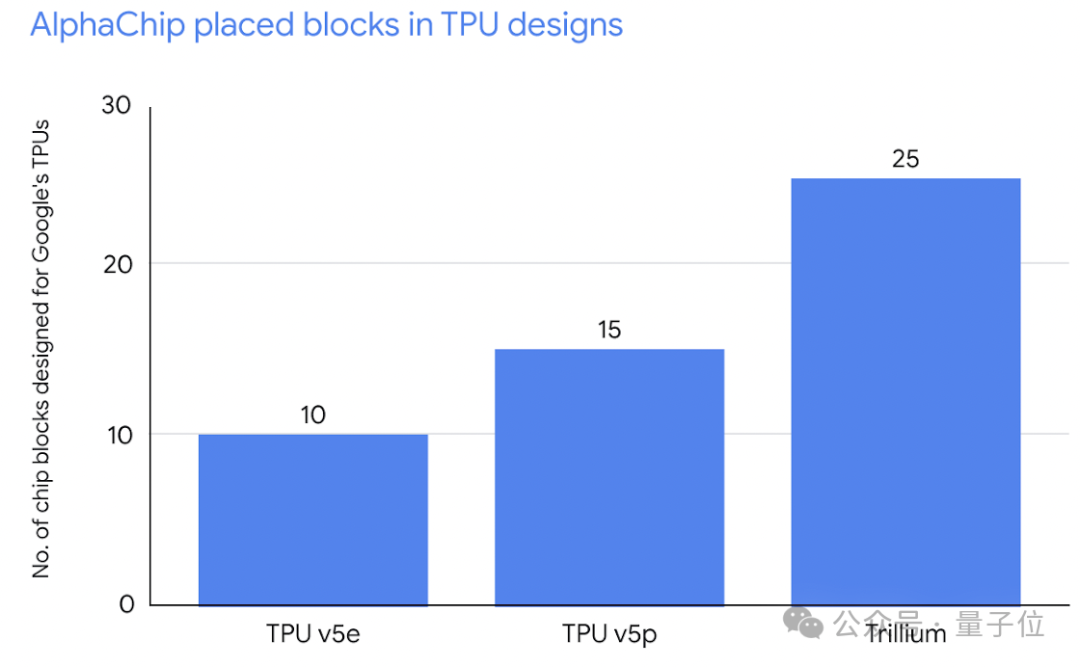

谷歌列举了AlphaChip在参与设计TPU v5e、TPU v5p、Trillium上的效果,它们分别是目前谷歌最先进的三款AI计算芯片。

值得一提的是,AlphaChip团队此前还陷入过打假风波。

谷歌大脑员工Satrajit Chatterjee在内部质疑该团队发表在Nature上的论文中存在一些站不住脚、实验尚未经过充分的测试。2022年3月,该研究员被谷歌解雇。

(一个猜测:这或许也是AlphaChip迟迟没有正式发布的原因之一?)

不过,用AI设计芯片,不只是谷歌在搞。

通过利用深度强化学习agent设计电路,H100中有近13000条电路由AI设计。

更早之前,三星也被曝用新思科技的DSO.ai来设计Exynos处理器。

当时新思还很得意表示,DSO.ai是第一个用于处理器设计的商业AI软件。

以及生成式AI大潮下,Cadence也在力推AI设计芯片,推出了Optimization AI方案。而且还有Cadence Copilot,利用大语言模型(LLM)和其他基础模型,显著提升工程师的生产力。

文章来源于“量子位”,作者“明敏”

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner