初衷是好的,但做法还有待商榷。

刚刚,被讨论了大半年的 SB 1047 终于迎来了大结局:加州州长 Gavin Newsom 否决了该法案。

SB 1047 全称是「Safe and Secure Innovation for Frontier Artificial Intelligence Act(《前沿人工智能模型安全创新法案》)」,旨在为高风险的 AI 模型建立明确的安全标准,以防止其被滥用或引发灾难性后果。

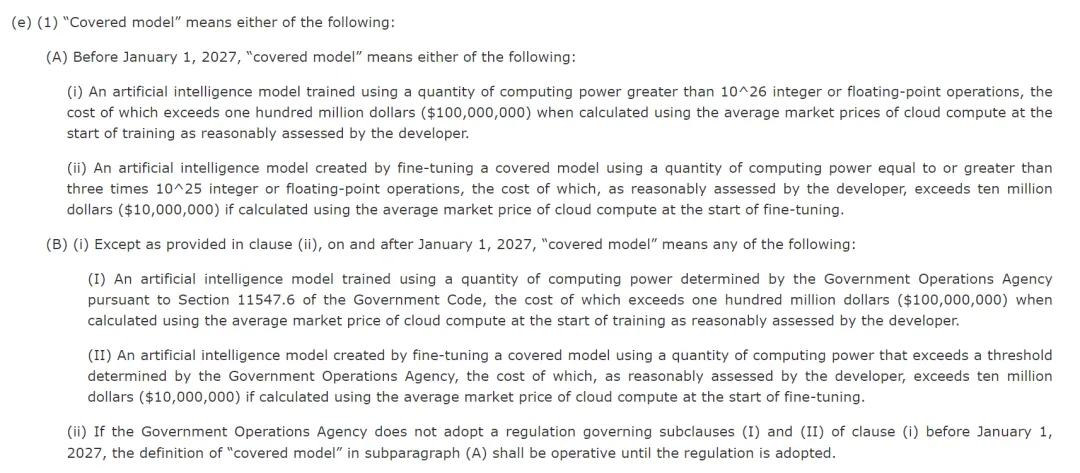

具体来说,该法案旨在从模型层面对人工智能进行监管,适用于在特定计算和成本阈值之上训练的模型。但如果严格按照规定的计算和成本阈值来算,现在市面上所有主流的大型模型都会被认为存在「潜在危险」。而且,法案要求模型背后的开发公司对其模型的下游使用或修改承担法律责任,这被认为会给开源模型的发布带来「寒蝉效应」。

法案链接:https://leginfo.legislature.ca.gov/faces/billTextClient.xhtml?bill_id=202320240SB1047

该法案于今年 2 月份在参议院被提出,随后一直争议不断。李飞飞、Yann LeCun、吴恩达都持反对态度。前段时间,李飞飞亲自撰文,阐述了法案可能带来的诸多不利影响。加州大学的数十名师生还签署了联名信,以反对这一法案(参见《李飞飞亲自撰文,数十名科学家签署联名信,反对加州 AI 限制法案》)。不过,也有很多人支持该法案,比如马斯克、Hinton、Bengio。在法案被提交给加州州长之前,双方展开了多次激烈论战。

如今,一切尘埃落定。在给出的否决声明中,州长 Newsom 列举了影响他做决断的多个因素,包括该法案会给人工智能公司带来的负担、加州在该领域的领先地位以及对该法案可能过于宽泛的批评。

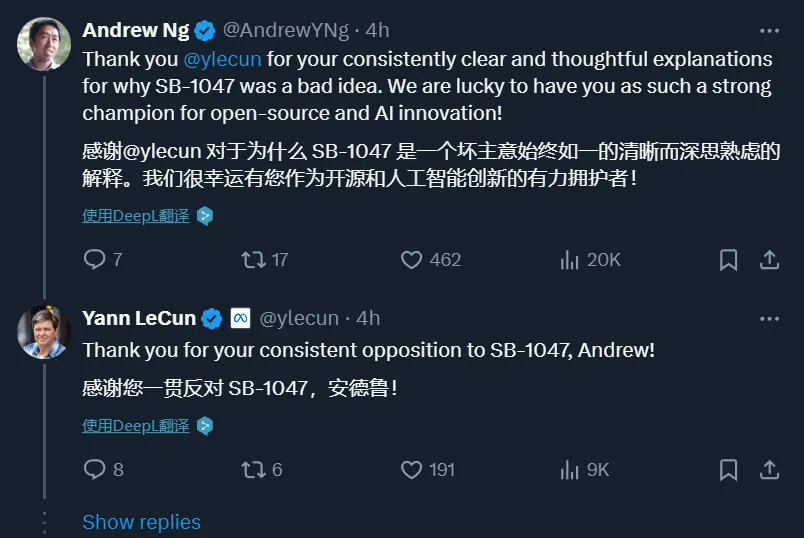

在消息发布后,Yann LeCun 代表开源社区表达了对加州州长的感谢。

吴恩达则肯定了 Yann LeCun 一直以来向公众解释该法案弊端的努力。

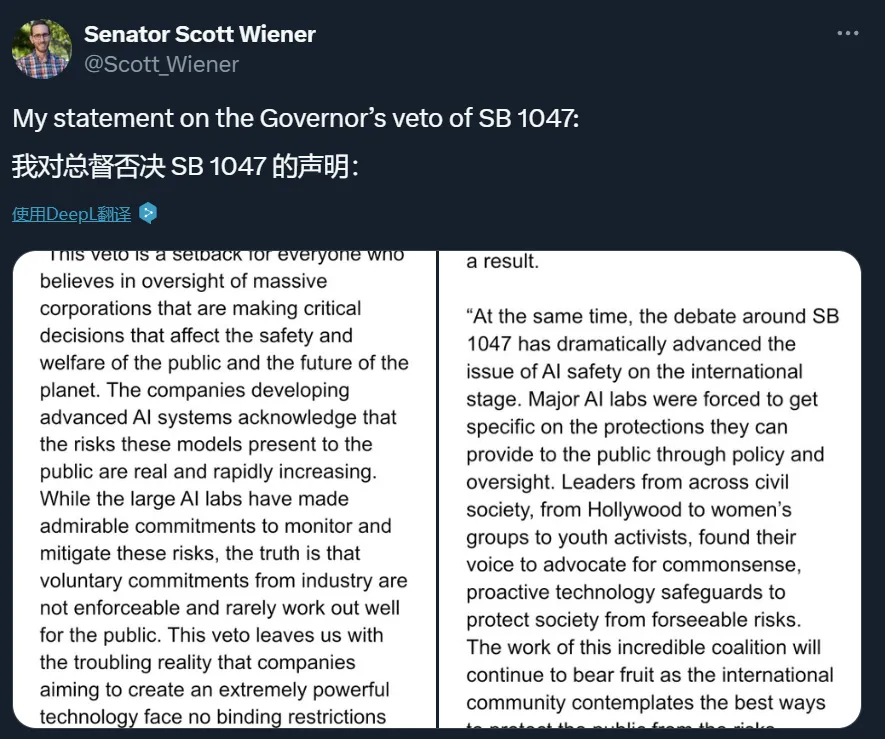

不过,有人欢喜有人忧 —— 法案的提出者、加州参议员 Scott Wiener 表示对结果非常失望。他在一个帖子中写道,这次否决「对所有相信将对大公司实施监督的人来说都是一个挫折,这些公司正在做出影响公共安全和福利以及『地球的未来』的关键决策」。

需要指出的是,否决 SB 1047 并不意味着加州对 AI 安全问题置之不理,州长 Newsom 在声明中提到了这一点。同时,他还宣布,李飞飞等人将协助领导加州制定负责任的生成式人工智能部署防护措施。

对于 SB 1047,加州州长 Newsom 拥有最终决断权。他为什么会否决该法案?一份声明提供了答案。

声明链接:https://www.gov.ca.gov/wp-content/uploads/2024/09/SB-1047-Veto-Message.pdf

声明节选如下:

在全球 50 家领先的 Al 公司中,加州拥有 32 家,它们是现代史上重要的技术进步的先驱。我们在这一领域处于领先地位,这得益于我们的研究和教育机构、多元化和积极进取的劳动力,以及我们对思想自由的自由奔放的培养。作为未来的管理者和创新者,我认真对待监管这一行业的责任。

SB 1047 夸大了关于部署 Al 可能带来的威胁的讨论。辩论的关键在于,监管的门槛是应该基于开发 Al 模型所需的成本和计算数量,还是应该不考虑这些因素而评估系统的实际风险。这一全球性的讨论是在 Al 的能力以惊人的速度不断扩展的情况下进行的。与此同时,应对灾难性危害风险的战略和解决方案也在迅速发展。

SB 1047 法案只关注最昂贵和最大规模的模型,它建立的监管框架可能会让公众对控制这种快速发展的技术产生错误的安全感。与 SB 1047 所针对的模型相比,较小的、专业化的模型可能同样危险,甚至更危险。

在我们争分夺秒监管一项仍处于起步阶段的技术时,适应性至关重要。这需要一种微妙的平衡。尽管 SB 1047 法案的初衷是好的,但它并没有考虑到 Al 系统是否部署在高风险环境中、是否涉及关键决策或敏感数据的使用。相反,该法案甚至对最基本的功能也采用了严格的标准 —— 只要大型系统部署了这些功能。我认为这不是保护公众免受该技术实际威胁的最佳方法。

我同意作者所说的我们不能等到发生重大灾难时才采取行动保护公众。加州不会放弃自己的责任。必须采纳安全协议。应该实施主动的防护措施,对于不良行为者必须有明确且可执行的严厉后果。然而,我不同意的是,为了保证公众的安全,我们必须满足于一种没有对人工智能系统和能力进行经验轨迹分析的解决方案。最终,任何有效规范 AI 的框架都需要跟上技术本身的步伐。

对于那些说我们没有解决问题,或者说加州在监管这项技术对国家安全的潜在影响方面没有作用的人,我不同意。只在加州采用这种方法可能是有道理的,尤其是在国会没有采取联邦行动的情况下,但这种方法必须建立在经验证据和科学的基础上。

隶属于美国国家科学技术研究院(National Institute of Science and Technology)的美国 AI 安全研究所(The U.S. Al Safety Institute)正在根据实证方法制定国家安全风险指南,以防范对公共安全的明显风险。

根据我在 2023 年 9 月发布的一项行政命令,我的政府内部各机构正在对加州关键基础设施使用 AI 的潜在威胁和脆弱性进行风险分析。

在专家的领导下,我们正在开展多项工作,向政策制定者介绍植根于科学和事实的 AI 风险管理实践,这些只是其中的几个例子。

通过这些努力,我在过去 30 天内签署了十多项法案,对 AI 造成的已知具体风险进行监管。

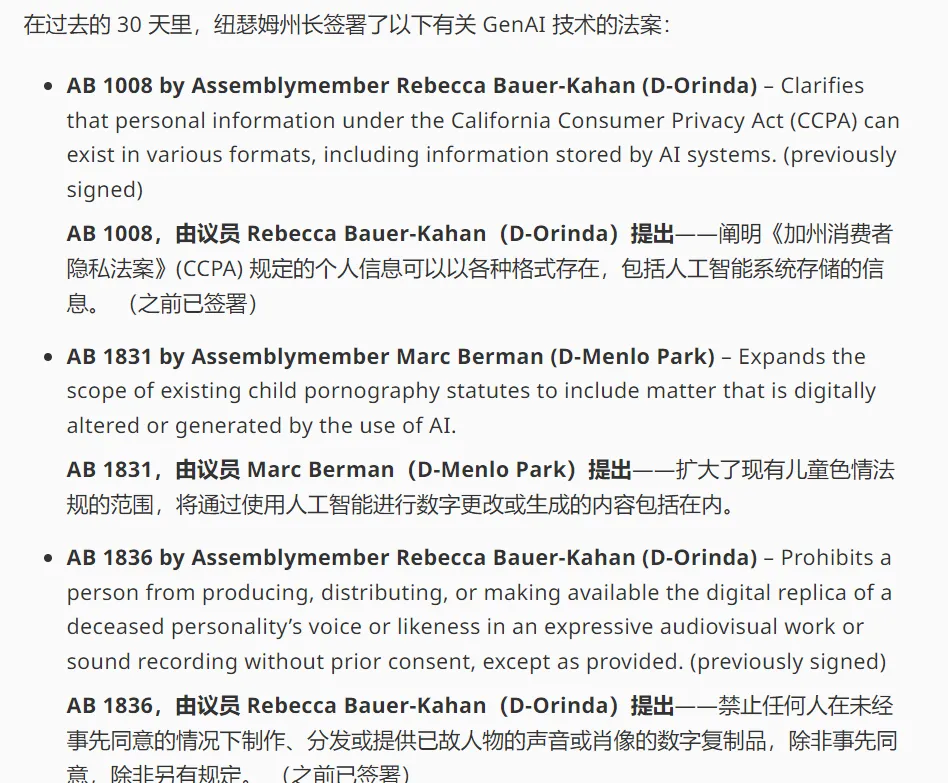

在声明中,Newsom 提到他在 30 天内签署了十多项法案。这些法案涉及面非常广,包括打击露骨的 Deepfake 内容,要求对 AI 生成的内容添加水印,保护表演者的数字肖像、已故人物的声音或肖像版权、消费者隐私,探讨人工智能纳入教学的影响等多个方面。

法案列表链接:https://www.gov.ca.gov/2024/09/29/governor-newsom-announces-new-initiatives-to-advance-safe-and-responsible-ai-protect-californians/

针对 SB 1047 对 AI 风险的评估缺乏科学分析这个问题,州长宣布,他已要求全球领先的生成式 AI 专家帮助加州开发部署生成式 AI 的可行护栏。

除了李飞飞,美国国家科学院计算研究社会和伦理影响委员会成员 Tino Cuéllar 以及加州大学伯克利分校计算、数据科学和社会学院院长 Jennifer Tour Chayes 也是该计划的成员之一。

他们的工作重点是对前沿模型及其能力和随之而来的风险进行经验性的、基于科学的轨迹分析。这一工作任重道远。

参考链接:https://www.gov.ca.gov/2024/09/29/governor-newsom-announces-new-initiatives-to-advance-safe-and-responsible-ai-protect-californians/

文章来自于“机器之心”,作者“张倩”。