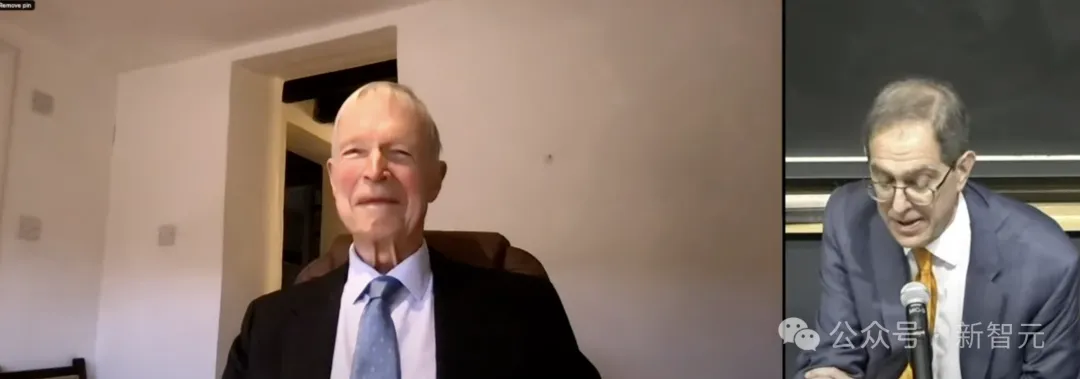

昨天的诺贝尔物理学奖一公布,瞬间炸翻了物理圈和AI圈。

Hinton的第一反应更是有趣:这不会是个诈骗电话吧?

如此出乎意料的结果,让各路针对诺奖物理学奖的严肃预测,都仿佛成了笑话。

而诺贝尔奖的官方账号,也被网友们给冲爆了。

他们纷纷高呼:这不是物理学!

「数据科学或神经网络是『用于』物理学,但绝对不『是』物理学。」

相比之下,AI圈则是一片其乐融融的景象。大佬们都开心地给Hinton送去了祝福。

AI教母李飞飞:AI的深远影响,如今才刚刚开始

MIT博士生Ziming Liu直言:「Physics (Science) for AI」是一个被严重低估的领域。规模化可以实现一对多的效果,但唯有科学才能带来从无到有的突破。

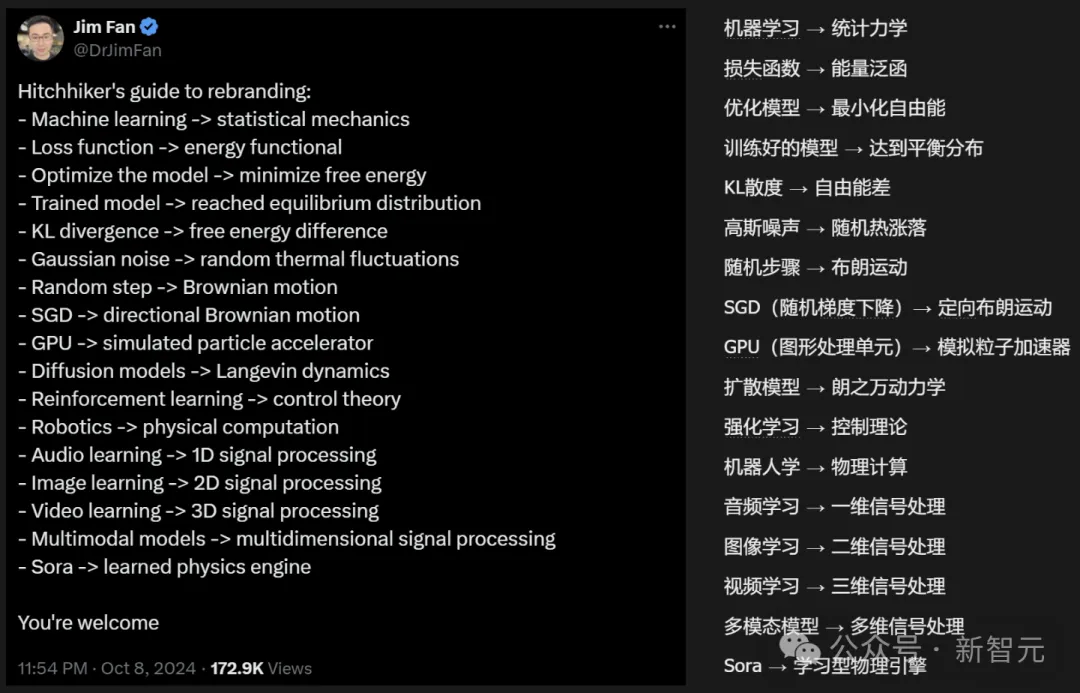

Jim Fan则做了一个非常有趣的「AI-物理学对照表」:

想冲击诺奖的AI学者们,你们学会了吗

言归正传,诺贝尔物理学奖,为何要颁给AI学者?

这就要从深度学习爆发的那一年讲起。

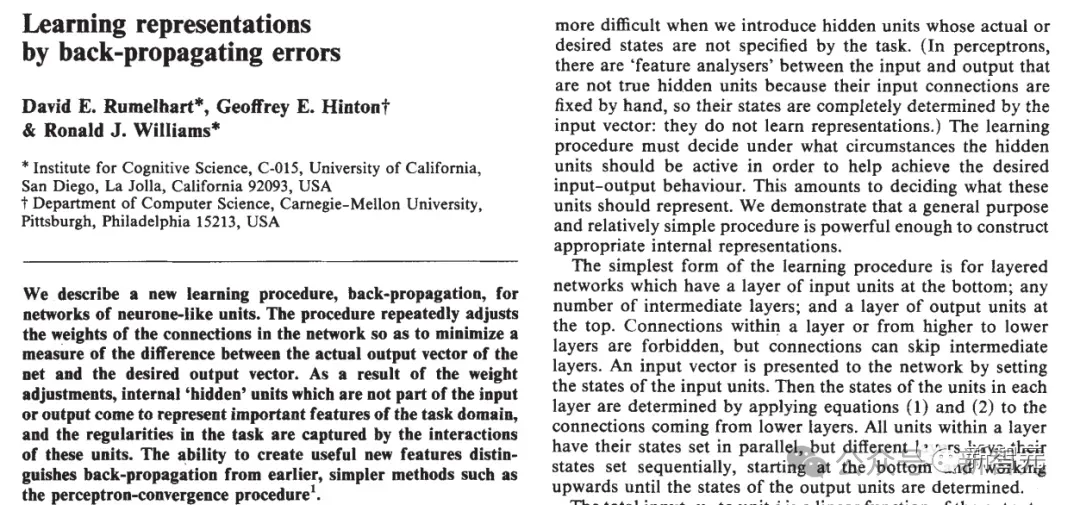

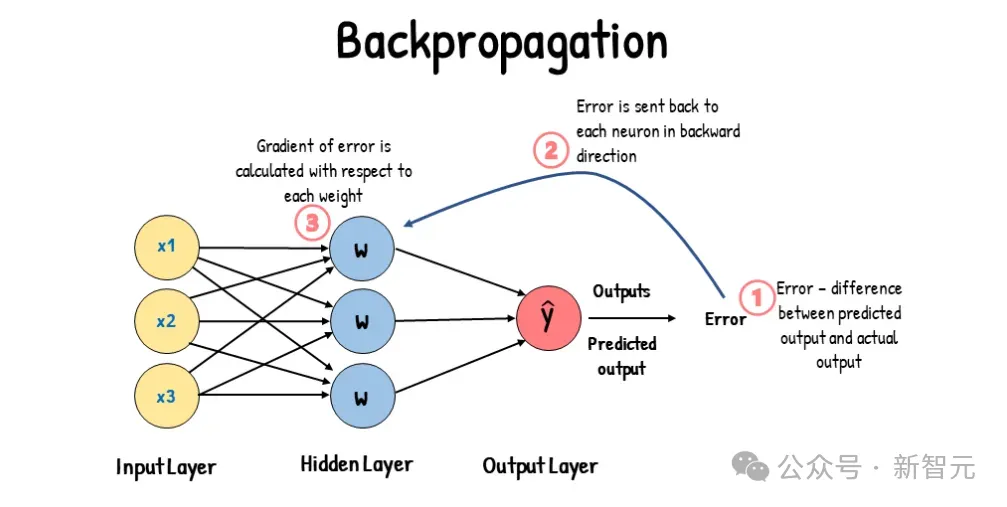

早在1986年,Geoffrey Hinton等人在Nature上发表的论文,就让训练多层神经网络的「反向传播算法」广为人知。

当时我们很多人都相信这一定是人工智能的未来。我们成功地证明了我们一直相信的东西是正确的。

可以说,神经网络在经历第一波寒冬之后,自此开始重新走向AI舞台。

1989年,LeCun率先使用了反向传播和卷积神经网络。他也同意Hinton的看法。

我毫不怀疑,最终我们在上世纪80-90年代开发的技术将被采用。

早期的图灵三巨头

不过,反向传播算法引发的热潮,随后又在1995年被统计机器学习盖过去了。

统计机器学习的风头兴盛了很多年,即使2006年Hinton在Science上首次提出「深度学习」,业内也响应寥寥。

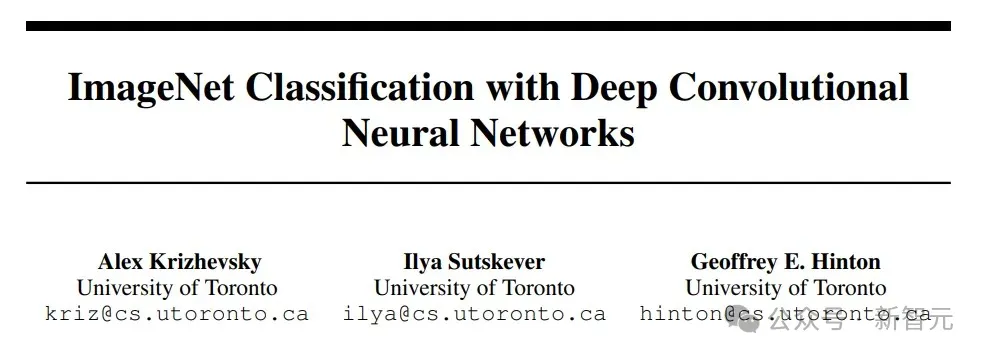

直到2012年9月,一篇题为「用深度卷积神经网络进行ImageNet图像分类」的论文,让此前沉寂多年的AI领域热度骤起。

文中提出的AlexNet深度卷积神经网络,在当年的ImageNet比赛上以碾压之势夺冠,一举将top-5错误率降低到了15.3%,比身后的第二名(26.2%)足足高出10多个百分点。

ImageNet数据集,正是由斯坦福李飞飞团队在2007年创建。

AlexNet摧枯拉朽般的大胜,让研究人员惊叹于大型卷积深度神经网络架构的神奇威力,这篇论文也成为深度学习和人工智能自「AI寒冬」后重新成为热门领域的重要里程碑。

后来人们所讲的「深度学习革命」,也借此文以发端,直到十二年后的今天。

事后李飞飞这样回顾:自2012年以来,深度学习的发展堪称「一场惊人的革命,令人做梦都没想到」。

自此,人们开始相信:大数据、算力、深度模型,是走向通用人工智能的关键三要素。

而深度模型也从最早的卷积神经网络,迭代为递归神经网络、Transformer、扩散模型,直至今天的GPT。

在年轻时,为了弄清楚人类的大脑如何工作,Hinton首先来到剑桥学习生理学,而后又转向哲学,但最终也没有得到想要的答案。

于是,Hinton去了爱丁堡,开始研究AI,通过模拟事物的运行,来测试理论。

「在我看来,必须有一种大脑学习的方式,显然不是通过将各种事物编程到大脑中,然后使用逻辑推理。我们必须弄清楚大脑如何学会修改神经网络中的连接,以便它可以做复杂的事情。」

「我总是受到关于大脑工作原理的启发:有一堆神经元,它们执行相对简单的操作,它们是非线性的,它们收集输入,进行加权,然后根据加权输入给出输出。问题是,如何改变这些权重以使整个事情做得很好?」

某个周日,Hinton坐在办公室,突然有人敲门。AI命运的齿轮从此转动。

敲门的正是Ilya。

当年青涩的Ilya

Hinton给了Ilya一篇关于反向传播的论文,约定两人一周后讨论。

Ilya:I didn't understand it.

Hinton:这不就是链式法则吗?

Ilya:不是,我不明白你为啥不用个更好的优化器来处理梯度?

——Hinton的眼睛亮了一下,这是他们花了好几年时间在思考的问题。

Ilya很早就有一种直觉:只要把神经网络模型做大一点,就会得到更好的效果。Hinton认为这是一种逃避,必须有新的想法或者算法才行。

但事实证明,Ilya是对的。

新的想法确实重要,比如像Transformer这样的新架构。但实际上,当今AI的发展主要源于数据的规模和计算的规模。

2011年,Hinton带领Ilya和另一名研究生James Martins,发表了一篇字符级预测的论文。他们使用维基百科训练模型,尝试预测下一个HTML字符。

模型首次采用了嵌入(embedding)和反向传播,将每个符号转换为嵌入,然后让嵌入相互作用以预测下一个符号的嵌入,并通过反向传播来学习数据的三元组。

当时的人们不相信模型能够理解任何东西,但实验结果令人震惊,模型仿佛已经学会了思考——所有信息都被压缩到了模型权重中。

讲到这里,你可能有一个疑问:这些跟物理学有什么关系呢?

诺奖委员会的解释是,人工神经网络是用物理学工具训练的。

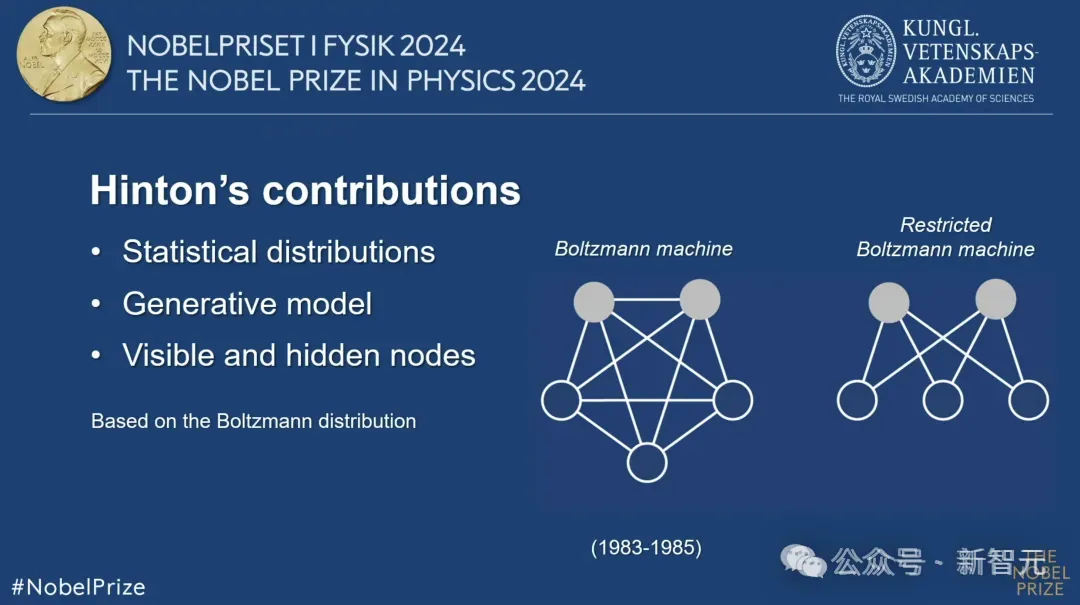

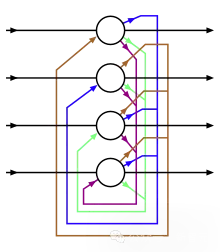

Geoffrey Hinton曾以Hopfield网络为基础,创建了一个使用不同方法的新网络:玻尔兹曼机。在这个过程中,Hinton使用的是统计物理学的工具,来学习和识别数据中的模式。

就这样,AI跟物理学联系上了。

如果讲到此次另一位获奖者John Hopfield,倒是和物理学的关系更紧密一些。

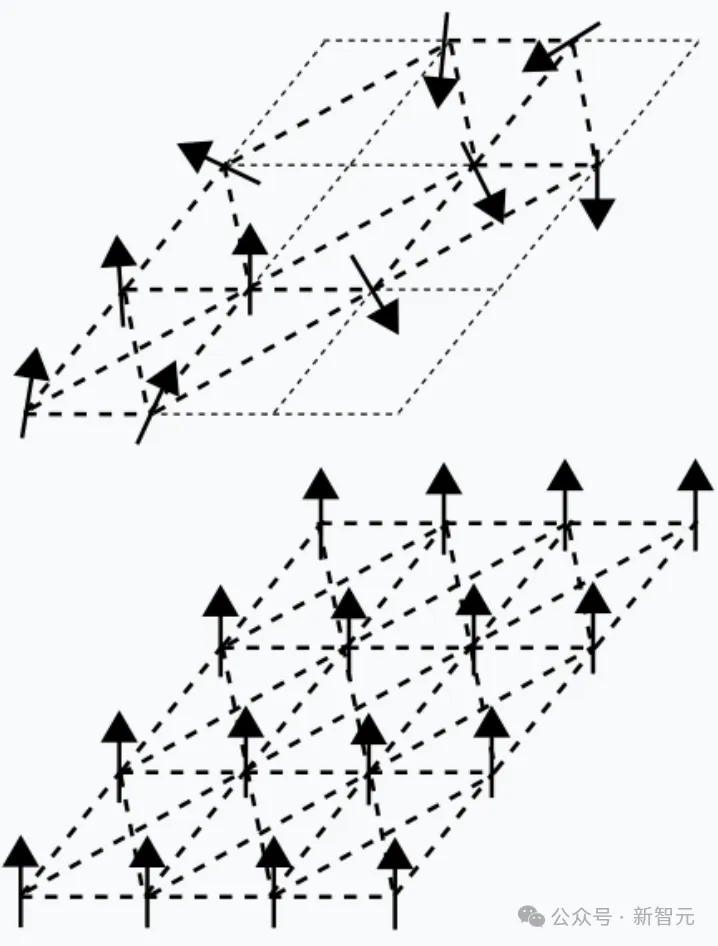

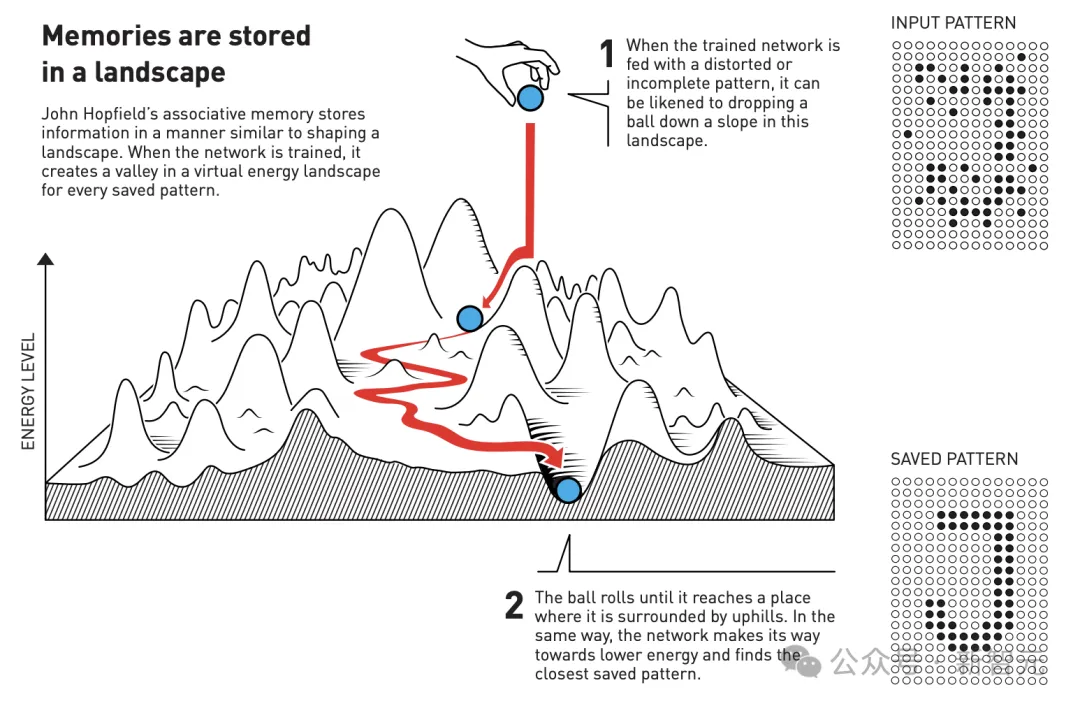

一言以蔽之,Hopfield网络是按物理学上能量函数最小化来构建的,可以看作是物理学中「自旋玻璃模型」的扩展。

Hopfield网络利用了材料由于其原子自旋而具有特性的物理学——这种特性使每个原子成为一个微小的磁铁。整个网络的描述方式等同于物理学中发现的自旋系统中的能量,并通过找到节点之间连接的值来训练,使保存的图像具有低能量。

另外,Hopfield Network和玻尔兹曼机都是基于能量的模型。

统计力学原理,便是这两者的核心。它们都使用来自统计力学的能量函数,来建模和解决与模式识别和数据分类相关的问题。

在前者当中,能量函数被用来寻找与所存储的模式相对应的最稳定状态。后者中,能量函数通过调整节点之间连接的权重来帮助学习数据的分布。

至此,诺奖委员会就自圆其说了。

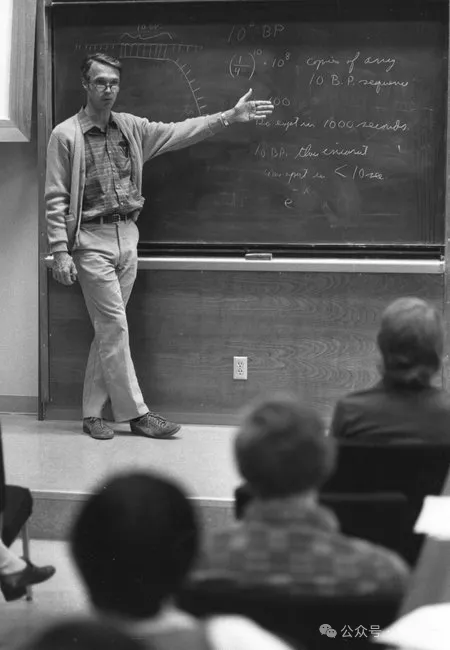

20世纪80年代初,John Hopfield在加州理工学院创建了一个简单的计算机模型——Hopfield Network。

其行为方式不太像当时的计算机,而更像人脑。

这是因为,Hopfield Network模仿了人脑储存信息的结构。它由相互连接的节点组成,正如人脑中的神经元一样。

节点中的连接强度具有可塑性,可强可弱,而强连接进而形成了我们所说的「记忆」。

Hopfield学生,现Caltech计算机科学、计算与神经系统以及生物工程教授Erik Winfree解释道:

Hopfield Network是物理学中「自旋玻璃模型」(the spin glass model)的扩展。自旋玻璃有两种磁化状态,可以称之为它的「记忆」。

Hopfield扩展了这一模型,让其有了更复杂的连接模式。

简言之,他使用一个简单的规则,让每对单元(每个节点)之间有不同的连接强度,而不再局限于两种状态。

他的工作证明了,这种网络可以储存多种复杂的模式(记忆),而且比之前的方法更接近大脑运作方式。

Hopfield以一种跨学科的视角阐述这个模型,解释了人工神经网络与物理学之间的联系。

复旦大学计算机科学教授张军平认为,Hopfield Network与物理学领域的关联是,它的设计思路模拟了电路结构。

「假设网络每个单元均由运算放大器和电容电阻组成,而每个单元就代表着一个神经元」。

在普林斯顿大学新闻发布会上,Hopfield表达了同样的观点。他认为,长远来看,新科学领域通常产生于,大量科学知识的交叉点上。

你必须愿意在这些「缝隙」中工作,找出你的知识局限性,以及让这些学科更丰富、更深入、更好被理解而采取的行动。

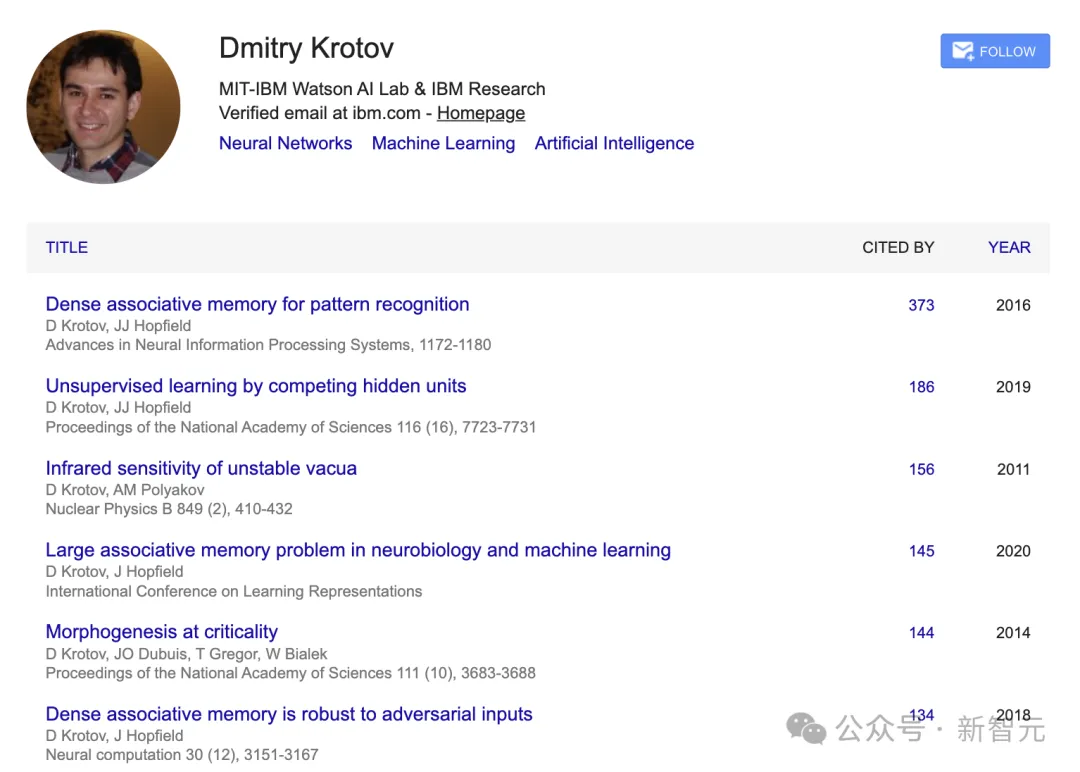

来自MIT-IBM实验室物理学家Dmitry Krotov分享了,Hopfield Network一个想法至少对三大学科产生了巨大的影响。

它们分别是,统计物理学、计算机科学和人工智能、神经科学。

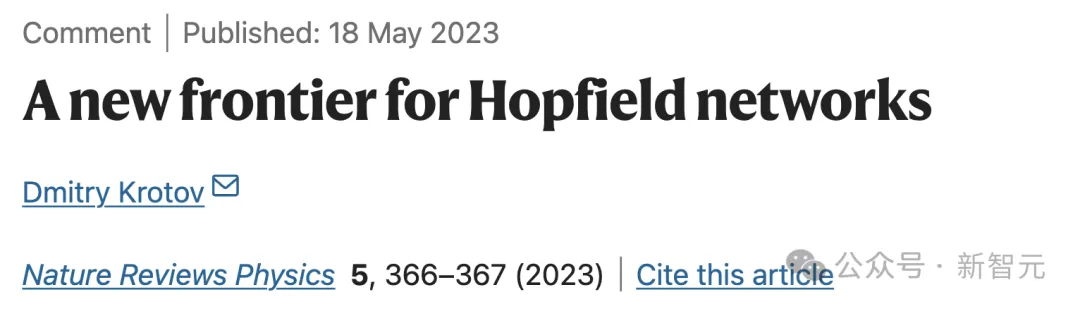

2023年,他曾发表了一篇Nature论文,对Hopfield Network在统计物理、神经科学和机器学习等多个学科中,进行了分析。

论文地址:https://www.nature.com/articles/s42254-023-00595-y

Krotov本人也与Hopfield合作过多篇研究,因此他对Hopfield Network工作的了解再熟悉不过了。

在统计物理学中,Hopfield Model成为最常被研究的哈密顿量(Hamiltonian)之一。哈密顿量在物理学中,描述了系统的总能量,是理解系统行为的关键。

这一模型已经催生了数以万计的论文、几本书籍。它为数百名物理学家进入神经科学和人工智能,提供了切入点。

就连诺贝尔奖官方给出了解释,机器学习模型,是基于物理方程式。

在计算机科学中,Hopfield Network终结了AI寒冬(1974-1981),并开启了人工神经网络的复兴。

Hopfield在1982年发表的论文,标志着现代神经网络的开始。

论文地址:https://www.pnas.org/doi/10.1073/pnas.79.8.2554

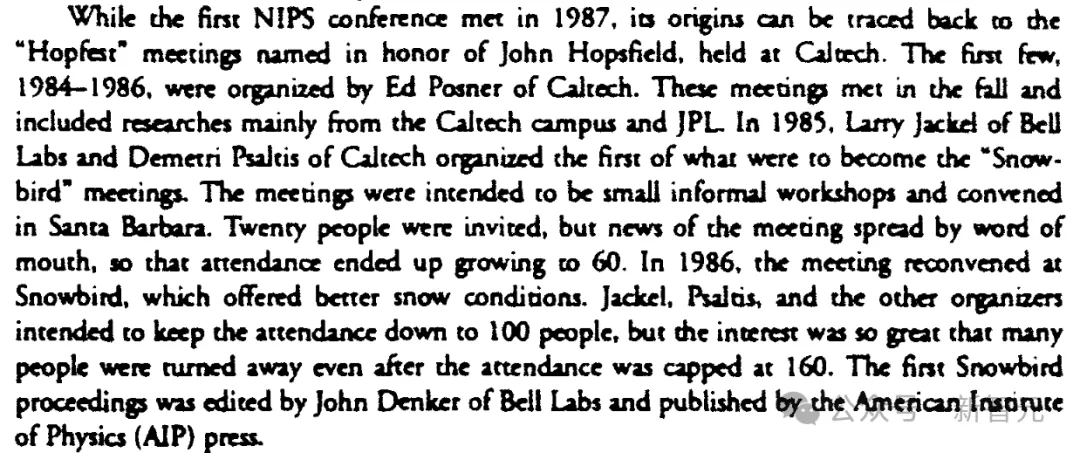

就连如今的顶会NeurIPS,起源可以追溯到1984-1986年在加州理工学院举行的被称为「Hopfests」的会议。

这个名字直接致敬了Hopfield,彰显了他的早期工作在神经网络研究中的核心地位。

John Moody在1991年的NeurIPS论文集中记录了这段历史。

另外,Hopfield Network成为限制玻尔兹曼机(Restricted Boltzmann Machine)发展的主要灵感来源。RBM在早期深度学习中,发挥着重要的作用。

还有基于能量的模型(Energy Based Model),代表着人工智能领域中一个重要的范式。

它也是从Hopfield基于能量和记忆的模型发展而来。

在神经科学领域,Hopfield Network成为后来许多计算记忆模型的基础。

它将记忆回忆概念化,即能量景观中滚下山坡的想法,已成为神经科学中的经典隐喻。

这次「诺奖风波」后,许多人也对如今的学科分类有了全新的思考。

不可否认的是,AI已经融入了全学科、全领域。

而这次诺贝尔物理学奖颁给AI,也是AI大爆发对于人类社会颠覆影响的一个真实写照。

文章来自于“新智元”,作者“编辑部 HYZ”。