最近这几天,让大模型具备控制计算机(包括电脑和手机)的相关研究和应用如雨后春笋般不断涌现。

先是 Anthropic 发布了能控制计算机的新版 Claude 3.5 Sonnet,之后荣耀 MagicOS 9.0 来了个全局智能体,再然后,昨天智谱发布了具备「全栈式工具使用能力」的 AutoGLM,同时华为也公布了一项可让 AI 像人类一样操作手机的新研究成果 LiMAC。

很显然,这股热潮完全没有要停息的意思。今天,有网友发现苹果已经默默发布了 Ferret-UI 的两个实现版本(分别基于 Gemma 2B 和 Llama 8B),这是苹果今年五月发布的一个可让 AI 理解手机屏幕的技术,详情参阅《让大模型理解手机屏幕,苹果多模态 Ferret-UI 用自然语言操控手机》。

来自 X 用户 Niels Rogge

不仅如此,微软也低调开源了他们的相关研究 OmniParser,这是一个基于大模型的屏幕解析工具,可将 UI 截图转换成结构化的元素;据称其解析和理解 UI 的能力达到了当前最佳水平,甚至超越了 GPT-4V。

有了这个工具,或许每个人都可以创建自己的计算机操控智能体了。

先来看看 OmniParser 的效果。对于一个用户任务:「将约翰内斯堡提供素食选择的餐厅保存到我的行程中」。

OmniParser 首先会解析 Tripadvisor 网页屏幕上的所有元素,然后它成功从中找到了「餐厅」选项。之后它点击(动作执行需要搭配其它模型)该选项,打开了一个搜索框。OmniParser 继续解析,这一次没有在屏幕上找到所需关键词,于是它在搜索框中输入了「约翰内斯堡」。再次解析后,它打开了相应的搜索项,展开了搜索结果。同样,继续解析,它成功定位到了素食选项,然后进行了勾选。最后,点击筛选出的第一个选项上的相应按钮将其收藏到行程中。至此,任务完成。

而如果你想看看能否进入布莱斯峡谷国家公园呢?OmniParser 也能助你轻松完成。

整体来看,OmniParser 的解析能力非常出色,过程也还算流畅。

我们知道,不同的操作系统和应用有着大不相同的交互界面。为了稳健地应对各种不同情况,屏幕解析模型需要:

OmniParser 正是为这一目的而生的。OmniParser 可基于用户任务和 UI 截图输出:(1) 解析后的截图,带有边界框和数值 ID,(2) 包含提取出的文本和图标描述的局部语义。下面展示了几个例子:

如果再搭配上其它可以基于 UI 采取行动的模型(比如 GPT-4V、Phi-3.5 和 Llama 3.2),便可以创造出可以理解并控制计算机的智能体。

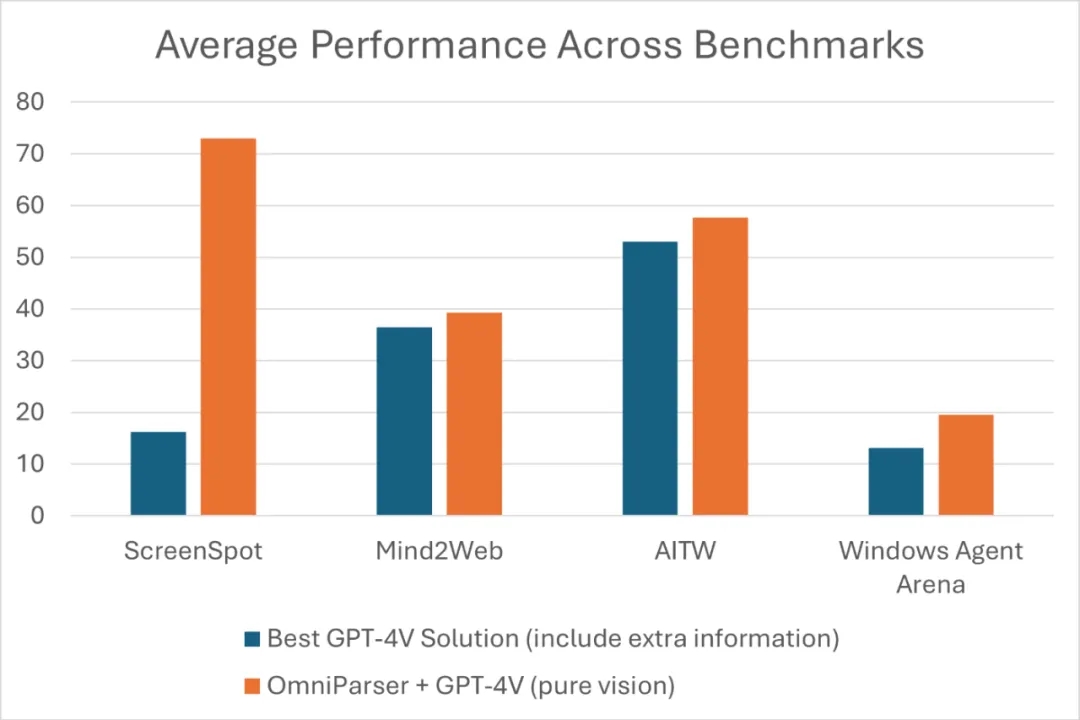

该团队用 GPT-4V 做了实验,结果发现 OmniParser 能大幅提升其为界面区域生成精准动作的能力。他们使用 OmniParser 和 GPT-4V 创建的一个智能体在 WindowsAgentArena 基准上达到了最佳水平。

收集和整理专用数据集 ——OmniParser 的开发始于创建两个数据集:

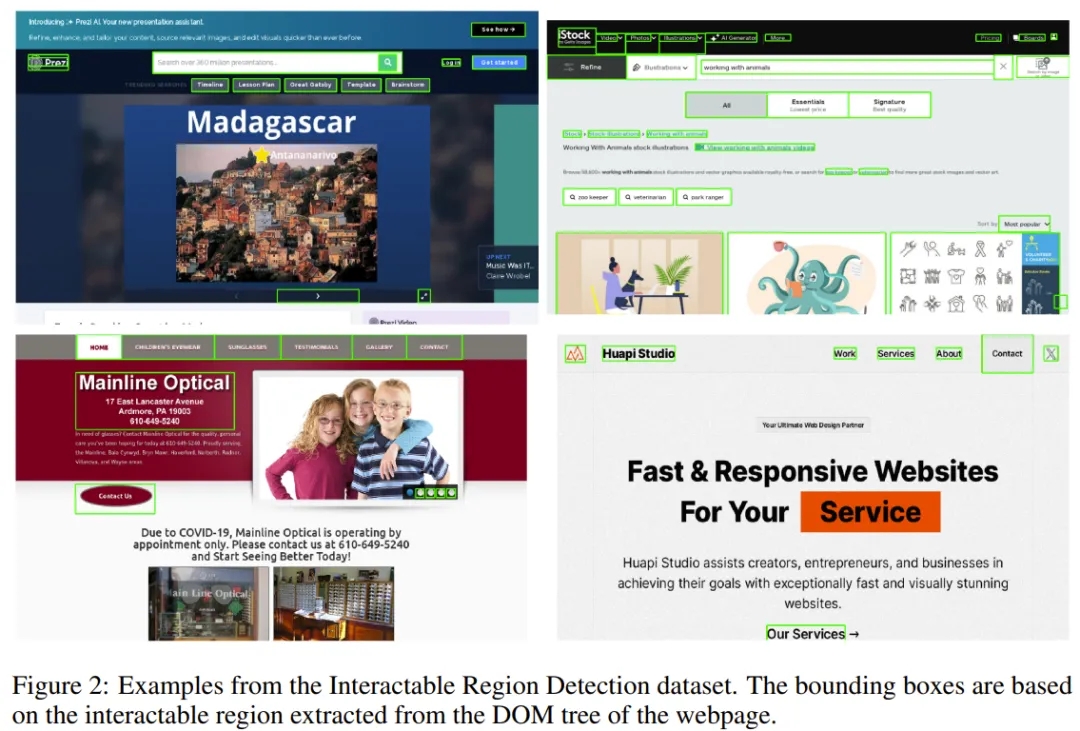

下面展示了可交互区域检测数据集的一些样本示例。

对检测和描述模型进行微调 ——OmniParser 使用了两个互补的模型:

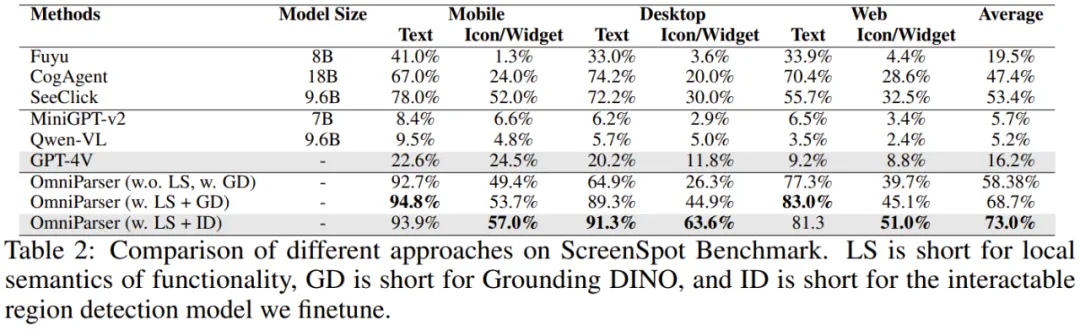

该团队对自己的方法进行了实验验证。结果发现,OmniParser 可大幅提升 GPT-4V 在 ScreenSpot 基准上的性能。

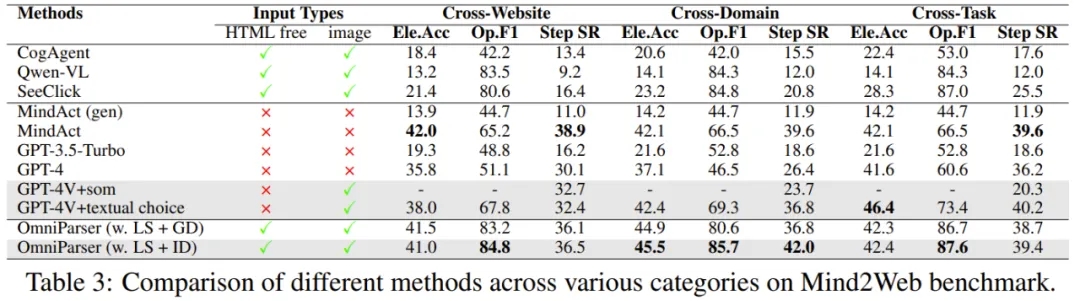

在 Mind2Web 基准上,OmniParser + GPT-4V 的表现也胜过可从 HTML 提取额外信息的 GPT-4V。

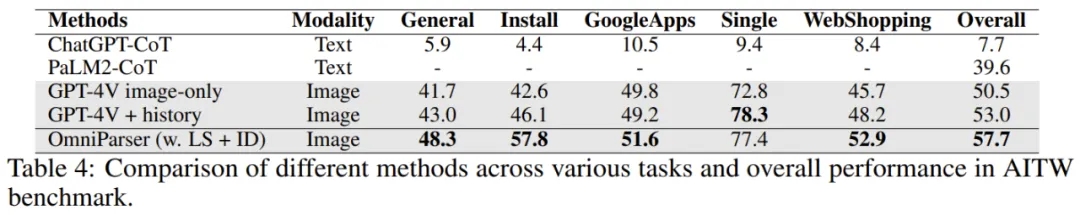

在 AITW 基准上,OmniParser 的表现优于一个经过增强的 GPT-4V—— 附带了一个使用视图图层训练的专用 Android 图标检测模型。

另外,其在新基准 WindowsAgentArena 上也达到了最佳性能。

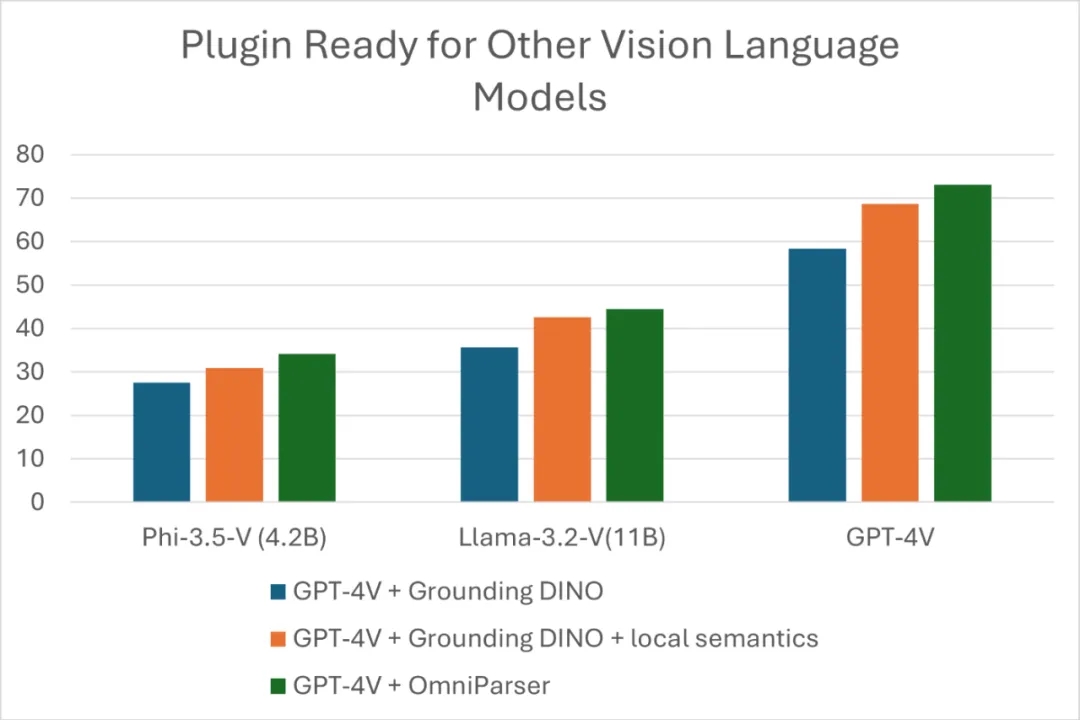

OmniParser 可作为当前各种视觉 - 语言模型(VLM)的插件。为了进一步演示这一点,该团队也测试了其与 Phi-3.5-V 和 Llama-3.2-V 的组合。

该团队表示:「我们希望 OmniParser 可以作为一种通用且易于使用的工具,在 PC 和移动平台上解析用户的屏幕,而无需依赖 HTML 和 Android 中的视图图层等额外信息。」

不知道如果将 OmniParser 与新版 Claude 3.5 Sonnet 的 Computer Use 结合起来会是什么效果?可能会像这位网友说的,很赞吧。

文章来自于微信公众号 “机器之心”,作者“Panda”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner