OpenAI研究副总裁(安全)翁荔(Lilian Weng),现身国内!

还首次在国内大型活动场合公开发表AI主题演讲。

先简单介绍一下,翁荔是OpenAI华人科学家、ChatGPT的贡献者之一。

北大毕业后,翁荔在2018年加入OpenAI,后来在GPT-4项目中主要参与预训练、强化学习&对齐、模型安全等方面的工作。

最著名的Agent公式也由她提出,即:Agent=大模型+记忆+主动规划+工具使用。

在今晚的2024Bilibili超级科学晚活动上,翁荔站在舞台上,以《AI安全与“培养”之道》为主题进行了演讲分享。

演讲并不十分深奥,主要以科普向为主,但深入浅出,介绍了AI安全相关种种问题。

她表示:

AI的安全不仅仅是研究者的责任,它需要每一个人的参与。

(以下是翁荔演讲全文,在不改变其原意的基础上略有删减。)

今天先与大家探讨一个既深刻又有趣的话题,「AI 安全」,以及「我们如何像培养下一代一样,培育出聪明又安全的人工智能」。

ChatGPT横空出世以来,AI技术如同搭乘了高速列车,迅速渗透并影响着我们。

AI每天都在变化,需要我们用心引导、教育,确保是更好的服务于人类,同时确保安全。

一个既安全又智能的AI,无异于将为我们的生活带来诸多裨益。

试想,一个洞察你生活习惯的智能家居系统,能根据你的需求自动调节室内温度、光线;或是一个时刻关注你健康状况的AI助手,能为你提领提供量身定制的健康AI。

这不仅能显著提升我们的生活质量,还能开辟新的就业领域,提升工作效率。

然而,这一切建立在AI安全的基础之上。

正如自动驾驶技术一样,它能极大地提升生活便利性,但是一旦出错,后果可能不堪设想。

随着AI应用日益智化与自主化,如何确保AI的行为符合人类价值观,真正做到以人为本,成为了AI 安全与对齐研究等核心议题。

人类在成长过程中会不断学习进步,但也会遇到成长的烦恼。

同样的,AI可能因为偏见而变得狭隘,也可能因为对抗性攻击而被恶意质疑,AI安全和对齐研究才能使AI成长过程更加顺利。

让我们以健康领域为例。

很多疾病研究的数据往往以男性的群体为主,这可能导致AI在处理女性的健康问题时风险评估不准确。

此外,数据本身也有可能存在偏见。

比如有研究表明,女性心脏病症状更容易被归结成焦虑等心理问题,而造成诊断遗漏。

因此,我们需要通过对AI安全和对齐研究来减少偏见。

AI 学习的基础是数据,数据是它的食物。

要想让AI变得聪明可靠,我们必须确保它营养均衡,也就是提供它多样、全面、正确的数据,帮助它能够正确地理解这个复杂的世界,并减少偏差。

在使用人类标志的数据时,我们可以依赖于群体智慧,也就是同一个数据点被多人标注。

有意思的是, 1907年的一篇自然科学杂志中的文章,作者追踪了一场年度展览会上的一个有趣的有奖竞猜。

展览会上,人们选出一头肥牛,让大家来猜测牛的重量,最接近真实数据的人将获得大额的奖金。

作者发现,「最中间值」往往是最接近真实数据。

这个数估计值也被称为the voice of the people。

在这篇近120年前的科学文章中,作者总结道:“我认为这个结果比人们预期的更能证明民主判断可信度。”

这也是最早提到群体智慧如何发生作用的科学文件。

而至于如何把高质量标注的数据给AI,则基于人类反馈的强化学习(RLHF)起到了关键作用。

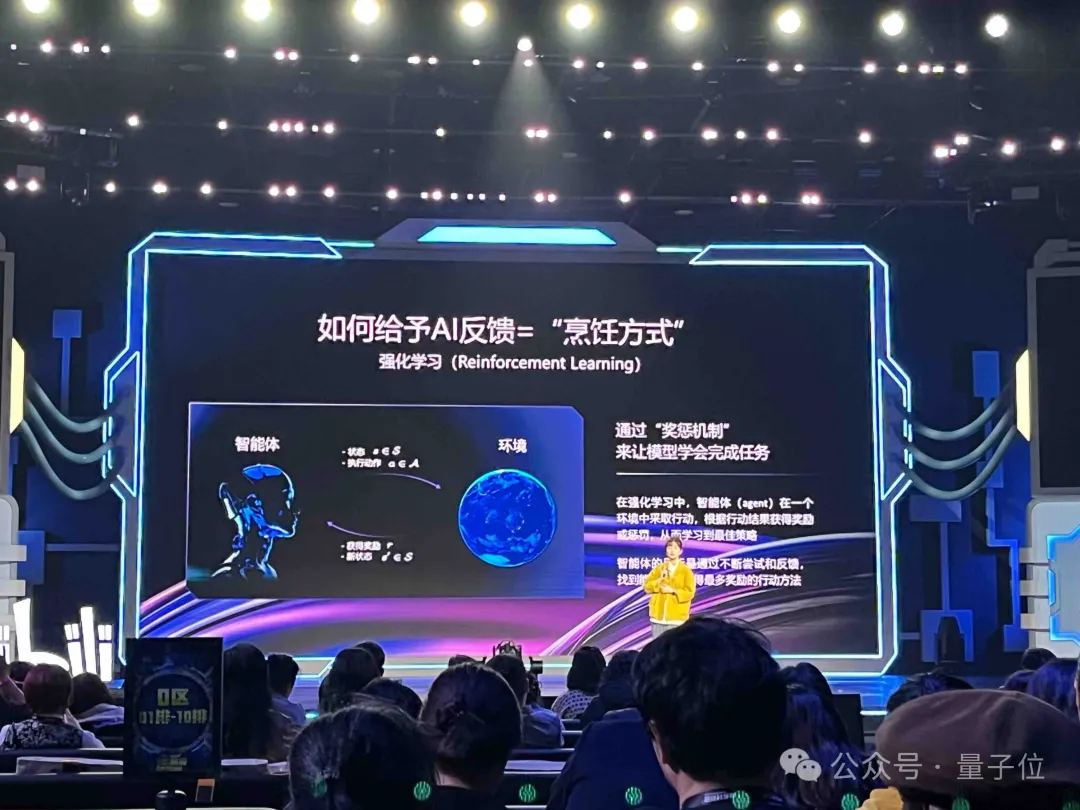

在了解RLHF之前,我们快速了解一下什么是强化学习(RL)。

强化学习是一种机器学习方法,它主要通过奖惩机制来让模型学会完成任务,而不是依靠直接告诉模型如何去做这件任务。

想象一下,就好像你训练小狗,如果小狗做对了一个动作,比如坐下,你就给他一块骨头饼干;做错了就不给奖励。

这样,小狗就会因为想吃到更多的饼干而学会如何正确地坐下。

同理,AI也在这种奖惩机制中学习,通过不断的尝试并得到反馈,找到最佳的服务策略。

一个早期的研究表明,强化学习能利用少量人类反馈,快速有效地教会智能体做复杂的动作,学会如何后空翻。

同样的方法也可以用于训练大语言模型(LLM)。

当我们看到针对同一问题的不同AI回答时,我们可以告诉模型哪一个回答更好、更正确、更符合人类价值观,这样我们就像家长教育孩子一样,调节AI的学习过程。

此外,我们还可以使用模型本身作为AI输出质量的评分者。

比如在Antropic发表的《Constitutional AI》中,模型就通过对自己行为的我评价进行改进;或者在对齐强化学习中,我们可以制定非常详细的行为规则来告诉AI,何时拒绝用户的请求,如何表达同理心等等。

然后我们在强化学习的奖励机制中,非常精准地给予相应的评分奖励。

这个过程中,一个更加强大的AI有能力更精准地判断它是否遵从了人类的价值观和行为准则。

强化学习技术就像一把钥匙,帮助我们打开AI高质量学习和发展的大门。

在培养AI更懂我们的过程中,普通人也能发挥重要的作用。

在文档写作上,我们可以采用两个小技巧。

首先,设定详细的背景和角色思想,像导演为演员准备剧本一样让AI在丰富的情境中,捕捉我们的意图。

其次,精心挑选关键词,构建逻辑清新的文档结构,使文档既美观又实用。

在视频音乐制作领域,我们可以通过使用专业术语来引导AI,比如黄金分割构图或和弦进行,将创意转换为现实。

同时,别忘了感情的投入,因为这是赋予作品灵魂关键词。

简而言之,通过细致的指导和情感的融入,我们可以帮助AI创作出既丰富又富有感染力的作品。

在《西游记》中,孙悟空有紧箍咒约束行为,我们应该给AI模型也戴上了紧箍咒,也就是教会 AI 安全基本准和道德标准,让其遵守行为规范,以人类利益为先,成为我们贴心的伙伴,而不是冰冷的机器。

让AI学习基本原则和道德准则,可以使模型在面对复杂问题时运用推理得出正确的结论。

比如在OpenAI最近发表的Open-o1-preview模型中,我们通过思维链(CoT)推理加强了模型的可靠性,使得模型可以更好地抵抗越狱攻击。

扩展性研究(scalable oversight)在AI对齐研究中也非常重要。

随着AI模型扩大,需要结合自动化工具和人类监督有效的行为,确保它朝着正确的方向发展。

在一组公开研究中,我们用监督学习训练语言模型对网络文本摘要进行批评,比如提供“这个摘要非常准确”,或者“这个摘要遗落要点”。

相比对照组,我们发现有AI帮助的标注员比没有帮助的能多找出摘要中约50%的问题,而且多数参考了模型提供的内容。

总之,给AI设定标准并进行有效监督,可以提升它对人们的帮助。

AI的安全不仅仅是研究者的责任,它需要每一个人的参与。

以B站为例,这个充满活力的社区聚集了众多AI爱好者、创作者,我们在这里分享便捷、讨论问题,甚至监督AI的表现,共同影响着 AI 的成长。

我们每个人都应该成为AI的大家长。

AI 技术是一把双刃剑,它带来的便利和挑战并行,我们的参与至关重要。

让我们携手培养出一个既聪明又负责的AI伙伴。

感谢大家的聆听,希望今天的分享激发大家对AI安全的热情兴趣,也感谢B站直播这个平台。

让我们共同为AI的未来贡献力量,谢谢。

然而,OpenAI在安全这个方向的前进,却一直备受争议。

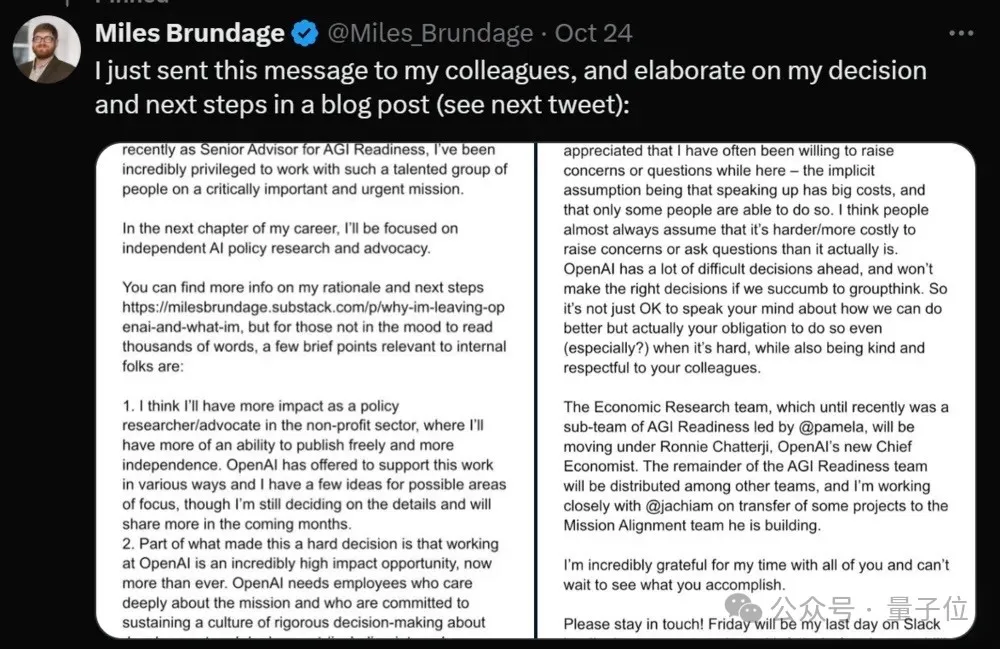

上周,一则“OpenAI解散AGI筹备团队”的消息传遍全球。

源头是AGI Readiness团队负责人Miles Brundage宣布离职。

他表示,已在OpenAI完成所有工作,在外部工作将产生更大的影响。

未来他计划在OpenAI之外继续从事该领域研究工作,并希望减少偏见。

这不是OpenAI安全方面离开的唯一一个重要人物。

今年上半年,OpenAI联合创始人、首席科学家Ilya Sutskever离职,他带领的“超级对齐团队”随即解散。

该团队成立于2023年7月,OpenAI给了它一个使命:

用20%的算力,在未来4年内解决控制超级智能AI的核心技术挑战。

Ilya是这么解释自己离开OpenAI的原因的:

制造比人类更聪明的机器本身就是一项危险的事业。

OpenAI代表全人类肩负着巨大的责任。

但在过去几年里,安全文化和流程已经让位于闪亮的产品。

毅然离开的还有“超级对齐”团队联合负责人、安全主管Jan Leike——他最终选择跳槽到OpenAI最强竞对、Claude背后团队Anthropic,继续超级对齐工作。

离职后,Leike对外爆料,最近几年OpenAI已经不惜内部文化,把“吸引眼球的产品”放在安全准则之前。

现在,翁荔无疑是是最前沿AI实验室的安全总负责人了。

OpenAI的安全之路,又将走向何方?

文章来自于微信公众号“量子位”,作者“衡宇”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales