今天,我们很高兴开源“强大”、“多样”、“实用”的Qwen2.5-Coder全系列模型,致力于持续推动Open CodeLLMs的发展。

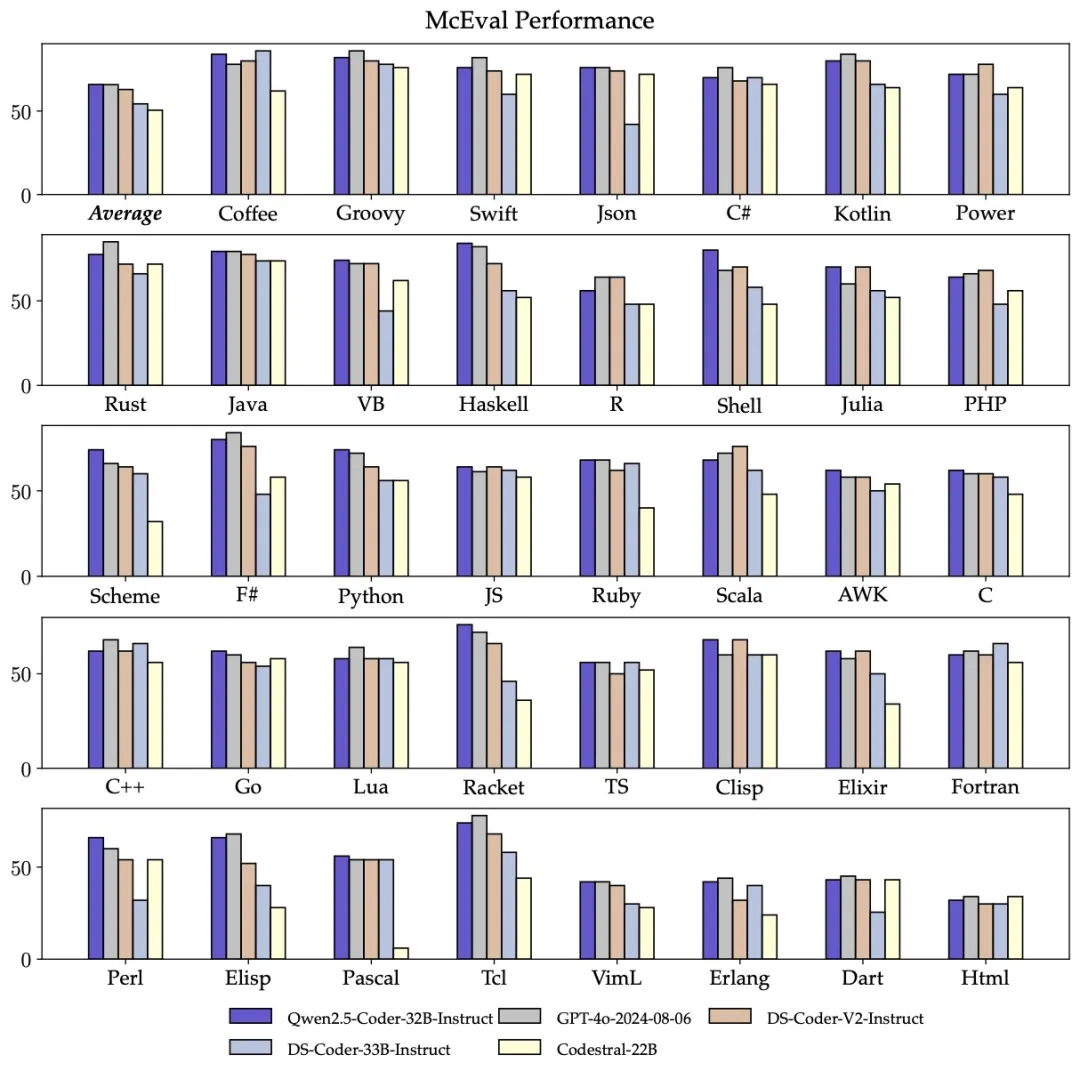

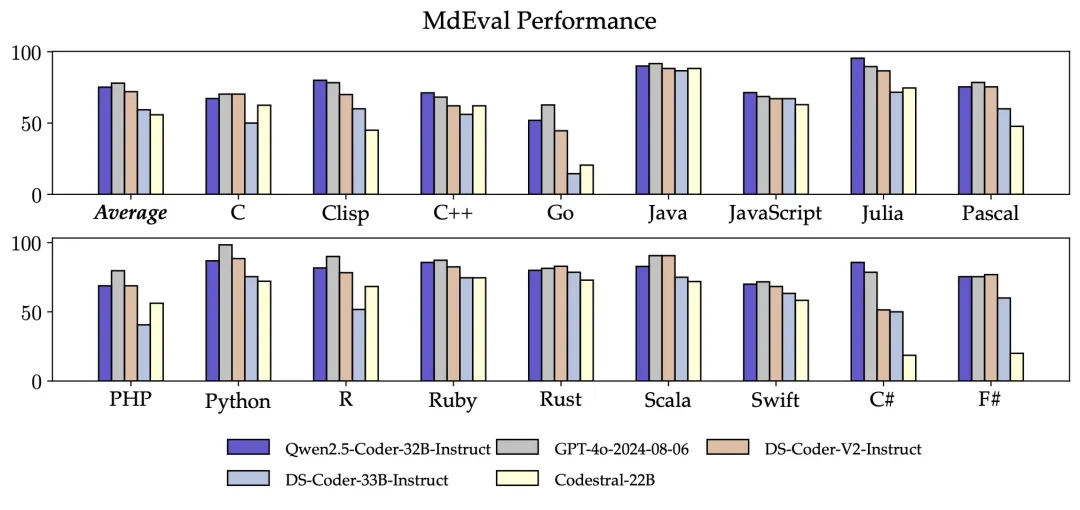

另外,Qwen2.5-Coder-32B-Instruct的多编程语言代码修复能力同样令人惊喜,这将有助于用户理解和修改自己熟悉的编程语言,极大降低陌生语言的学习成本。

与McEval类似,MdEval是多编程语言的代码修复基准,Qwen2.5-Coder-32B-Instruct在MdEval上取得了75.2分,在所有开源模型中排名第一。

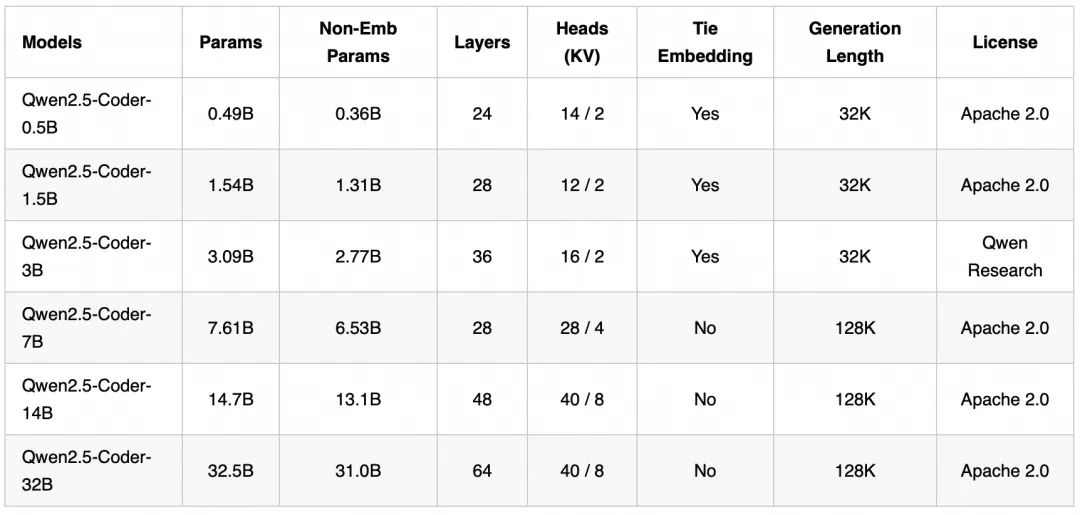

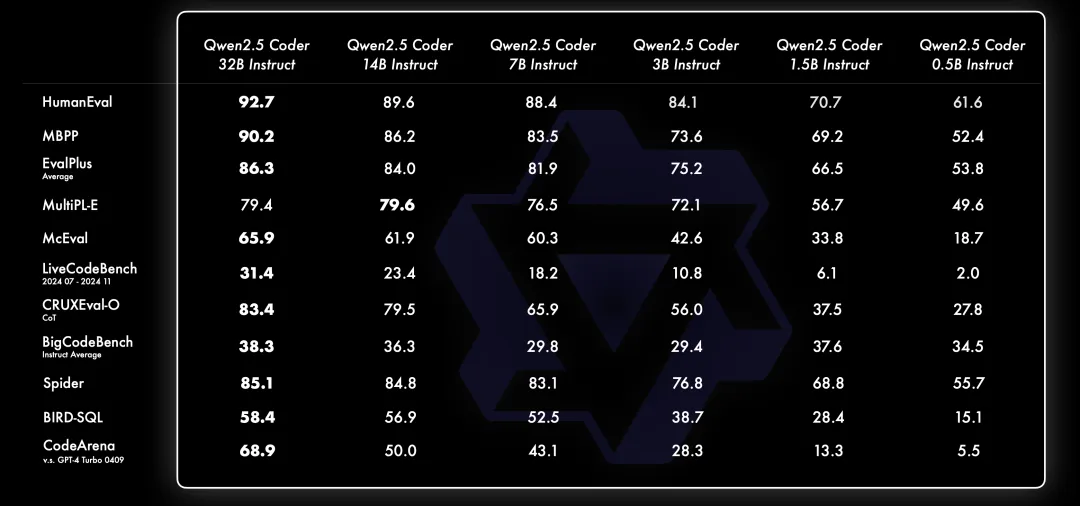

Qwen2.5-Coder开源模型家族包含0.5B、1.5B、3B、7B、14B、32B六个尺寸,不仅能够满足开发者在不同资源场景下的需求,还能给研究社区提供良好的实验场。下表是详细的模型信息:

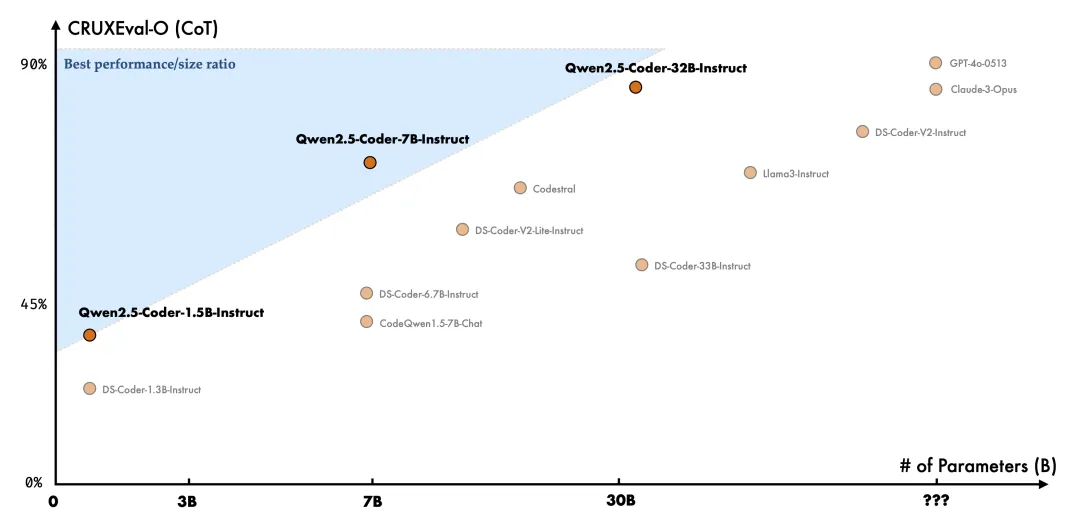

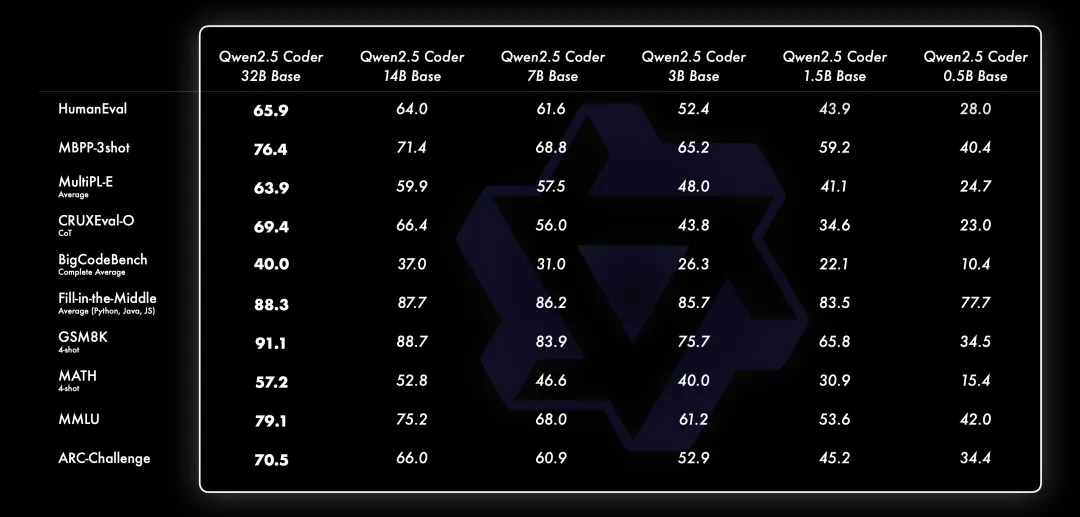

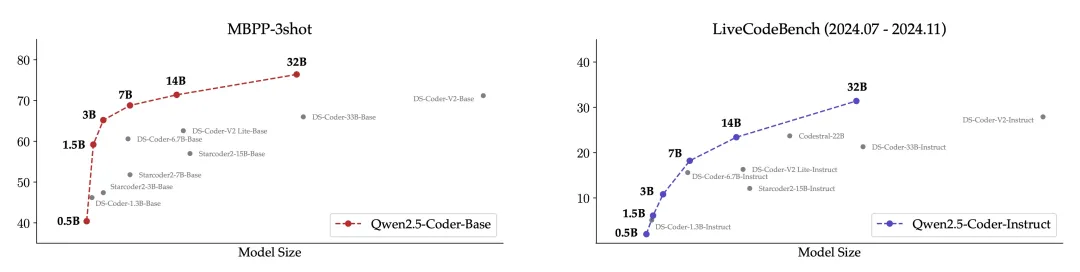

我们一直相信Scaling Law哲学。我们评估了不同尺寸的Qwen2.5-Coder模型在所有数据集上的表现,以验证Scaling在Code LLMs上的有效性。

对于每一个尺寸,我们都开源了Base和Instruct模型,其中,Base模型可作为开发者微调模型的基座,Instruct模型是可以直接聊天的官方对齐模型。

下面是不同尺寸Base模型的表现:

下面是不同尺寸Instruct模型的表现:

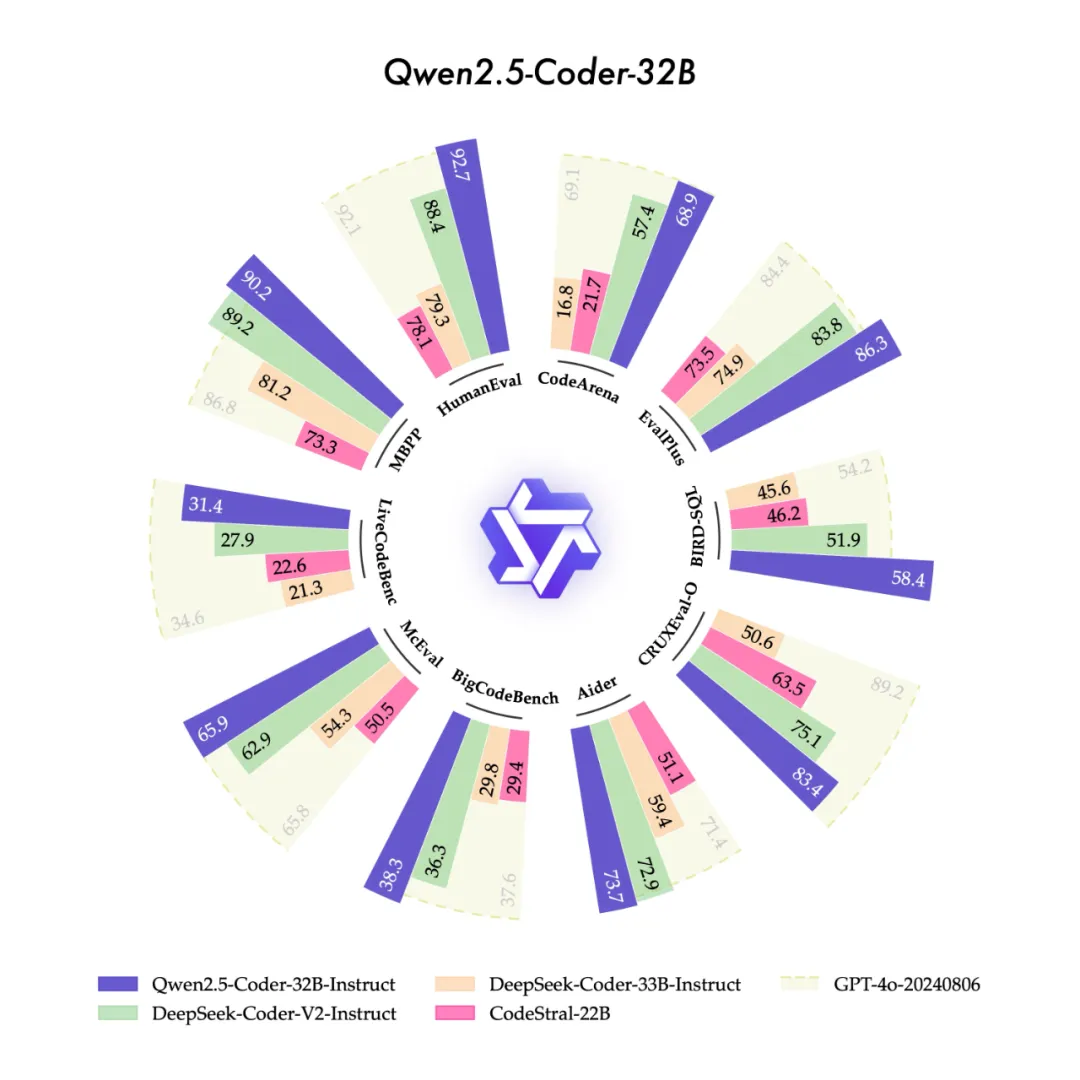

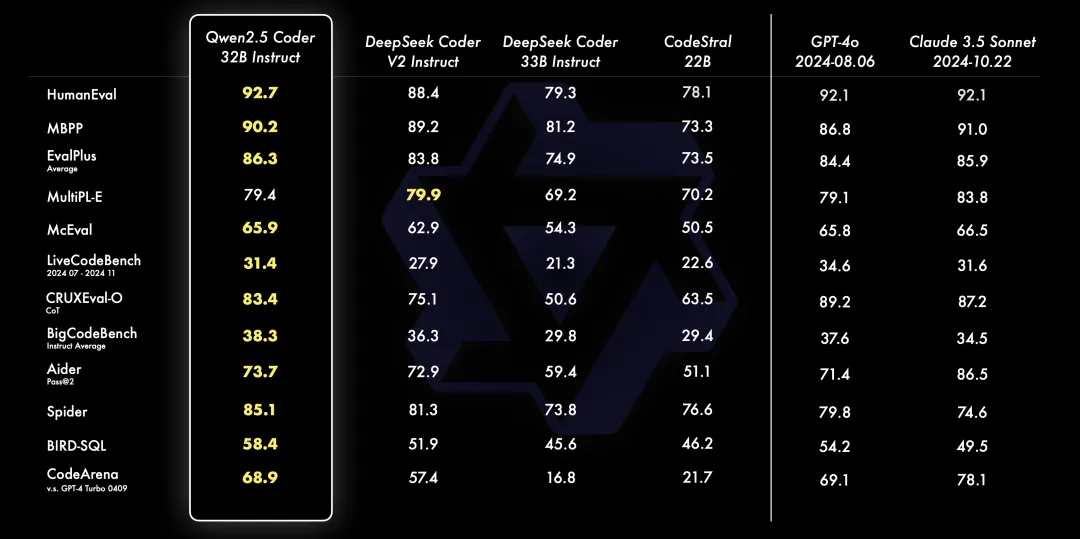

为了更加直观,我们展示了不同尺寸Qwen2.5-Coder模型和其他开源模型在核心数据集上的对比。

模型尺寸和模型效果之间存在预期中的正相关关系,并且,Qwen2.5-Coder在所有尺寸下都取得了SOTA表现,这鼓励我们继续探索更大尺寸的Coder模型。

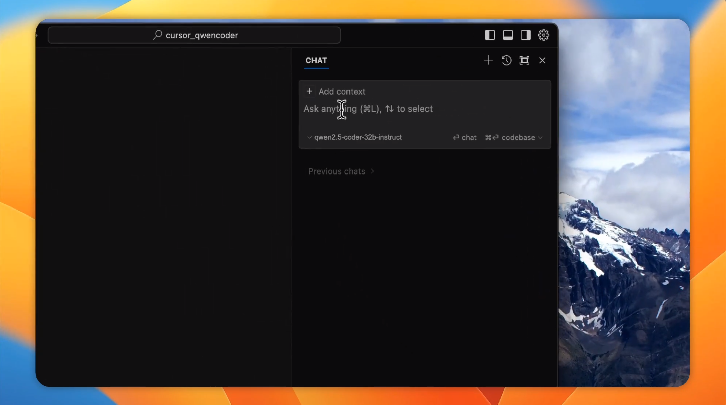

实用的Coder一直是我们的愿景。为此,我们探索了Qwen2.5-Coder模型在代码助手和Artifacts场景下的实际应用。

当Qwen2.5-Coder遇见Cursor:

智能代码助手已经得到广泛应用,但目前大多依赖闭源模型,我们希望Qwen2.5-Coder的出现能够为开发者提供一个友好且强大的选择。

下面是Qwen2.5-Coder在Cursor场景下的一个例子:

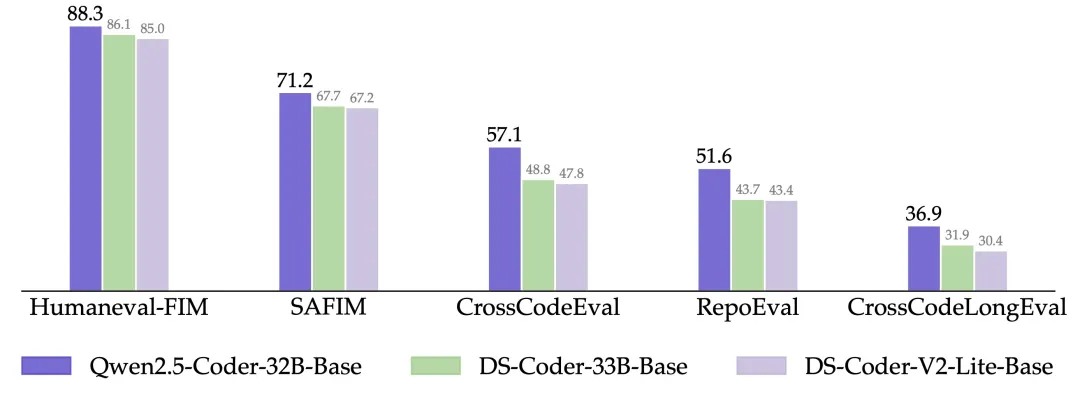

另外,Qwen2.5-Coder-32B在预训练模型上就展现出强大的代码补全能力,在Humaneval-Infilling、CrossCodeEval、CrossCodeLongEval、RepoEval、SAFIM等5个评测集上都取得了SOTA表现。

为了保持公平对比,我们将最大序列长度控制在8k,采用Fill-in-the-Middle模式进行测试。在CrossCodeEval、CrossCodeLongEval、RepoEval、Humaneval-Infilling4个评测集中,我们评估了生成内容与真实标签是否绝对相等(Exact Match);在SAFIM中,我们采用1次执行成功率(Pass@1)进行评价。

当Qwen2.5-Coder遇见Artifacts:

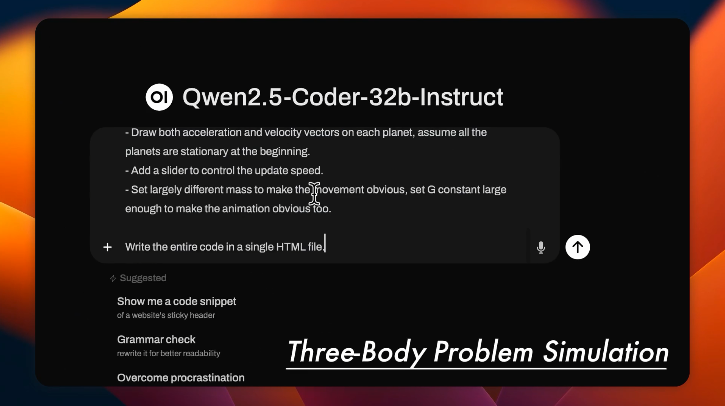

Artifacts是代码生成的重要应用之一,能够帮助用户创作一些适合可视化的作品。我们选择Open WebUI探索Qwen2.5-Coder在Artifacts场景下的潜力,下面是一些具体的例子:

(Lissajous Curve,利萨茹曲线)

(Emojis dancing,跳舞的Emoji)

(Drafting a resume,写简历)

(Three-Body Problem Simulation,三体问题模拟)

我们即将在通义官网(tongyi.aliyun.com)上线代码模式,支持一句话生成网站、小游戏和数据图表等各类可视化应用。欢迎大家体验!

Qwen2.5-Coder-0.5B、1.5B、7B、14B、32B模型均采用Apache 2.0许可证,3B模型使用“Research Only”许可。

相信我们这次的发布能够真正帮助到开发者,和社区一起探索更多有趣的应用场景。另外,我们正在深入探索以代码为中心的强大推理模型,相信很快能和大家见面!

文章来自于微信公众号 “通义千问Qwen”,作者“ 爱开源的 ”

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner