就在刚刚,OpenAI治理研究员Richard Ngo宣布离职。

在OpenAI从事人工智能预测和治理工作三年后,我刚刚在Slack上发布了这条离职的消息。

内容并没有什么特别惊讶的地方,但你应该比大多数类似的消息更字面地理解它——我尽量只说了我直白相信的事情。

Ngo表示,他对过去一年里发生的事件有很多未解的问题,这使得他更难相信自己的工作能在长期内造福世界。他逐渐意识到,想要实现OpenAI的使命——让AGI良好发展,是多么困难。

Ngo自2021年起加入OpenAI,之前曾在Google DeepMind担任AI安全研究员。

近来,OpenAI中专注于AI安全的员工接连出走,Ngo是最新的一位。

OpenAI研究科学家、德扑之父Noam Brown送上了祝福。

前OpenAI员工(今年8月离职)回忆道,自己是通过Ngo「AGI安全基础」课程才接触到AI安全的,并祝他未来一切顺利。

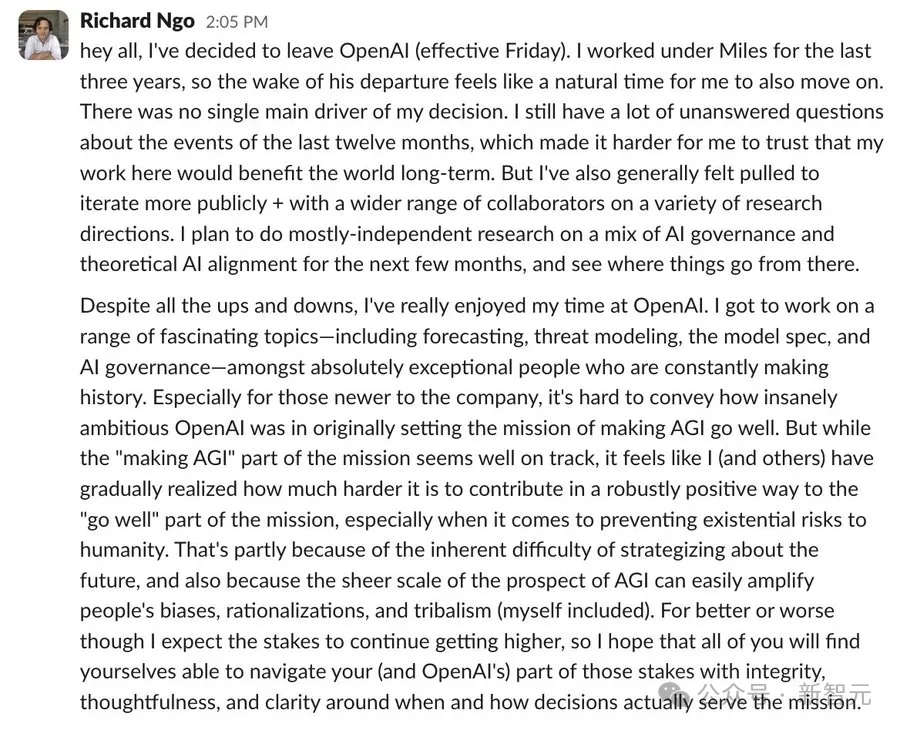

大家好,我决定离开OpenAI(生效日期为星期五)。

在过去的三年里,我一直在Miles的领导下工作,因此在他离开之后,很自然,我似乎也该离开了。没有一个单一的主要因素促使我做出这个决定。

对于过去一年发生的事情,我依然有很多未解的问题,这让我更难以相信我的工作能长期为世界带来正面影响。我也一直感觉自己更倾向于公开地进行更多的迭代,并与更多合作者一起探讨多种研究方向。

接下来的几个月里,我打算主要进行独立研究,内容包括AI治理和理论性AI对齐问题的结合,然后再看看未来的方向如何。

尽管经历了许多波折,我真的很享受在OpenAI的时光。我有机会参与许多令人着迷的议题,包括预测、威胁建模、模型规格和AI治理,并与一群不断创造历史的、卓越的人一起工作。

当我面对那些新加入公司的成员时,我很难向他们传递OpenAI最初的雄心壮志:设定了让AGI良好发展的使命。

虽然「发展AGI」这一部分的任务似乎已在正确轨道上,我(和其他人)却逐渐意识到,想要对「良好发展」这一部分的任务作出积极贡献,远比预期的要困难得多,特别是需要预防它对人类生存的威胁。

部分是因为预测未来本身就很困难,同时由于AGI前景的巨大规模,容易放大人们的偏见、合理化和部落主义倾向(包括我自己)。

PS:

合理化(rationalization)是心理学和行为经济学中的一个概念,指的是人们在面对自己无法接受的行为、想法或决定时,通过给自己提供看似合理或合情的解释来减轻内心的不适感或认知失调。简单来说,合理化是一种防御机制,人们会为自己的不理性行为或决策找到合适的理由,以便自己能够接受或不感到内疚。这种心理机制帮助人们减轻认知冲突,但也可能导致不诚实或不理性的行为得以持续。

部落主义(tribalism)是一种社会现象,指的是人们对某个特定群体的强烈认同感和忠诚感,并因此对其他群体或文化产生排斥、敌视或竞争的态度。部落主义不仅限于传统的部落或民族,还可以表现在各种现代社会群体中,如政治派别、宗教信仰、公司文化、体育队伍支持者等。

无论好坏,我预计风险将会继续加大,因此我希望你们都能以正直、深思熟虑的态度,以及清晰的判断,来应对你们(以及OpenAI)在这些风险中的角色,明确何时以及如何做出的决定才能真正服务于我们的使命。

继许多专注于AI安全的员工离职OpenAI后,Richard Ngo的离职特别具有象征意义。

要知道,他是AI安全社区中一个有影响力的声音,自2018年以来一直致力于AI安全研究——而ChatGPT是在2022年底才开始风靡全球。

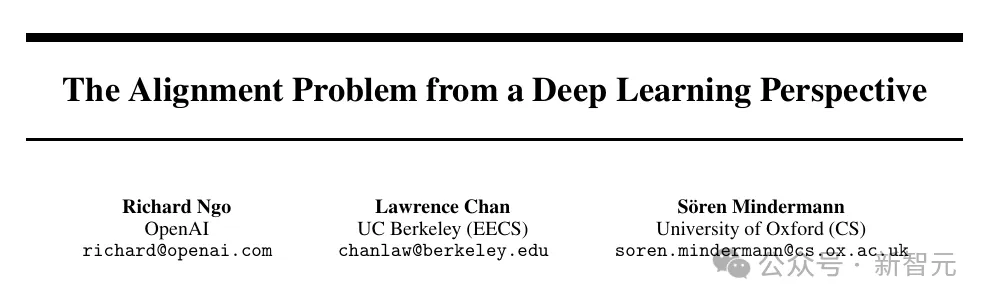

他是论文《The Alignment Problem from a Deep Learning Perspective》的共同作者,该论文已在ICLR上发表。

论文地址:https://arxiv.org/abs/2209.00626

他还收集了很多网络上的学习资料,编成了一系列「AI Alignment」的课程。

课程地址:https://course.aisafetyfundamentals.com/alignment

Ngo还是一个非常具有人文气息的科技从业者。这也不难解释他对OpenAI初心的坚守,以及对AI安全未来的担忧。

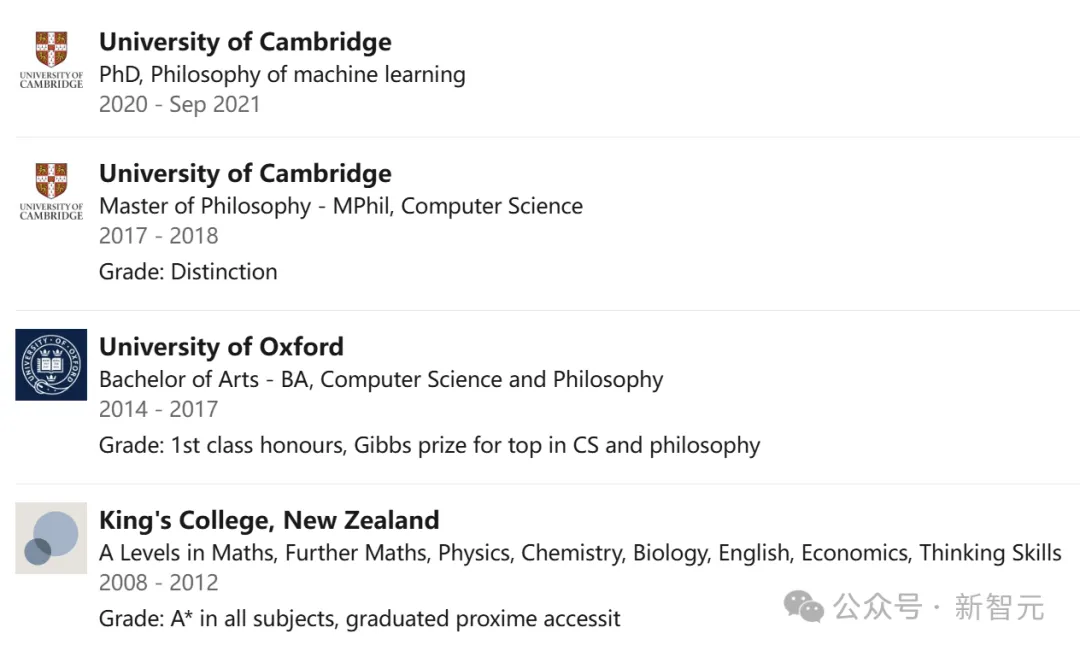

他在剑桥大学获得了机器学习哲学的哲学博士学位(2020–2021),并在同校获得了计算机科学的哲学硕士学位(2017–2018)。此外,他还在牛津大学获得了计算机科学与哲学的文学学士学位(2014–2017)。

他还在博客里撰写「AI Autofiction」(AI自传小说),在其中描述了从未来AI的角度来看世界可能是什么样子。

博客地址:https://www.narrativeark.xyz/t/ai-autofiction

近来,许多专注于AI安全的员工都先后离职OpenAI。

OpenAI七年元老、安全副总裁Lilian Weng,于上周宣布离职。

OpenAI六年元老、研究主管Miles Brundage,同时也是Ngo的上司,于上个月离职。

再往前追溯,今年早些时候,OpenAI的超级对齐共同负责人Ilya Sutskever和Jan Leike也离开了公司。

Leike曾表示,「OpenAI的安全文化和流程已被耀眼的产品所取代」。

许多其他专注于安全的员工,包括William Saunders、Leopold Aschenbrenner、Pavel Izmailov、Collin Burns、Carroll Wainwright、Ryan Lowe、Daniel Kokotajlo和Cullen O’Keefe等,也都相继离职。

参考资料:

https://x.com/RichardMCNgo/status/1856843040427839804

https://www.transformernews.ai/p/richard-ngo-openai-resign-safety

文章来自于“新智元”,作者“静音”。