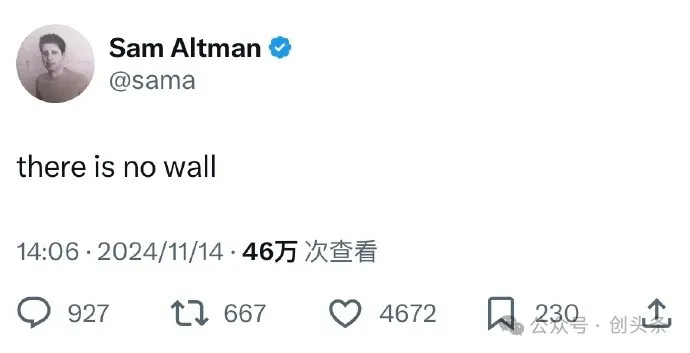

OpenAI奥特曼前天发了条神神秘秘的推文,“there is no wall”。

最近以来,AI 大模型训练陷入瓶颈的讨论沸沸扬扬,甚至引起了行业性恐慌。

作为行业灯塔,这被认为是奥特曼针对此议题的回应,大模型训练“没有边界”。

此前,美国老牌IT媒体《 The Information》报道称,OpenAI 下一代旗舰模型“Orion”(猎户座)未能达到公司预期的性能。相较于 OpenAI 现有模型,Orion 被视为“没有重大飞跃”。而 GPT-4 则显著优于 GPT-3.5。

该报道称,GPT 进化速度放缓的部分原因是,用于预训练的文本和数据供应减少。

根据 OpenAI 员工和研究人员的说法,公司现在难以获得高质量的培训数据,现有大模型开发已经耗尽了网站、书籍和其他用于预训练的公开文本。

为了解决这些问题,OpenAI 甚至成立了一个基础团队,以研究如何在新训练数据不断减少的情况下,继续改进其模型的新策略。

据Bloomberg 报道,不光OpenAI,Google 的Gemini 软件版本也未达到内部期望,Anthropic 则干脆推迟了备受期待的 Claude 模型 3.5 Opus 发布时间表。

“关键在于数据的质量和多样性,而非数量,” 前微软副首席技术官 Lila Tretikov 对此表示,“我们可以合成生成大量数据,但在没有人工指导的情况下,难以获取独特且高质量的数据集,尤其是在涉及语言的情况下。”

OpenAI前首席科学家Ilya也认同这一判断。

他在接受路透社采访时表示,通过扩展预训练——即在训练 AI 模型时使用大量未标注数据来理解语言模式和结构的阶段——取得的效果已经触及瓶颈。

要知道,Ilya 可是在预训练阶段通过大数据与大算力来实现AI进化的最早倡导者。

更有行业研究预计,如果大型语言模型(LLM)保持现在的发展势头,预计在2028年左右,已有的数据储量将被全部利用完。

届时,基于大数据的大模型的发展将可能放缓甚至陷入停滞。

《Nature》杂志的一篇专业研究文章对此详细论述称,当AI 大模型被训练在由先前版本的AI生成的数据上时,很快就会导致模型产生无意义的内容。这种现象被称为“模型崩溃”。这是与人类衍生训练数据耗尽之外,阻碍大型语言模型(LLMs)改进的另一个重要原因。

Anthropic创始人Dario Amodei 则是反对论者,他公开表示,预训练的扩展法则(Scaling Laws)来自经验而非客观规律,它“仍然会继续存在”。

他还说,公司在今年将花费 1 亿美元训练一个前沿模型,未来数年内这一数额将攀升至 1000 亿美元。

无独有偶。

前两天百度世界大会上,李彦宏也在演讲中表示,“基础模型两年一个大的版本迭代,是比较合适的节奏”。

甚至上个月还有报道指出,国内 AI“ 六小虎”中,至少有两家要放弃大模型预训练。

这与之前国内大模型间争相发布新版本的状态相比,确实有了反差。

如何实现新的跃升?

比如离开OpenAI,创办SSI后,Ilya 在开始研究“传统扩展”的替代方法。

“2010年代是扩展定律的时代,现在我们又回到了奇迹和发现的时代。每个人都在寻找下一个东西。”在他看来,“现在,在正确的方向扩展,比什么都重要。”但他并没有对外透露具体方向。

2022年11月30日,OpenAI发布ChatGPT,开启这一波AI大浪潮。

至今刚好两年时间。

可见的事实是,整个行业已从开始的炸裂、兴奋,进入冷静、平稳期,甚至不乏迷茫。

而除了数据问题,面临的其他问题实际上更加复杂。

比如算力问题、能源问题、商业模式问题、社会伦理问题、社会治理,还有地缘竞争问题等,每一个都让这头一往无前的技术巨兽,从不同角度开始停下来反思,以确定下一步更好的往哪里去。

最近一个值得关注关注的插曲是,Epoch AI联合60多位顶尖数学家提出了数学基准FrontierMath,给头部AI来了次统考。

结果是,Gemini 1.5 Pro、Claude 3.5 Sonnet,及GPT-4o与o1-preview 准确率都都不到2%。面对未被学习过的题库,它们都没能证明其高级推理能力。

当然,乐观派还是一如既往坚定。

最近一次接受YC总裁兼CEO Garry Tan访问时,奥特曼表示,AGI将在2025年左右降临,ASI 将在几千天内到来。

他还强调称,计算的成本将持续降低,而随着模型性能的不断提升,AI的价值也将持续攀升,“高质量AI的成本最后都可以降至趋近零”。

文章来自于微信公众号“创头条”,作者“ 沐风”