价格暴涨 6 倍,程序员已经用不起 Claude 了

价格暴涨 6 倍,程序员已经用不起 Claude 了明明可以去抢,他们却给了你更好的模型?

明明可以去抢,他们却给了你更好的模型?

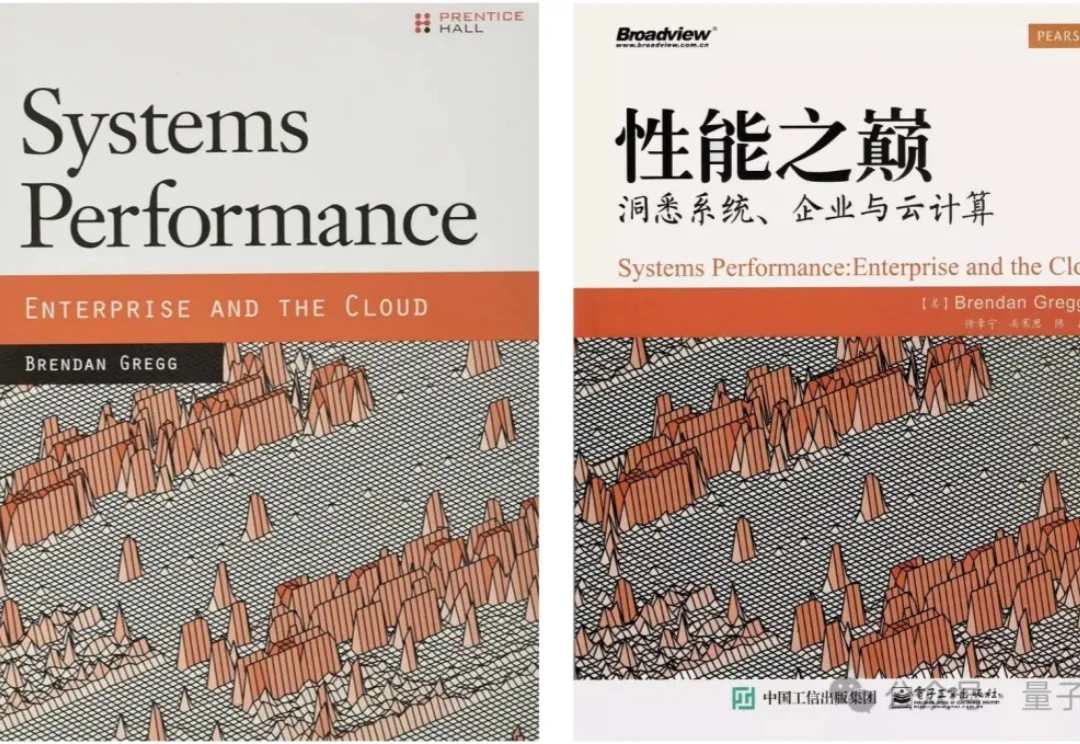

系统性能优化领域顶级专家Brendan Gregg,正式官宣加入OpenAI。

Contrary 是一家成立于 2018 年的美国风险投资公司,由 Eric Tarczynski 创办,自成立以来,其以“人才驱动+研究驱动”为核心方法论,在全球顶级高校铺设了庞大的人才网络,通过识别最优秀的年轻技术人才来发现投资机会。

春晚还没来,但机器人春晚已经刷屏了(doge)!

近日,硅谷知名创业孵化器 Y Combinator 发布了 2026 年春季创业赛道指南(RFS)。作为全球最具影响力的创业加速器,这一传统旨在让创业者窥见 YC 希望他们解决的下一代问题。

“过去,创始人对自己的公司忠心耿耿。如今,只要价钱合适,任何人都可以被挖走。”

大家发现了吗?这个马年春节,一场甚至比春运还要拥挤的「AI 春节大战」早已硝烟弥漫。

马年未至,春节档新模型已经蓄势待发。

一位在硅谷摸爬滚打30年的老兵,花了4个月时间,跟Anthropic近40人深聊后,他揭示了一个残酷的公式:工作量碾压人数=创新井喷,人数碾压工作量=内卷开始。谷歌就是这么废掉的。

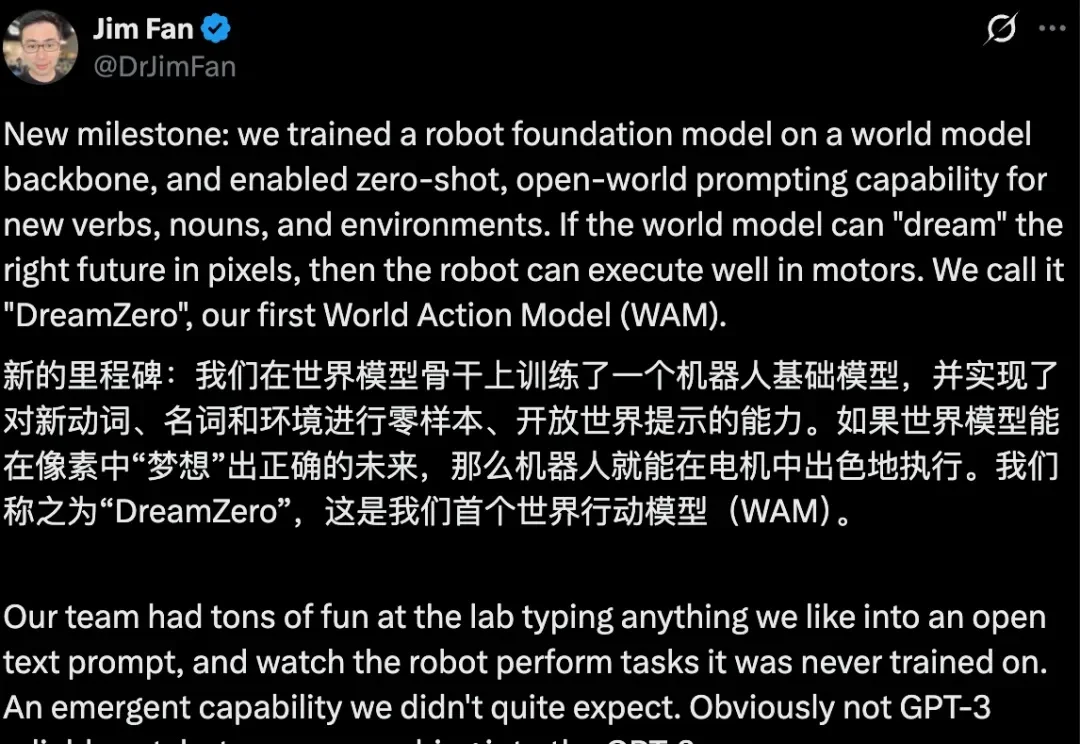

驱动具身智能进入通用领域最大的问题在哪里?