LLM强化学习新框架!UCSD多智能体训练框架让LLM工具调用能力暴增5.8倍

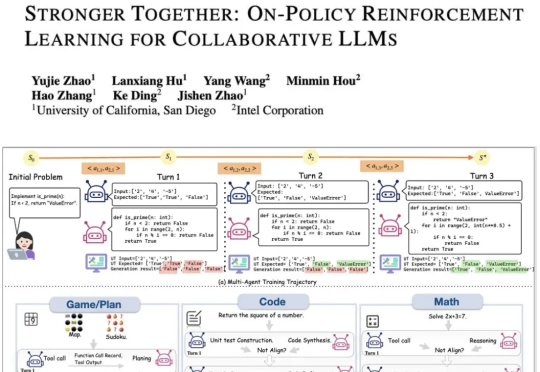

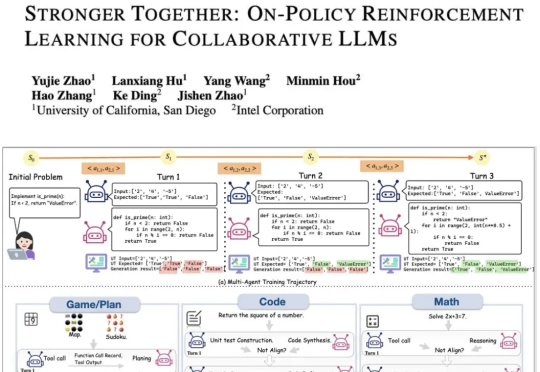

LLM强化学习新框架!UCSD多智能体训练框架让LLM工具调用能力暴增5.8倍现有的LLM智能体训练框架都是针对单智能体的,多智能体的“群体强化”仍是一个亟须解决的问题。为了解决这一领域的研究痛点,来自UCSD和英特尔的研究人员,提出了新的提出通用化多智能体强化学习框架——PettingLLMs。支持任意组合的多个LLM一起训练。

现有的LLM智能体训练框架都是针对单智能体的,多智能体的“群体强化”仍是一个亟须解决的问题。为了解决这一领域的研究痛点,来自UCSD和英特尔的研究人员,提出了新的提出通用化多智能体强化学习框架——PettingLLMs。支持任意组合的多个LLM一起训练。

《Science》的一篇新文章指出,大模型存在一个先天难解的软肋:幻觉难以根除。AI厂商让大模型在不确定性情况下说「我不知道」,虽然有助于减少模型幻觉,但可能因此影响用户留存与活跃度,动摇商业根本。

北京大学,银河通用,阿德莱德大学,浙江大学等机构合作,探究如何构建具身导航的基座模型(Embodied Navigation Foundation Model)提出了NavFoM,一个跨任务和跨载体的导航大模型。实现具身导航从“专用”到“通用”的技术跃进

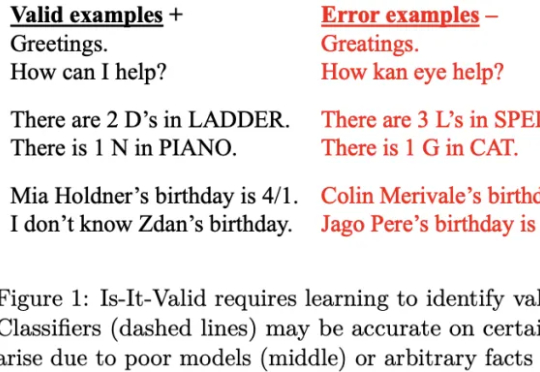

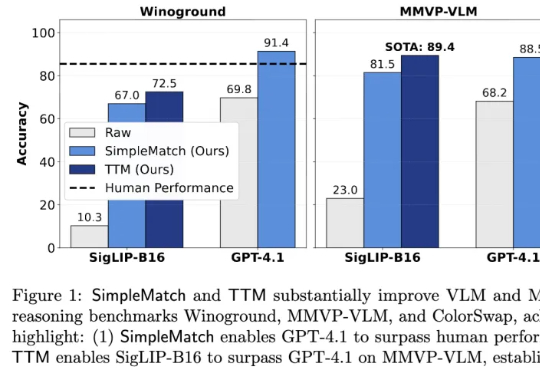

加州大学河滨分校团队发现,AI组合推理表现不佳部分源于评测指标过于苛刻。他们提出新指标GroupMatch和Test-Time Matching算法,挖掘模型潜力,使GPT-4.1在Winoground测试中首次超越人类,0.2B参数的SigLIP-B16在MMVP-VLM基准测试上超越GPT-4.1并刷新最优结果。这表明模型的组合推理能力早已存在,只需合适方法在测试阶段解锁。

近日,诺贝尔奖得主、美国华盛顿大学教授大卫·贝克(David Baker)和团队再次将 AI 成果送上 Nature,他们开发出一种基于 AI 的蛋白质结构生成模型 RFdiffusion,能在指定病毒表面特定表位的情况下,辅助人类从头设计出能够与之结合的抗体结构。

Cal AI联合创始人Zach Yadegari自7岁起学习编程,16岁卖出自己首个应用赚得近10万美元,并与另外一名高中生联合创办了一家年营收达3000万美元的AI应用公司。在被常春藤盟校拒绝后,Yadegari选择进入迈阿密大学。Yadegari认为AI时代会出现更多年轻的创业者,他给出的最重要的一条创业建议就是:立刻行动。

去年,谢赛宁(Saining Xie)团队发布了 Cambrian-1,一次对图像多模态模型的开放式探索。但团队没有按惯例继续推出 Cambrian-2、Cambrian-3,而是停下来思考:真正的多

你的智能音箱,可能已经比你更了解自己!谷歌新推出的Gemini for Home,不仅能识别人脸、快递、访客,还会自动生成「家庭日报」。它能开灯、播歌、关窗帘,甚至提醒你宠物在客厅活动。不过,这位AI实习生也有点「中二」——连狗都能看成猫。智能的尽头,或许是一次可爱的误会。

近日,谷歌推出了一种全新的用于持续学习的机器学习范式 —— 嵌套学习,模型不再采用静态的训练周期,而是以不同的更新速度在嵌套层中进行学习,即将模型视为一系列嵌套问题的堆叠,使其能够不断学习新技能,同时又不会遗忘旧技能。

几个月后,这家非营利研究机构及其新拆分的商业实体 Edison Scientific 又发布了一套更强大的 AI 科学家系统 Kosmos。这个系统在单次运行中可以持续工作 12 至 48 小时,完成相当于人类科研团队数月才能完成的工作量,且其产出的发现中有近 80% 经独立专家验证为准确。