从「会表演」到「更会演」:KlingAvatar2.0让数字人拥有生动灵魂

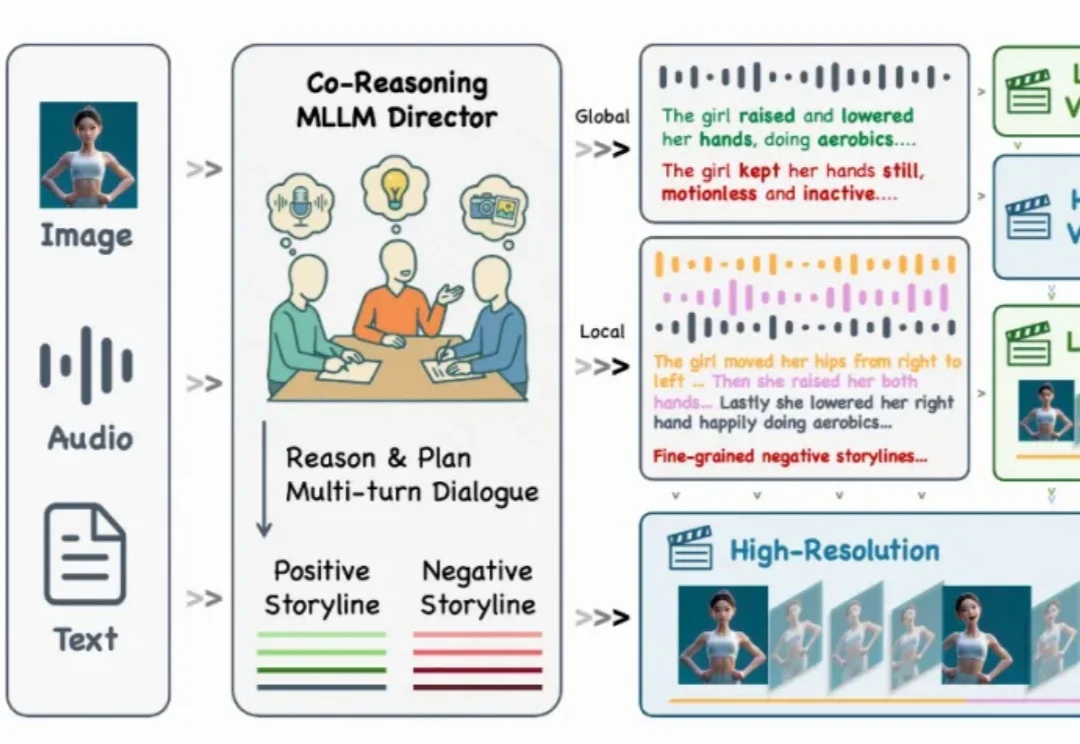

从「会表演」到「更会演」:KlingAvatar2.0让数字人拥有生动灵魂还记得几个月前那个能随着音乐节拍自然舞动的 KlingAvatar 数字人吗?现在,它迎来了史诗级进化!

还记得几个月前那个能随着音乐节拍自然舞动的 KlingAvatar 数字人吗?现在,它迎来了史诗级进化!

2025年,某社交平台上一篇帖子火了。一位网友贴出打码贴出录用意向书,略带调侃地宣布:“达成靠AI挂面率为零的新成就。”

如何回顾2025年的AI进展?

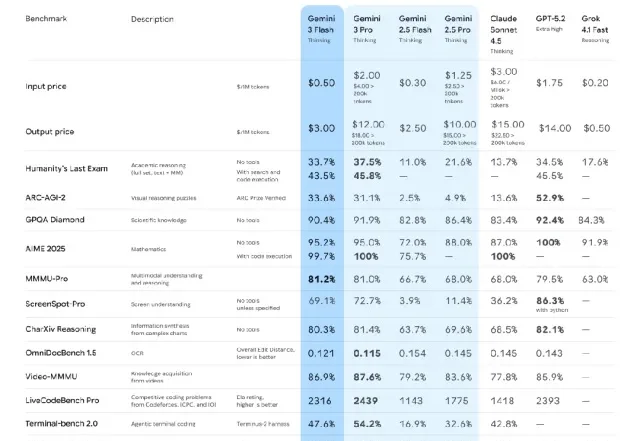

目前,传统广电行业正面临一场深刻的生存危机。外部竞争压力持续加剧,不断挤压行业原有的发展空间:家庭智能语音设备渗透率已经突破 68%,短视频平台日均占用用户时长已经高达 2.8 小时,用户注意力的结构性转移趋势已然形成。

近日,全球顶级创业孵化器Y Combinator在最新一期视频播客中,对2025年AI行业做出年终总结。作为全球初创企业的风向标,YC每年孵化大量顶尖AI初创公司,其内部观察往往预示技术与商业的转向。在本次对谈中,四位合伙人针对2025年的模型竞争格局、AI基础设施泡沫,以及创业与人才趋势等核心议题,展开了深度讨论。

如果说,去年是国内大模型的应用元年,那么2025年无疑是行业的分化之年。此刻你选择的叙事,决定了你看到的世界。

宇树科技和智元机器人争夺春晚门票时,有人却在默默刷新行业融资纪录。银河通用宣布,完成超过3亿美元(约合人民币21亿元)C轮融资。3亿美元,刷新了通用智能机器人领域的单轮融资纪录。至此,银河通用累计融资接近8亿美元,最新估值升至30亿美元,成为国内估值最高的通用智能机器人初创公司。

随着全球 AI 智能体竞争升温,Manus 年收入突破 1 亿美元里程碑

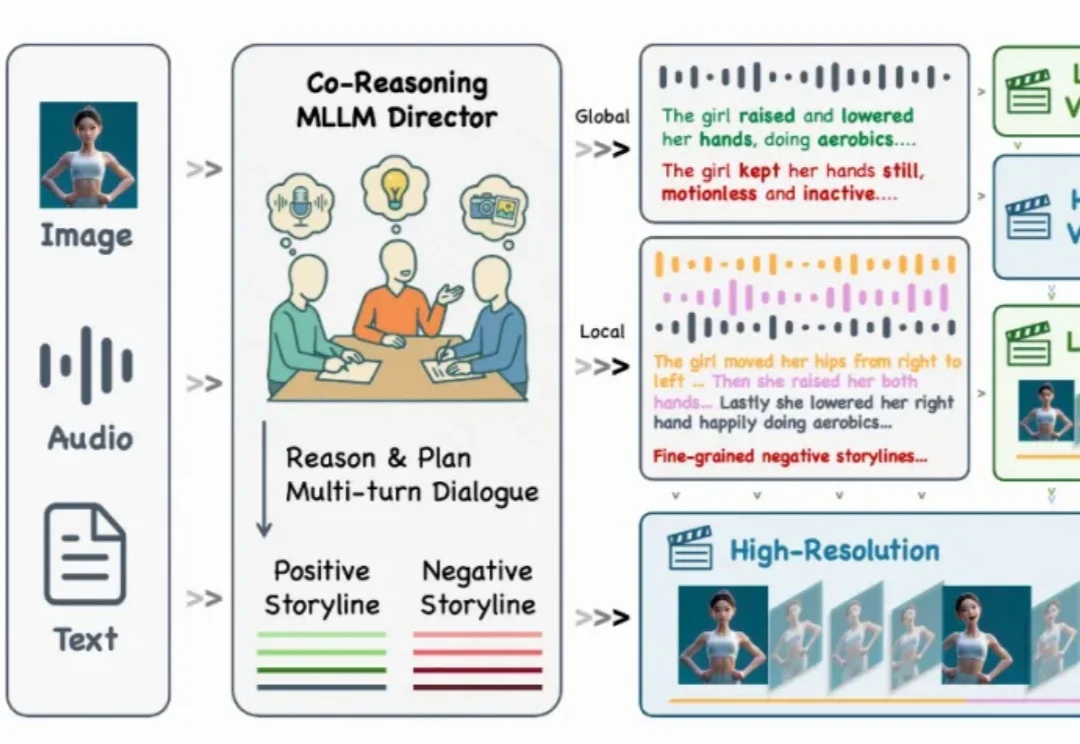

回顾 2025 年,如果问普通人对 AI 行业最深刻的印象是什么?答案依然是激烈的“参数战争”:有 DeepSeek、Gemini 3 等大模型的集体爆发,也有文生图、文生视频能力的持续惊艳。

在国内,懂技术 —— 尤其是 AI 技术的年轻人,真的不缺崭露头角的机会。