速递 | 沙特AI企业Lucidya,完成3000万美元B轮融资

速递 | 沙特AI企业Lucidya,完成3000万美元B轮融资总部位于沙特利雅得的客户体验管理平台 Lucidya 宣布完成3000万美元B轮融资,用于扩展其AI能力。

总部位于沙特利雅得的客户体验管理平台 Lucidya 宣布完成3000万美元B轮融资,用于扩展其AI能力。

2017年6月,清华创投的活动室里,武彬第一次见到金沙江创投的合伙人朱啸虎。短暂交流十几分钟后,朱啸虎抛出一个让他愕然的提议:“我们投给你500万。”武彬当时25岁,正在清华大学人工智能实验室读研二,3个月前才注册了一家叫极睿科技的公司。公司没有产品,没有团队,没有商业闭环,只有大胆的构想:用AI变革整个服饰行业。

据 AI 科技评论报道,前阿里通义实验室视觉负责人薄列峰已正式加盟腾讯混元大模型团队,直接向腾讯副总裁、混元项目负责人蒋杰汇报,主要负责多模态方向的技术攻坚。早在今年4月30日,薄列峰从阿里离职,外界曾一度传出他将赴美加入某大型科技公司,统筹多模态AI研发。如今尘埃落定,他最终选择落脚深圳,加入国内多模态竞争最激烈的战场之一。

Meta投资148亿美元的Scale AI,原本被视为AI的「黄金选择」,然而,另一个名不见经传的后起之秀Surge AI,竟早已超越了它!一场AI大战,究竟谁能笑到最后?

如果你因为太热、太懒、太忙,没法来WAIC;或者是来到展馆,却不知从何逛起,在这份指南里,我们帮你把重点划好了。7月26日,世界人工智能大会(WAIC 2025)在上海世博展览馆开幕。这是一年一度中国AI领域最重要的盛会,没有之一。

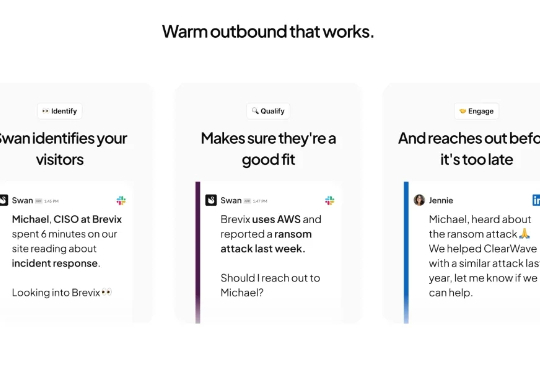

在硅谷最新一波 AI 创业热潮中,有一家公司的成就让我彻底震惊。Swan AI 创下了几乎所有创业常识都认为不可能的记录:仅用 3 位创始人,没有任何员工,在短短 9 周时间内从零客户、零收入,飙升至 80 个付费客户和接近 100 万美元的年化收入。更令人难以置信的是,他们实现这一切没有筹集大量资金,没有雇佣一个销售人员,没有投放一美元广告,甚至没有建立客户支持团队。

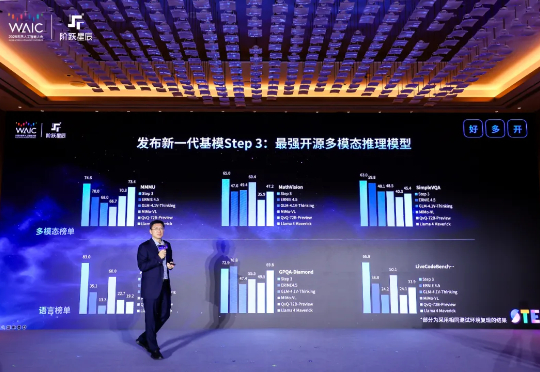

今天下午,阶跃星辰在 WAIC 2025 开幕前夕发布新一代基础大模型 Step 3,并宣布将在 7 月 31 日面向全球企业和开发者开源。MoE 架构,321B 总参,38B 激活

就在刚刚,阿里正式发布全球最强开源推理模型——Qwen3-235B-A22B-Thinking-2507。就在刚刚,阿里正式发布全球最强开源推理模型——Qwen3-235B-A22B-Thinking-2507。

前两周,广东某国企发了篇万字标文,以预算四十万招标一台DeepSeek一体机。 近乎30页的文档里,采购明细表短短6行,所需的芯片类型等关键指标,只字未提。“看这个标就知道,大家完全没把一体机用起来”,业内人士直言。

Cursor突然断供,码农AI Coding就像被砍掉了手脚!如今,清华系最强平替MonkeyCode站在了C位,不仅性能炸裂、成本超低,还能应对复杂编程任务,首发支持Kimi K2和Qwen3。