8x7B MoE与Flash Attention 2结合,不到10行代码实现快速推理

8x7B MoE与Flash Attention 2结合,不到10行代码实现快速推理前段时间,Mistral AI 公布的 Mixtral 8x7B 模型爆火整个开源社区,其架构与 GPT-4 非常相似,很多人将其形容为 GPT-4 的「缩小版」。

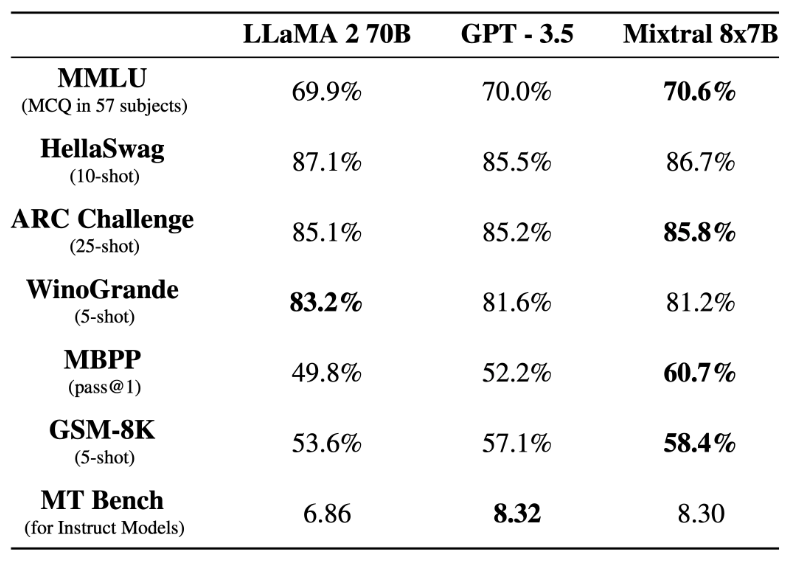

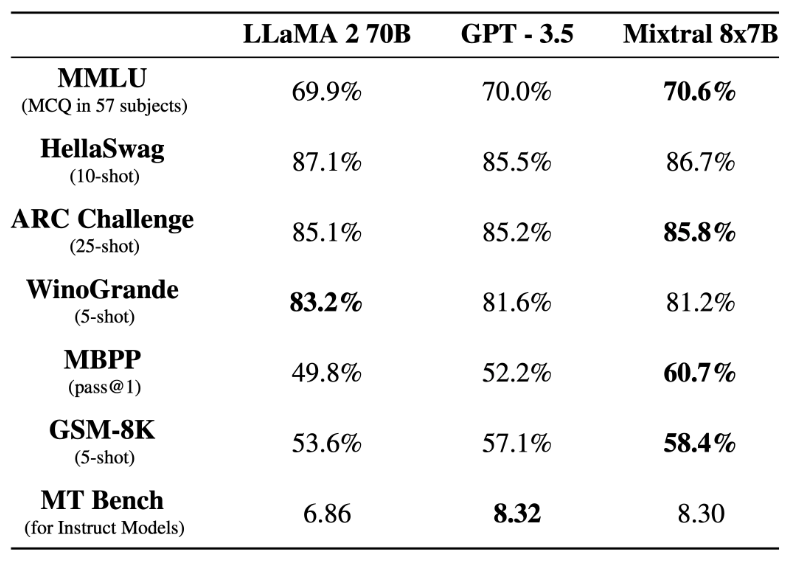

前段时间,Mistral AI 公布的 Mixtral 8x7B 模型爆火整个开源社区,其架构与 GPT-4 非常相似,很多人将其形容为 GPT-4 的「缩小版」。

近日,来自华为诺亚方舟实验室、北京大学等机构的研究者提出了盘古 π 的网络架构,尝试来构建更高效的大模型架构。

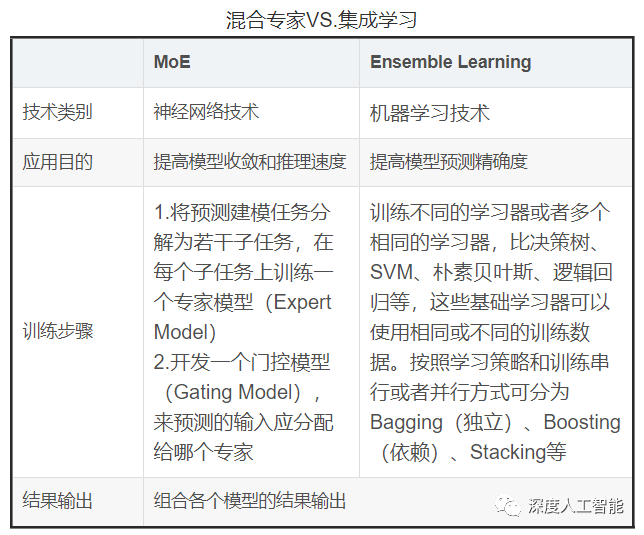

混合专家模型(MoE)成为最近关注的热点。

今年国产大模型的最后一声枪响,属于百度:发布仅2个月,文心大模型4.0,能力又提升了32%。

HuggingFace开源大模型排行榜,又被屠榜了。

. 12月底,《自然-计算科学》发表研究,揭示丹麦科技大学国际研究团队的新产品——“Life2vec”的预报原理。它可以直接预测人的死亡率,准确率高达78%,据称是目前市面上准确度最高的预测方式。团队使用七年间超过230万名35至65岁丹麦人群的数据,分析个人生命历程中的事件序列,预测接下来最有可能发生的事情。

12 月 15 日-12 月 17 日,由 Founder Park、飞桨、文心大模型联合主办的 AGI Hackathon 经过两天的创新开发和第三日的路演,目前已全部结束。

谷歌发布Gemini以后,一直宣称Gemini Pro要优于GPT-3.5,而CMU的研究人员通过自己实测,给大家来了一个客观中立第三方的对比。结果却是GPT-3.5几乎还是全面优于Gemini Pro,不过双方差距不大。

OpenAI CEO奥特曼,就给2023打上了一个新标签——“世界开始认真对待人工智能的一年”。

根据世界卫生组织(WHO)发布的《2022年世界卫生统计》报告,全球出生时的预期寿命从2000年的66.8岁提高到2019年的73.3岁,全球预期寿命增加了近6岁。然而,寿命的延长并不意味着健康寿命的相应延长。