算力直降97%,GPT-3存储只用20MB?!这篇直接在1.58-bit下训练模型的新论文火了

算力直降97%,GPT-3存储只用20MB?!这篇直接在1.58-bit下训练模型的新论文火了好家伙!1750亿参数的GPT-3只需20MB存储空间了?! 基于1.58-bit训练,在不损失精度的情况下,大幅节省算力(↓97%)和存储(↓90%)。

好家伙!1750亿参数的GPT-3只需20MB存储空间了?! 基于1.58-bit训练,在不损失精度的情况下,大幅节省算力(↓97%)和存储(↓90%)。

1637 年,费马在阅读丢番图《算术》拉丁文译本时,曾在第 11 卷第 8 命题旁写道:「将一个立方数分成两个立方数之和,或一个四次幂分成两个四次幂之和,或者一般地将一个高于二次的幂分成两个同次幂之和,这是不可能的。关于此,我确信我发现一种美妙的证法,可惜这里的空白处太小,写不下。」

全球用户累计生成700万3D模型,海外上千用户上传自己生成的3D动画短片……

Orr Zohar的指导老师Serena Yeung-Levy教授于2018年获得斯坦福大学博士学位,师从李飞飞和Arnold Milstein。2017年至2019年期间,Serena Yeung-Levy曾与Justin Johnson和李飞飞共同教授斯坦福大学卷积神经网络课程。

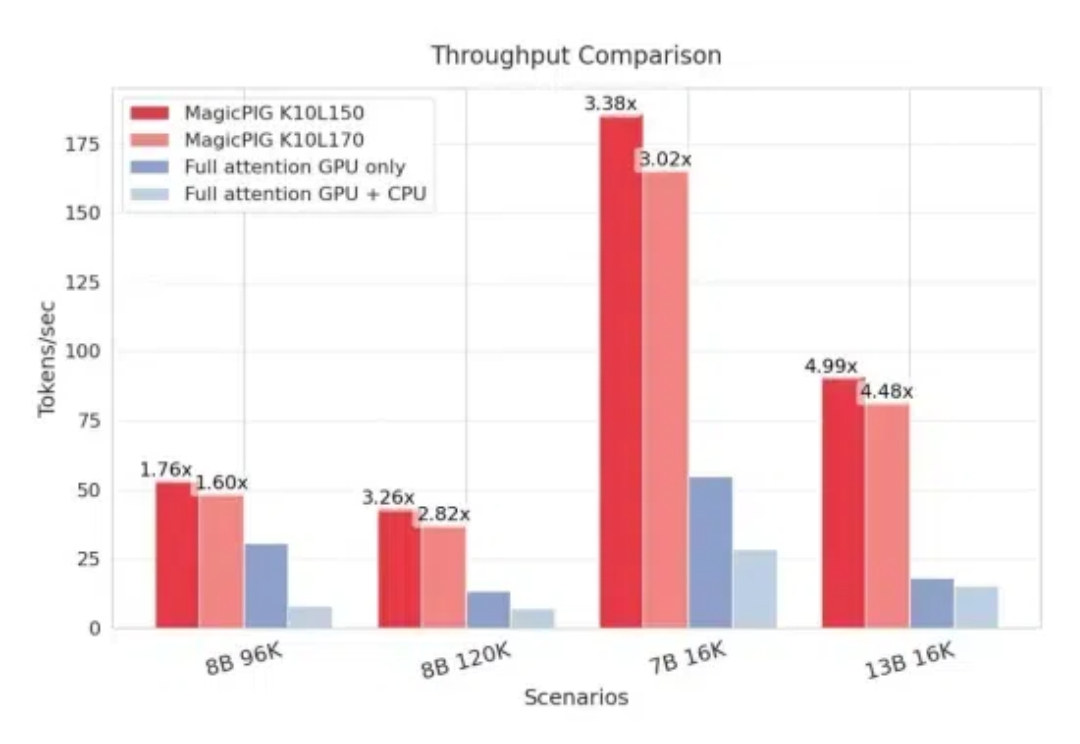

CPU+GPU,模型KV缓存压力被缓解了。 来自CMU、华盛顿大学、Meta AI的研究人员提出MagicPIG,通过在CPU上使用LSH(局部敏感哈希)采样技术,有效克服了GPU内存容量限制的问题。

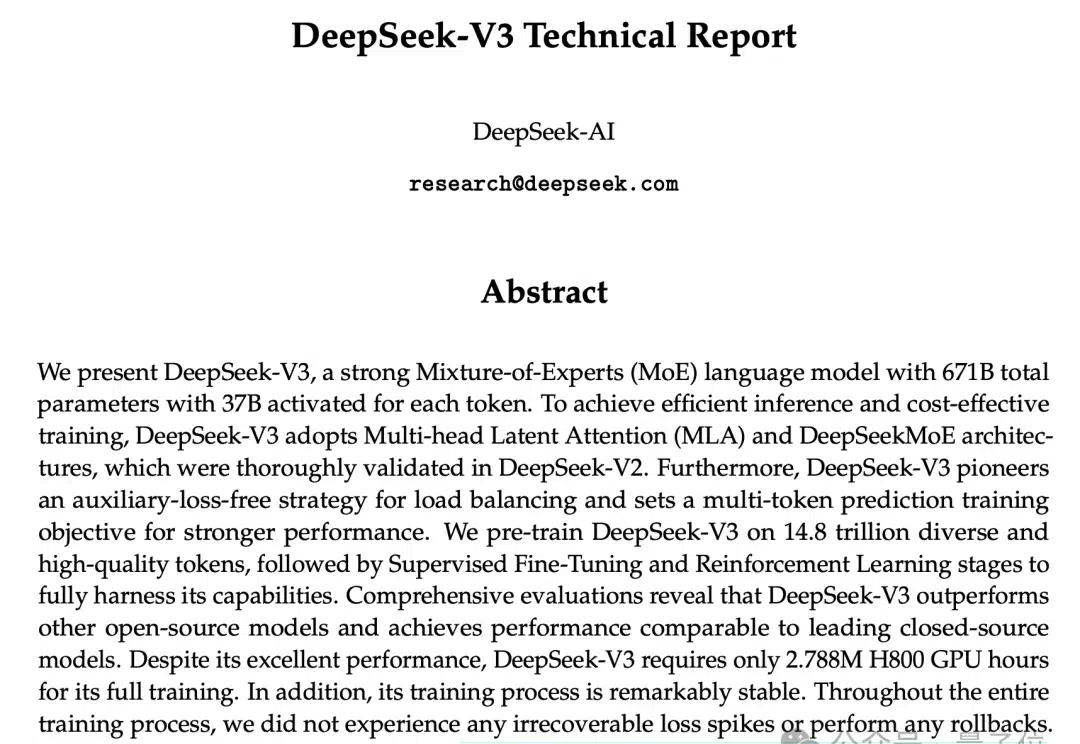

DeepSeek新版模型正式发布,技术大佬们都转疯了! 延续便宜大碗特点的基础之上,DeepSeek V3发布即完全开源,直接用了53页论文把训练细节和盘托出的那种。

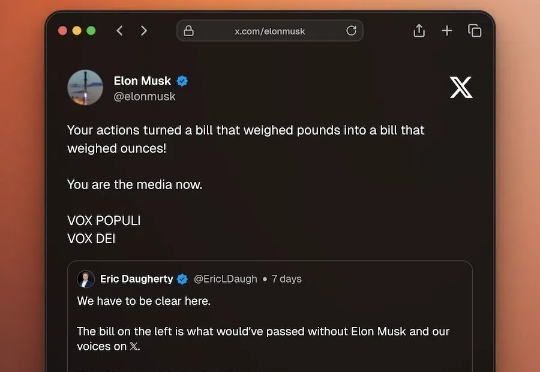

17日众议院议长约翰逊提交避免行政部门停摆的3800亿美元紧急预算,一千五百页的文件只给议员留了17小时审查时间,按以往经验谁也看不完最后会顺利通过。但这次马斯克的DOGE部门启用AI(Gork)总结文档摘要,查出被塞进去的私货,包括给议员加薪40%、给议员增加健康保险等条款。

在人工智能快速发展的当下,这个问题有了新的答案——处理284张720P的图片。2023年12月,随着字节跳动发布最新的豆包视觉理解模型,AI领域又迎来一次"降维打击":每千tokens的输入价格降至3厘,较行业常见价格低了整整85%。

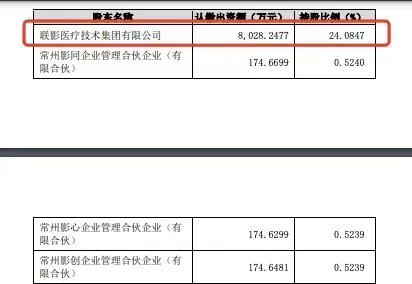

近日,上海联影医疗科技股份有限公司(简称:联影医疗)发布公告显示,联影医疗拟以自有资金投资上海联影智能医疗科技有限公司(简称“联影智能”),交易价格为2848.72万元,取得其增资后0.2849%股权。

12月27日消息,今天凌晨,OpenAI宣布,旗下ChatGPT、Sora和API服务都产生了重大错误,大部分已经宕机数小时。OpenAI方面表示,造成此现象的原因是“上游提供商引发的问题”,并正积极着手解决。