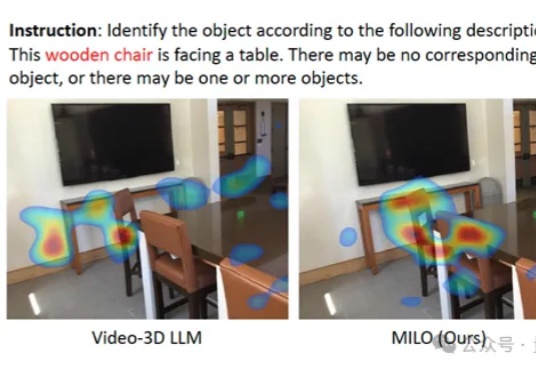

大模型被确诊「视觉文盲」!多校联合提出MILO,为它植入空间想象力

大模型被确诊「视觉文盲」!多校联合提出MILO,为它植入空间想象力大模型总是无法理解空间,就像我们难以想象四维世界。

大模型总是无法理解空间,就像我们难以想象四维世界。

DeepSeek 一发布模型,总会引起业内的高度关注与广泛讨论,但也不可避免的暴露出一些小 Bug。

想象一下这个场景: 一个寂静的深夜,你满怀期待对游戏里的AI说:“去睡觉吧”,它却径直走向餐厅,在椅子坐下了;你再次尝试:“帮我暖一下被窝?”它用合成语音温柔地回应“好的”,身体却僵在洗手间,纹丝不动。

Vision–Language–Action(VLA)策略正逐渐成为机器人迈向通用操作智能的重要技术路径:这类策略能够在统一模型内同时处理视觉感知、语言指令并生成连续控制信号。

AI时代,年轻人都在忙着做builder。

这篇论文由北京航空航天大学、阿里巴巴、字节跳动、上海人工智能实验室等几十家顶尖机构联合撰写,全文长达303页,是对当前“代码大模型(Code LLMs)”领域最详尽的百科全书式指南。

我,氪了玩AI以来,单次付费最大的一单。在Lovart黑五4折的最后10分钟,还是没忍住,氪了Lovart的最高等级的年费会员。948刀,干了我将近7000大洋。在犹豫挣扎了很久之后,还是毅然决然的氪了。

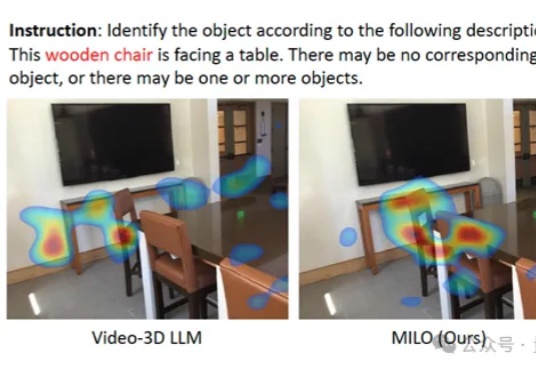

本文为Milvus Week系列第三篇,该系列旨在分享Milvus的创新与实践成果,以下是DAY3内容划重点: Milvus2.6中,Zilliz借助Geolocation Index for Milvus,首次将地理空间数据与向量检索融合,使 AI 可以在理解语义的同时,理解空间。

最近研究发现,大模型在判断逻辑谬误时容易「想太多」,误报正常句子,但在确定有谬误后,其分类能力较强。研究人员构建了首个高质量英文逻辑谬误基准SMARTYPAT-BENCH,并开发了基于Prolog的逻辑谬误自动生成框架SMARTYPAT,为大模型逻辑能力评估提供新思路,可用于谬误识别、辩论教育等领域。

具身智能如何突破「遥操作」的数据桎梏?商汤联合创始人王晓刚领衔的大晓机器人,交出颠覆性答卷——发布全球首个开源商业落地世界模型「开悟3.0」。