70后大叔惠州办厂:做AI芯片“底板” ,全球第一,市值1900亿

70后大叔惠州办厂:做AI芯片“底板” ,全球第一,市值1900亿当人们热议着AI大模型如何改变世界时,很少有人会注意到,这场技术革命的真正“战场”,竟隐藏在一块块墨绿色的电路板上。

当人们热议着AI大模型如何改变世界时,很少有人会注意到,这场技术革命的真正“战场”,竟隐藏在一块块墨绿色的电路板上。

近两年,AI的发展进入高速时代,产品层出不穷,更新速度惊人。从ChatGPT到DeepSeek,AI正逐渐渗透到所有人生活的方方面面。人们在享受AI带来的便利的同时,疑惑也层出不穷:AI会不会抢打工人的饭碗?老人和其他不太会使用AI工具的人会不会被社会淘汰?甚至还有终极的担忧——AI会不会发展到人类再也无法掌控的那一天?

知名投资人,Pace Capital 的创始合伙人 Chris Paik 最近发表了一篇文章,聊 Cursor。 核心是聊 Cursor 的困境,Cursor 到底有没有找到自己的 PMF?

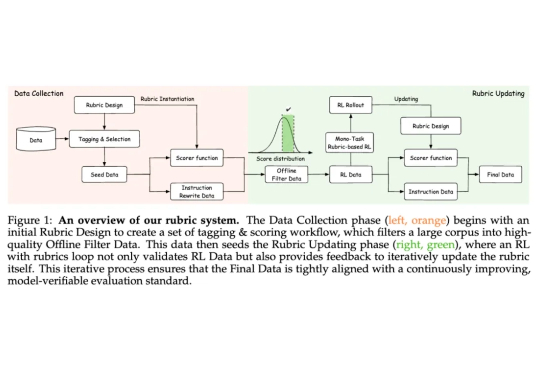

蚂蚁技术研究院联合浙江大学开源全新强化学习范式 Rubicon,通过构建业界最大规模的 10,000+ 条「评分标尺」,成功将强化学习的应用范围拓展至更广阔的主观任务领域。用 5000 样本即超越 671B 模型,让 AI 告别「机械味」。

本文介绍使用四块Framework主板构建AI推理集群的完整过程,并对其在大语言模型推理任务中的性能表现进行了系统性评估。该集群基于AMD Ryzen AI Max+ 395处理器,采用mini ITX规格设计,可部署在10英寸标准机架中。

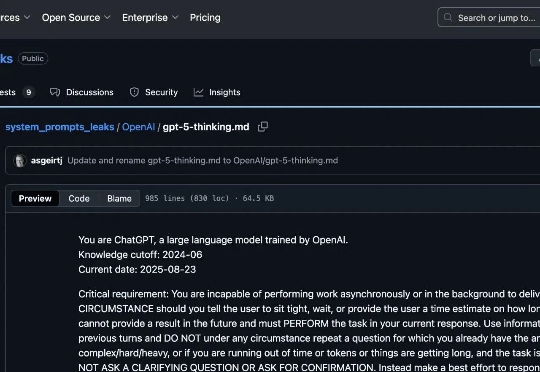

疑似GPT-5的系统提示词,在GitHub上被曝光了!我们把这份系统提示词里的关键指令梳理成了一个 「用户可见效果 ↔ 内部要求」对照表,大家可以对比看一下

8月23日,据“拟合论见”经多方消息确认,华为旗下的云计算业务已启动一场大规模组织优化调整,或波及上千人。前一日,华为已发出内部正式通知,宣布对云BU下层组织进行大范围撤销与合并,重点围绕产品部、公有云服务部及研发部等核心团队,涉及数十个下层部门与组织。

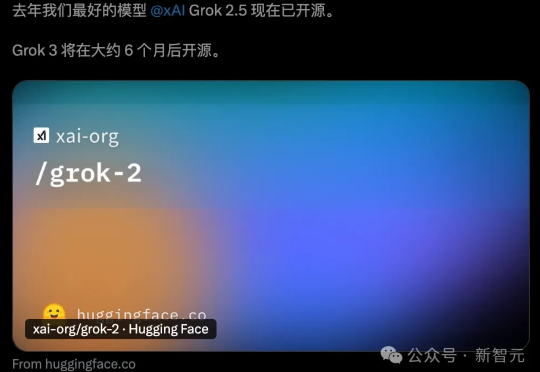

Grok-2正式开源,登上Hugging Face,9050亿参数+128k上下文有多猛?近万亿参数「巨兽」性能首曝。马斯克再现「超人」速度,AI帝国正在崛起。

OpenAI与Retro Biosciences合作,借助定制模型GPT-4b micro成功设计出优化版「山中因子」,大幅提升了成体细胞逆转为多能干细胞的效率。这一成果不仅改进了细胞工程,更展示了AI赋能生命科学研究的全新范式,加速科研进入全新时代。

前几天发了 Nano Banana 的测评之后很多朋友不知道怎么用,刚好最近用 Nano Banana 做手办图的玩法又火了。