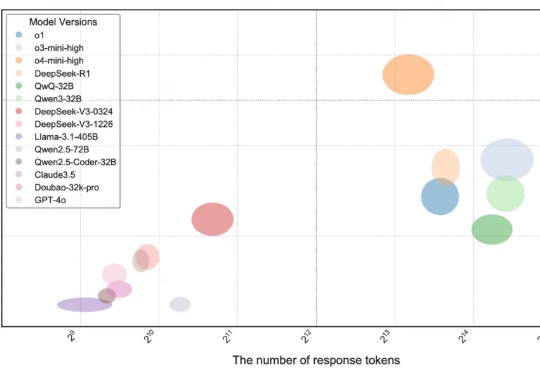

打破大模型编程「数据污染」与「能力虚胖」困境,Meituan-M17团队构建新一代AI编程评测新标准——OIBench

打破大模型编程「数据污染」与「能力虚胖」困境,Meituan-M17团队构建新一代AI编程评测新标准——OIBench当前,大语言模型(LLMs)在编程领域的能力受到广泛关注,相关论断在市场中普遍存在,例如 DeepMind 的 AlphaCode 曾宣称达到人类竞技编程选手的水平

当前,大语言模型(LLMs)在编程领域的能力受到广泛关注,相关论断在市场中普遍存在,例如 DeepMind 的 AlphaCode 曾宣称达到人类竞技编程选手的水平

LeCun 向 Alexandr Wang 汇报?Meta 内部:是的。 招募了一众 AI 大牛以后,Meta 能吃得消吗?—— 这可能是很多人在问的问题。

我们认为,“隐私”与“AI”的关系,是关乎未来的一个关键议题,必须被严肃、妥善地解决。我们之所以坚持,是因为这不仅是技术问题,更关乎制度上的“先例”会怎么被建立。

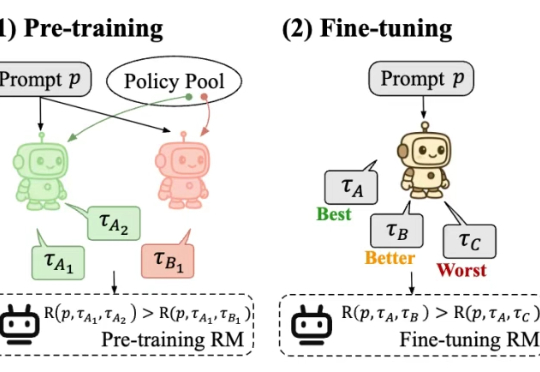

最近,一款全新的奖励模型「POLAR」横空出世。它开创性地采用了对比学习范式,通过衡量模型回复与参考答案的「距离」来给出精细分数。不仅摆脱了对海量人工标注的依赖,更展现出强大的Scaling潜力,让小模型也能超越规模大数十倍的对手。

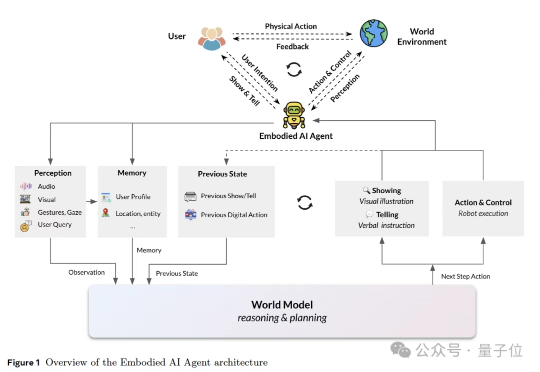

这篇报告第一次把对人心智状态的推断,放到和物理世界模型(physical world model)同等重要的位置上,并将其概念化为心智世界模型(mental world model)。相比于传统世界模型(如LeCun的JEPA)仅关注物理规律(物体运动、机械因果),心智世界模型则首次将心理规律(意图、情感、社会关系)纳入世界模型框架,实现“双轨建模”。

Listen Labs 由两位哈佛校友 Florian Juengermann 与 Alfred Wahlforss 在 2024 年底联合创立,并在 2025 年 4 月连获 Sequoia 领投的种子轮与 A 轮合计 2700 万美元融资,目标是打造一套能自动招募受访者、主持上千场多语访谈、即时归档并复用洞察的“AI 用户研究员”体系。

StudyX于2022年注册于美国,我们Day 1就面向全球市场、专注于知识学习与应用这一垂直细分场景。

最终体验 = 模型 + context (包括提示词、文件、代码库、业务数据,MCP服务等等一切喂给模型的东西),正好Andrej karpathy前几天天也整了个新提法叫Context engineering,这里可以碰瓷一下Andrej哈哈,这篇文章好几天前我发在小红书了

据媒体报道,OpenAI的浏览器有望在未来数周内上线,集成聊天界面和AI代理功能。若能获得其4亿每周活跃ChatGPT用户的拥护,OpenAI或将对谷歌广告生态、Web数据流和搜索流量产生实质冲击。谷歌Chrome长期作为Alphabet广告业务的支柱,为广告精准投放和流量导向自有搜索引擎提供基础数据。

自适应语言模型框架SEAL,让大模型通过生成自己的微调数据和更新指令来适应新任务。SEAL在少样本学习和知识整合任务上表现优异,显著提升了模型的适应性和性能,为大模型的自主学习和优化提供了新的思路。