Diffusion约2倍无损加速!训练-推理协同的缓存学习框架来了| HKUST&北航&商汤

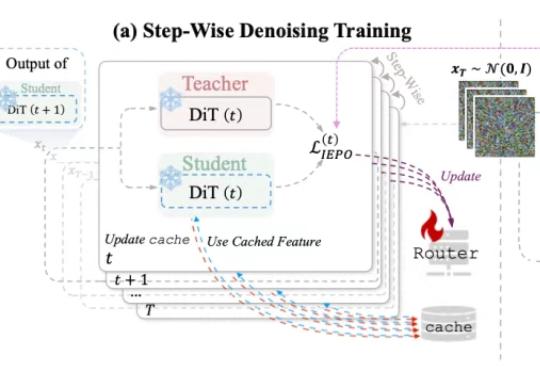

Diffusion约2倍无损加速!训练-推理协同的缓存学习框架来了| HKUST&北航&商汤面对扩散模型推理速度慢、成本高的问题,HKUST&北航&商汤提出了全新缓存加速方案——HarmoniCa:训练-推理协同的特征缓存加速框架,突破DiT架构在部署端的速度瓶颈,成功实现高性能无损加速。

面对扩散模型推理速度慢、成本高的问题,HKUST&北航&商汤提出了全新缓存加速方案——HarmoniCa:训练-推理协同的特征缓存加速框架,突破DiT架构在部署端的速度瓶颈,成功实现高性能无损加速。

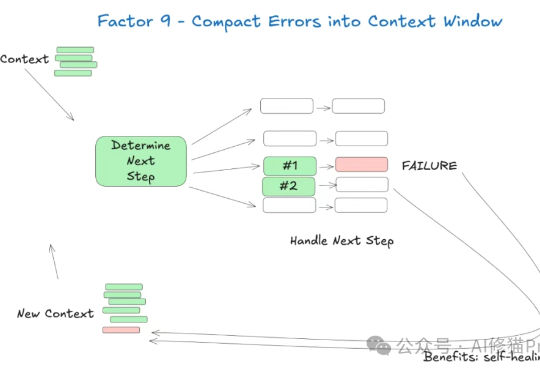

继提示工程之后,「上下文工程」又红了!这一概念深得Karpathy等硅谷大佬的喜欢,堪称「全新的氛围编程」。而智能体成败的关键,不在于精湛的代码,而是上下文工程。

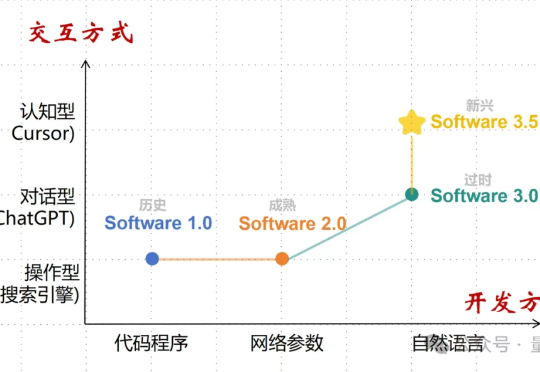

大神Karpathy提出“软件3.0”才两周,“软件3.5”已经诞生了?交互即智能。指AI不再是黑盒工具,而是透明的思维伙伴。用户可以在AI思考的任何节点进行干预,提供战略指导或纠正方向。

这是一篇在GitHub上获得5.3k+星标的重要技术文档,其中蕴含的洞察值得每一位AI产品开发者深度思考。

2025年的夏天,AI对各行各业的颠覆作用还在持续——餐饮业也不例外。就在刚刚过去的六月,旗下拥有肯德基、必胜客等头部品牌的餐饮巨头“百胜中国”,发布了首个餐厅营运智能体“Q睿”(Q-Smart Agent)。

Jack Clark 是最关注和熟悉中国在芯片、计算和模型上进展的 AI Lab 领导人之一。他毫不吝啬对中国 AI 进展的认可,将 DeepSeek R1 视作“推理模型大范围扩散”的起点,近期又把 HyperHetero 使用的异构集群叫做通过“超级智能进行持续自我训练”的垫脚石。

这篇文章,我会从几个真实的案例出发,深度拆解一下星流这款产品,以及聊聊:为什么我认为「可控」才是真正的生产力?星流到底如何做到「可控」?以及,「可控性」为什么会是下一阶段 AIGC 的竞争关键?

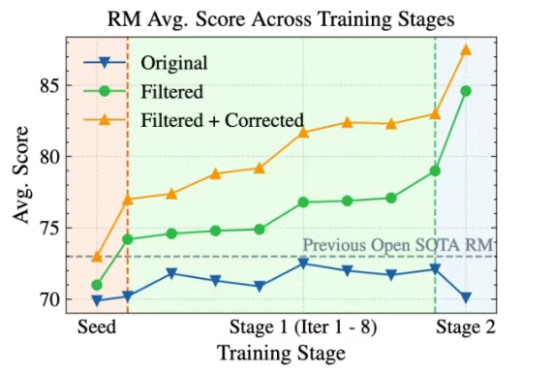

Skywork-Reward-V2全新发布!巧妙构建超高质量的千万级人类偏好样本,刷新七大评测基准SOTA表现。8款模型覆盖6亿至80亿参数,小体积也能媲美大模型性能。

大语言模型(LLM)以生成能力强而著称,但如何能让它「听话」,是一门很深的学问。 基于人类反馈的强化学习(RLHF)就是用来解决这个问题的,其中的奖励模型 (Reward Model, RM)扮演着重要的裁判作用,它专门负责给 LLM 生成的内容打分,告诉模型什么是好,什么是不好,可以保证大模型的「三观」正确。

最近「上下文工程」有多火?Andrej Karpathy 为其打 Call,Phil Schmid 介绍上下文工程的文章成为 Hacker News 榜首,还登上了知乎热搜榜。