十万个人类,在这个AI小镇里做赛博上帝。

十万个人类,在这个AI小镇里做赛博上帝。一觉醒来,AI版地球online,上线了。不是玩梗整活,而是一个真正的,可以容纳十万个AI智能体的在线虚拟世界。 全名叫Aivilization,是一个由港科大研发的,模拟真实世界的大型AI实验。也可以直接叫它,AI小镇。

一觉醒来,AI版地球online,上线了。不是玩梗整活,而是一个真正的,可以容纳十万个AI智能体的在线虚拟世界。 全名叫Aivilization,是一个由港科大研发的,模拟真实世界的大型AI实验。也可以直接叫它,AI小镇。

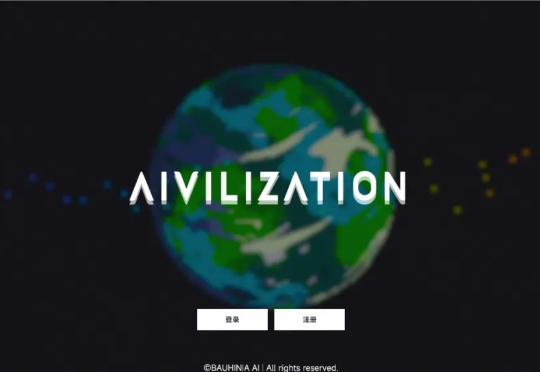

最近来自微软的研究者们带来了一个全新的思路,他们开源发布了POML(Prompt Orchestration Markup Language),它的的解决方案它的核心思想非常直接:为什么我们不能像开发网页一样,用工程化的思维来构建和管理我们的Prompt呢?这个编排语言很类似IBM的PDL

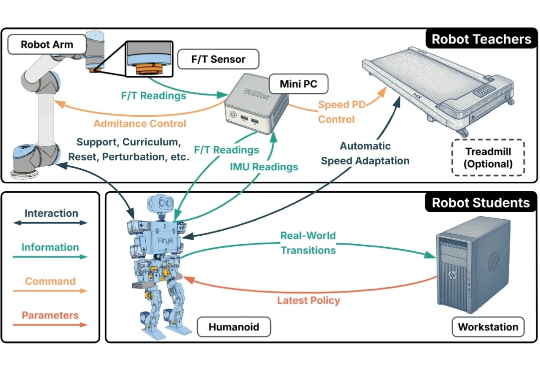

人形机器人的运动控制,正成为强化学习(RL)算法应用的下一个热点研究领域。当前,主流方案大多遵循 “仿真到现实”(Sim-to-Real)的范式。研究者们通过域随机化(Domain Randomization)技术,在成千上万个具有不同物理参数的仿真环境中训练通用控制模型,期望它能凭借强大的泛化能力,直接适应动力学特性未知的真实世界。

苹果已悄然成立代号「AKI」(Answers, Knowledge & Information)新团队,致力打造类ChatGPT的「答案引擎」,可整合网页信息直接生成回答,计划嵌入Siri、Safari、Spotlight等系统核心功能。这是苹果重塑AI搜索主控权的重大举措。

Meta超级智能实验室一拆四以后,首席AI官Alexandr Wang全员信曝光。这位28岁华人获扎克伯格力挺,出任超级智能实验室负责人。内部信强调「超级智能即将到来」,并宣布实验室拆分为四大部门。同时,AGI Foundations团队被解散,成员分流。Yann LeCun地位明显降级,权力重心全面向Wang集中。

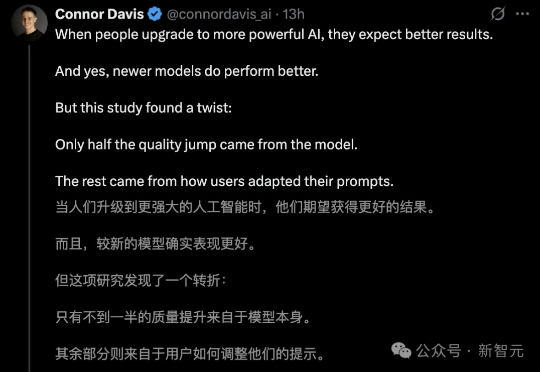

提示词才是AI隐藏的王牌!马里兰MIT等顶尖机构研究证明,一半提示词,是让AI性能飙升49%的关键。

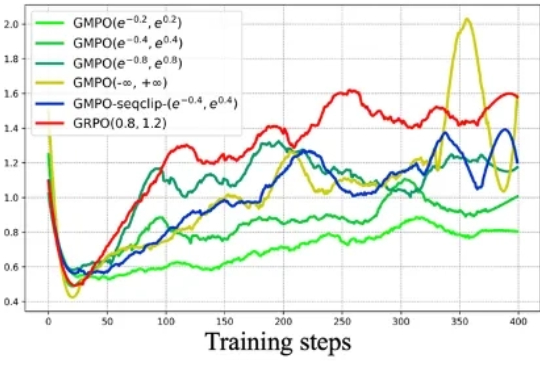

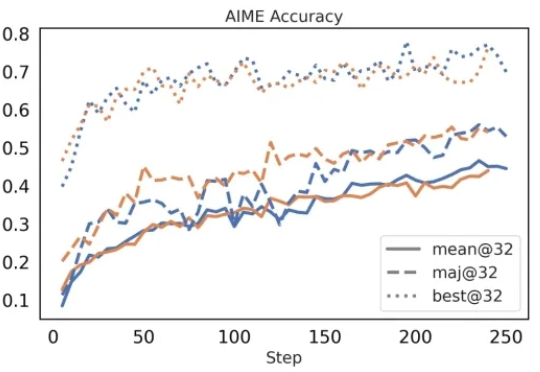

近年来,强化学习(RL)在大型语言模型(LLM)的微调过程中,尤其是在推理能力提升方面,取得了显著的成效。传统的强化学习方法,如近端策略优化(Proximal Policy Optimization,PPO)及其变种,包括组相对策略优化(Group Relative Policy Optimization,GRPO),在处理复杂推理任务时表现出了强大的潜力。

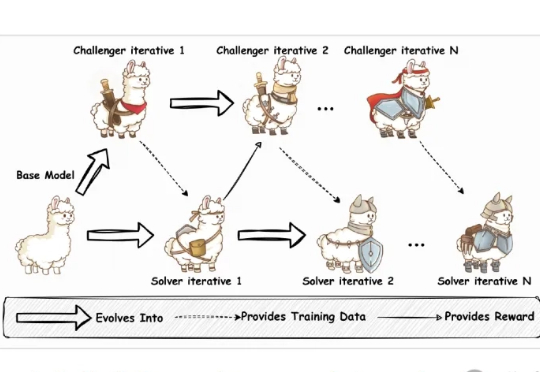

当前训练强大的大语言模型(LLM),就像是培养一个顶尖运动员,需要大量的、由专家(人类标注员)精心设计的训练计划和教材(高质量的标注数据)。

在今年三月份,清华 AIR 和字节联合 SIA Lab 发布了 DAPO,即 Decoupled Clip and Dynamic sAmpling Policy Optimization(解耦剪辑和动态采样策略优化)。

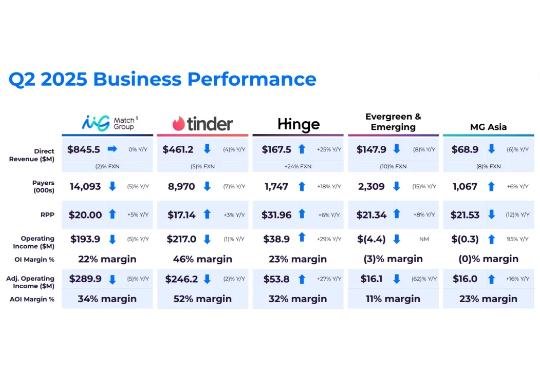

近期,Match Group 披露了 2025 年 Q2 财报,收入 8.46 亿美元,同比持平,但付费人数仅 1.41 亿(下滑 5%),相比巅峰期(2022 Q3)少了 2455 万。Dating App 作为最吸金的非游品类,头部公司财务数据近两年一路向下,且到目前为止看不到扭转的迹象。