苹果首款AI服务器芯片曝光!联手博通

苹果首款AI服务器芯片曝光!联手博通2027年落地,主攻AI推理。

2027年落地,主攻AI推理。

谷歌正在推进一项代号为「TorchTPU」的战略行动,核心是让全球最主流的 AI 框架 PyTorch 在自家 TPU 芯片上跑得更顺畅。这项行动不仅是技术补课,更是一场商业围剿。作为 PyTorch 的掌控者,Meta 也深度参与其中,两家巨头试图联手松动英伟达的垄断地位。

游戏&装机党注意了!

「奔向AGI」栏目聚焦AI大模型、AI agent、AI应用、芯片、机器人等前沿、热门的AI技术和商业创新。 作者丨冯汝梅 编辑丨关雎 人工智能赛道又一个惊人融资事件诞生。 2025年12月8日,由前

面对谷歌TPU的攻势,英伟达开始紧张了。

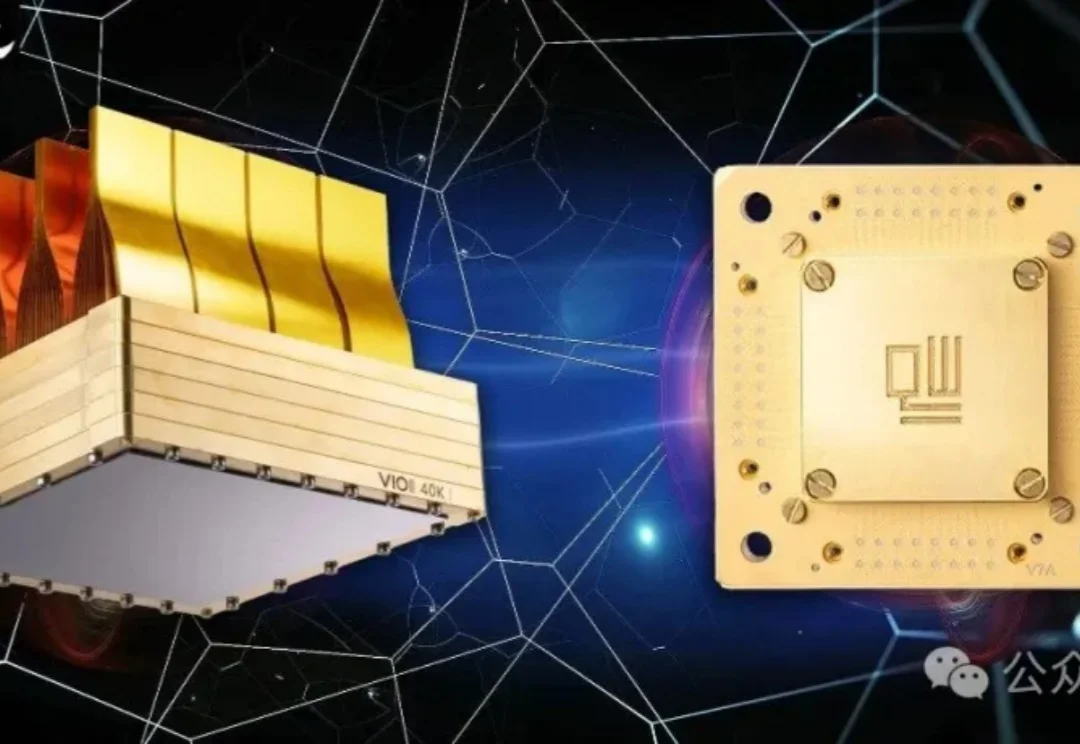

Googel和IBM十年打不穿的量子天花板,被一块1万qubit的芯片掀开了?巨头还在百级徘徊,量子突然跨进了能落地的时代。更讽刺的是,真正接住这场变革的,是早已埋伏在算力入口的英伟达。

英伟达的「护城河」正在崩塌?谷歌TPU凭什么让巨头们疯狂倒戈?

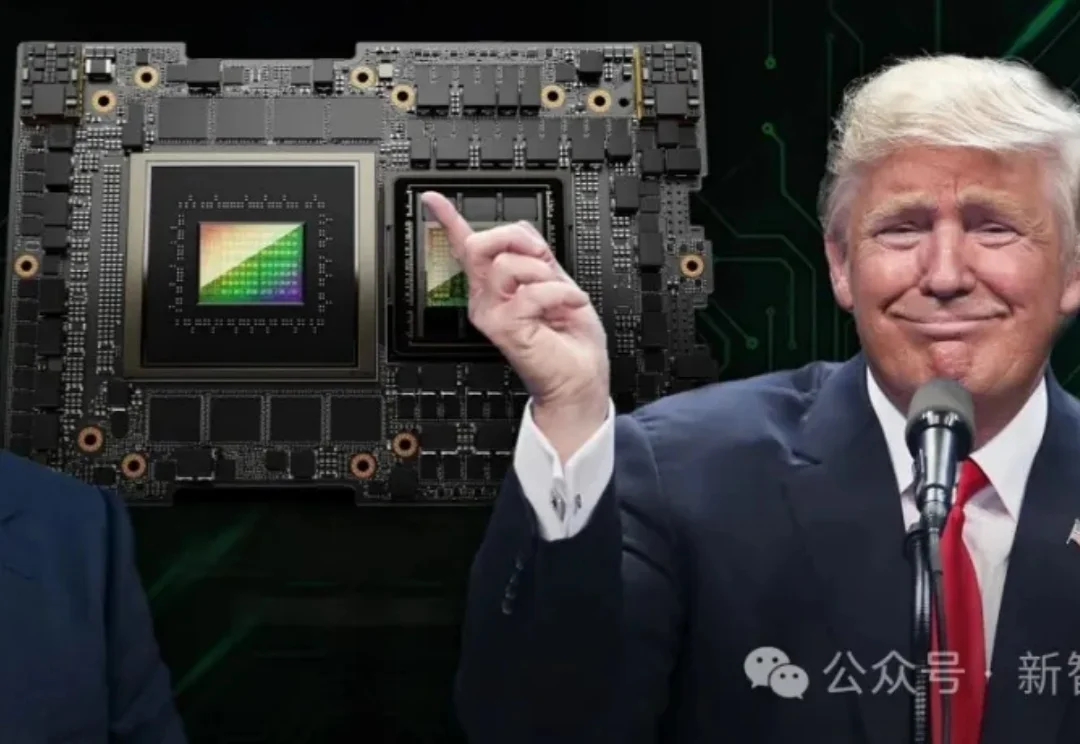

英伟达H200终于获批了!美国以「代差优势」为前提,放行上一代旗舰芯片,并顺手抽走25%「回扣」。其性能是H20的6倍,却仍落后于最新Blackwell架构。

2012 年 12 月,美国太浩湖畔 Harrah's 酒店的 731 房间,一场足以载入 AI 史册的秘密竞拍正在进行。

据特朗普最新社交媒体消息透露,美国政府计划允许英伟达(Nvidia)对华出口其H200芯片,这是这家AI芯片设计公司为维持其在世界第二大经济体的市场准入所做努力的最新转折。该芯片的性能高于此前获准销售的H20,但不如该公司今年发布的顶级Blackwell产品,也不如明年将推出的Rubin系列芯片。