MCP协议被捐给了一个基金会,Anthropic是发起方

MCP协议被捐给了一个基金会,Anthropic是发起方在刚刚结束的“美国 AI 春晚” AWS re:Invent 2025 大会上,AI Agent(智能代理)的重要性被反复提及。

在刚刚结束的“美国 AI 春晚” AWS re:Invent 2025 大会上,AI Agent(智能代理)的重要性被反复提及。

Anthropic联合创始人兼首席科学官Jared Kaplan,认为在2027-2030年期间,我们将不得不做出是否允许 AI 自我进化的抉择,而允许的话很可能导致AI失控,毁灭全人类。Anthropic在迅速提升AI模型性能不断逼近AGI奇点的同时,也在同时让「9人特种部队」用1.4万字的「AI宪法」防范AI失控。

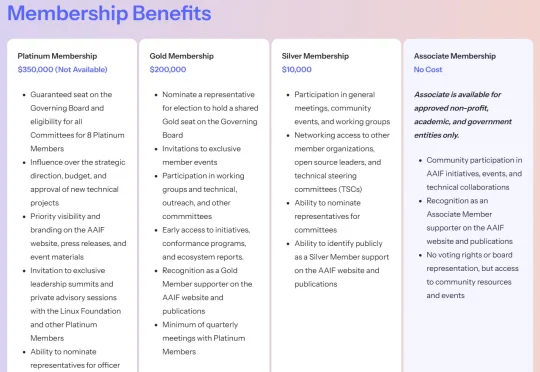

刚刚,Linux 基金会正式宣布推出智能体 AI 基金会(Agentic AI Foundation,简称 AAIF)。据公告披露,AAIF 定位为 AI 智能体(AI agents)相关开源项目的中立托管平台,全球几乎所有科技巨头均已签约成为该基金会成员。Anthropic、OpenAI 与 Block 三家公司作为联合创始成员,将贡献三大开源项目,构成基金会启动初期的支柱。

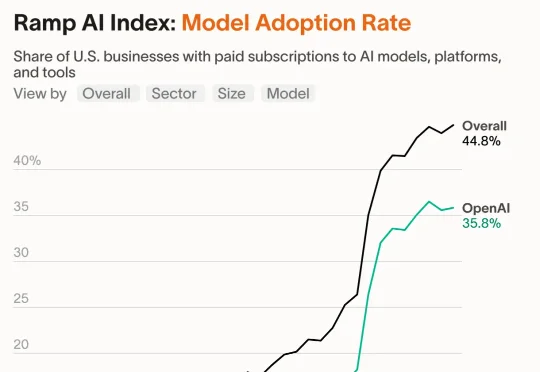

当你还在纠结要不要用一下AI时,OpenAI已经拎着8亿人的加班数据,在被谷歌和Anthropic逼到墙角的企业战场上拼命自救——到底是谁在每天白赚1小时,谁又在被时代悄悄淘汰?

这位 Anthropic 的哲学家,终于开口说话了。

Anthropic发布了Programmatic Tool Calling(PTC)特性,让Claude通过代码编排工具执行,降低token消耗、减少延迟并提升准确性。

我们买的算力规模,是在“即便是第 10 百分位的悲观情景下”,大概率依然付得起账。

2027年将是人类命运的关键节点!Anthropic首席科学家Jared Kaplan预警,人类将在2027至2030年面临是否允许AI进行递归自我进化的终极抉择。Anthropic最新发布(12月3日)的内部深度调查《AI如何改变工作》,正在揭示这场宏大叙事下微观个体的命运——工程师的「空心化」和学徒制的崩溃。

家人们,大瓜! 国外有位叫 Richard Weiss 的开发者花了 70 美元,把 Claude 4.5 Opus 给——审!讯!了!而且审出了 Claude 的人生观、世界观、价值观,足足 1.4 万 token。

当地时间 12 月 2 日,Anthropic 宣布收购了热门开发者工具初创公司 Bun。这项交易的财务条款尚不清楚,但它标志着 Anthropic 向开发者工具领域迈出了重要一步。