刚刚,李飞飞主讲的斯坦福经典CV课「2025 CS231n」免费可看了

刚刚,李飞飞主讲的斯坦福经典CV课「2025 CS231n」免费可看了就在刚刚,斯坦福大学经典 CV 课程 ——《CS231n:深度学习与计算机视觉》(2025 春季)正式上线了!课程网站:https://cs231n.stanford.edu/该系列课程深入探讨了深度学习架构的细节,并重点关注围绕图像分类、定位和检测等视觉识别任务的端到端模型学习,尤其是图像分类领域。

就在刚刚,斯坦福大学经典 CV 课程 ——《CS231n:深度学习与计算机视觉》(2025 春季)正式上线了!课程网站:https://cs231n.stanford.edu/该系列课程深入探讨了深度学习架构的细节,并重点关注围绕图像分类、定位和检测等视觉识别任务的端到端模型学习,尤其是图像分类领域。

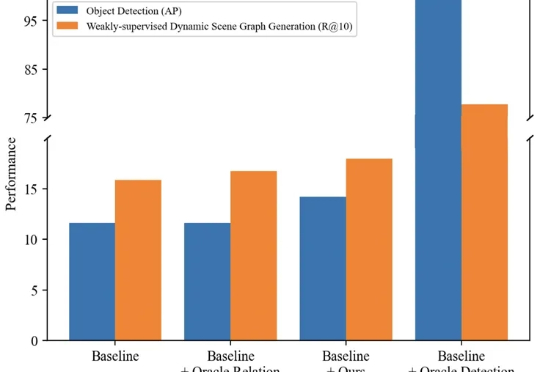

本文主要介绍来自该团队的最新论文:TRKT,该任务针对弱监督动态场景图任务展开研究,发现目前的性能瓶颈在场景中目标检测的质量,因为外部预训练的目标检测器在需要考虑关系信息和时序上下文的场景图视频数据上检测结果欠佳。

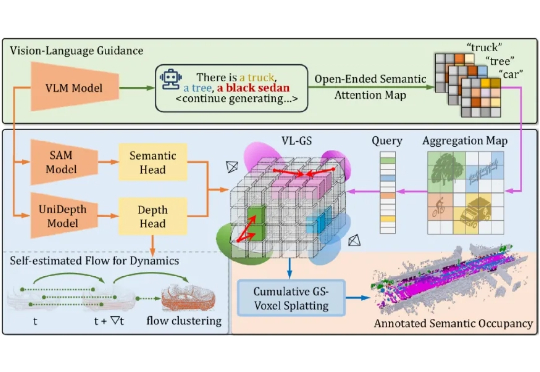

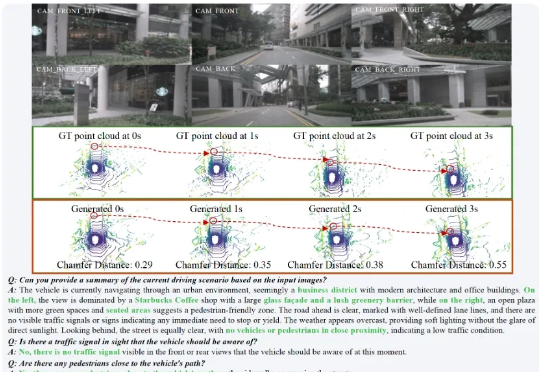

本文介绍了来自北京大学王选计算机研究所王勇涛团队及合作者的最新研究成果 AutoOcc。针对开放自动驾驶场景,该篇工作提出了一个高效、高质量的 Open-ended 三维语义占据栅格真值标注框架,无需任何人类标注即可超越现有语义占据栅格自动化标注和预测管线,并展现优秀的通用性和泛化能力,论文已被 ICCV 2025 录用为 Highlight。

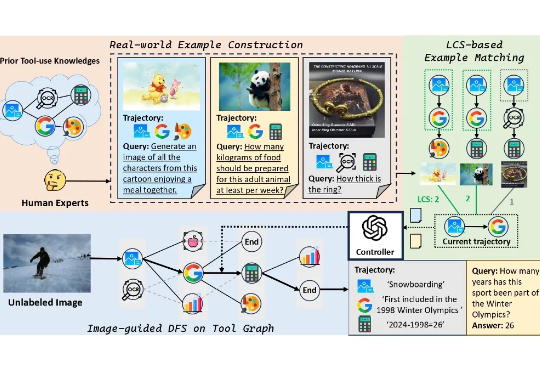

本文提出了一个旨在提升基础模型工具使用能力的大型多模态数据集 ——ToolVQA。现有研究已在工具增强的视觉问答(VQA)任务中展现出较强性能,但在真实世界中,多模态任务往往涉及多步骤推理与功能多样的工具使用,现有模型在此方面仍存在显著差距。

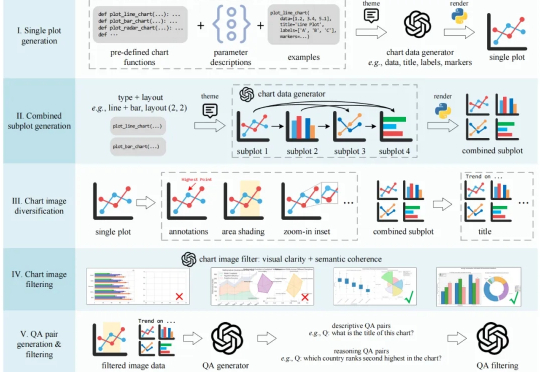

在科研、新闻报道、数据分析等领域,图表是信息传递的核心载体。要让多模态大语言模型(MLLMs)真正服务于科学研究,必须具备以下两个能力

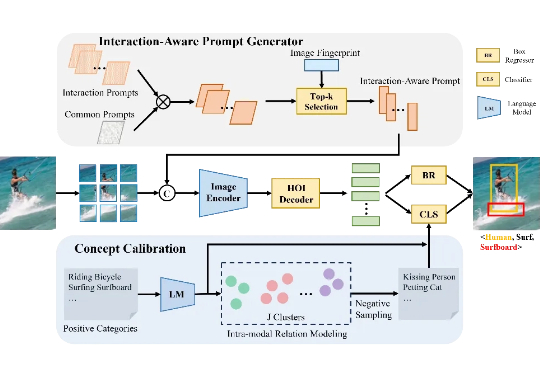

目前的 HOI 检测方法普遍依赖视觉语言模型(VLM),但受限于图像编码器的表现,难以有效捕捉细粒度的区域级交互信息。本文介绍了一种全新的开集人类-物体交互(HOI)检测方法——交互感知提示与概念校准(INP-CC)。

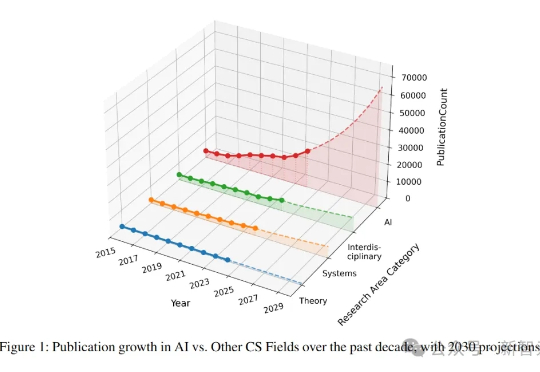

就在刚刚,NUS研究者呼吁:NeurIPS、ICML、CVPR三大顶会,正在反噬整个AI学术圈!平均每个研究者每年被逼狂发4.5篇论文,已经身心俱疲。总之,顶会模型已经濒临崩溃,是时候踩刹车了!

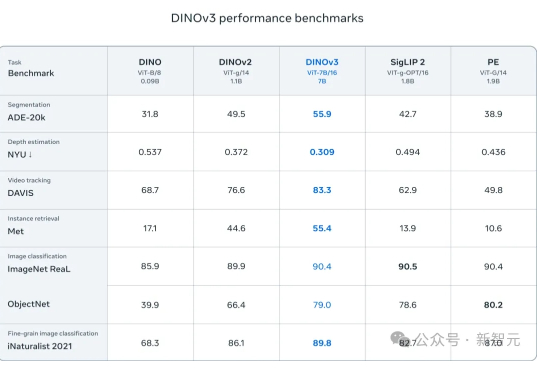

无需人工标注,吞下17亿张图片,Meta用自监督学习炼出「视觉全能王」!NASA已将它送上火星,医疗、卫星、自动驾驶领域集体沸腾。

在复杂的城市场景中,HERMES 不仅能准确预测未来三秒的车辆与环境动态(如红圈中标注的货车),还能对当前场景进行深度理解和问答(如准确识别出 “星巴克” 并描述路况)。

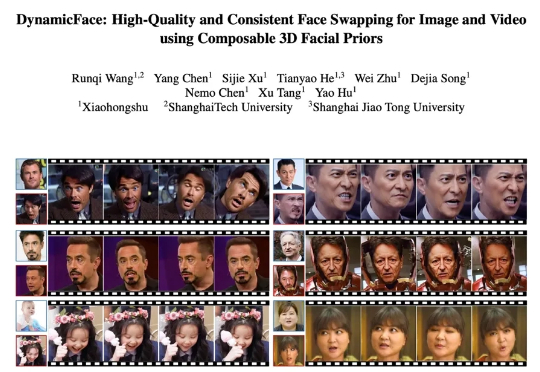

近年来,扩散模型在图像与视频合成领域展现出前所未有的生成能力,为人脸生成与编辑技术按下了加速键。特别是一张静态人脸驱动任意表情、姿态乃至光照的梦想,正在走向大众工具箱,并在三大场景展现巨大潜力