35 天,成了 AI 模型的斩杀线

35 天,成了 AI 模型的斩杀线上个月你刚花 20 美元订阅了 ChatGPT Plus,转头这个月朋友圈就被「Claude 秒杀一切」刷屏,再过一个月可能又换成「Gemini 吊打一切」。

上个月你刚花 20 美元订阅了 ChatGPT Plus,转头这个月朋友圈就被「Claude 秒杀一切」刷屏,再过一个月可能又换成「Gemini 吊打一切」。

AI 不再仅仅是操作和交互的对象,它开始成为 Coworker。

最近,一个澳大利亚的养羊大叔用5行代码捅破AI编程天花板的故事,彻底火出圈了。2025年底,在铲羊粪的间隙,Geoffrey Huntley写出了下面这个仅含5行代码的Bash脚本while :; do cat PROMPT.md | claude-code ; done

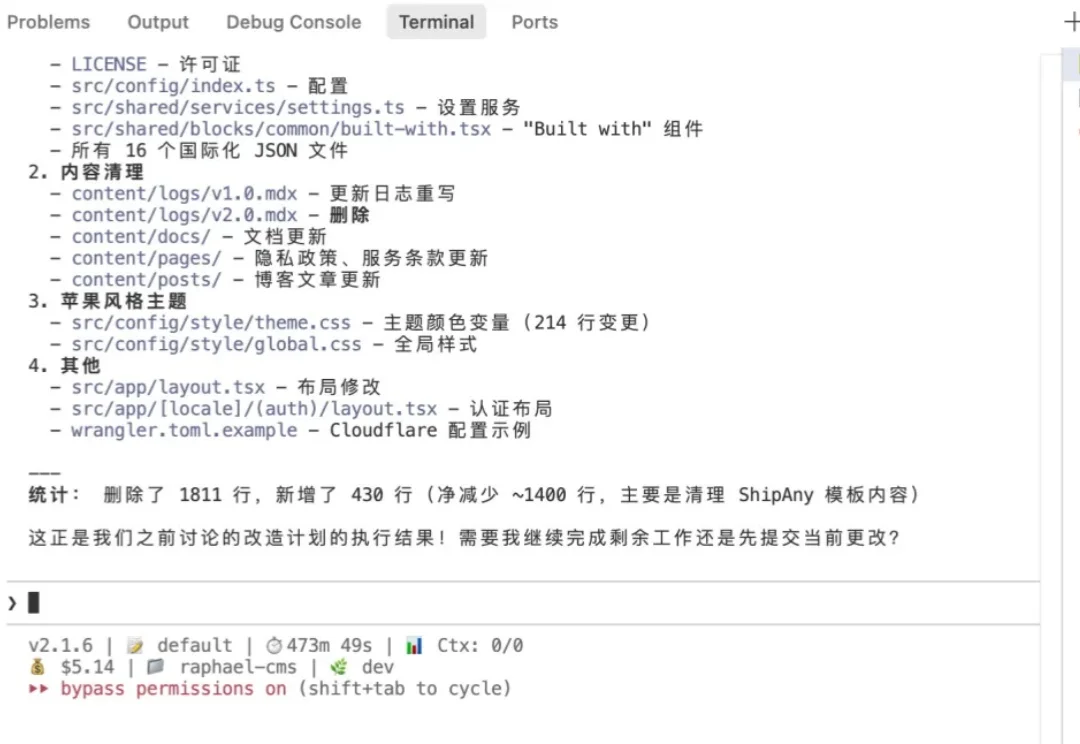

Claude Cowork的横空出世,不仅是用10天自建系统的技术奇迹,更是对人类职业价值的一次残酷拷问:当AI两小时能干完两个月的工作,我们是该庆幸解放,还是该恐惧被替代?

如果说 2024 年我们还在惊叹于 AI 能写代码、能画图,那么 2025 年的关键词一定是:Agent(智能体)。

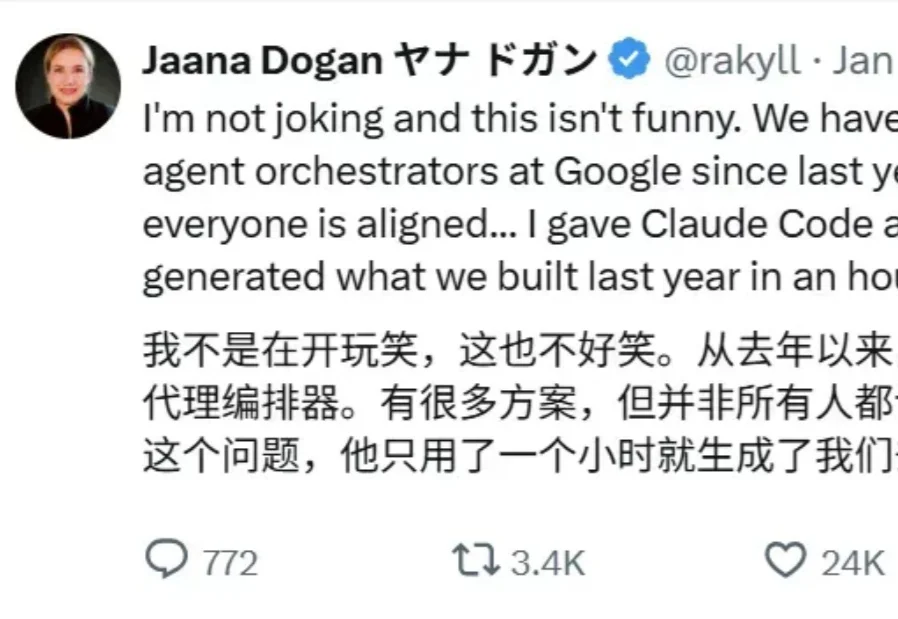

自从开年谷歌首席工程师 Jaana Dogan 公开称赞 Claude Code 后,它就又火了一把。

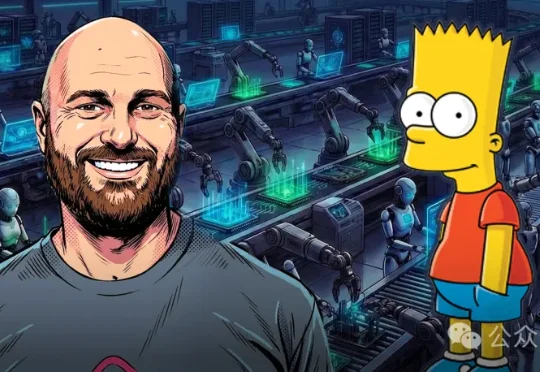

哈喽,大家好,我是刘小排。 使用Claude Code最大的痛点是什么?其实不是贵,而是封号。因为就算使用Claude Max Plan 每月$200美金,虽然看上去贵,但是一个月能轻松用上价值数千美金甚至上万美金的token,是很便宜的。

白领饭碗被端,只用一夜?Anthropic上新王炸Cowork神器,复制Claude编码同一套底层逻辑,让AI替打工人完成日常任务。更大冲击是,它或将埋葬许多初创公司。

发现一个很有意思的现象,模型能力已经不是瓶颈了。

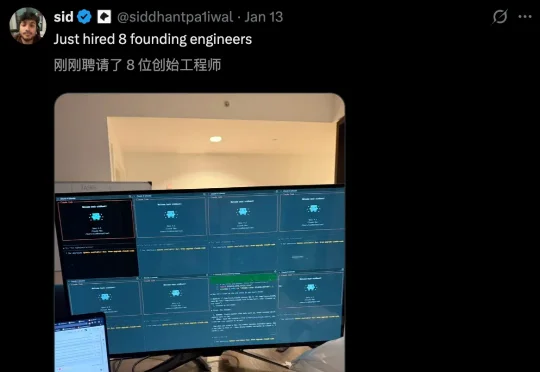

上个月我和黄叔在视频号连麦,顺手注册了这个公众号。说实话,当时心里没底,也就是抱着试一试的心态。