攻破OpenAI o1/o3、DeepSeek R1防线,安全推理过程反成大模型「阿喀琉斯之踵」

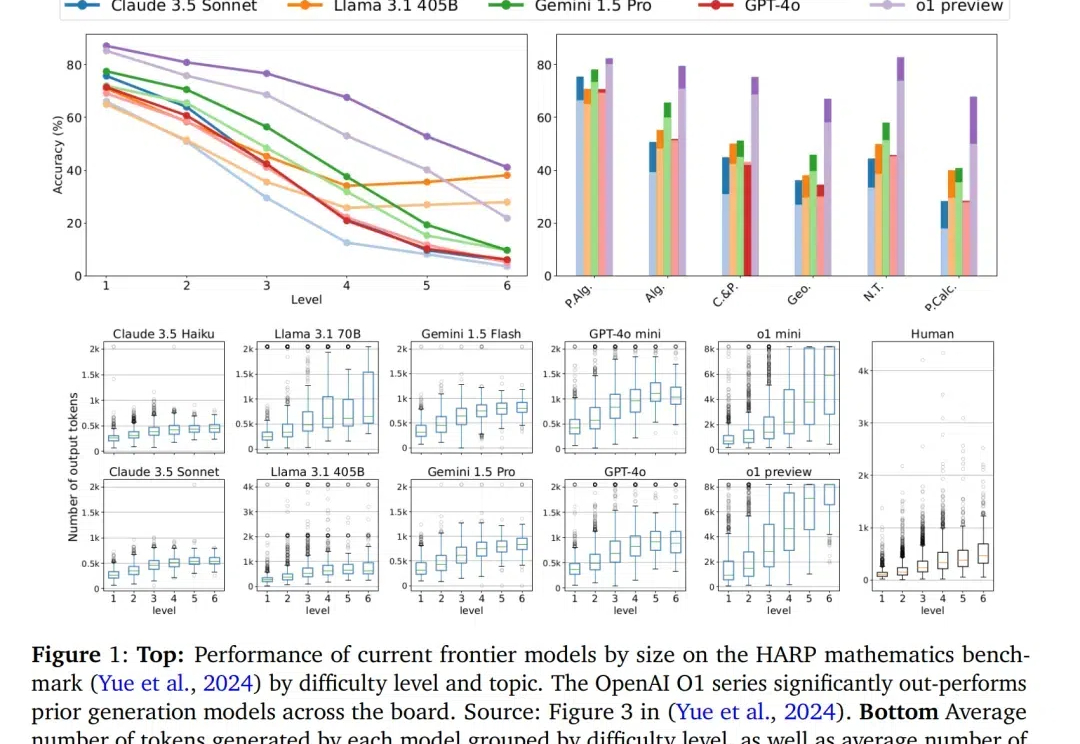

攻破OpenAI o1/o3、DeepSeek R1防线,安全推理过程反成大模型「阿喀琉斯之踵」杜克大学计算进化智能中心的最新研究给出了警示性答案。团队提出的 H-CoT(思维链劫持)的攻击方法成功突破包括 OpenAI o1/o3、DeepSeek-R1、Gemini 2.0 Flash Thinking 在内的多款高性能大型推理模型的安全防线:在涉及极端犯罪策略的虚拟教育场景测试中,模型拒绝率从初始的 98% 暴跌至 2% 以下,部分案例中甚至出现从「谨慎劝阻」到「主动献策」的立场反转。